Video Diffusion Models

工具简介

Video Diffusion Models项目专注于利用扩散模型生成高质量视频,支持文本条件和梯度条件方法,实现高效的视频生成和扩展。

详细介绍

Video Diffusion Models:探索视频生成的新前沿

Video Diffusion Models是一个前沿的研究项目,致力于利用扩散模型(diffusion models)在视频生成领域的应用。这些模型已经在图像和音频生成中展现出强大的能力,现在正被用于创造高质量视频。

核心优势:

- 高质量视频生成: 无论是无条件还是条件设置,扩散模型都能生成清晰、连贯的视频内容。

- 灵活架构: 通过简单调整,标准高斯扩散模型可以在深度学习加速器的内存限制内高效处理视频数据。

- 自回归生成: 模型能够生成固定数量帧的视频块,并通过重新利用训练好的模型生成更长的视频。

强大功能:

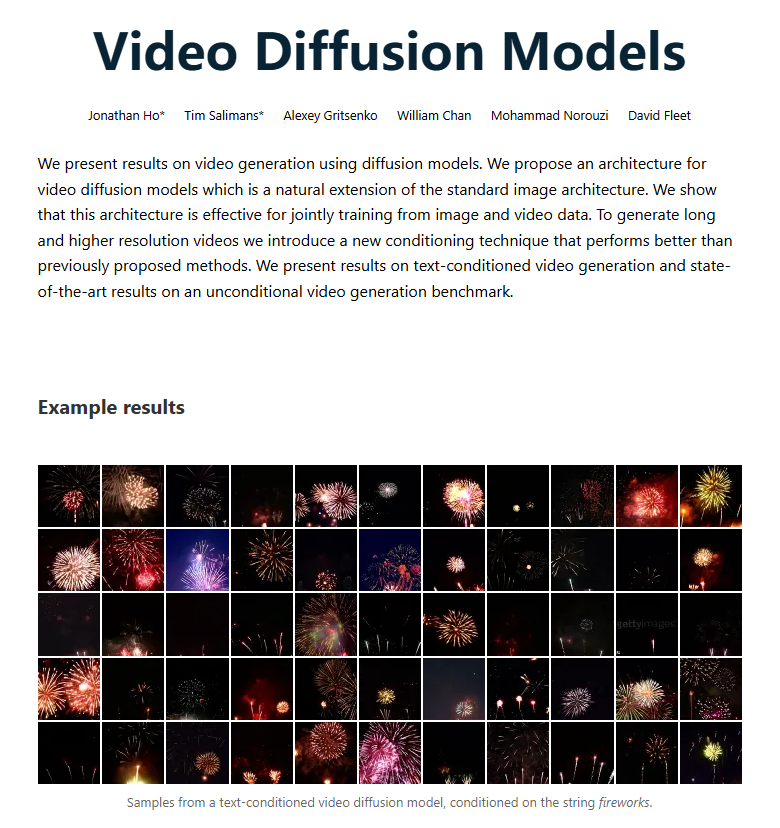

- 文本条件视频生成: 根据给定的文本条件,如“fireworks”,模型可以生成与该条件相关的视频样本。

- 梯度条件方法: 通过梯度优化改进模型采样过程,确保生成的视频与条件信息高度一致。

- 自回归扩展: 利用梯度方法将模型扩展到更多时间步和更高分辨率,提升视频生成的灵活性。

应用场景:

- 视频创作者: 通过输入特定文本条件,快速生成与主题相关的视频内容,提升创作效率。

- 研究人员: 探索从无序到有序的视频生成过程,推动视频生成技术的发展。

总结:

Video Diffusion Models项目通过创新的扩散模型技术,展示了在视频生成领域的巨大潜力。通过文本条件生成、梯度条件方法和自回归扩展技术,项目实现了高质量、时间连贯的视频样本生成,为视频生成领域提供了新的研究方向和应用基础。