Go爬虫(http、goquery和colly)详解

来源:脚本之家

时间:2022-12-31 14:52:23 353浏览 收藏

怎么入门Golang编程?需要学习哪些知识点?这是新手们刚接触编程时常见的问题;下面golang学习网就来给大家整理分享一些知识点,希望能够给初学者一些帮助。本篇文章就来介绍《Go爬虫(http、goquery和colly)详解》,涉及到爬虫、goquery、colly,有需要的可以收藏一下

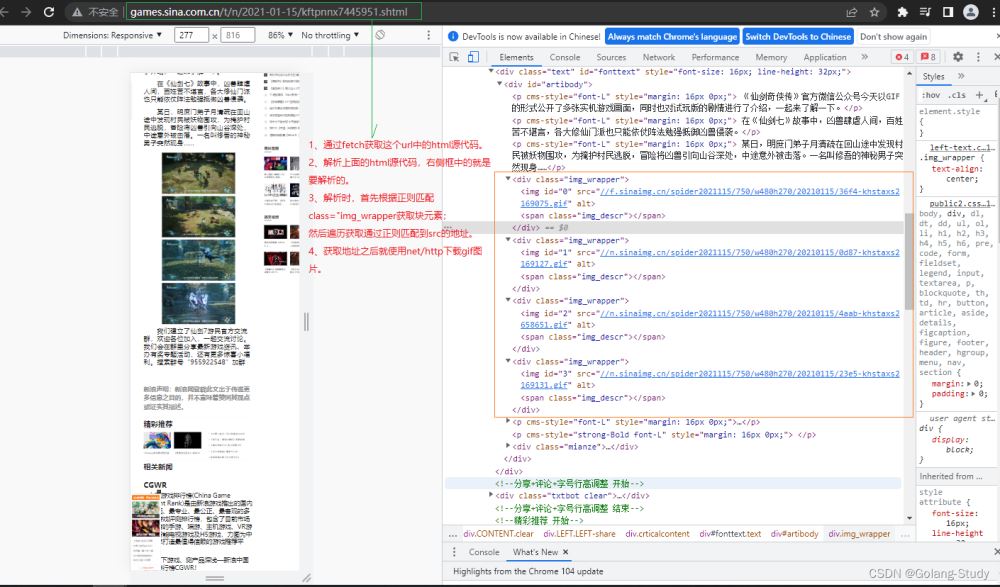

1、net/http爬虫

net/http配合正则表达式爬虫。

package main

import (

"fmt"

"io/ioutil"

"log"

"net/http"

"os"

"regexp"

"strings"

"sync"

)

// 负责抓取页面的源代码(html)

// 通过http包实现

func fetch(url string) string {

// 得到一个客户端

client := &http.Client{}

request, _ := http.NewRequest("GET", url, nil)

request.Header.Set("User-Agent", "Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/104.0.0.0 Mobile Safari/537.36")

request.Header.Add("Cookie", "test_cookie=CheckForPermission; expires=Tue, 30-Aug-2022 01:04:32 GMT; path=/; domain=.doubleclick.net; Secure; HttpOnly; SameSite=none")

// 客户端发送请求,并且获取一个响应

response, err := client.Do(request)

if err != nil {

log.Println("Error: ", err)

return ""

}

// 如果状态码不是200,就是响应错误

if response.StatusCode != 200 {

log.Println("Error: ", response.StatusCode)

return ""

}

defer response.Body.Close() // 关闭

// 读取响应体中的所有数据到body中,这就是需要的部分

body, err := ioutil.ReadAll(response.Body)

if err != nil {

log.Println("Error: ", err)

return ""

}

// 转换为字符串(字节切片 --> 字符串)

return string(body)

}

var waitGroup sync.WaitGroup

// 解析页面源代码

func parseURL(body string) {

// 将body(响应结果)中的换行替换掉,防止正则匹配出错

html := strings.Replace(body, "\n", "", -1)

// 正则匹配

re_Img_div := regexp.MustCompile(`<div class="img_wrapper">(.*?)</div>`)

img_div := re_Img_div.FindAllString(html, -1) // 得到<div><img alt="Go爬虫(http、goquery和colly)详解" ></div>

for _, v := range img_div {

// img正则

re_link := regexp.MustCompile(`src="(.*?)"`)

// 找到所有的图片链接

links := re_link.FindAllString(v, -1) // 得到所有图片链接

// 遍历links,切掉不必要的部分src="和最后的"

for _, v := range links {

src := v[5 : len(v)-1]

src = "http:" + src

waitGroup.Add(1)

go downLoad(src)

}

}

}

// 下载

func downLoad(src string) {

fmt.Println("================================", src)

// 取一个文件名

filename := string(src[len(src)-8 : len(src)])

fmt.Println(filename)

response, _ := http.Get(src)

picdata, _ := ioutil.ReadAll(response.Body)

image, _ := os.Create("./files/" + filename)

image.Write(picdata)

defer func() {

image.Close()

waitGroup.Done()

}()

}

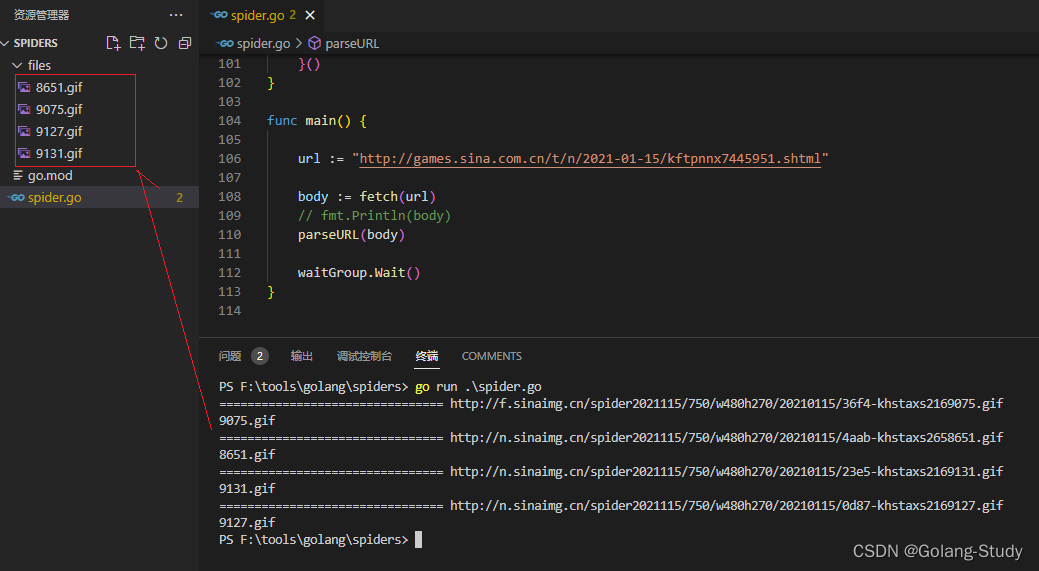

func main() {

url := "http://games.sina.com.cn/t/n/2021-01-15/kftpnnx7445951.shtml"

body := fetch(url)

// fmt.Println(body)

parseURL(body)

waitGroup.Wait()

}

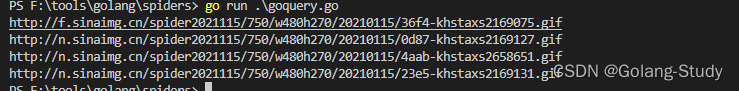

2、goquery库爬虫

goquery可以避免操作复杂的正则表达式,它可以直接根据url获取一个Document对象,然后根据标签选择器、类选择器和id选择器获取相应的选择对象,进行自定义的操作。

goquery可以灵活的获取页面中的元素。

*** 一个简单的例子,引出goquery中的重要API

package main

import (

"fmt"

"strings"

"github.com/PuerkitoBio/goquery"

)

func main() {

url := "http://games.sina.com.cn/t/n/2021-01-15/kftpnnx7445951.shtml"

// 得到页面原文档对象

d, _ := goquery.NewDocument(url)

// 根据文档对象借助类选择器获取Selection对象,通过Each遍历所有的适配类选择器的对象

// Each的参数是一个函数,里面是处理逻辑

d.Find("img").Each(func(index int, s *goquery.Selection) {

// 根据属性名获取属性值 一个Selection对象 --> <img src="http://localhost:8080/images" alt="Go爬虫(http、goquery和colly)详解" > text

text, _ := s.Attr("src")

// 只处理gif动态图片

if strings.HasSuffix(text, ".gif") {

text = "http:" + text

fmt.Println(text)

}

})

}

*** 操作一、获取html整个原文档

分别是goquery.NewDocument(url string)、goquery.NewDocumentFromResponse(*http.Response)、goquery.NewDocumentFromReader(*io.Reader)。三种方式的第一种比较最为方便使用。

package main

import (

"log"

"net/http"

"strings"

"github.com/PuerkitoBio/goquery"

)

/*

goquery得到Document对象的3种方式

*/

// 1、通过NewDocument传入一个URL地址

func GetDocument_1(url string) string {

document, _ := goquery.NewDocument(url)

document.Find("href")

return "document.Text()"

}

// 2、通过响应获取。第一种方式是第二种方式的封装

func GetDocument_2(url string) string {

client := &http.Client{}

request, _ := http.NewRequest("GET", url, nil)

response, _ := client.Do(request)

document, err := goquery.NewDocumentFromResponse(response)

if err != nil {

log.Fatalln(err)

}

document.Find("")

return ""

}

// 3、有一个html文本的情况下,读取转换为Document对象

func GetDocument_3(html string) string {

document, _ := goquery.NewDocumentFromReader(strings.NewReader(html))

document.Find("")

return ""

}

*** 操作二、选择器

同html的标识方式,在Find函数中。

*** 操作三、Selection相关方法

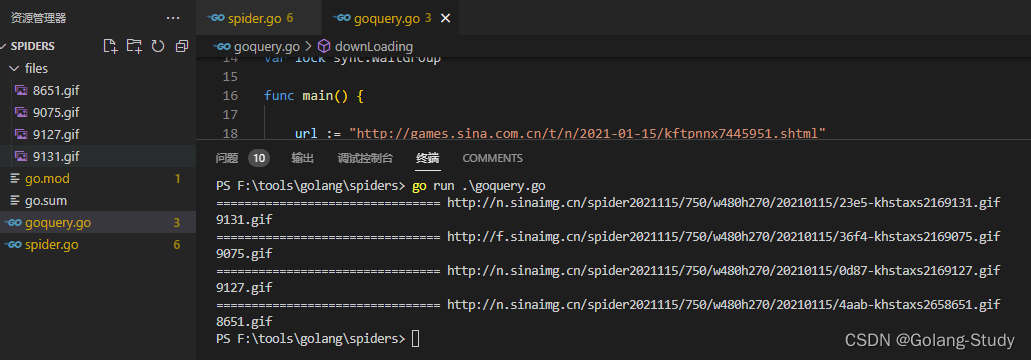

*** 最后来完成net/http中的网页爬虫

package main

import (

"fmt"

"io/ioutil"

"net/http"

"os"

"strings"

"sync"

"github.com/PuerkitoBio/goquery"

)

var lock sync.WaitGroup

func main() {

url := "http://games.sina.com.cn/t/n/2021-01-15/kftpnnx7445951.shtml"

// 得到页面原文档对象

d, _ := goquery.NewDocument(url)

// 根据文档对象借助类选择器获取Selection对象,通过Each遍历所有的适配类选择器的对象

// Each的参数是一个函数,里面是处理逻辑

d.Find("img").Each(func(index int, s *goquery.Selection) {

// 根据属性名获取属性值 一个Selection对象 --> <img src="http://localhost:8080/images" alt="Go爬虫(http、goquery和colly)详解" > text

text, _ := s.Attr("src")

// 只处理gif动态图片

if strings.HasSuffix(text, ".gif") {

lock.Add(1)

http := "http:" + text

// 得到图片地址,开启协程下载图片

go downLoading(http)

}

})

lock.Wait()

}

func downLoading(src string) {

fmt.Println("================================", src)

// 取一个文件名

filename := string(src[len(src)-8 : len(src)])

fmt.Println(filename)

response, _ := http.Get(src)

picdata, _ := ioutil.ReadAll(response.Body)

image, _ := os.Create("./files/" + filename)

image.Write(picdata)

defer func() {

image.Close()

lock.Done()

}()

}

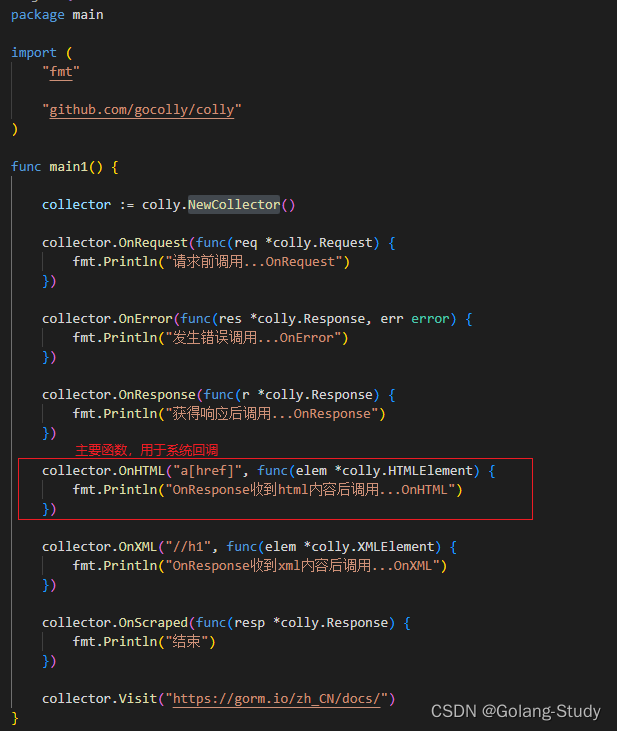

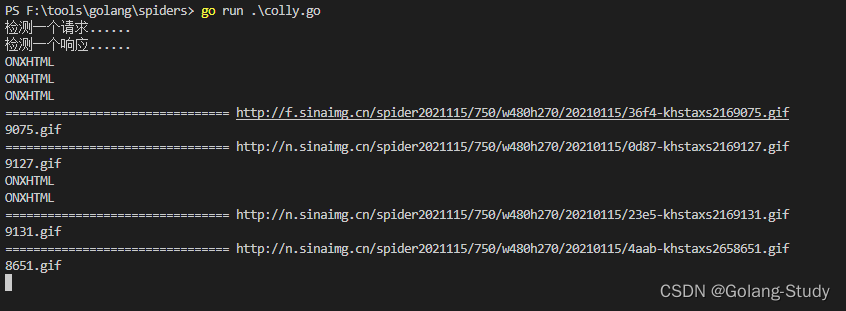

3、colly框架爬虫

首先要获取一个*colly.Collector对象;

然后注册处理函数OnXxx函数;

之后就可以访问url了。

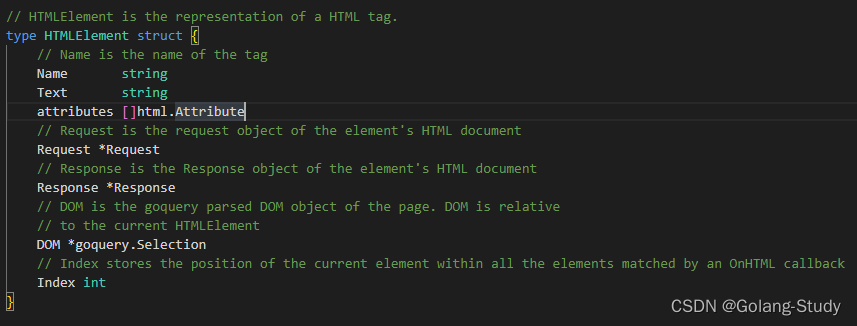

*** OnXxx函数

主要操作都是由OnXxx函数的参数函数进行处理的

*** 完成图片的爬取

package main

import (

"fmt"

"io/ioutil"

"net/http"

"os"

"strings"

"sync"

"github.com/gocolly/colly"

)

var locker sync.WaitGroup

func main() {

col := colly.NewCollector()

// 检测请求

col.OnRequest(func(req *colly.Request) {

fmt.Println("检测一个请求......")

})

// 检测响应

col.OnResponse(func(r *colly.Response) {

fmt.Println("检测一个响应......")

})

// 定位img标签。注册该函数,框架内部回调

col.OnHTML("img", func(elem *colly.HTMLElement) {

fmt.Println("ONXHTML")

// 获取标签对应属性的值。

// 其他对标签的操作,可以查看对应的API

http := elem.Attr("src")

if strings.HasSuffix(http, ".gif") {

locker.Add(1)

http := "http:" + http

go DownLoad(http)

}

})

col.Visit("http://games.sina.com.cn/t/n/2021-01-15/kftpnnx7445951.shtml")

locker.Wait()

}

func DownLoad(src string) {

fmt.Println("================================", src)

// 取一个文件名

filename := string(src[len(src)-8 : len(src)])

fmt.Println(filename)

response, _ := http.Get(src)

picdata, _ := ioutil.ReadAll(response.Body)

image, _ := os.Create("./files/" + filename)

image.Write(picdata)

defer func() {

image.Close()

locker.Done()

}()

}

今天带大家了解了爬虫、goquery、colly的相关知识,希望对你有所帮助;关于Golang的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

-

308 收藏

-

331 收藏

-

263 收藏

-

427 收藏

-

459 收藏

-

399 收藏

-

166 收藏

-

445 收藏

-

115 收藏

-

296 收藏

-

448 收藏

-

111 收藏

-

453 收藏

-

140 收藏

-

497 收藏

-

109 收藏

-

407 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习