开源LLMS应该得到代码,而不是提示! (DSPY,瞧!)

时间:2025-02-03 09:22:06 114浏览 收藏

小伙伴们有没有觉得学习文章很有意思?有意思就对了!今天就给大家带来《开源LLMS应该得到代码,而不是提示! (DSPY,瞧!)》,以下内容将会涉及到,若是在学习中对其中部分知识点有疑问,或许看了本文就能帮到你!

DSPY:将提示工程转变为提示编程的革命性框架

大型语言模型 (LLM) 时代,新模型层出不穷。然而,充分发挥 LLM 的潜力往往依赖于繁琐易错的提示工程。DSPY 应运而生,它是一个开源框架,彻底改变了我们与 LLM 交互的方式。DSPY 将提示视为可训练、模块化的组件,而非静态文本,并通过编程方式进行优化。

为什么选择 DSPY?

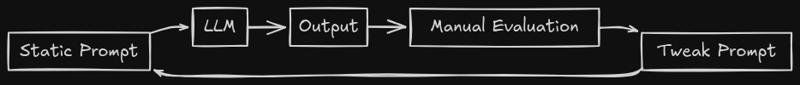

传统的提示工程依赖于脆弱的手工编写的指令。例如,要求 LLM “写一首关于 DSPY 的诗” 可能会得到不一致的结果。开发者不得不反复调整提示,但这方法效率低下,存在以下问题:

- 难以扩展到多步推理等复杂任务。

- 跨模型或领域的泛化能力差。

- 需要大量手动尝试,浪费时间和资源。

DSPY 提供了解决方案:它将提示定义为类似代码的模块,并自动优化以获得最佳性能。它将 LLM 视为管道中的组件,使用远程编译器(优化器)迭代优化提示和权重。其核心理念包括:

- 代码优先的提示: 开发者专注于模型应该做什么,而非如何去做。

- 自我改进: DSPY 程序从数据中学习,优化自身的提示和逻辑。

- 模型无关: 可与任何 LLM 配合使用,例如 GPT-4、Llama 3 和 Claude 等。

DSPY 的核心组成部分:

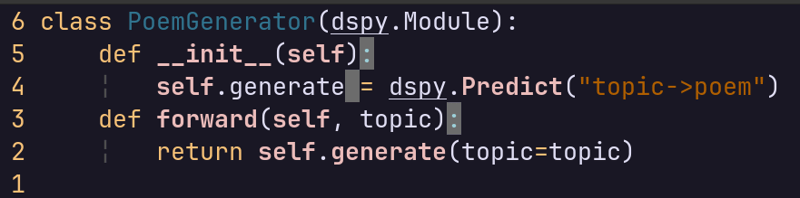

- 模块: 可重复使用的、特定于任务的构建块,例如

dspy.predict(用于生成文本)、dspy.Chainofthought(用于逐步推理)和dspy.retrieve(用于整合检索结果)。 一个简单的模块定义如下:

<code># 模块定义示例</code>

- 签名: 类似于合约,用于提示优化。它指定了任务中 LLM 的预期行为。例如,主题 -> 诗歌。

-

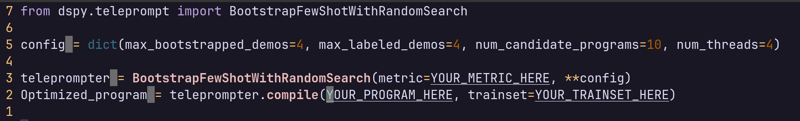

远程编译器(优化器): 自动化提示优化的工具,例如

BootstrapFewShot、BayesianOptimizer和MIPRO(多目标指令提案优化器)。 -

指标: 指导优化的指标(例如,准确性、BLEU 分数)。DSPY 通过调整提示和示例来最大化这些指标。

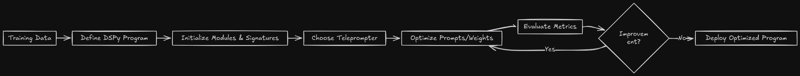

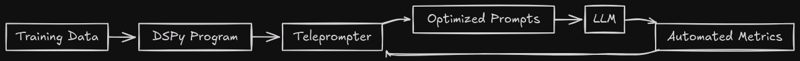

DSPY 的工作流程:

- 定义程序: 将模块组装成管道。

- 初始化: 设置初始提示和模型权重。

- 优化: 迭代测试并调整提示。

- 评估: 使用指标评估新提示的性能。

- 部署: 部署性能最佳的提示进行推理。

DSPY 与传统方法的对比:

(传统方法) vs.

(传统方法) vs.  (DSPY 方法)

(DSPY 方法)

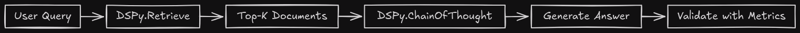

DSPY 的应用案例:

- 检索增强型生成 (RAG): DSPY 共同优化检索和生成提示,解决静态 RAG 管道经常检索到无关信息的问题。

- 微调协调: 使用 DSPY 生成微调样本,简化微调过程。

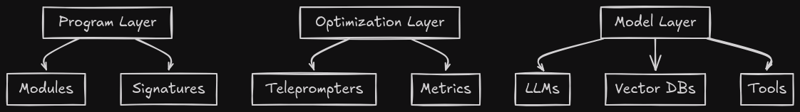

DSPY 架构:

- 程序层: 用户定义的管道。

- 优化层: 远程编译器和指标。

- 模型层: 集成 LLM、向量数据库和外部工具。

结论:

DSPY 将范式从 提示工程 转变为 提示编程,将 提示 转化为构建强大、自我改进的 LLM 应用程序的工具。通过将提示转换为可训练模块并自动化优化,DSPY 帮助我们大规模高效地使用开源 LLM。 无论是构建 RAG 系统、多模态代理还是自适应管道,DSPY 都是关键。

请访问 DSPY 官方文档了解更多信息。

理论要掌握,实操不能落!以上关于《开源LLMS应该得到代码,而不是提示! (DSPY,瞧!)》的详细介绍,大家都掌握了吧!如果想要继续提升自己的能力,那么就来关注golang学习网公众号吧!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

378 收藏

-

412 收藏

-

110 收藏

-

349 收藏

-

231 收藏

-

427 收藏

-

252 收藏

-

315 收藏

-

479 收藏

-

484 收藏

-

297 收藏

-

247 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习