让大模型不再「巨无霸」,这是一份最新的大模型参数高效微调综述

来源:机器之心

时间:2024-05-01 17:27:10 470浏览 收藏

哈喽!今天心血来潮给大家带来了《让大模型不再「巨无霸」,这是一份最新的大模型参数高效微调综述》,想必大家应该对科技周边都不陌生吧,那么阅读本文就都不会很困难,以下内容主要涉及到,若是你正在学习科技周边,千万别错过这篇文章~希望能帮助到你!

AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。

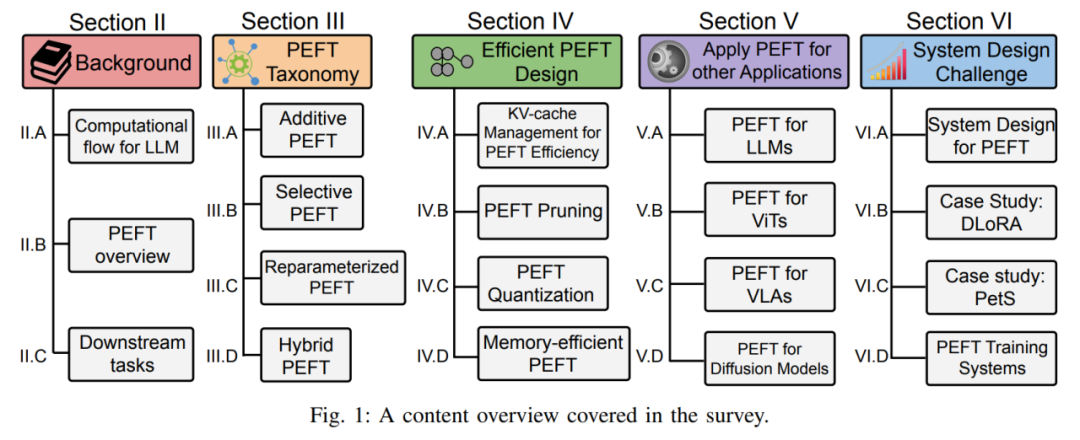

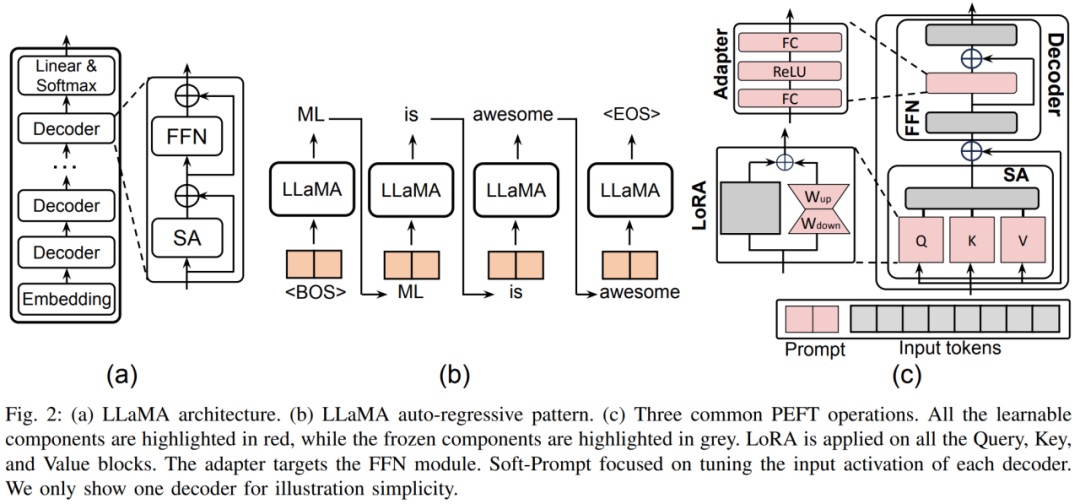

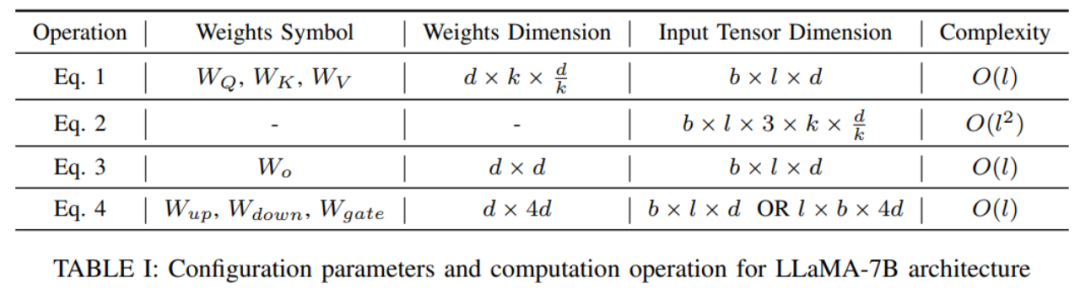

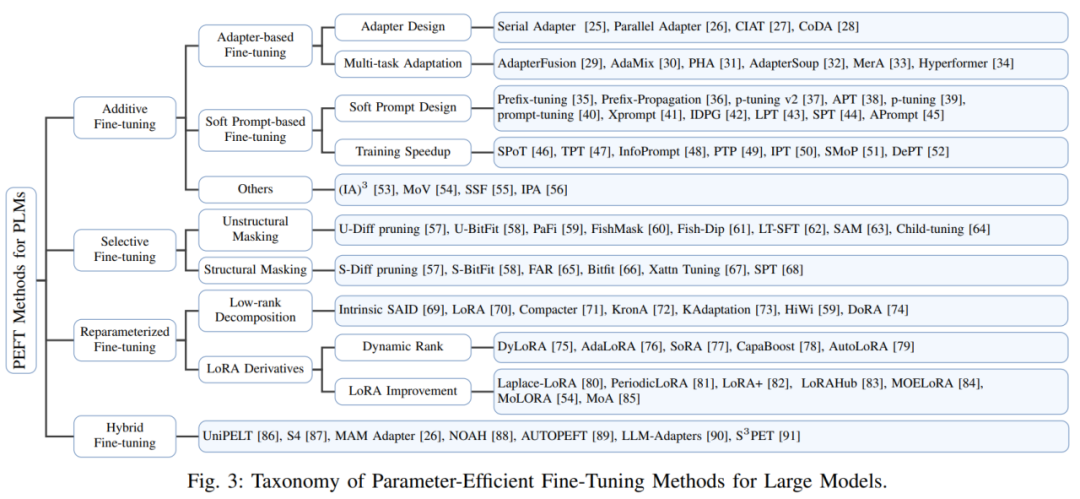

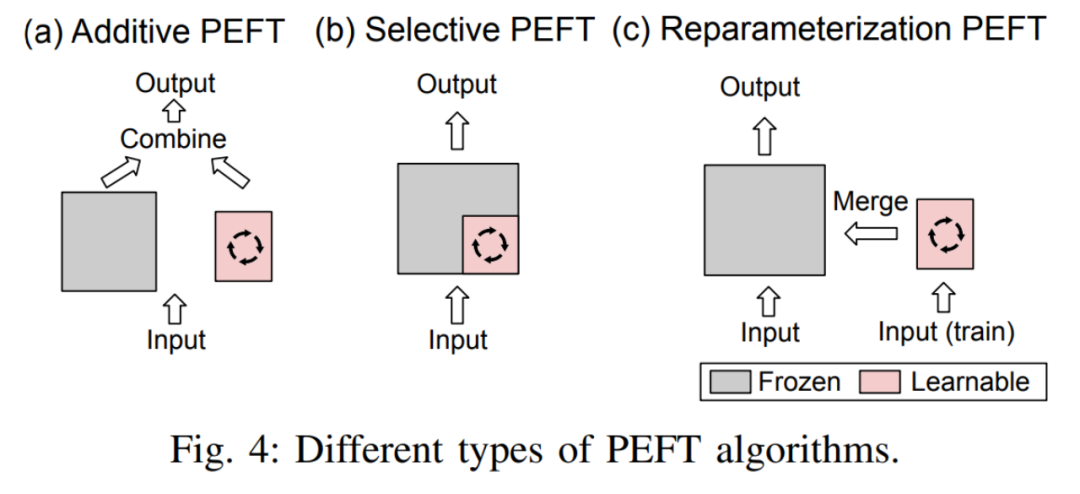

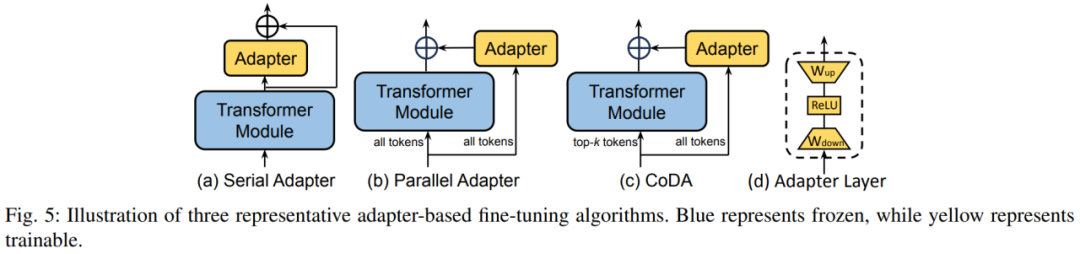

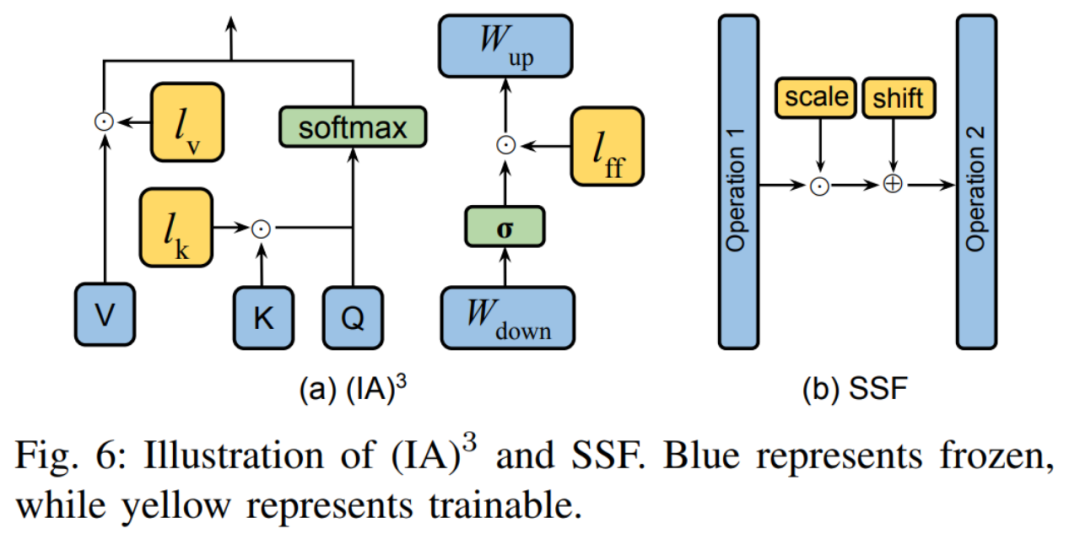

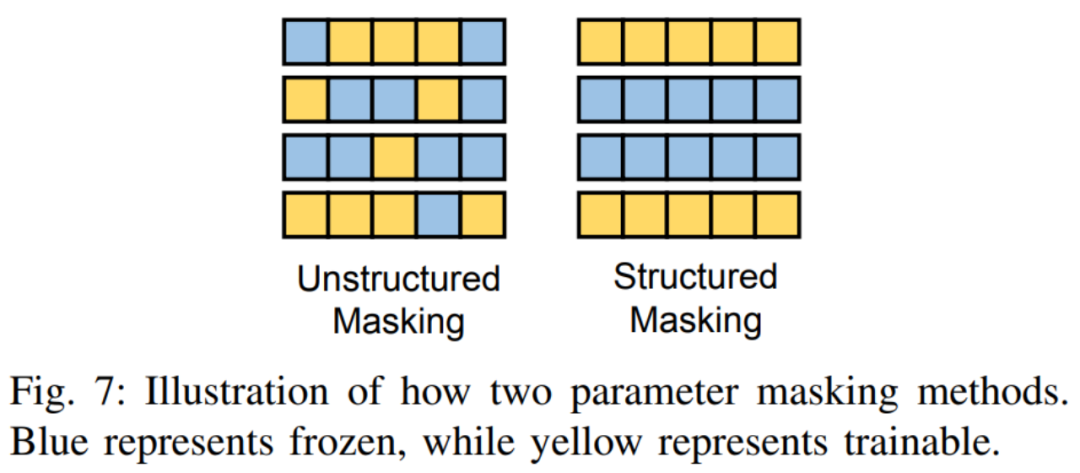

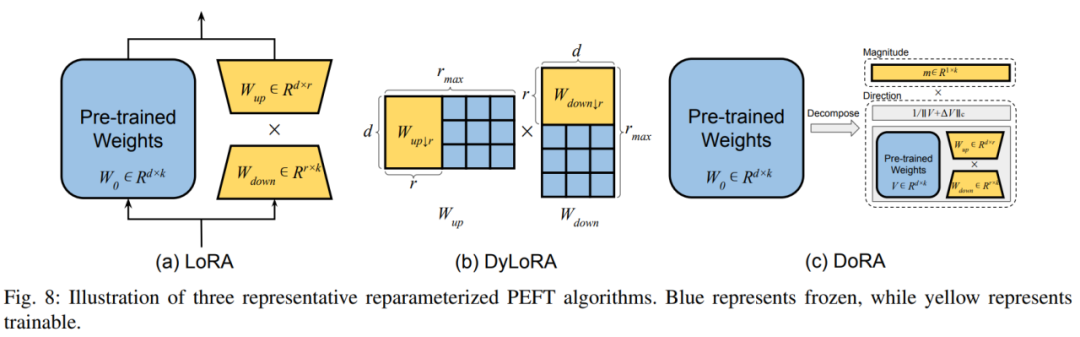

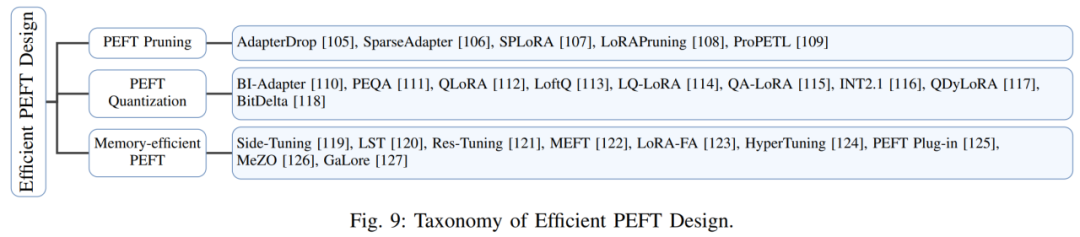

作者首先给出了加性微调、选择性微调、重参数化微调和混合微调的定义:

加性微调通过在预训练模型的特定位置添加可学习的模块或参数,以最小化适配下游任务时模型的可训练的参数量。 选择性微调在微调过程中只更新模型中的一部分参数,而保持其余参数固定。相较于加性微调,选择性微调无需更改预训练模型的架构。 重参数化微调通过构建预训练模型参数的(低秩的)表示形式用于训练。在推理时,参数将被等价的转化为预训练模型参数结构,以避免引入额外的推理延迟。

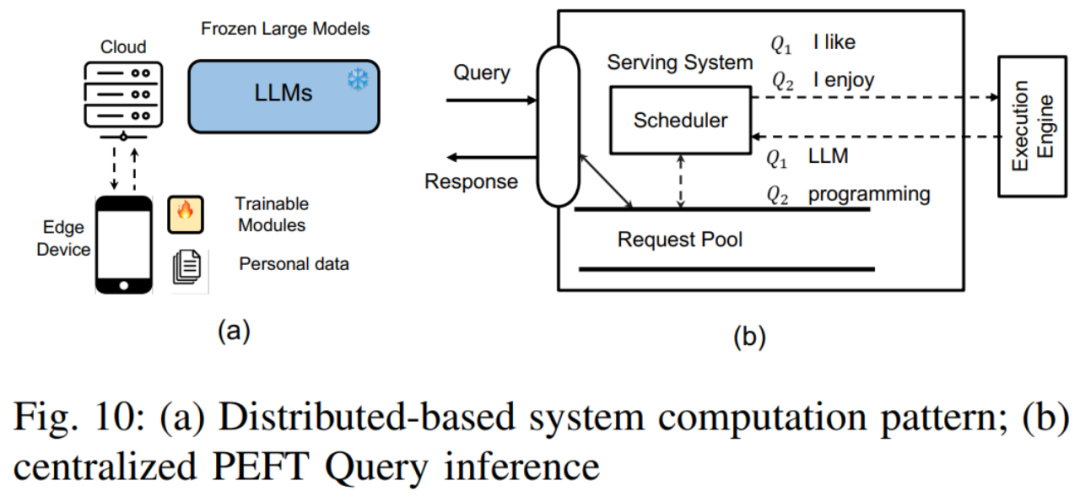

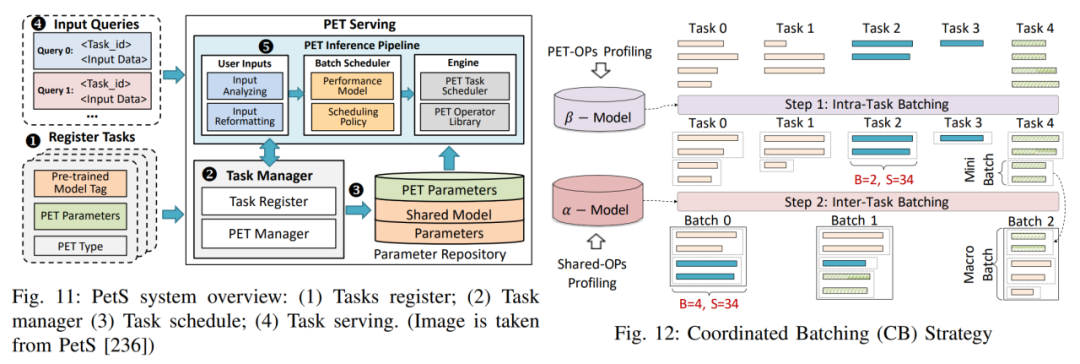

多 PEFT 训练:挑战包括如何管理内存梯度和模型权重存储,以及如何设计一个有效的内核来批量训练 PEFT 等。

多 PEFT 训练:挑战包括如何管理内存梯度和模型权重存储,以及如何设计一个有效的内核来批量训练 PEFT 等。

今天关于《让大模型不再「巨无霸」,这是一份最新的大模型参数高效微调综述》的内容就介绍到这里了,是不是学起来一目了然!想要了解更多关于理论,参数高效微调的内容请关注golang学习网公众号!

声明:本文转载于:机器之心 如有侵犯,请联系study_golang@163.com删除

相关阅读

更多>

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

最新阅读

更多>

-

215 收藏

-

340 收藏

-

190 收藏

-

283 收藏

-

103 收藏

-

252 收藏

-

254 收藏

-

151 收藏

-

367 收藏

-

325 收藏

-

211 收藏

-

144 收藏

课程推荐

更多>

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习