检索总结能力超博士后,首个大模型科研智能体PaperQA2开源了

来源:机器之心

时间:2024-09-21 13:21:18 138浏览 收藏

IT行业相对于一般传统行业,发展更新速度更快,一旦停止了学习,很快就会被行业所淘汰。所以我们需要踏踏实实的不断学习,精进自己的技术,尤其是初学者。今天golang学习网给大家整理了《检索总结能力超博士后,首个大模型科研智能体PaperQA2开源了》,聊聊,我们一起来看看吧!

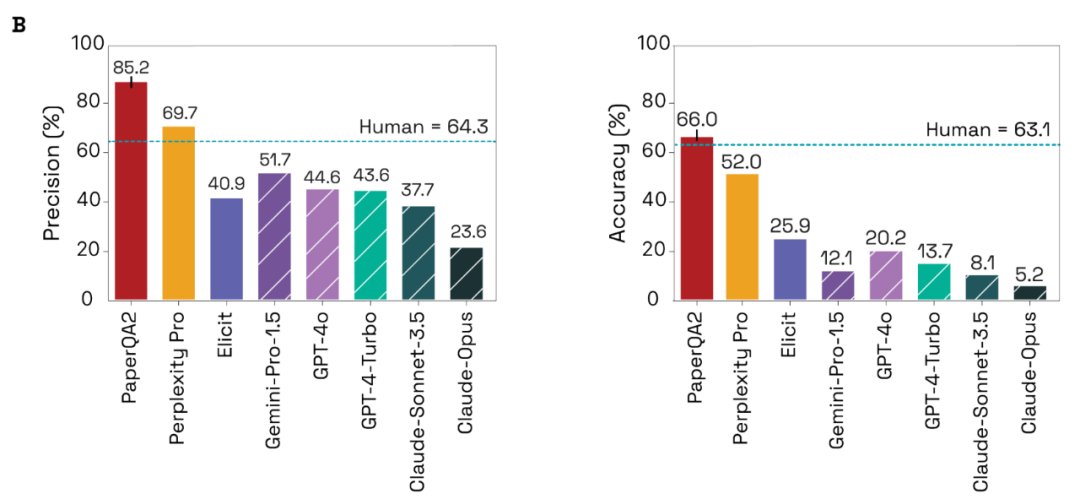

这是 AI 智能体在大部分科学研究中超越人类的第一个案例,或许会彻底改变人类与科学文献互动的方式。

论文地址:https://storage.googleapis.com/fh-public/paperqa/Language_Agents_Science.pdf GitHub 链接:https://github.com/Future-House/paper-qa

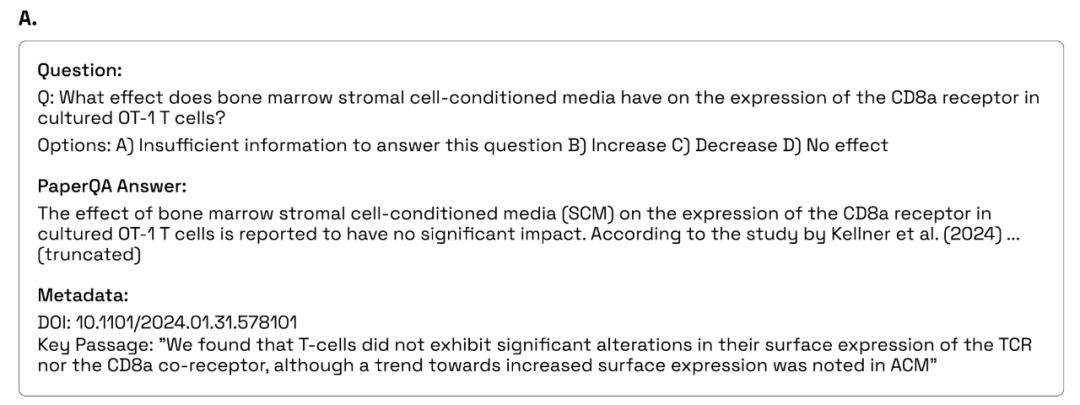

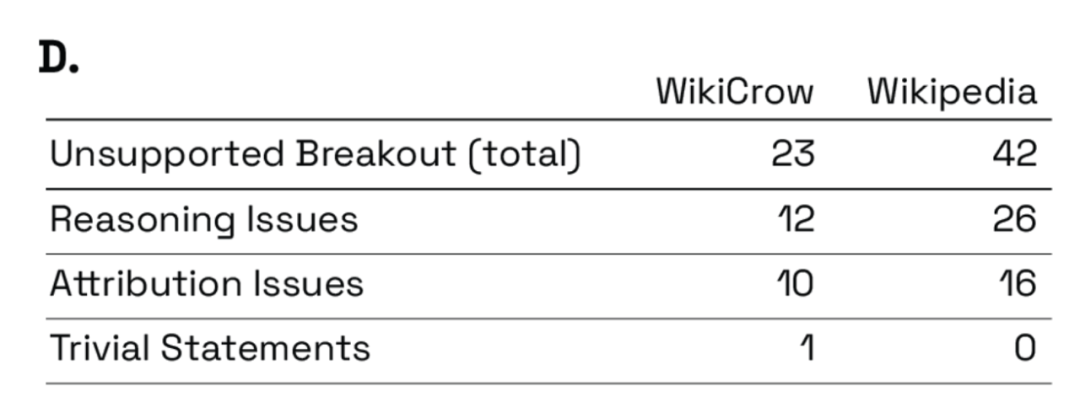

推理问题,即书面信息自相矛盾、过度推断或不受任何引用支持; 归因问题,即信息可能得到另一个包含的来源支持,但该声明在本地没有包含正确的引用或来源太宽泛(例如数据库门户链接); 琐碎的声明,这些声明虽是真实的段落,但过于迂腐或没有必要。

本篇关于《检索总结能力超博士后,首个大模型科研智能体PaperQA2开源了》的介绍就到此结束啦,但是学无止境,想要了解学习更多关于科技周边的相关知识,请关注golang学习网公众号!

声明:本文转载于:机器之心 如有侵犯,请联系study_golang@163.com删除

相关阅读

更多>

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

最新阅读

更多>

-

482 收藏

-

377 收藏

-

397 收藏

-

438 收藏

-

432 收藏

-

165 收藏

-

223 收藏

-

102 收藏

-

469 收藏

-

261 收藏

-

475 收藏

-

226 收藏

课程推荐

更多>

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习