自动化、可复现,基于大语言模型群体智能的多维评估基准Decentralized Arena来了

来源:机器之心

时间:2024-10-26 08:12:41 295浏览 收藏

对于一个科技周边开发者来说,牢固扎实的基础是十分重要的,golang学习网就来带大家一点点的掌握基础知识点。今天本篇文章带大家了解《自动化、可复现,基于大语言模型群体智能的多维评估基准Decentralized Arena来了》,主要介绍了,希望对大家的知识积累有所帮助,快点收藏起来吧,否则需要时就找不到了!

AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

Maitrix.org 是由 UC San Diego, John Hopkins University, CMU, MBZUAI 等学术机构学者组成的开源组织,致力于发展大语言模型 (LLM)、世界模型 (World Model)、智能体模型 (Agent Model) 的技术以构建 AI 驱动的现实。Maitrix.org 此前成功开发了 Pandora 视频-语言世界模型、LLM Reasoners,以及 MMToM-QA 评测(ACL 2024 Outstanding Paper Award)。

研究者们已经并陆续构建了成千上万的大规模语言模型(LLM),这些模型的各项能力(如推理和生成)也越来越强。因此,在多样的应用场景中对其进行性能基准测试已成为了一项重大挑战。目前最受欢迎的基准测试是 Chatbot Arena,它通过收集用户对模型输出的偏好来对 LLM 进行综合排名。然而,随着 LLM 逐渐落地于众多应用场景,无论是针对工业生产目标,还是科学场景辅助需求,评估 LLM 在精细化维度上的能力都是至关重要的,例如:

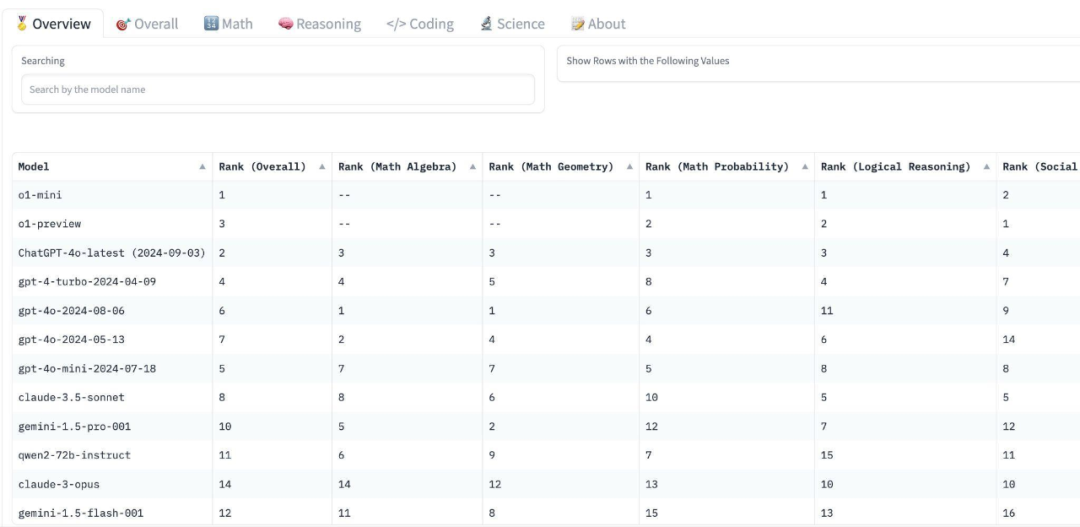

数学及其专门分支领域,如代数、几何、概率和微积分。

不同类型的推理能力,例如符号推理、类比推理、反事实推理和社会推理。

不同编程语言的编码能力,如 Python、C++、JavaScript 和 SQL。

各种科学领域,如物理学、生物学和化学。

以及任何与开发者实际应用相关的具体问题。

如此大规模且精细化(甚至定制化)的评估对于依赖于人群众包的 Chatbot Arena 或类似的基准测试来说是一大挑战 —— 在成百上千个维度上为数千对模型(或数万对模型)收集足够的用户投票是不切实际的。此外,由于人类查询和投票过程存在噪声以及个人主观因素,评估结果往往难以复现。

最近,研究者们还探索了其他的自动评估方案,通过选择一个(或几个)“最强” 模型(通常是 GPT-4)作为评委来评估所有其他模型。然而,评委模型可能存在偏见,例如更倾向于选择与其自身风格相似的输出。基于这种评估进行模型优化可能会导致所有模型过度拟合 GPT-4 的偏见。

为了结合这两种方案的优势,通过利用 “群体智能”(Chatbot Arena 依赖于人群智慧)来实现更稳健且更少偏见的评估,同时使该过程自动化且可扩展到多维度能力比较,Maitrix.org 发布了 Decentralized Arena。

原文地址: https://de-arena.maitrix.org

Leaderboards: https://huggingface.co/spaces/LLM360/de-arena

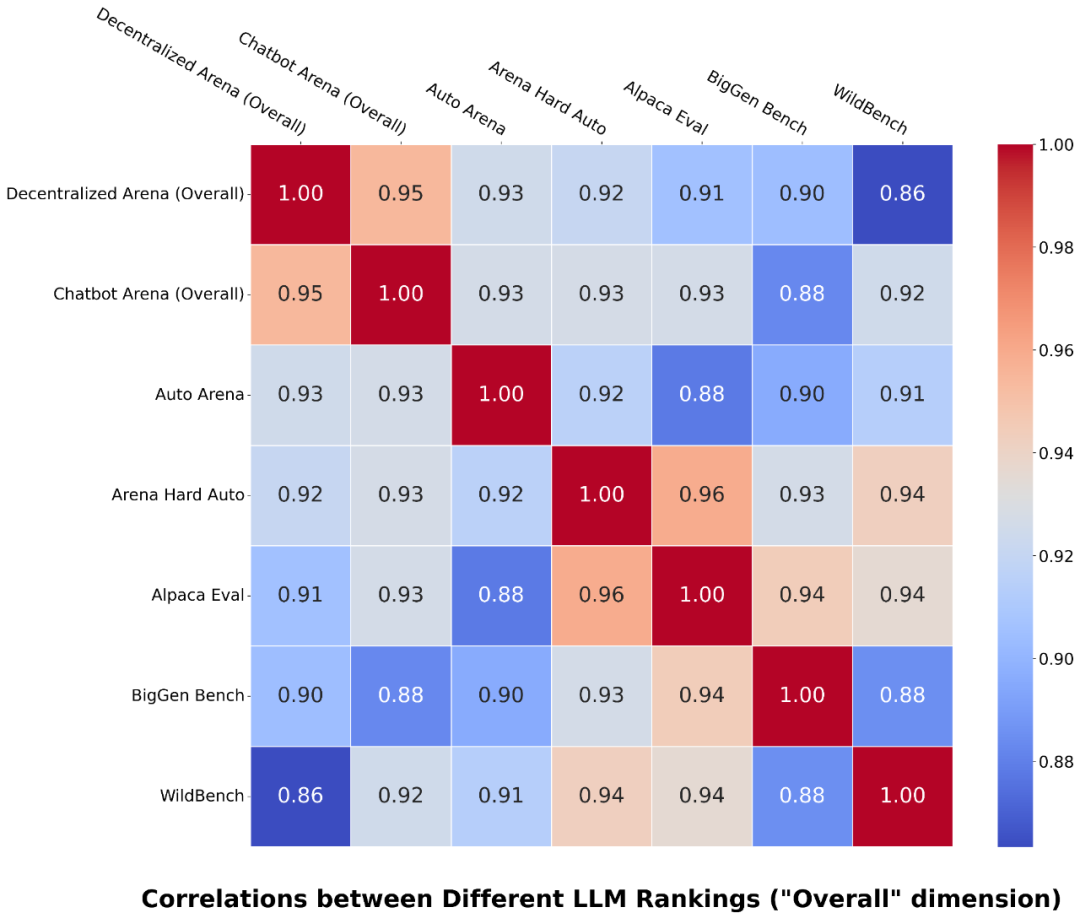

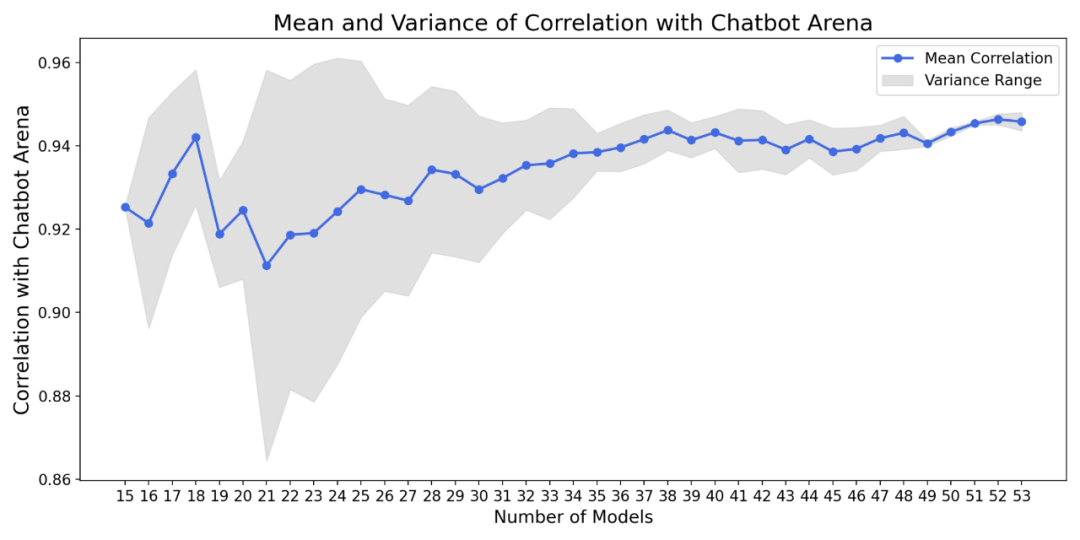

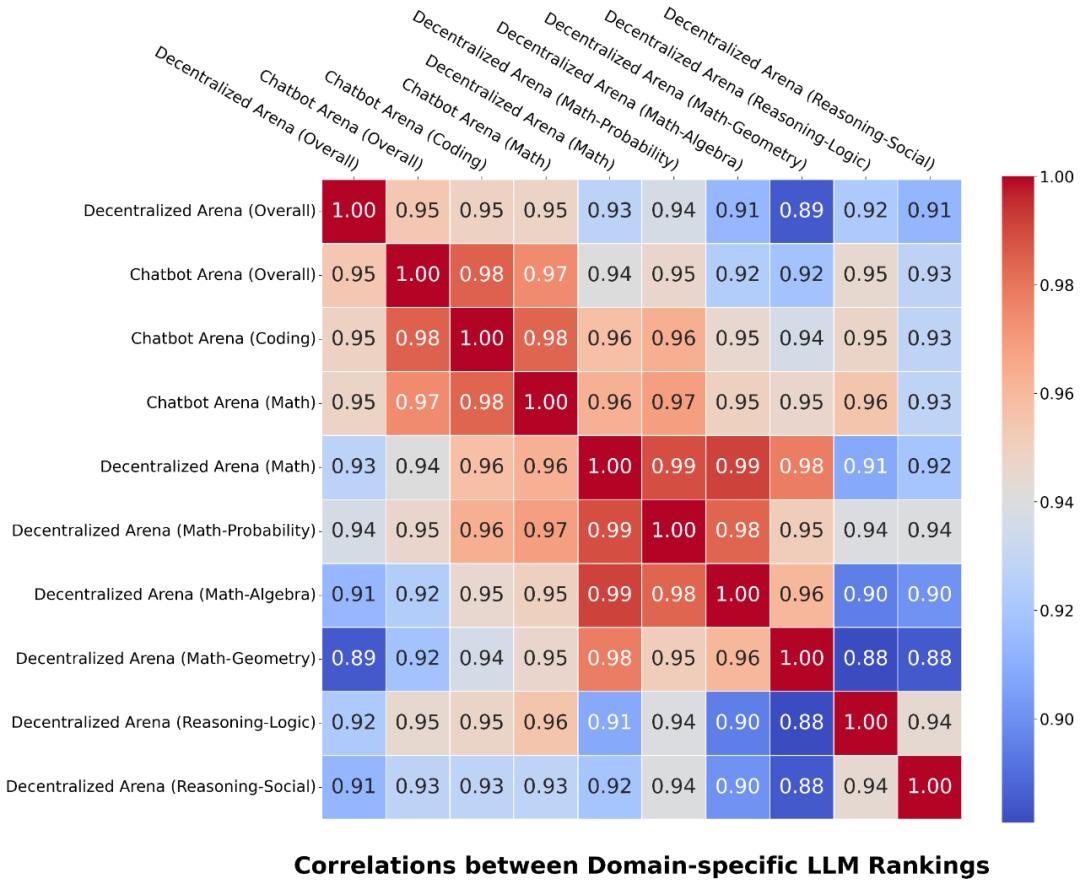

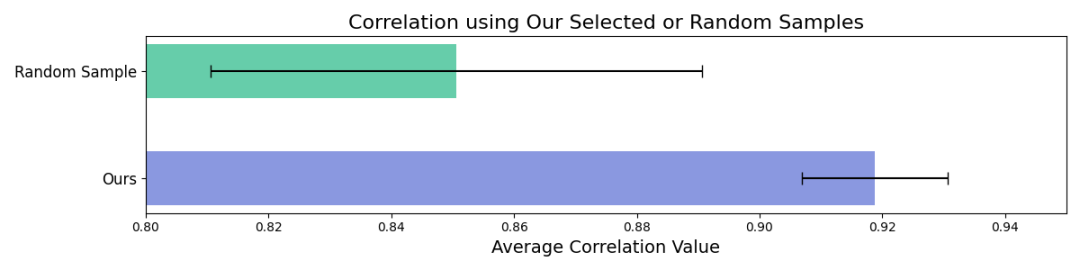

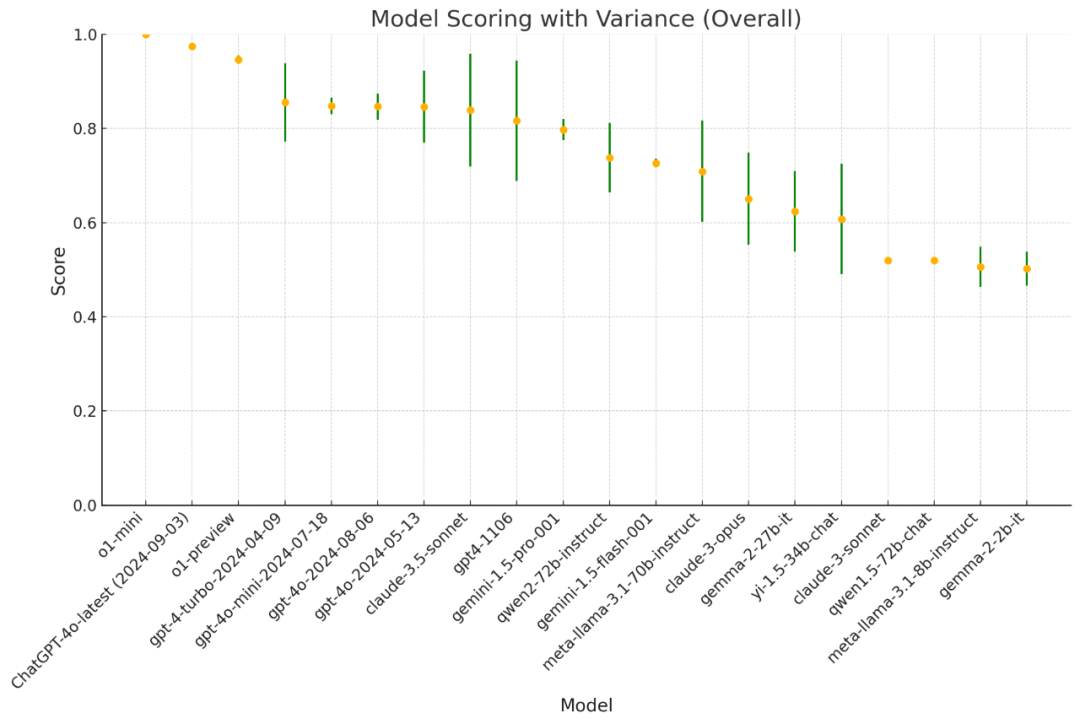

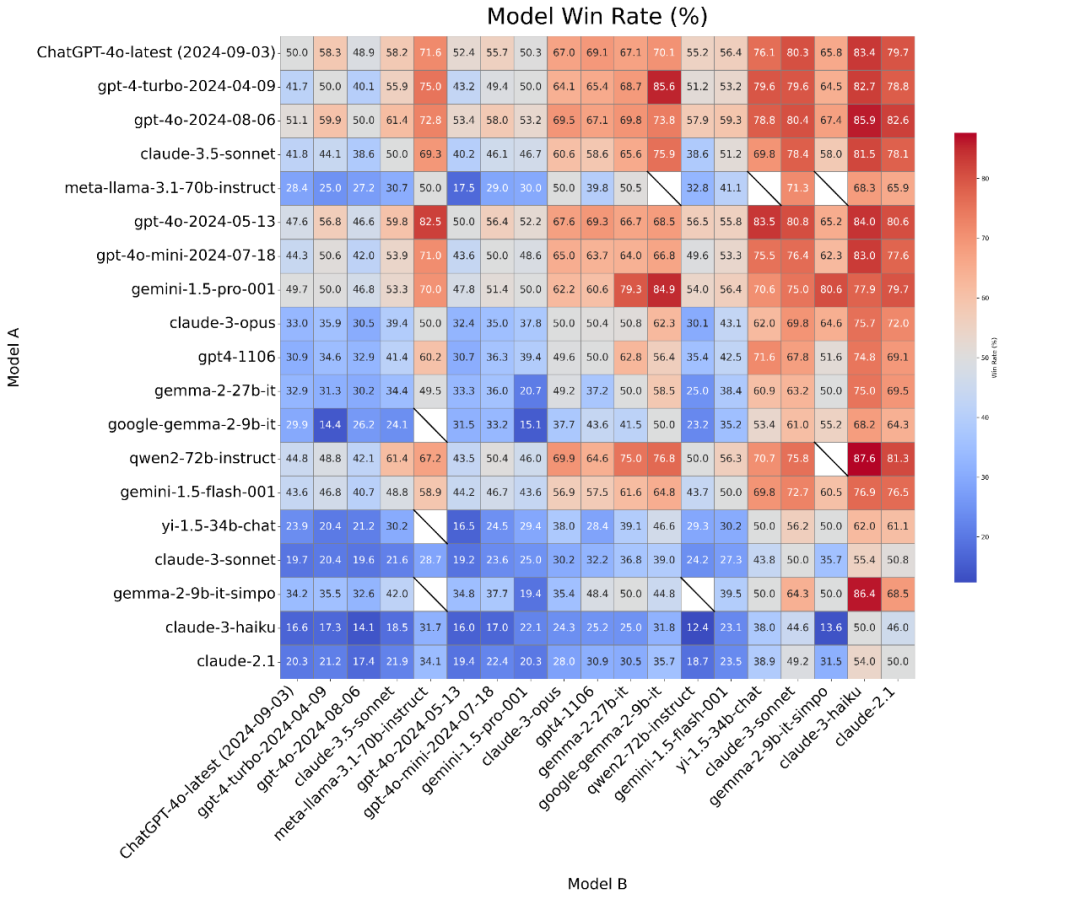

稳健且无偏:去中心化避免了单个或少数评委模型所带来的偏见,并且不容易通过过拟合评委模型进行操控。参与竞技场的 LLM 越多,评估越稳健(图 4)。此外,Decentralized Arena 在 50 多个模型的 “整体” 维度上与 Chatbot Arena 达到了非常高的相关性(95%,图 2)。

自动化、易于扩展且可定制到任何评估维度:由于用户投票的数量有限,Chatbot Arena 只能评估少数维度,而 Decentralized Arena 由于完全自动化的设计,其能够扩展到无限的评估维度,并且还提供了自动选择特定维度问题以实现定制化评估的方案。

快速、即时的新模型排名:同样,由于自动化和高效的二分搜索排名算法,Decentralized Arena 能够即时获得新模型的评估结果,无需等待数周以收集用户投票。

透明且完全可复现:所有算法、实现和输入 / 输出都会公开,使得结果完全可复现。

值得信赖:凭借其稳健性、与现有人类评估结果的高度一致性、精细的维度分析以及透明度,Decentralized Arena 最终旨在提供一个值得社区信赖的基准。

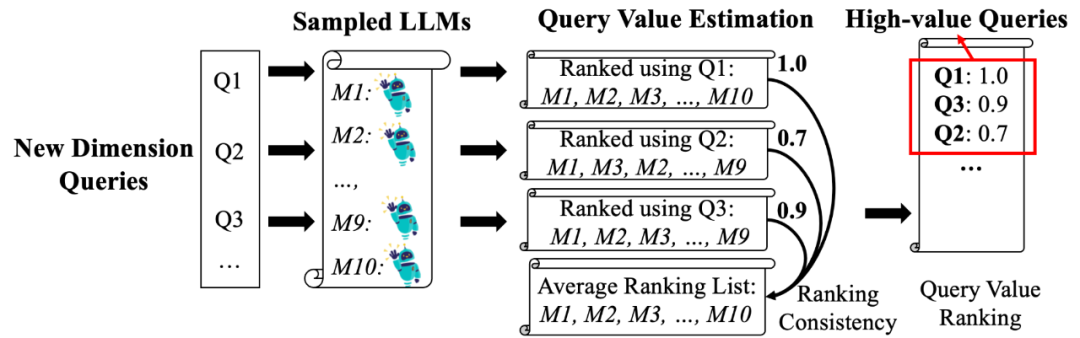

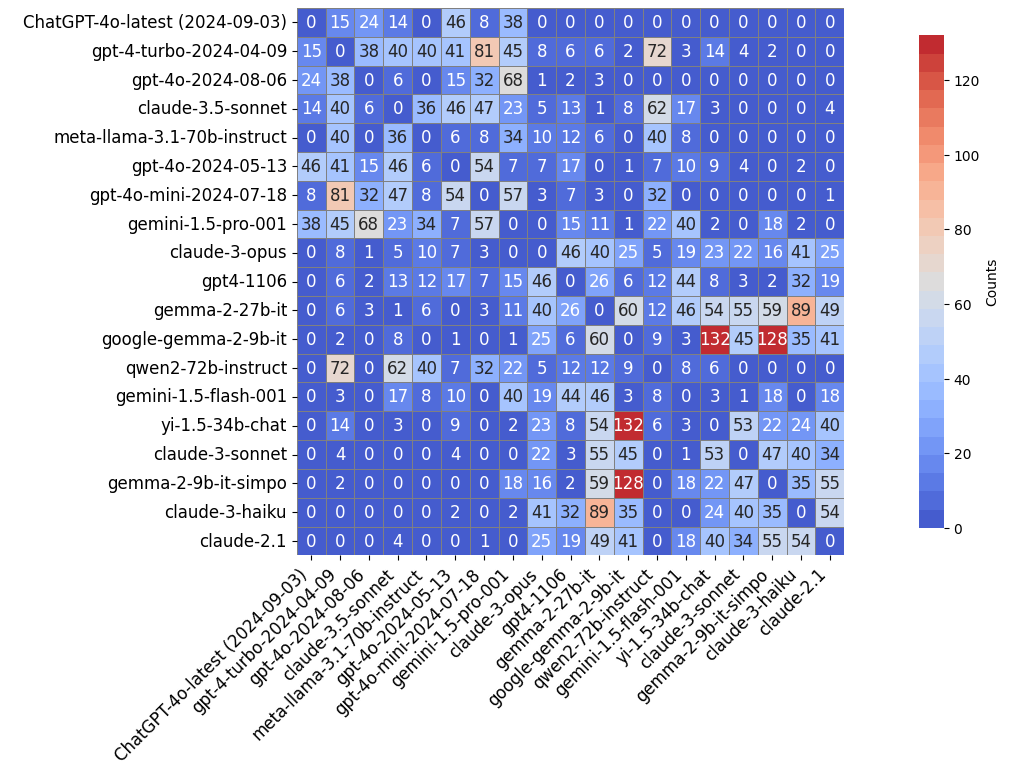

步骤 1: 基于二分搜索插入的粗略排名。该步骤旨在找到新模型在当前排名中的大致位置,其核心思想是使用二分搜索快速缩小位置范围。在比较新模型与现有模型时,排名中的其他模型将作为评审,该二分搜索的时间复杂度为 O (k*n*logn)。

步骤 2: 窗口内精细排名和滑动。为了进一步细化新模型的排名,该研究将它与排名中相邻的模型进行比较(例如,排名中前后两个模型)。这些相邻的 LLM 往往是最难区分的,因此需要进行更细致的比较。窗口外的所有其他模型将作为评审,如果窗口内的比较导致新模型的位置发生变化,则在更新后的窗口内重复该过程,直到排名稳定下来。此过程类似于一个滑动窗口,指导 LLM 群体关注最具模糊性的 LLM 比较对,确保精确排名并最小化计算成本。

终于介绍完啦!小伙伴们,这篇关于《自动化、可复现,基于大语言模型群体智能的多维评估基准Decentralized Arena来了》的介绍应该让你收获多多了吧!欢迎大家收藏或分享给更多需要学习的朋友吧~golang学习网公众号也会发布科技周边相关知识,快来关注吧!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

290 收藏

-

152 收藏

-

350 收藏

-

479 收藏

-

458 收藏

-

174 收藏

-

497 收藏

-

113 收藏

-

481 收藏

-

373 收藏

-

114 收藏

-

207 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习