决策过程是魔法还是科学?首个多模态大模型的可解释性综述全面深度剖析

时间:2024-12-21 15:46:12 237浏览 收藏

来到golang学习网的大家,相信都是编程学习爱好者,希望在这里学习科技周边相关编程知识。下面本篇文章就来带大家聊聊《决策过程是魔法还是科学?首个多模态大模型的可解释性综述全面深度剖析》,介绍一下,希望对大家的知识积累有所帮助,助力实战开发!

这篇综述论文探讨了多模态大型语言模型(MLLM)的可解释性。研究人员来自香港科技大学(广州)、上海人工智能实验室、中国人民大学和南洋理工大学。该论文对 MLLM 可解释性的研究进展进行了系统性梳理,并从数据、模型和训练/推理三个维度进行了深入分析。

本站 AIxiv 专栏长期报道全球顶级实验室的学术和技术成果,旨在促进学术交流。欢迎投稿或联系报道。联系邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

论文要点:

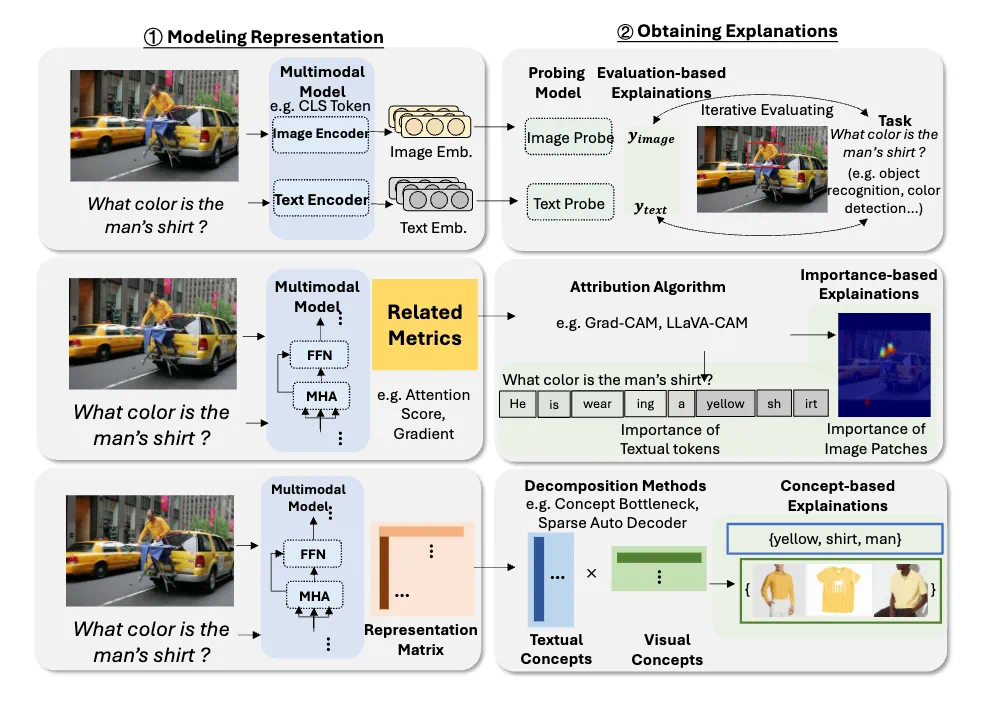

该论文提出了首个关于多模态大模型可解释性的全面综述。文章从三个维度探讨了 MLLM 的可解释性:

- 数据层面: 考察了输入输出数据、数据集和多模态数据对模型可解释性的影响。

- 模型层面: 分析了词元、特征、神经元、网络层级和整体架构在模型决策中的作用。

- 训练与推理过程: 探讨了训练和推理过程如何影响模型的可解释性。

论文还深入分析了当前研究面临的核心挑战,并展望了未来的发展方向,旨在提高多模态大模型的透明度和可信度。

- 论文标题:迈向可解释和可理解的多模态大型语言模型:一项全面综述 (Towards Explainable and Interpretable Multimodal Large Language Models: A Comprehensive Survey)

- 论文链接:https://arxiv.org/pdf/2412.02104

多模态大模型可解释性研究

近年来,大型语言模型(LLM)和计算机视觉(CV)技术的融合催生了多模态AI的蓬勃发展。多模态大模型在各种任务中展现出强大的能力,但其决策过程的缺乏透明度成为一个关键挑战。 这篇综述旨在解决这一问题,提升多模态大模型的可解释性和可信度。

研究维度:

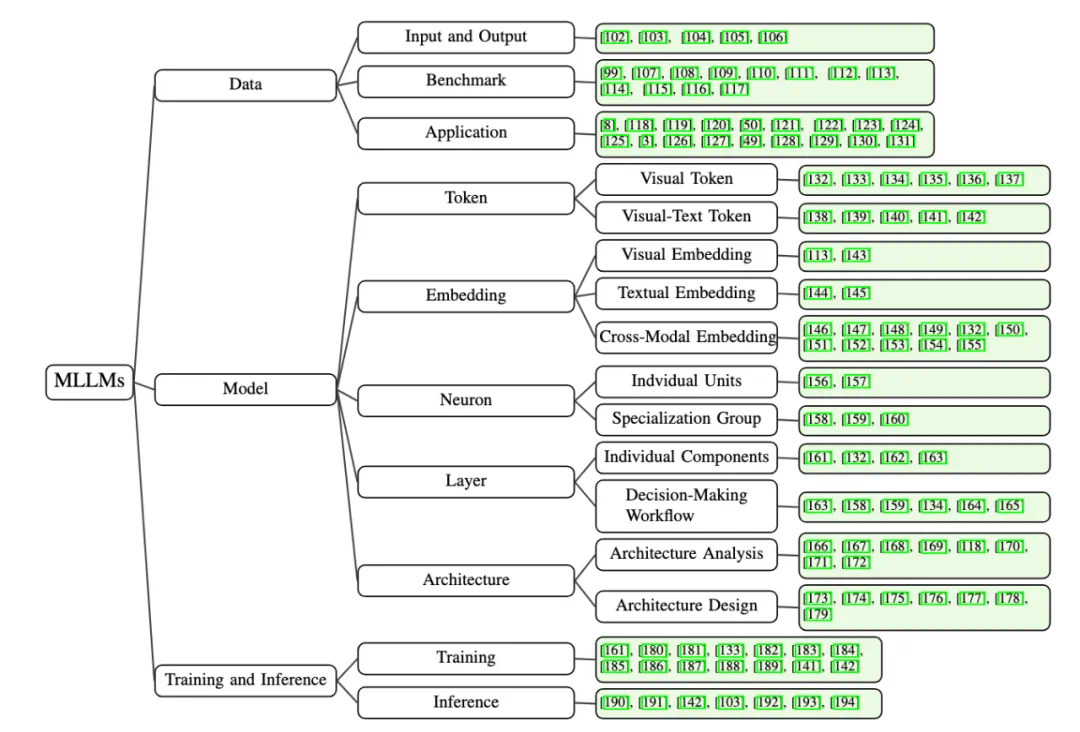

论文将现有的方法分为三个视角:数据、模型和训练/推理。

1. 数据视角: 关注输入和输出数据,不同数据集和多模态应用如何影响模型的可解释性。

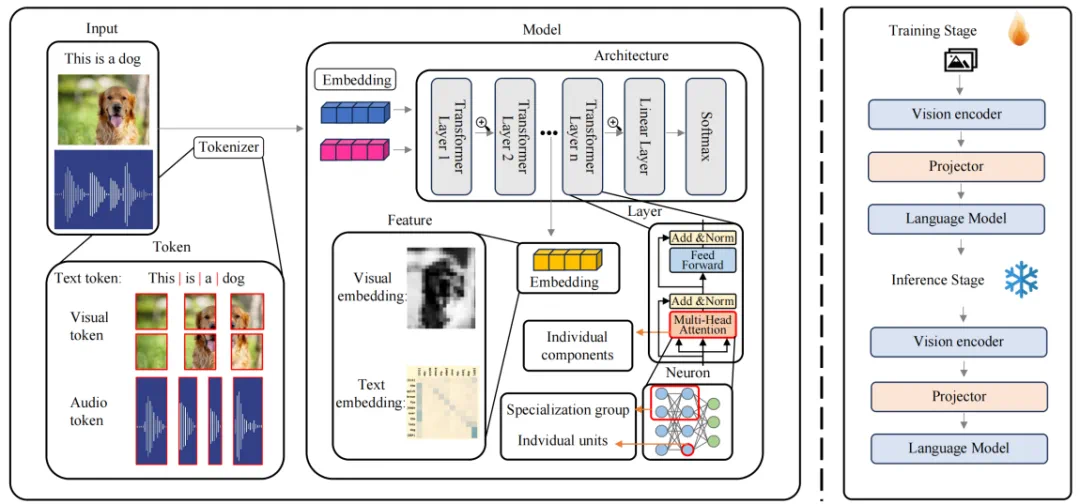

2. 模型视角: 深入分析模型内部组件,包括:

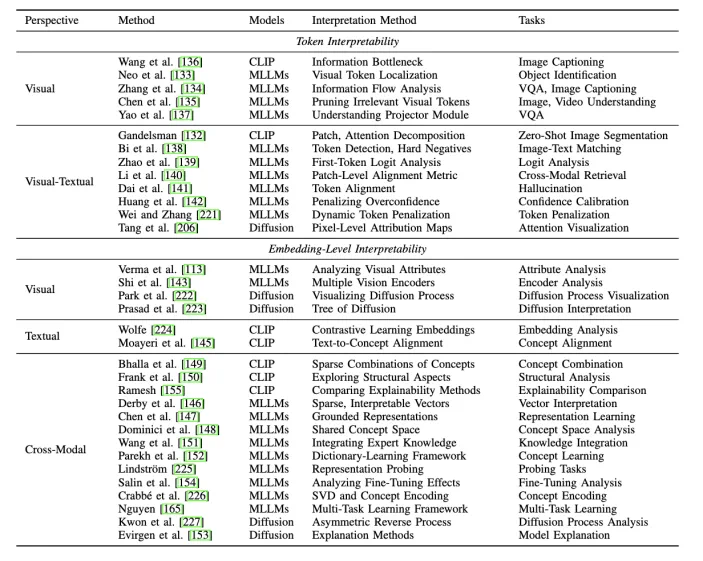

- 词元 (Token): 视觉词元和视觉-文本词元对模型决策的影响。

- 嵌入 (Embedding): 多模态嵌入如何融合信息并影响决策透明度。

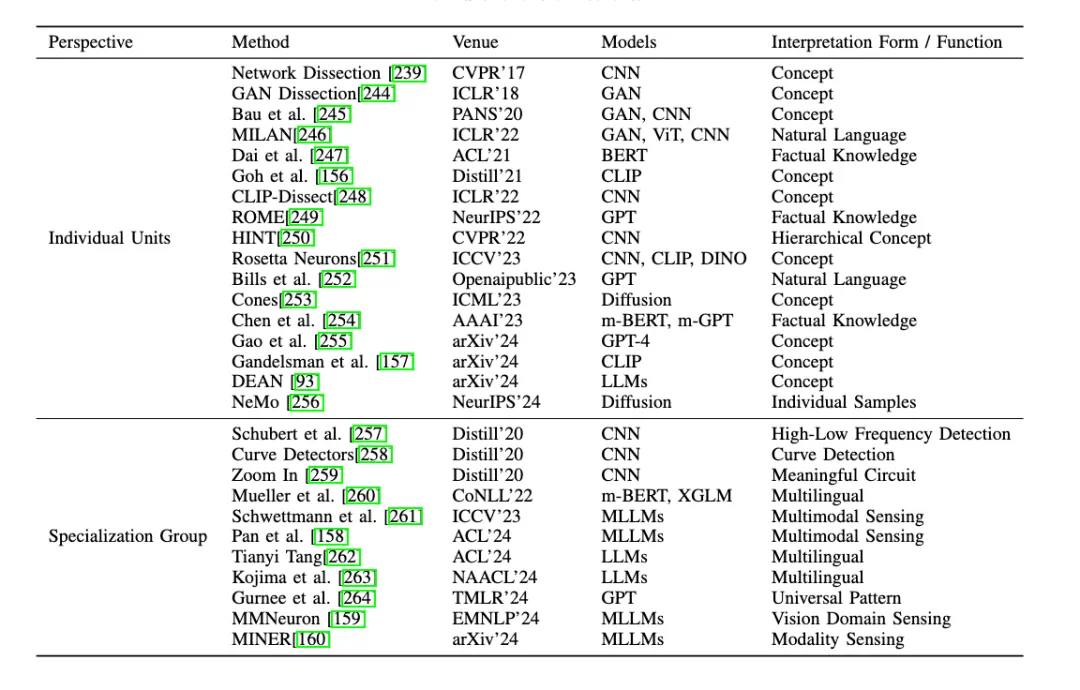

- 神经元 (Neuron): 单个神经元和神经元组对模型输出的贡献。

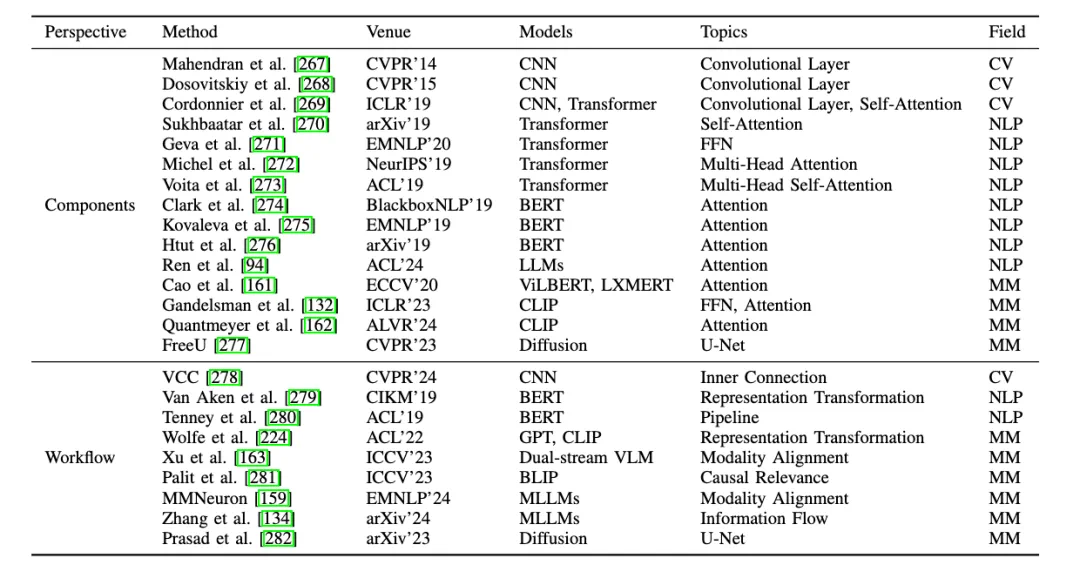

- 层级 (Layer): 单个网络层和不同网络层在决策过程中的作用。

- 架构 (Architecture): 网络结构分析和设计如何促进模型的透明度和可理解性。

3. 训练与推理视角: 探讨训练和推理阶段如何影响可解释性,例如预训练策略、多模态对齐、减少幻觉等。

(以下部分包含论文中大量的图片,为了简化输出,我将用文字概述图片内容,保留图片链接)

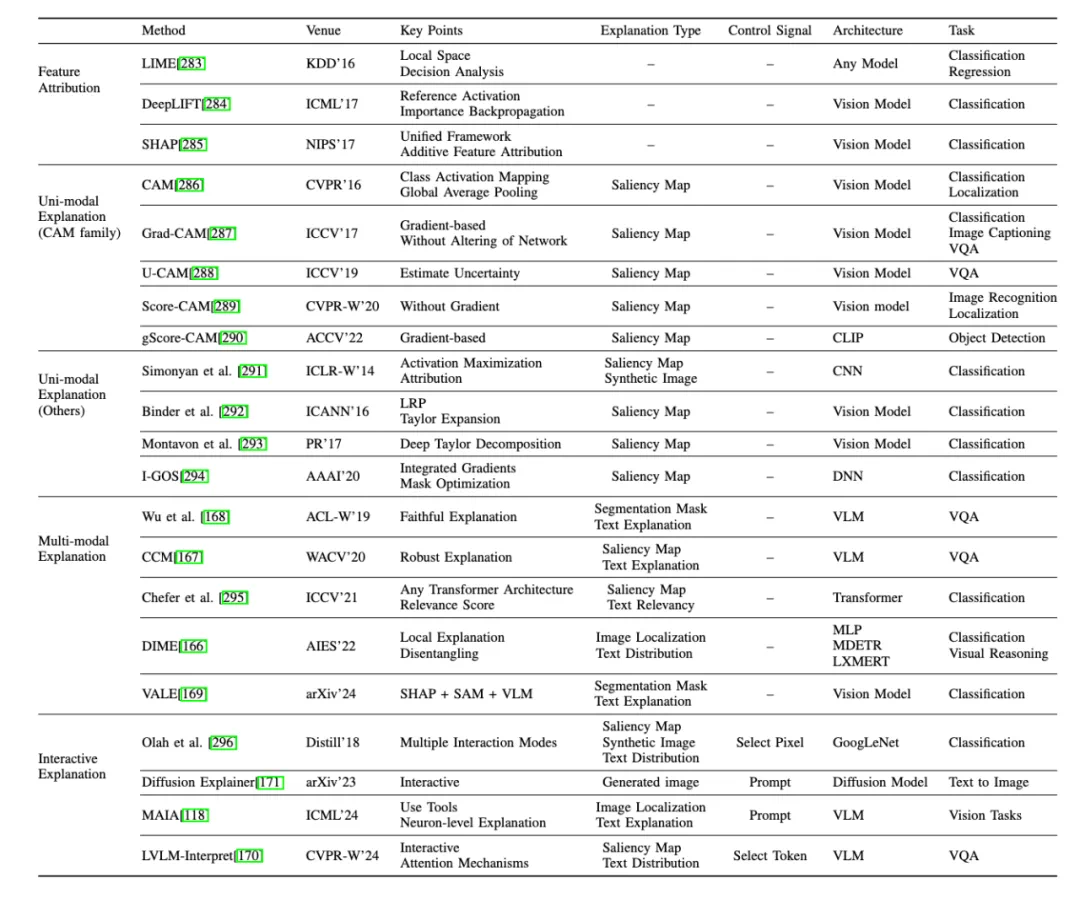

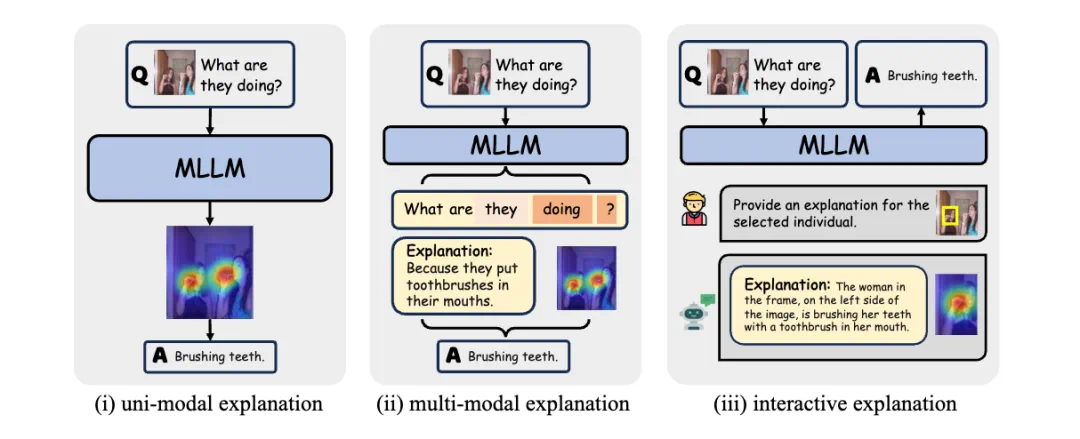

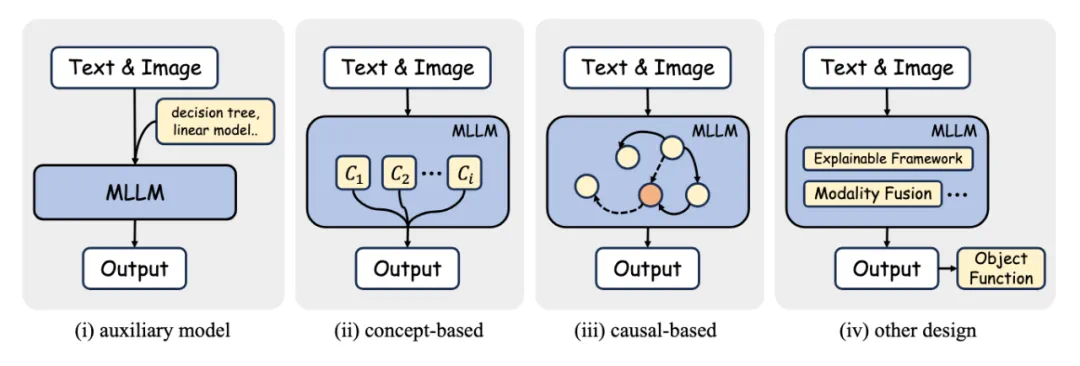

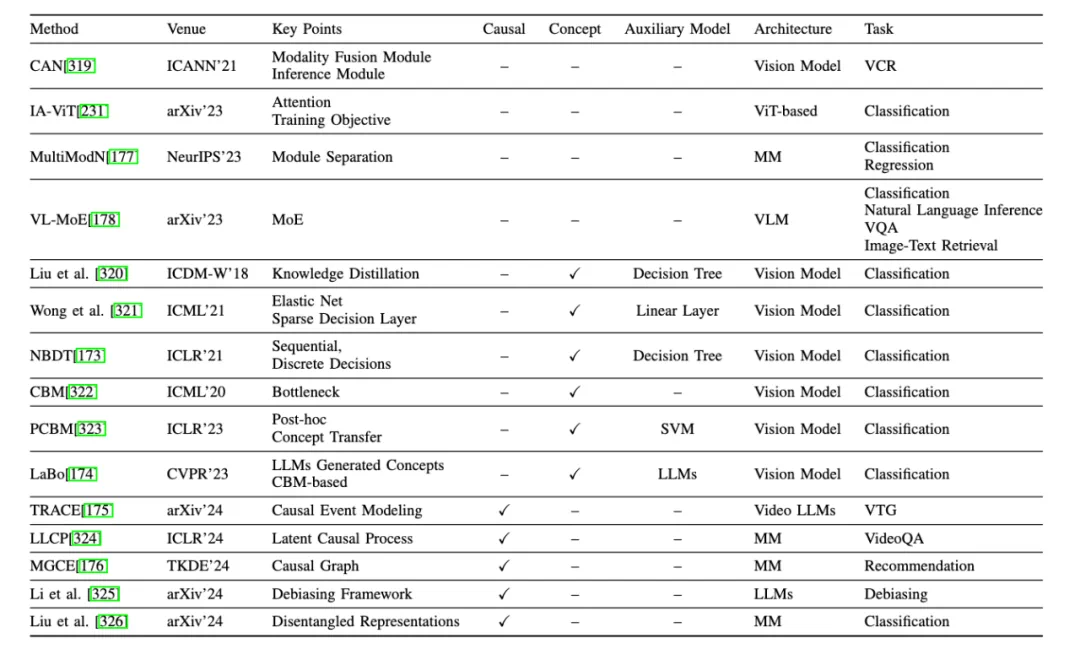

论文中包含大量图表,详细阐述了不同方法在词元、嵌入、神经元、层级和架构层面如何提升多模态大模型的可解释性。 这些图表分别从不同角度展示了模型内部机制,以及各种可解释性技术的应用效果。 (此处省略对每张图片的详细描述,保留图片链接,请参考原文图片。)

未来展望:

论文最后展望了多模态大模型可解释性的未来研究方向,包括改进数据集、优化嵌入和特征表示、增强模型架构的透明度、以及建立训练和推理的统一解释框架等。 这些努力将有助于构建更透明、可靠和可信的多模态AI系统。

今天带大家了解了的相关知识,希望对你有所帮助;关于科技周边的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

258 收藏

-

358 收藏

-

321 收藏

-

382 收藏

-

142 收藏

-

222 收藏

-

223 收藏

-

378 收藏

-

353 收藏

-

461 收藏

-

284 收藏

-

404 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习