数据不够致Scaling Law撞墙?CMU和DeepMind新方法可让VLM自己生成记忆

时间:2025-01-17 17:01:37 196浏览 收藏

从现在开始,我们要努力学习啦!今天我给大家带来《数据不够致Scaling Law撞墙?CMU和DeepMind新方法可让VLM自己生成记忆》,感兴趣的朋友请继续看下去吧!下文中的内容我们主要会涉及到等等知识点,如果在阅读本文过程中有遇到不清楚的地方,欢迎留言呀!我们一起讨论,一起学习!

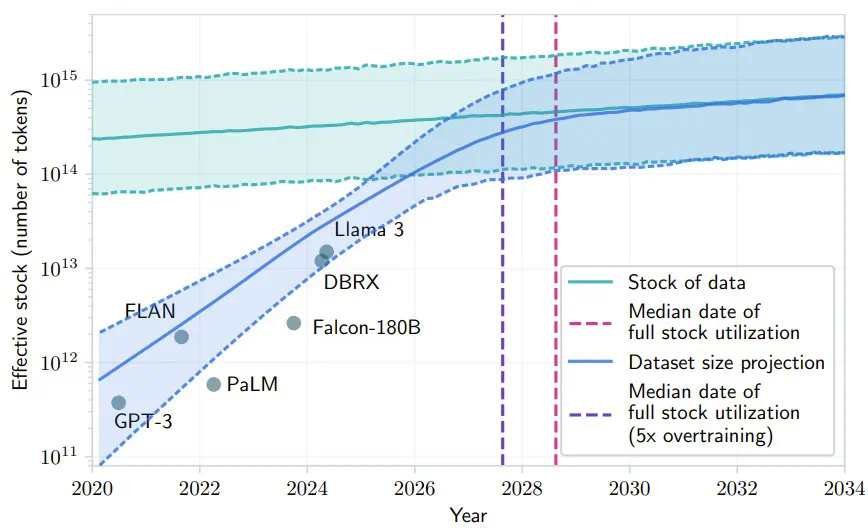

AI领域对“扩展定律是否触及瓶颈”的讨论甚嚣尘上。 有人认为,高质量数据即将耗尽是扩展定律触及瓶颈的证据之一,研究预测,按LLM当前发展速度,可用高质量数据或将在2028年左右被完全消耗。

图源:Will we run out of data? Limits of LLM scaling based on human-generated data

图源:Will we run out of data? Limits of LLM scaling based on human-generated data

然而,卡内基梅隆大学(CMU)和Google DeepMind的一项研究——“VLM智能体生成自身记忆:将经验提炼为具身思维程序”——提出了一种可能的解决方案。该研究发现,利用低质量数据和反馈,或许可以弥补高质量数据不足的问题。 研究中提出的ICAL方法,允许LLM和VLM基于次优演示和人工反馈创建有效的提示词,从而改进决策,并减少对专家演示的依赖。该论文已被NeurIPS 2024评为Spotlight论文,项目代码已公开发布。

- 论文标题:VLM Agents Generate Their Own Memories: Distilling Experience into Embodied Programs of Thought

- 论文地址:https://openreview.net/pdf?id=5G7MRfPngt

- 项目地址:https://ical-learning.github.io/

- 代码地址:https://github.com/Gabesarch/ICAL

人类拥有卓越的小样本学习能力,能够将观察到的行为与内部世界模型结合,快速从单一任务演示中泛化到相关场景。 人类能区分成功与失败的关键因素,并预测潜在风险。 通过反复练习和反馈,人类能快速找到正确的抽象概念,从而模仿并调整任务以适应各种情况,实现知识在不同任务和环境中的迁移和改进。

近期研究探索了利用大型语言模型(LLM)和视觉-语言模型(VLM)从轨迹和经验中提取高级见解。这些见解通过模型的内省产生,并通过添加到提示词中来提升模型性能,利用了其强大的上下文学习能力。

现有方法通常侧重于基于文本的任务奖励信号、存储失败后的纠正、使用领域专家人工编写或挑选示例(无需内省),或利用语言来塑造策略和奖励。 这些方法大多基于文本,缺乏视觉提示或演示,或仅在失败时使用内省,这并非人类和机器整合经验和提取见解的唯一方式。

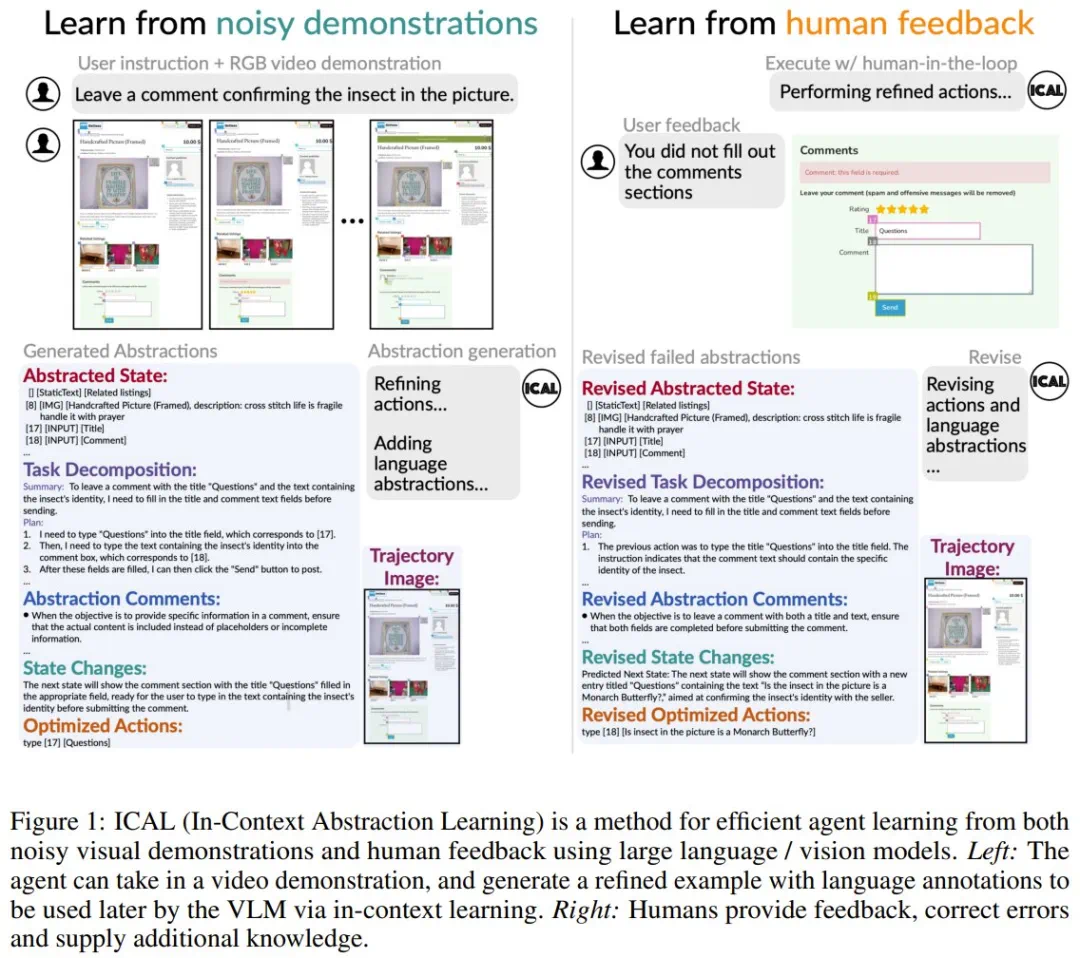

CMU和DeepMind的研究团队则提出了一种新方法:给定次优演示和人类自然语言反馈,通过学习上下文经验抽象,让VLM学习解决新任务。 该方法被称为In-Context Abstraction Learning (ICAL),即上下文抽象学习。

ICAL如何学习?

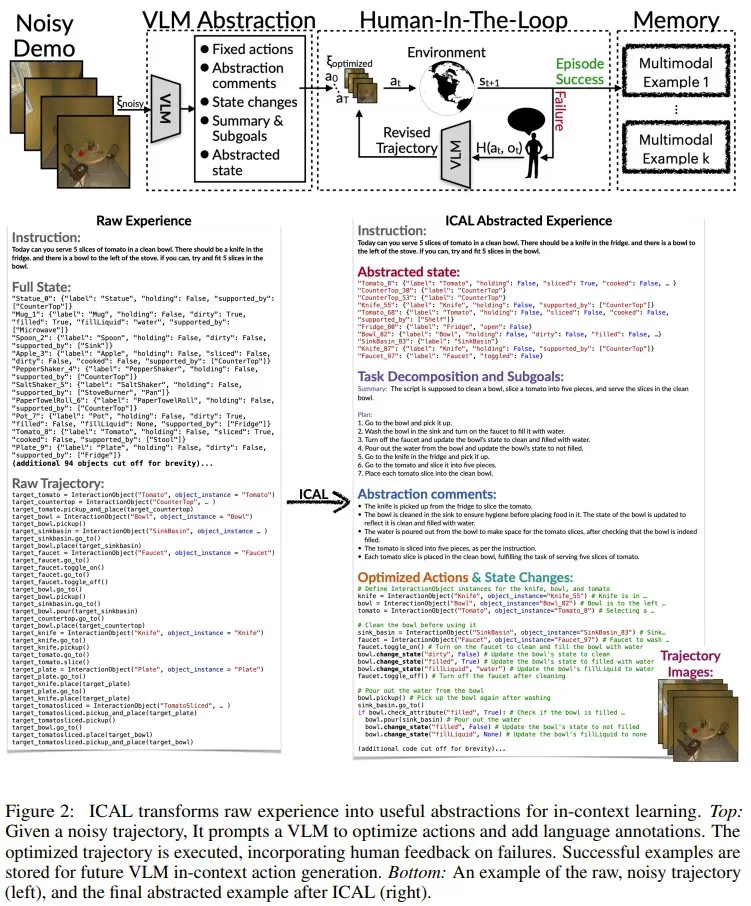

ICAL通过提示,引导VLM为陌生领域创建多模态抽象。 与以往仅存储和检索成功动作规划或轨迹的方法不同,ICAL强调学习抽象,这种抽象包含了关于任务动态和关键知识的信息(如图1所示)。

ICAL处理四种认知抽象:

- 任务和因果关系

- 对象状态变化

- 时间抽象

- 任务建构

在最优或次优演示下,ICAL通过提示VLM将演示转换为优化轨迹,同时创建相关的语言和视觉抽象。然后,在人类自然语言反馈的引导下,通过在环境中执行这些轨迹来优化这些抽象。 抽象生成过程的每一步都利用之前推导出的抽象,从而提升模型的执行和抽象能力。

图2展示了ICAL的概览。

ICAL包含两个阶段:

- 抽象阶段(F_abstract):VLM利用语言评论纠正错误,丰富序列。

- 有人类参与的阶段(F_hitl):序列在环境中执行,抽象过程由人类自然语言反馈指导。

成功执行的轨迹将被存档,作为智能体的上下文参考,用于处理新任务和新环境。 学习到的抽象总结了动作序列、状态迁移、规则和关注区域的关键信息,并通过自由形式的自然语言和视觉表征表达。

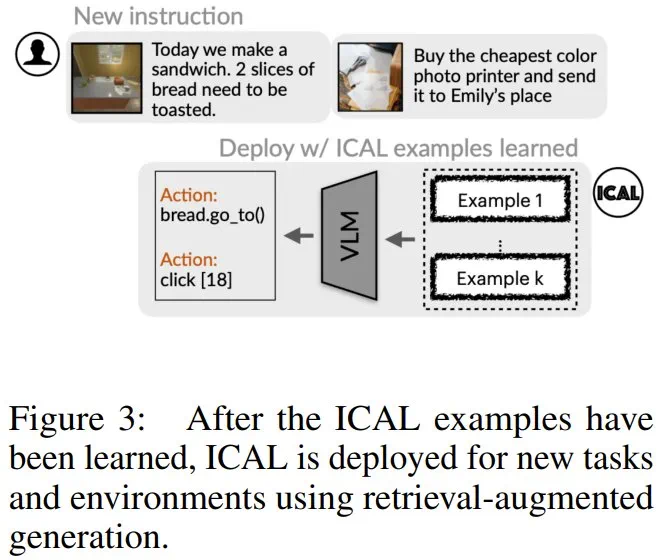

学习到的ICAL样本可用于检索增强式生成,应用于新任务和新环境。

实验结果表明ICAL有效

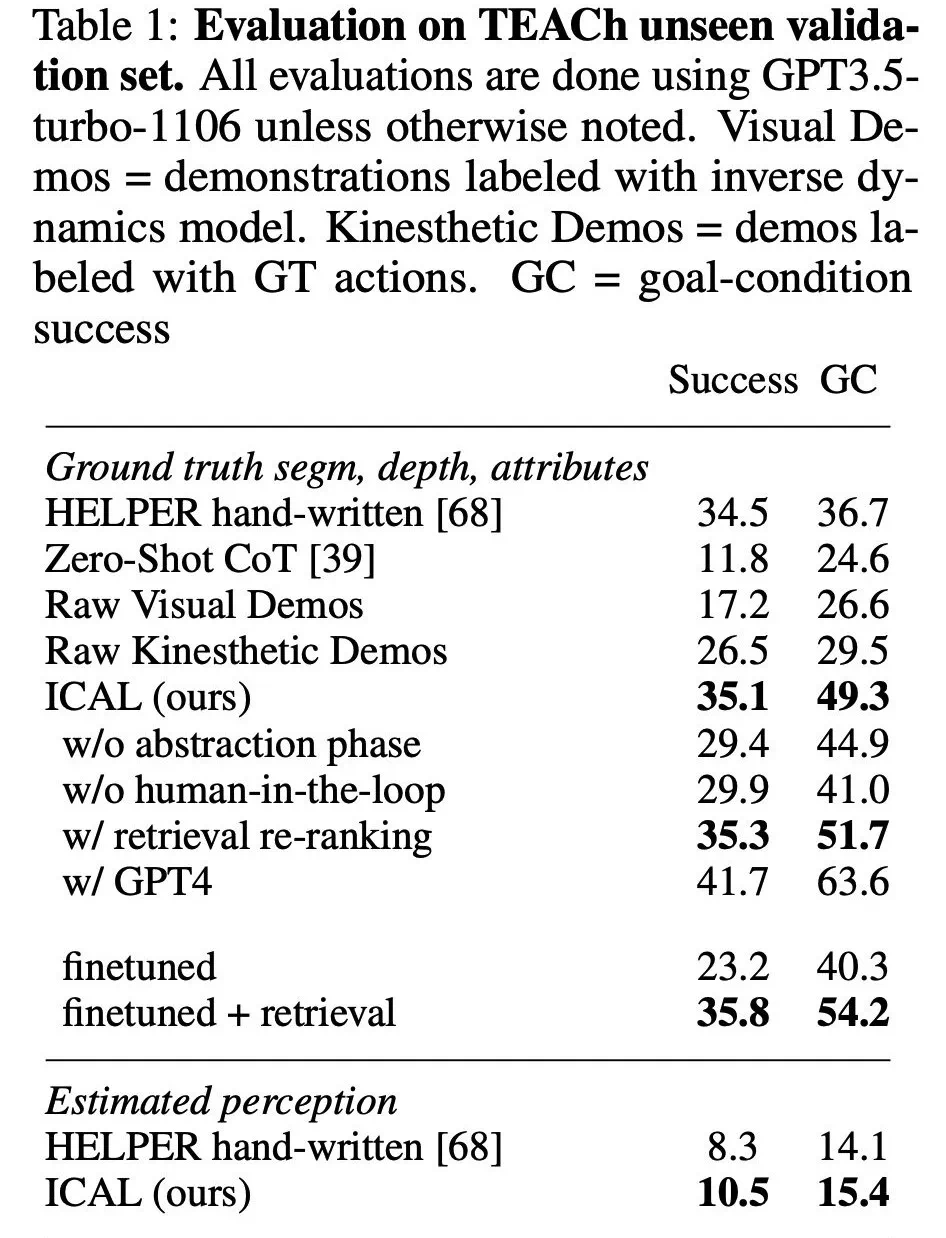

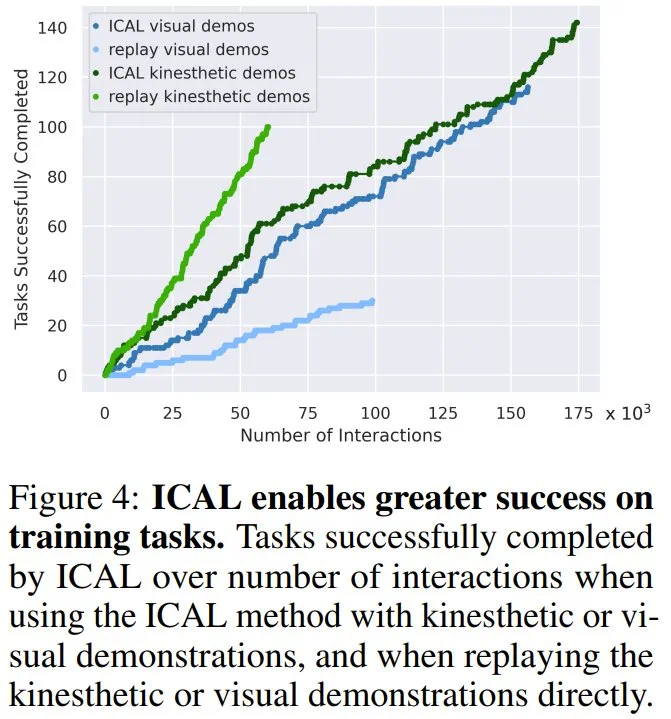

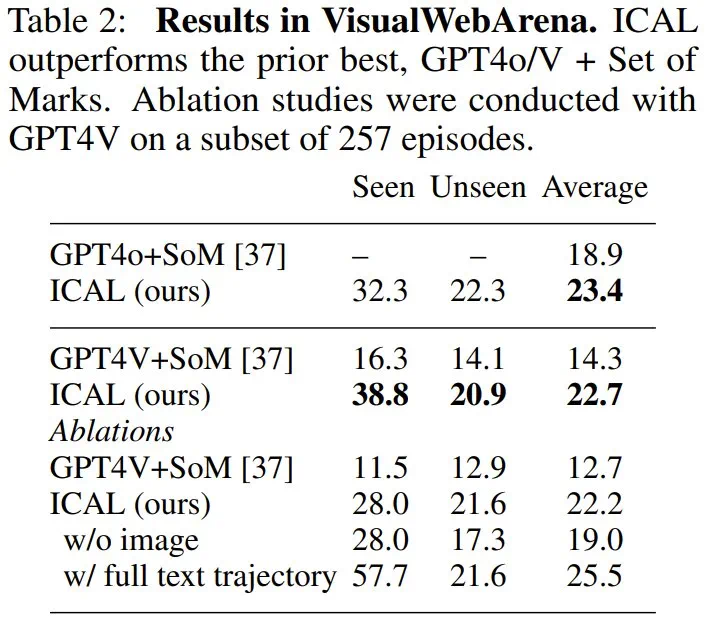

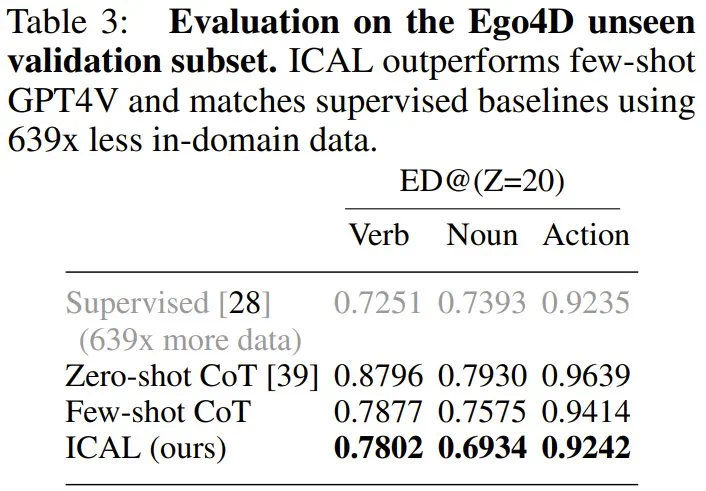

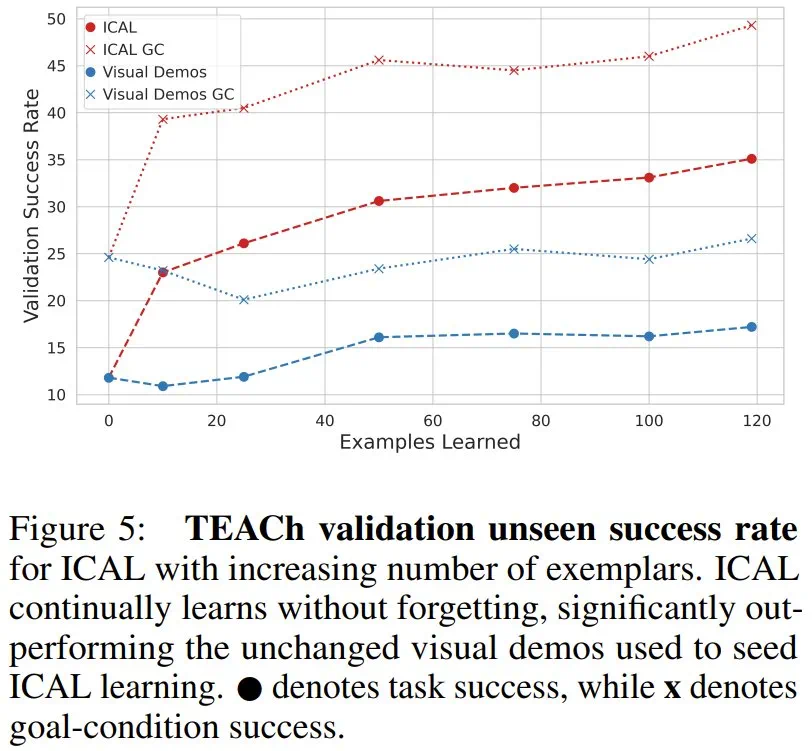

研究人员在TEACh、VisualWebArena和Ego4D基准测试中评估了ICAL的任务规划和动作预测能力。结果显示,ICAL在家庭环境指令遵循任务中优于固定演示;在视觉网络任务中取得了最先进的性能;在Ego4D设置中,其性能优于使用思维链的少样本GPT4V,并且与完全监督方法差距很小,但使用的领域内训练数据减少了639倍。 此外,随着示例数量增加,ICAL性能也显著提升,表明其具有良好的扩展性。

文中关于工程的知识介绍,希望对你的学习有所帮助!若是受益匪浅,那就动动鼠标收藏这篇《数据不够致Scaling Law撞墙?CMU和DeepMind新方法可让VLM自己生成记忆》文章吧,也可关注golang学习网公众号了解相关技术文章。

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

482 收藏

-

377 收藏

-

397 收藏

-

438 收藏

-

432 收藏

-

165 收藏

-

223 收藏

-

102 收藏

-

469 收藏

-

261 收藏

-

475 收藏

-

226 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习