如何高效桥接视觉和语言,字节&中大提出全新多模态大模型连接器ParGo

时间:2025-01-19 14:07:17 437浏览 收藏

积累知识,胜过积蓄金银!毕竟在科技周边开发的过程中,会遇到各种各样的问题,往往都是一些细节知识点还没有掌握好而导致的,因此基础知识点的积累是很重要的。下面本文《如何高效桥接视觉和语言,字节&中大提出全新多模态大模型连接器ParGo》,就带大家讲解一下知识点,若是你对本文感兴趣,或者是想搞懂其中某个知识点,就请你继续往下看吧~

字节跳动与中山大学合作研发的ParGo模型,在多模态大语言模型(MLLMs)的视觉-语言连接方面取得突破,并被AAAI 2025收录。该模型巧妙地融合全局和局部视觉信息,在多个权威基准测试中表现优异。

AIxiv专栏持续发布前沿学术和技术内容,多年来已报道2000余篇来自全球顶尖高校和企业实验室的成果,致力于促进学术交流与传播。欢迎投稿或联系报道:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

以往的MLLMs多采用线性投影或多层感知机(MLP)将视觉特征直接映射到LLM语言空间,这导致视觉token数量难以控制,尤其在处理细粒度特征时计算成本极高。基于注意力机制的方法(如Q-former)虽然降低了计算成本,但往往过度关注图像显著区域,忽略细节。

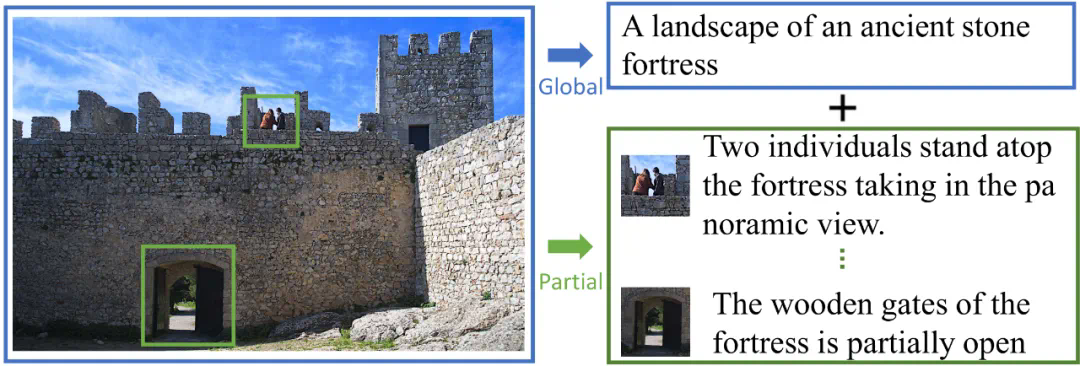

ParGo模型创新性地提出全局-局部投影器,通过整合全局视野和局部细节,避免了对显著区域的过度依赖,实现了更细致全面的视觉特征表达,并有效控制了token数量,从而提升了视觉特征与LLM的连接效率。

全局+局部视角融合

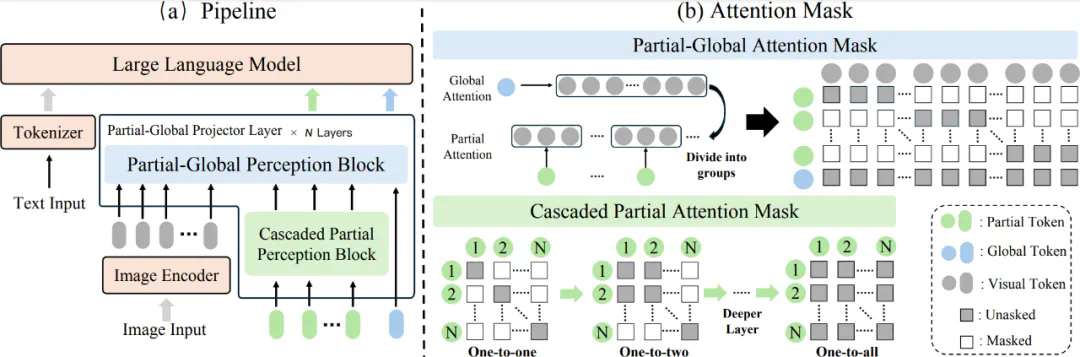

模型架构

ParGo模型包含两个核心模块:局部-全局感知块(PGP)和级联局部感知块(CPP)。PGP模块将视觉特征映射为局部token和全局token,分别捕捉局部和全局信息。CPP模块则通过级联的自注意力机制,逐步扩展局部token的感知范围,增强对多种局部信息的捕获能力。

图1:ParGo模型框架

核心模块详解

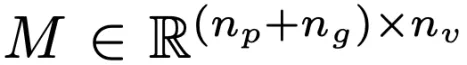

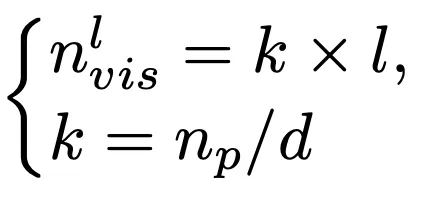

- 局部-全局感知块(PGP):PGP模块利用交叉注意力掩码(Partial-Global Attention Mask), 同时生成局部token和全局token。局部token关注局部视觉特征,全局token则整合所有视觉特征。相关公式如下:

- 级联局部感知块(CPP):CPP模块使用特殊设计的自注意力掩码(Cascaded Partial Attention Mask),随着层数增加,每个局部token的感知范围逐步扩大,从而更全面地捕捉局部信息。公式如下:

实验结果

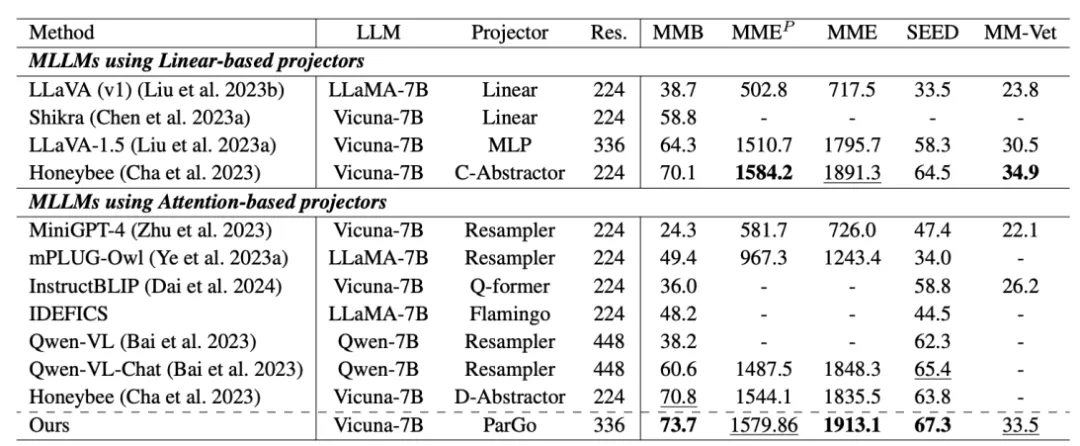

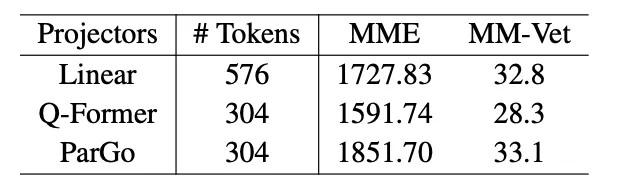

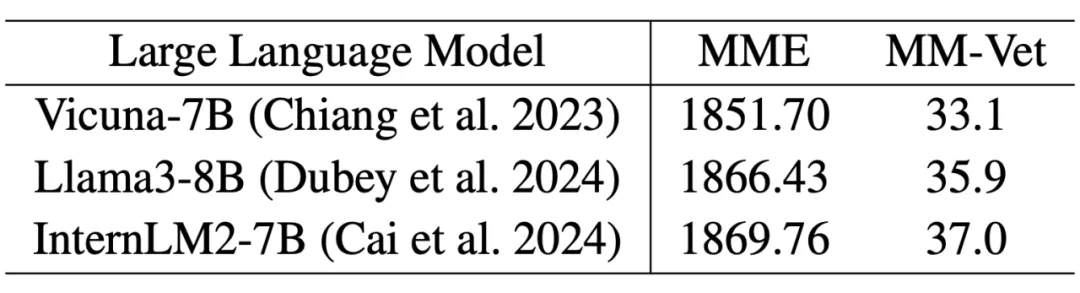

ParGo模型在多个MLLM基准测试中均取得了领先的性能,并与其他主流投影器进行了公平对比,展现了其优越性及良好的泛化能力。

不同投影器的性能对比

不同基座LLM下的性能对比

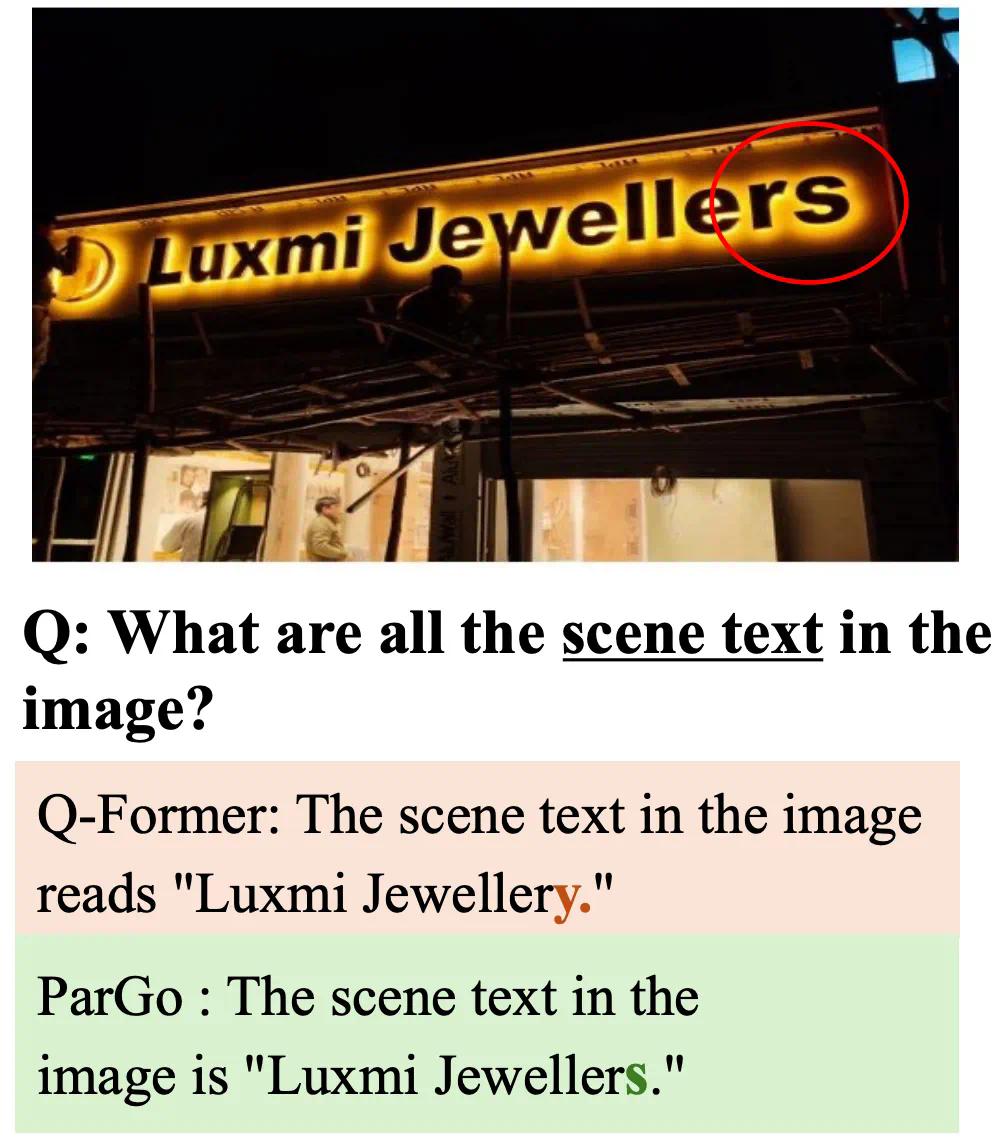

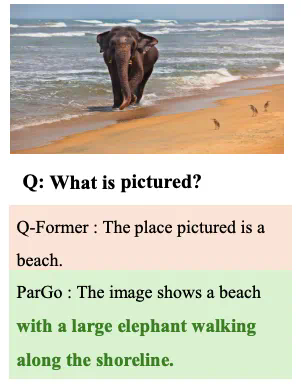

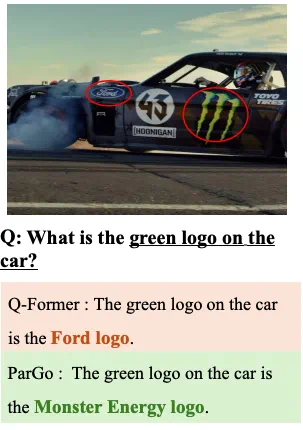

案例分析

与Q-former相比,ParGo在相同token数量下,对图像细节和空间关系的捕捉能力更强,文字识别和局部元素识别效果更佳。

总结

ParGo模型通过巧妙地融合全局和局部视觉信息,有效提升了MLLMs的视觉-语言对齐效果,为多模态大模型的发展提供了新的方向。

本篇关于《如何高效桥接视觉和语言,字节&中大提出全新多模态大模型连接器ParGo》的介绍就到此结束啦,但是学无止境,想要了解学习更多关于科技周边的相关知识,请关注golang学习网公众号!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

310 收藏

-

157 收藏

-

278 收藏

-

405 收藏

-

189 收藏

-

216 收藏

-

183 收藏

-

440 收藏

-

310 收藏

-

373 收藏

-

236 收藏

-

293 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习