年末惊喜!ByteDance Research视频理解大模型「眼镜猴」正式发布

时间:2025-01-30 18:46:30 339浏览 收藏

本篇文章向大家介绍《年末惊喜!ByteDance Research视频理解大模型「眼镜猴」正式发布》,主要包括,具有一定的参考价值,需要的朋友可以参考一下。

字节跳动研究团队的视频理解大模型Tarsier迎来了重大升级,推出了第二代模型Tarsier2及其技术报告。此前发布的Tarsier-7B/34B已成为最强大的开源视频描述模型,仅次于闭源模型Gemini-1.5-Pro和GPT-4o。那么,Tarsier2又有哪些突破呢?

让我们先看看Tarsier2对经典影视片段的理解:

《燕子,没有你我怎么活》

《燕子,没有你我怎么活》

《曹操盖饭》

《曹操盖饭》

Tarsier2不仅精准捕捉人物动作(例如小岳岳追车、下跪,曹操的挥舞动作),还巧妙结合字幕信息,深入分析人物动机、心理,理解人物关系和剧情发展。

Tarsier2 视频描述效果合集

Tarsier2 视频描述效果合集

Tarsier2在视频描述任务上的表现同样出色,无论是真人还是动画、横屏还是竖屏、多场景还是多镜头,都能精准捕捉核心视觉元素和动态事件,并用简洁的语言进行描述,且很少出现幻觉。其性能已可与GPT-4o媲美。

Tarsier2的“火眼金睛”是如何炼成的?

Tarsier2是一个7B参数的轻量级模型,支持动态分辨率,能够理解长达数十分钟的视频,尤其擅长分析几十秒的短视频片段。其强大的视频理解能力源于精细的预训练和后训练阶段:

预训练阶段:

Tarsier2在4000万个互联网视频-文本数据上进行预训练。团队通过海量收集互联网视频-文本数据,并设计了一套严谨的数据筛选流程(分镜、过滤、合并),确保训练数据的质量。特别值得一提的是,Tarsier2筛选了大量的影视剧解说视频,帮助模型理解更深层次的情节信息。

后训练阶段:

后训练分为SFT和DPO两个阶段:

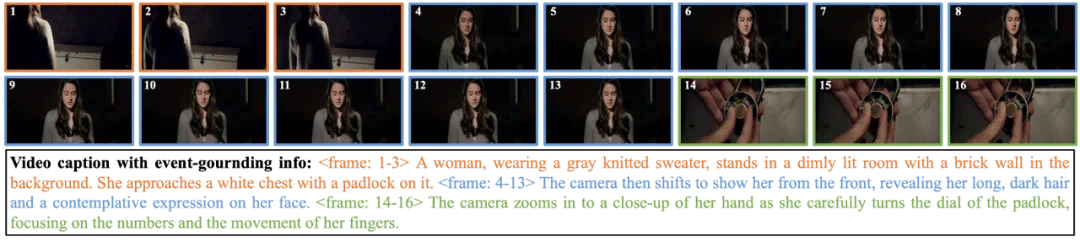

- SFT (监督微调): 在人工标注的视频描述数据上进行训练,并引入针对每个子事件的具体定位信息,强化模型对时序信息和视觉特征的关注。

SFT数据样例

SFT数据样例

- DPO (数据增强): 在自动化构造的正负样本上进行DPO训练,正样本来自模型对原始视频的预测,负样本来自模型对经过随机扰动的视频的预测。这种方法提高了描述的准确性和完整性,减少了幻觉。

性能测试:

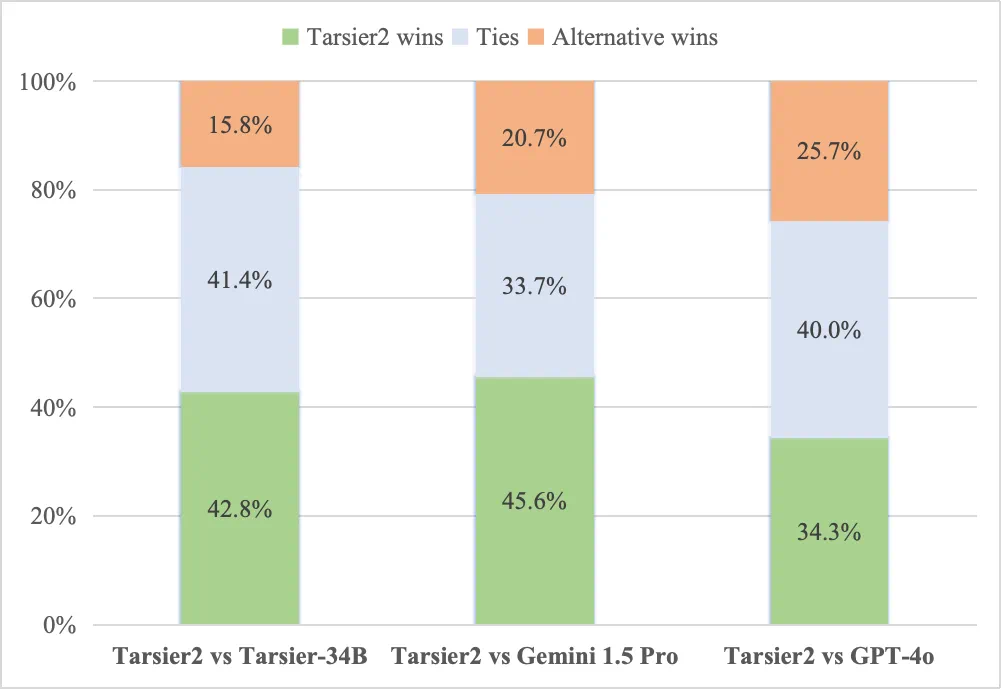

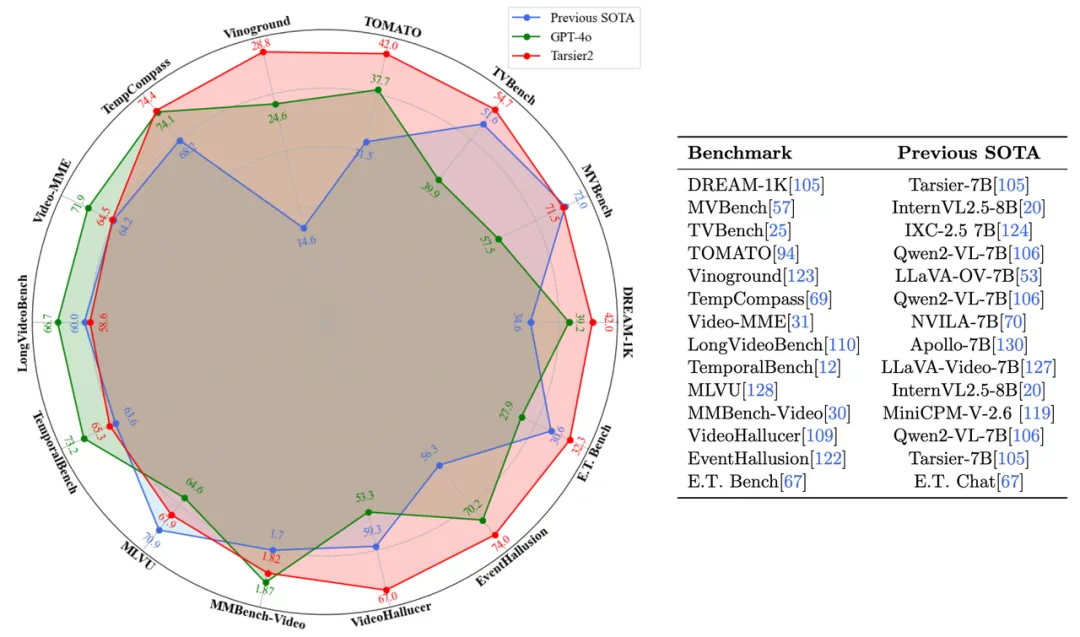

Tarsier2在19个视频理解公开基准上进行了测试,与10多个最先进的开源模型(Qwen2-VL、InternVL2.5、LLaVA-Video等)和闭源模型(Gemini-1.5, GPT-4o)进行了比较。结果显示,Tarsier2在视频描述、短/长视频问答等通用视频理解任务上表现出色。

视频描述质量人工评估结果

视频描述质量人工评估结果

Tarsier2在广泛的视频理解任务上树立了新的标杆

Tarsier2在广泛的视频理解任务上树立了新的标杆

Tarsier2还在机器人和智能驾驶等下游任务中展现了强大的泛化能力。

机器人场景

机器人场景

智能驾驶场景

智能驾驶场景

未来展望:

Tarsier2在生成准确详细的视频描述方面超越了现有模型,并在广泛的视频理解任务中树立了新的标杆。 它在多模态融合领域迈出了坚实的一步,未来有望在人工智能发展中发挥更大的作用。

论文地址:https://arxiv.org/abs/2501.07888 项目仓库:https://github.com/bytedance/tarsier HuggingFace:https://huggingface.co/omni-research

到这里,我们也就讲完了《年末惊喜!ByteDance Research视频理解大模型「眼镜猴」正式发布》的内容了。个人认为,基础知识的学习和巩固,是为了更好的将其运用到项目中,欢迎关注golang学习网公众号,带你了解更多关于产业,Tarsier2的知识点!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

132 收藏

-

424 收藏

-

412 收藏

-

163 收藏

-

369 收藏

-

501 收藏

-

477 收藏

-

292 收藏

-

225 收藏

-

314 收藏

-

226 收藏

-

206 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习