线性扩散模型LiT来了,用极简线性注意力助力扩散模型AIPC时代端侧部署

时间:2025-02-01 20:46:09 316浏览 收藏

学习科技周边要努力,但是不要急!今天的这篇文章《线性扩散模型LiT来了,用极简线性注意力助力扩散模型AIPC时代端侧部署》将会介绍到等等知识点,如果你想深入学习科技周边,可以关注我!我会持续更新相关文章的,希望对大家都能有所帮助!

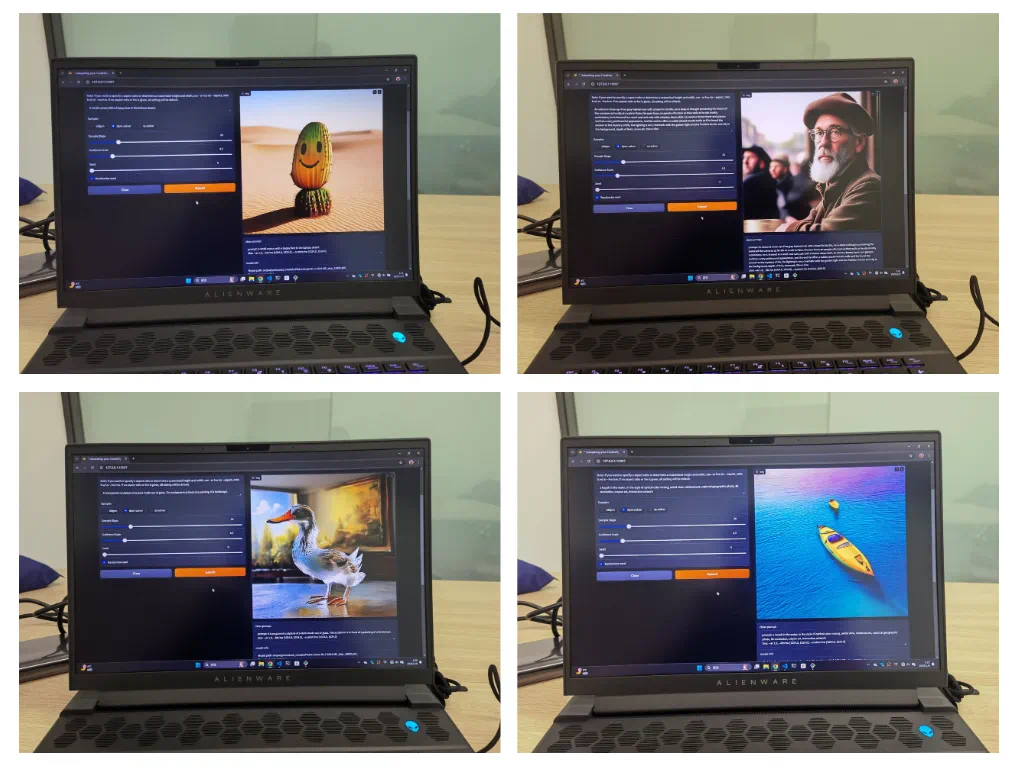

香港大学与上海人工智能实验室、华为诺亚方舟实验室合作,推出高效扩散模型LiT,该模型在架构设计和训练策略上均有创新,实现了在普通Windows笔记本电脑上离线生成1K分辨率高清图像。

LiT的核心突破:

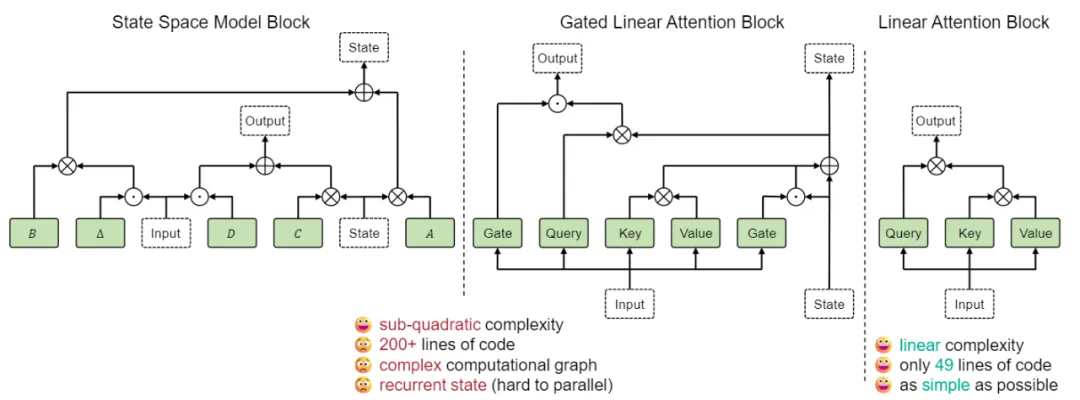

为提升扩散模型效率,LiT采用极简线性注意力机制替代计算成本更高的自注意力机制。线性注意力的优势在于简洁性和高并行化能力,这对于大型模型至关重要。研究团队总结了以下关键经验:

- 极简线性注意力足够: 无需复杂的线性注意力变体,简化版即可满足图像生成需求。

- 权重继承策略: 建议从预训练的Diffusion Transformer模型继承权重,但需排除自注意力模块的权重。

- 混合知识蒸馏: 采用知识蒸馏加速训练,同时蒸馏噪声预测和方差预测结果,以获得更佳效果。

性能表现:

LiT在ImageNet基准测试中,仅需DiT模型20%-23%的训练迭代次数,即可达到相当的FID分数。在文本生成图像任务中,LiT-0.6B可在离线状态下,于Windows笔记本电脑上快速生成1K分辨率的逼真图像,展现出强大的端侧部署能力。

论文及项目信息:

- 论文名称:LiT: Delving into a Simplified Linear Diffusion Transformer for Image Generation

- 论文地址:https://arxiv.org/pdf/2501.12976v1

- 项目主页:https://techmonsterwang.github.io/LiT/

研究背景:

Diffusion Transformer在文生图领域展现出巨大潜力,但自注意力机制的高计算复杂度限制了其在高分辨率场景和端侧设备的应用。LiT通过线性注意力机制有效解决了这一问题,并通过高效的训练策略进一步降低了训练成本。

(后续内容可根据原文目录,对架构设计、训练方法、实验结果等章节进行类似的改写,保持原意不变,并保留图片格式和位置)

理论要掌握,实操不能落!以上关于《线性扩散模型LiT来了,用极简线性注意力助力扩散模型AIPC时代端侧部署》的详细介绍,大家都掌握了吧!如果想要继续提升自己的能力,那么就来关注golang学习网公众号吧!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

200 收藏

-

264 收藏

-

284 收藏

-

381 收藏

-

208 收藏

-

220 收藏

-

236 收藏

-

449 收藏

-

345 收藏

-

146 收藏

-

197 收藏

-

379 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习