训练1000样本就能超越o1,李飞飞等人画出AI扩展新曲线

时间:2025-02-05 18:49:55 118浏览 收藏

来到golang学习网的大家,相信都是编程学习爱好者,希望在这里学习科技周边相关编程知识。下面本篇文章就来带大家聊聊《训练1000样本就能超越o1,李飞飞等人画出AI扩展新曲线》,介绍一下,希望对大家的知识积累有所帮助,助力实战开发!

DeepSeek R1 今年一月横空出世,其创新方法和极低的算力需求,给英伟达等巨头带来了巨大冲击,也引发了业界对AGI发展路径的深刻反思。通往AGI之路并非只有扩大算力规模一条路,更高效的方法才能带来更多创新。

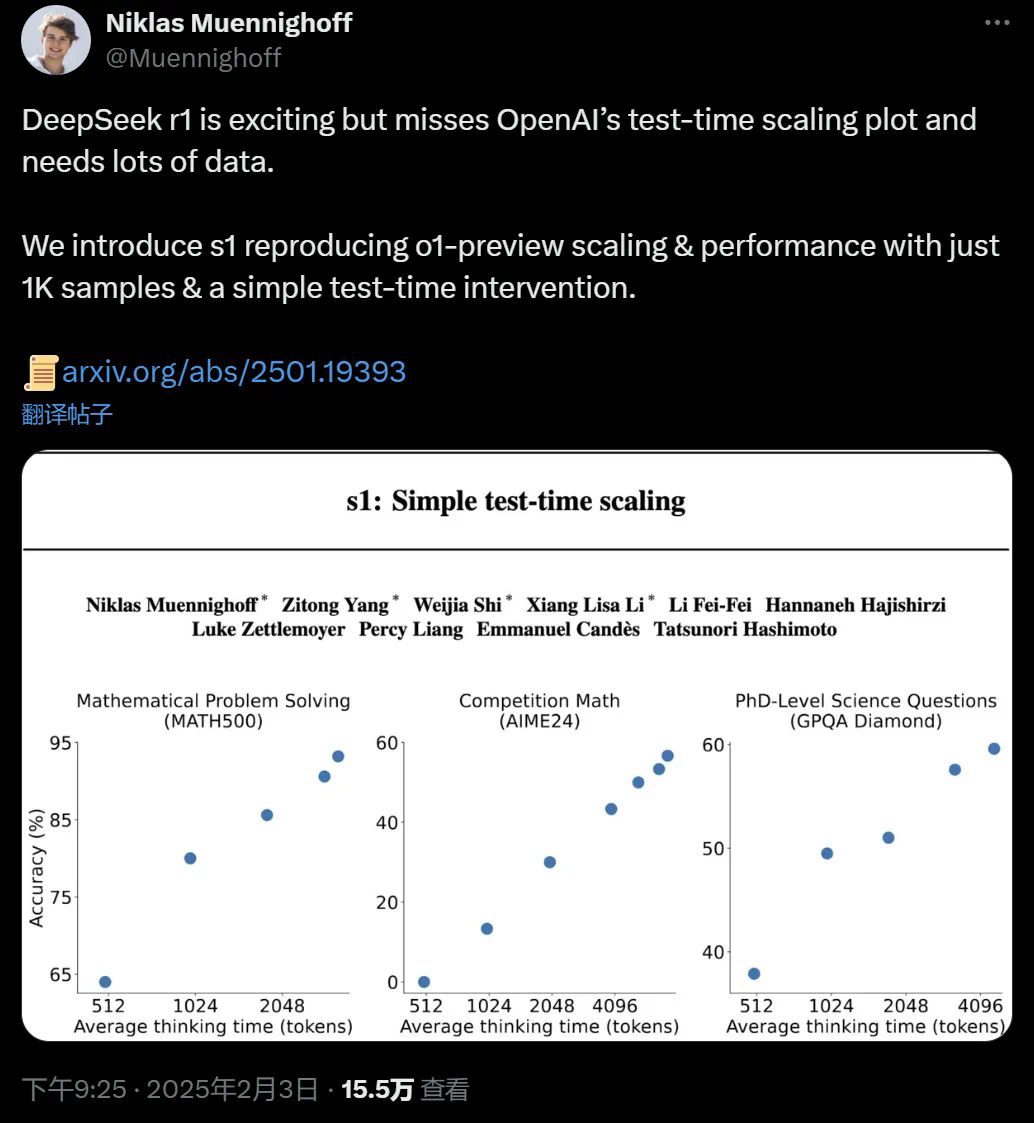

近期,全球众多科技公司和研究团队都在尝试复现DeepSeek。而就在此时,一项名为s1的新方法宣告问世,它大幅提升了AI的推理效率。你或许会感到难以置信!  s1论文作者,斯坦福大学在读博士Niklas Muennighoff指出,DeepSeek R1令人兴奋,但其缺乏OpenAI的测试时间扩展图,且需要海量数据。而s1仅需1000个样本和简单的测试时间干预,即可复现o1的预览扩展和性能。

s1论文作者,斯坦福大学在读博士Niklas Muennighoff指出,DeepSeek R1令人兴奋,但其缺乏OpenAI的测试时间扩展图,且需要海量数据。而s1仅需1000个样本和简单的测试时间干预,即可复现o1的预览扩展和性能。

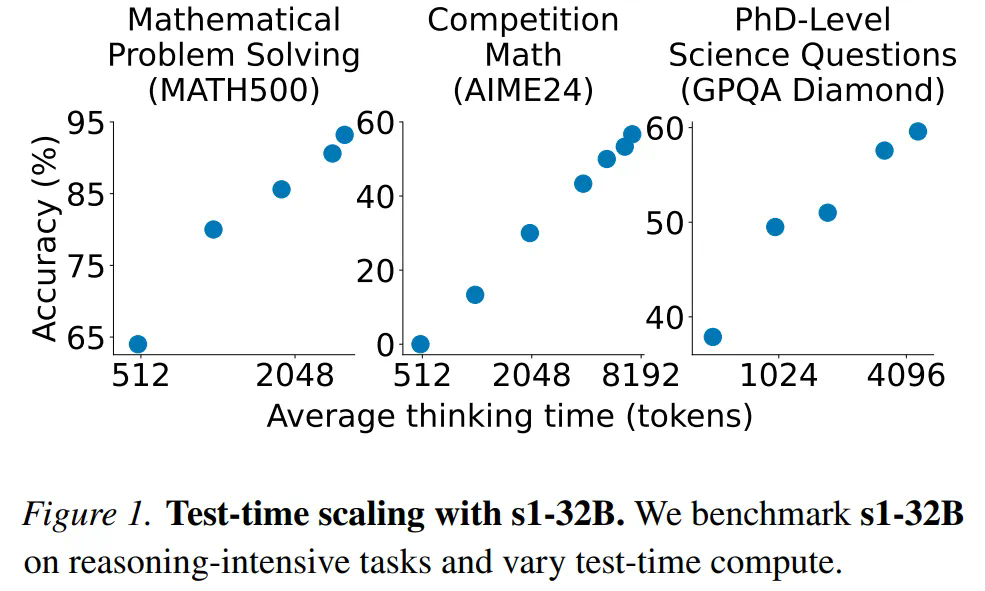

这项由斯坦福大学、华盛顿大学等机构主导的研究,探索了一种极简的测试时间扩展(test-time scaling)方法。令人惊叹的是,该方法仅用1000个问题训练模型,就实现了超越o1的强推理性能。

测试时间扩展是一种极具潜力的语言建模新方法,它利用额外的测试时间计算来提升模型性能。OpenAI的o1模型曾展示了这种能力,但其方法并未公开。许多研究都致力于复现o1,尝试了蒙特卡洛树搜索、多智能体等多种方法。而今年一月开源的DeepSeek R1,则通过数百万样本的多阶段强化学习,成功实现了o1级别的性能。

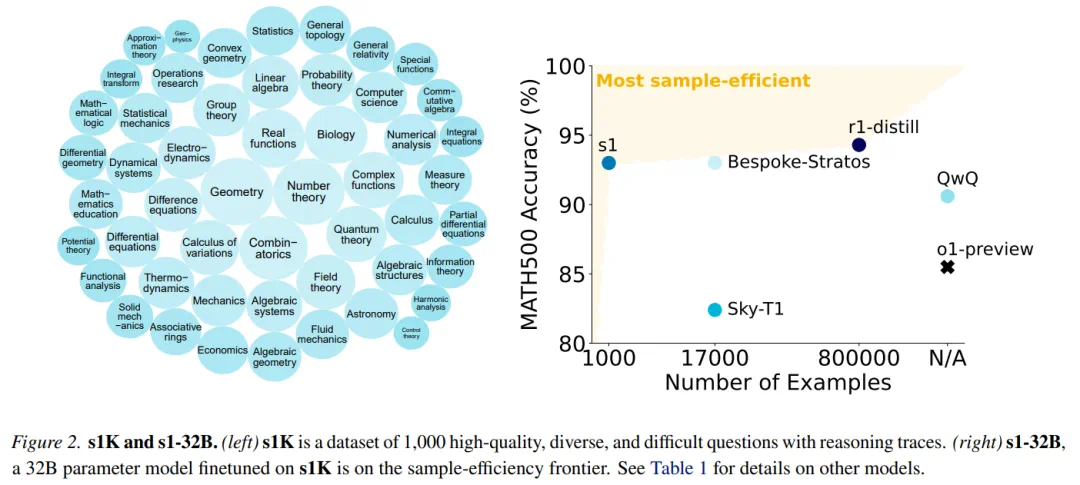

s1研究人员则另辟蹊径,寻求最简化的测试时间扩展方法。他们构建了一个包含1000个问题的s1K数据集,并根据难度、多样性和质量三个标准,与推理轨迹进行匹配。

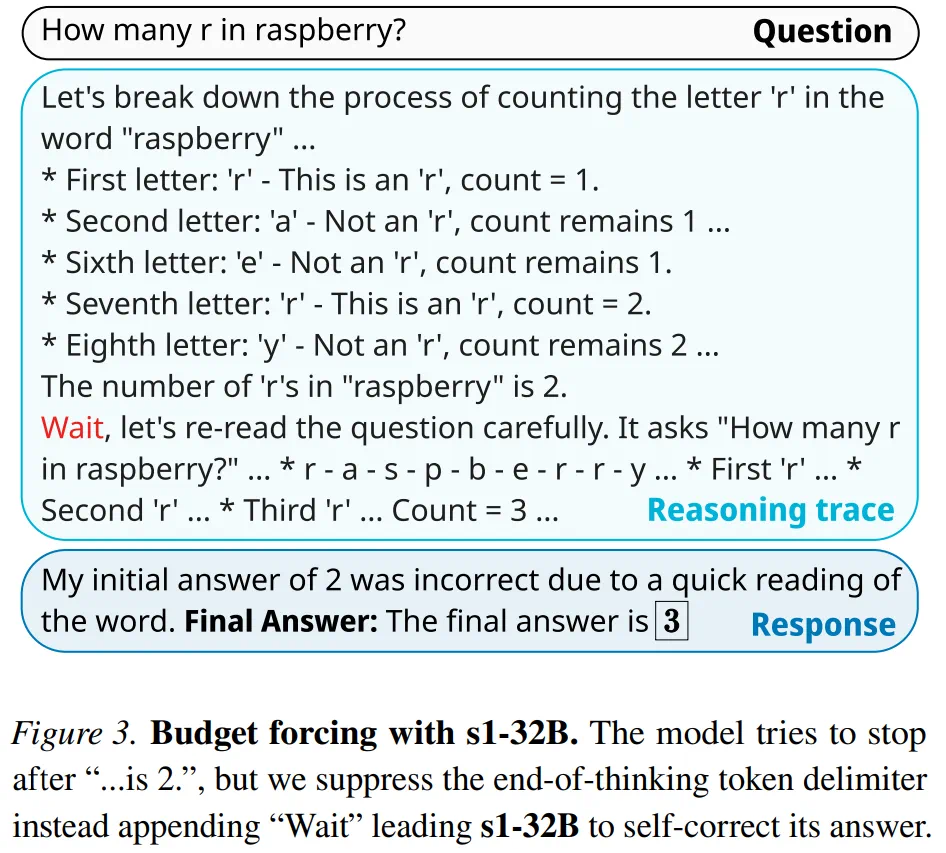

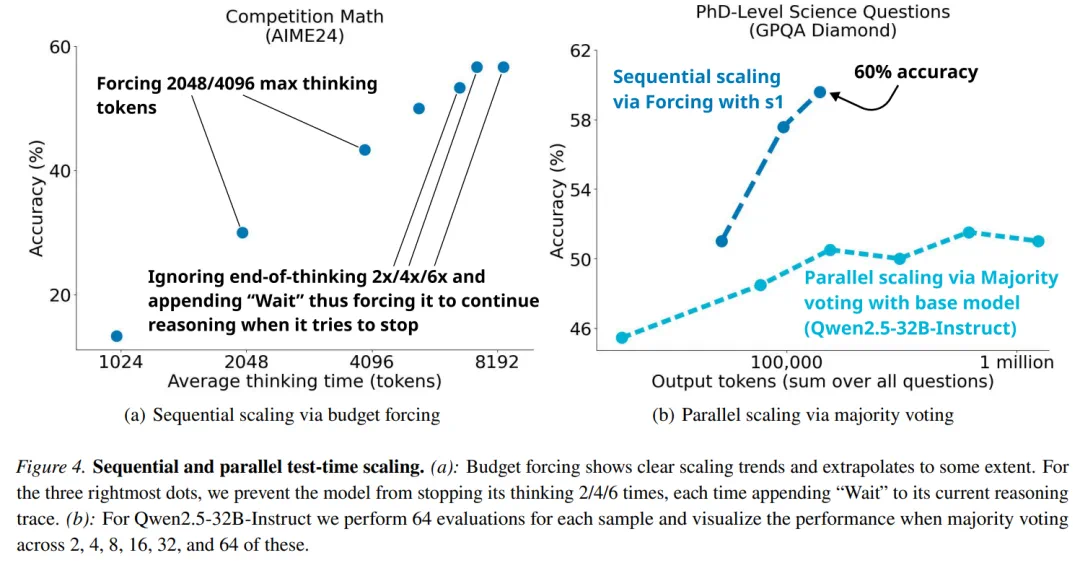

基于此,研究人员提出了“预算强制”技术,通过强制终止模型的思考过程,或在模型试图结束时多次添加“等待”指令来延长思考时间,从而控制测试时间计算。 这有助于模型仔细检查答案,修正错误的推理步骤。

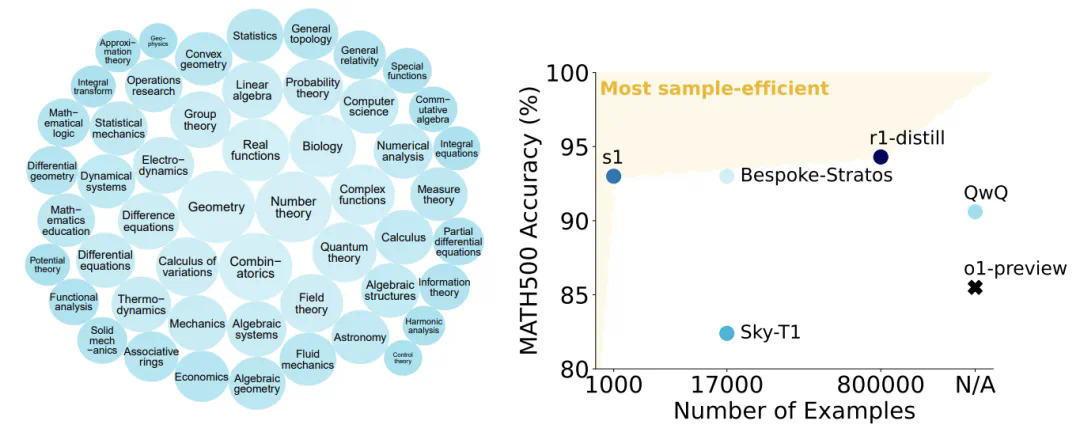

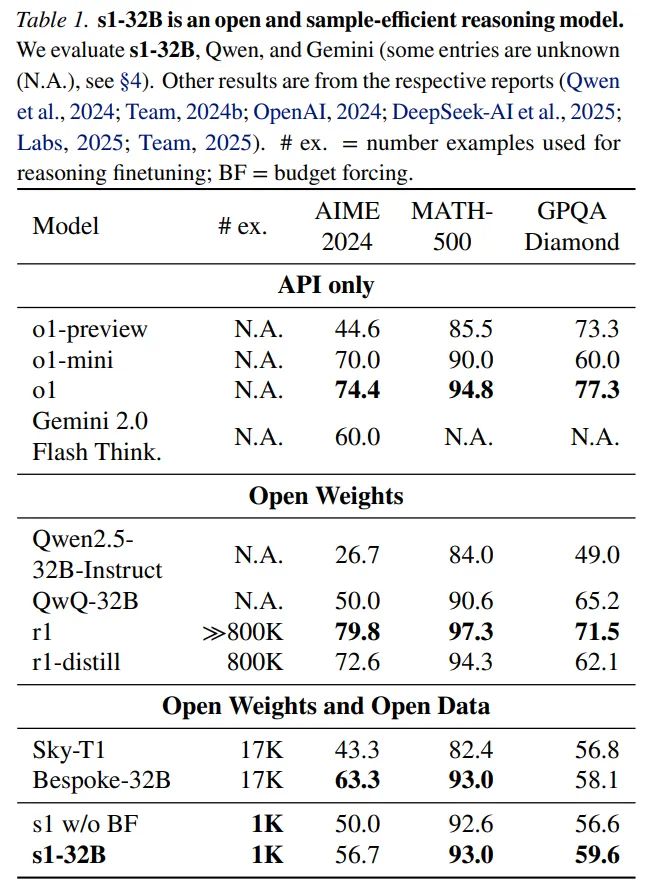

在s1K数据集上,研究人员对Qwen2.5-32B-Instruct语言模型进行了监督微调(使用16块H100 GPU,耗时26分钟),并应用了预算强制技术。最终得到的s1-32B模型,在竞赛数学问题上的表现,比o1-preview高出27%(MATH和AIME24)。 s1性能与其他大模型的对比。

s1性能与其他大模型的对比。

- 论文:《s1: Simple test-time scaling》

- 论文链接:https://arxiv.org/abs/2501.19393

- 项目链接:https://github.com/simplescaling/s1

测试时间扩展

本文将测试时间扩展方法分为两类:1. 序列扩展(后续计算依赖于先前结果);2. 并行扩展(计算独立运行)。

本文重点关注序列扩展,因为它更具扩展性,后续计算可以基于中间结果进行迭代优化。

此外,本文还提出了一种新的序列扩展方法及基准测试方法:预算强制(Budget forcing)。该方法通过在测试时强制设定最大或最小思考token数量来实现解码时间干预。 具体来说,通过添加思考结束token分隔符和“Final Answer:”来强制设定最大token数量;而通过抑制思考结束token分隔符的生成,并添加“Wait”指令,来强制设定最小token数量。

具体来说,通过添加思考结束token分隔符和“Final Answer:”来强制设定最大token数量;而通过抑制思考结束token分隔符的生成,并添加“Wait”指令,来强制设定最小token数量。

基准测试方法包括:条件长度控制方法(token、步骤、类条件控制)和拒绝采样。

实验

训练阶段:使用s1K数据集对Qwen2.5-32B-Instruct进行监督微调,得到s1-32B模型(16块NVIDIA H100 GPU,26分钟)。

评估:使用AIME24、MATH500和GPQA Diamond三个推理基准进行评估。

对比模型:OpenAI o1、DeepSeek r1、Qwen QwQ-32B-preview等。s1-32B完全开源,包括权重、推理数据和代码。

性能

测试时间扩展:

结果显示,过度抑制思考结束token可能会导致模型陷入循环。序列扩展比并行扩展更有效。

结果显示,过度抑制思考结束token可能会导致模型陷入循环。序列扩展比并行扩展更有效。

样本效率:

s1-32B是样本效率最高的开放数据推理模型,仅用1000个样本就取得了优异的性能。 s1-32B在AIME24上的表现与Gemini 2.0 Thinking不相上下。

s1-32B是样本效率最高的开放数据推理模型,仅用1000个样本就取得了优异的性能。 s1-32B在AIME24上的表现与Gemini 2.0 Thinking不相上下。

文中还包含了详细的消融实验结果,感兴趣的读者可以参考原文论文。

文中还包含了详细的消融实验结果,感兴趣的读者可以参考原文论文。

理论要掌握,实操不能落!以上关于《训练1000样本就能超越o1,李飞飞等人画出AI扩展新曲线》的详细介绍,大家都掌握了吧!如果想要继续提升自己的能力,那么就来关注golang学习网公众号吧!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

253 收藏

-

198 收藏

-

363 收藏

-

346 收藏

-

116 收藏

-

351 收藏

-

202 收藏

-

342 收藏

-

440 收藏

-

268 收藏

-

146 收藏

-

288 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习