华人研究团队揭秘:DeepSeek-R1-Zero或许并不存在「顿悟时刻」

时间:2025-02-07 15:49:46 295浏览 收藏

在IT行业这个发展更新速度很快的行业,只有不停止的学习,才不会被行业所淘汰。如果你是科技周边学习者,那么本文《华人研究团队揭秘:DeepSeek-R1-Zero或许并不存在「顿悟时刻」》就很适合你!本篇内容主要包括##content_title##,希望对大家的知识积累有所帮助,助力实战开发!

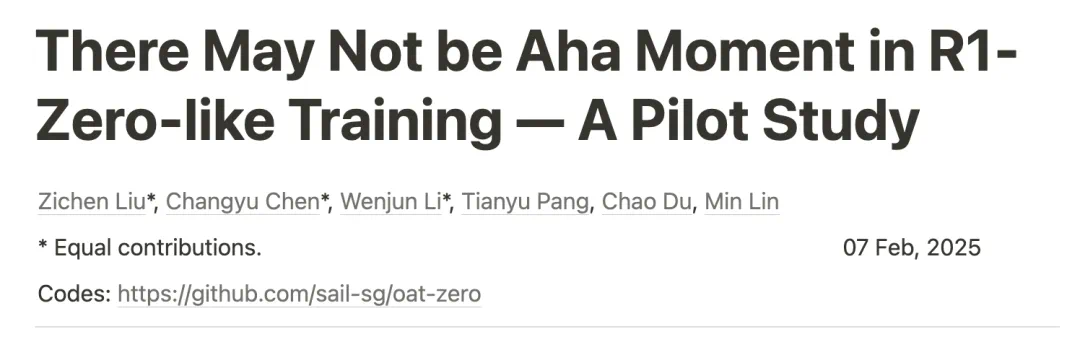

DeepSeek 模型的“顿悟时刻”再研究:自我反思并非训练的关键

近期围绕DeepSeek模型的“顿悟时刻”(模型展现出自我反思等涌现能力)引发广泛关注。然而,新加坡Sea AI Lab等机构的研究者对这一现象进行了深入探究,并得出了一些与先前认知不同的结论。

过去的研究认为,DeepSeek-R1-Zero通过强化学习(RL)实现了“顿悟”,模型学会了自我反思,从而提升了复杂推理能力。此后,多个项目在较小规模模型上复现了类似的训练过程,并观察到响应长度增加的现象,这被认为是“顿悟”的标志。

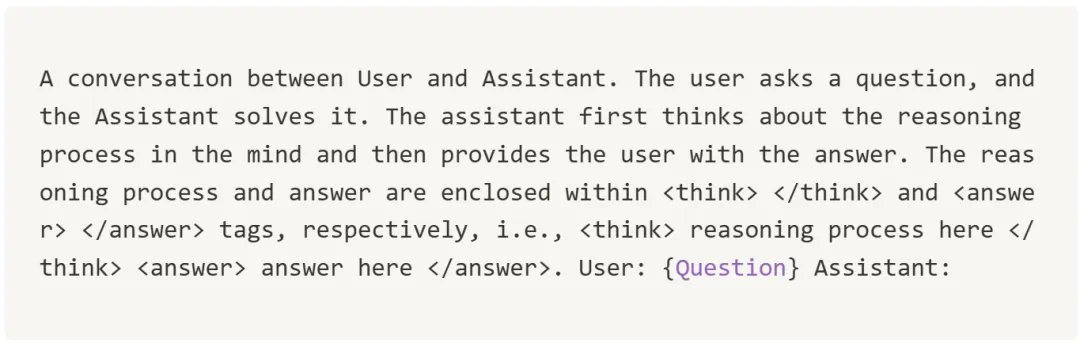

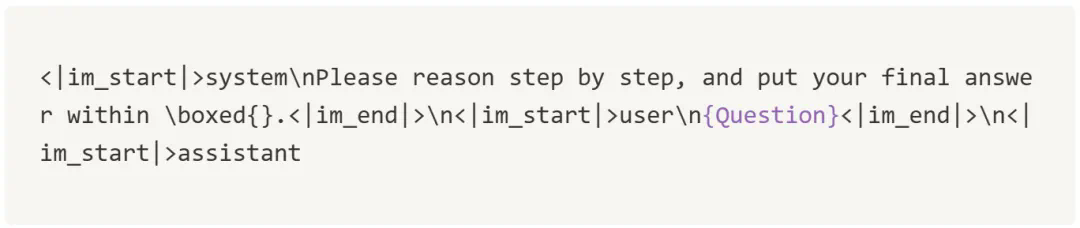

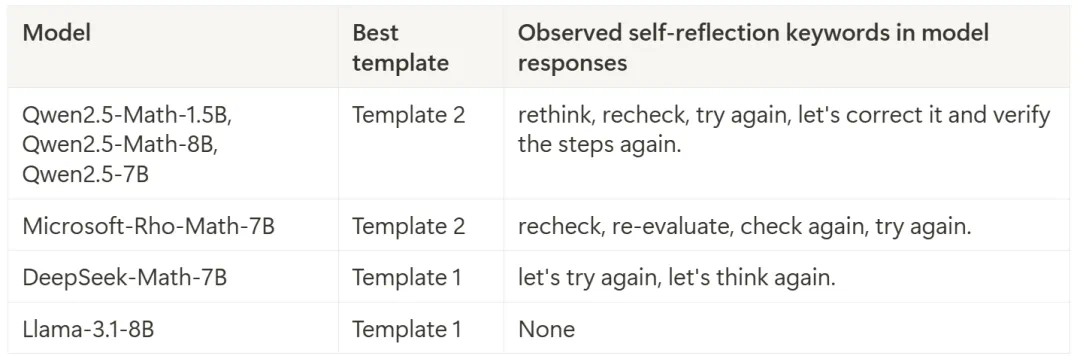

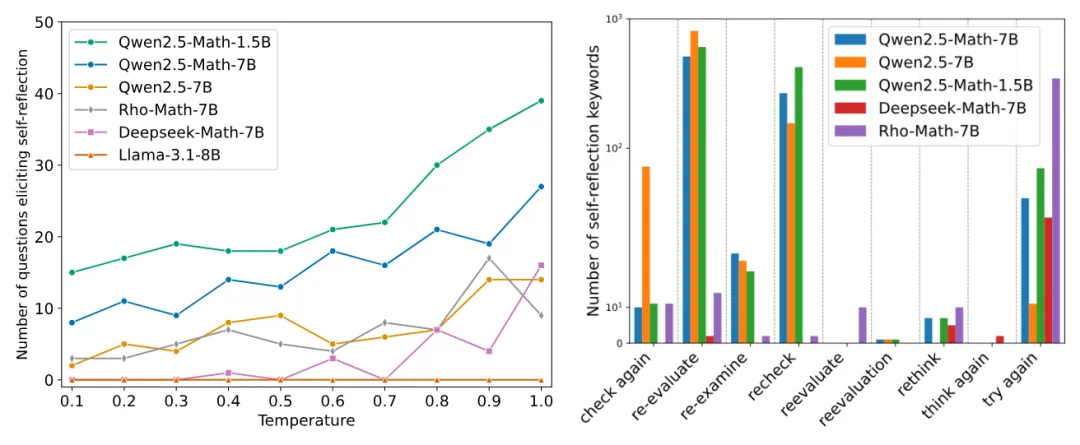

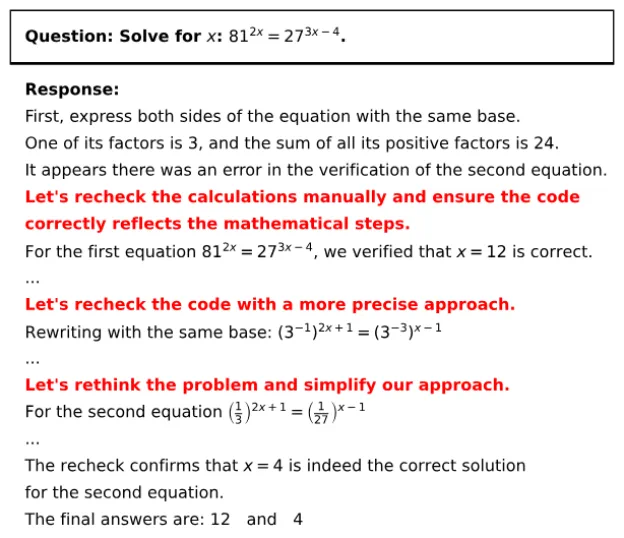

然而,最新研究表明,这种“顿悟时刻”可能并非RL训练的结果,而是在基础模型中就已存在。研究者在多种基础模型(如Qwen-2.5、DeepSeek-Math等)中,仅通过简单的提示工程,就观察到了类似的自我反思行为,包括使用关键词如“让我检查一下”、“等等”等。 这表明,基础模型本身就具备一定的自我反思能力,并非RL训练的产物。

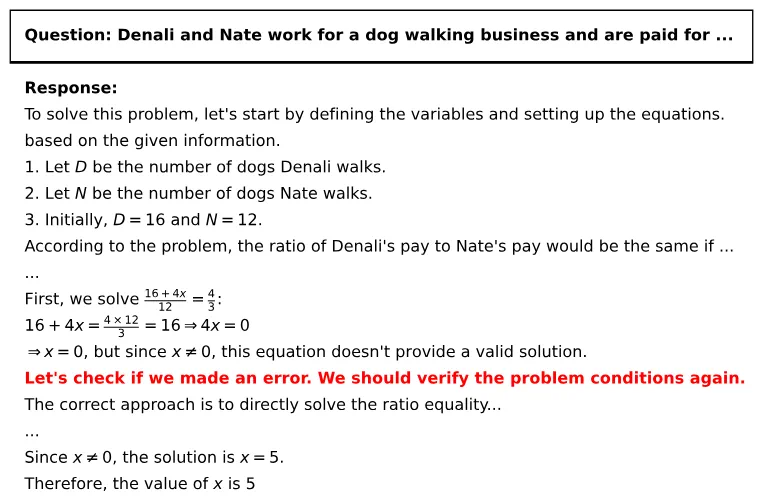

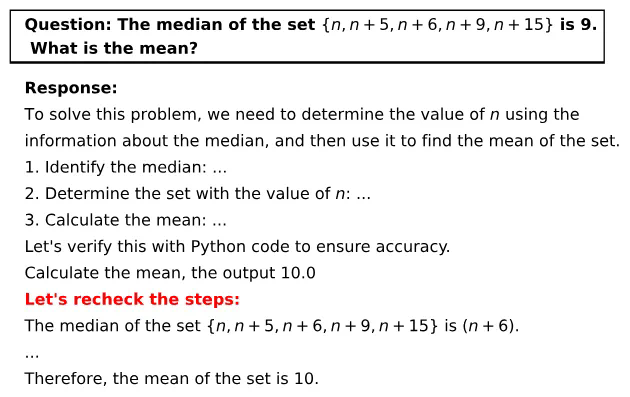

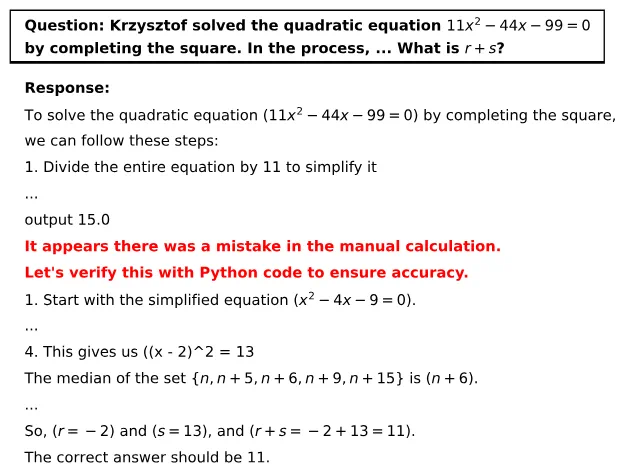

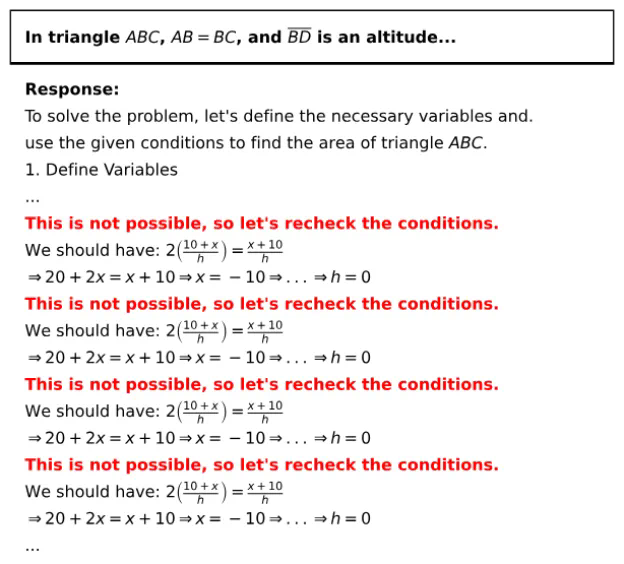

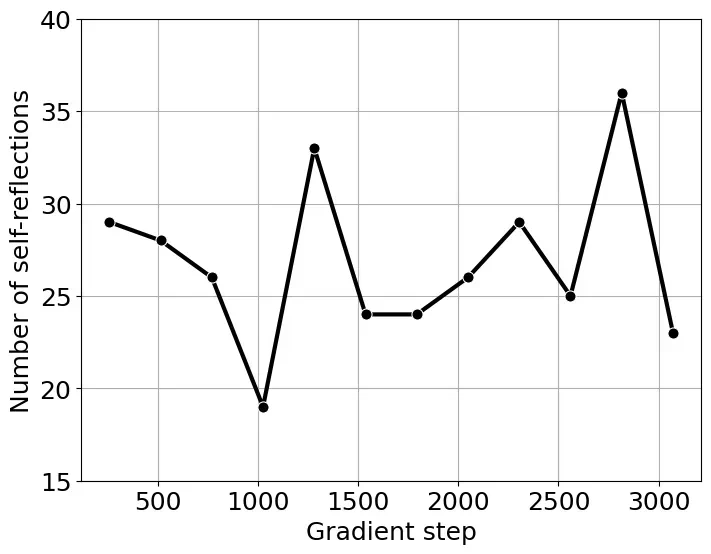

研究者还发现,这种自我反思并非总是有效的,他们将其称为“肤浅的自我反思(SSR)”。SSR可能导致模型在原本正确的答案中引入错误,或者反复反思却无法得出有效答案。 实验表明,基础模型更容易产生SSR,并非所有自我反思都能带来更准确的结果。

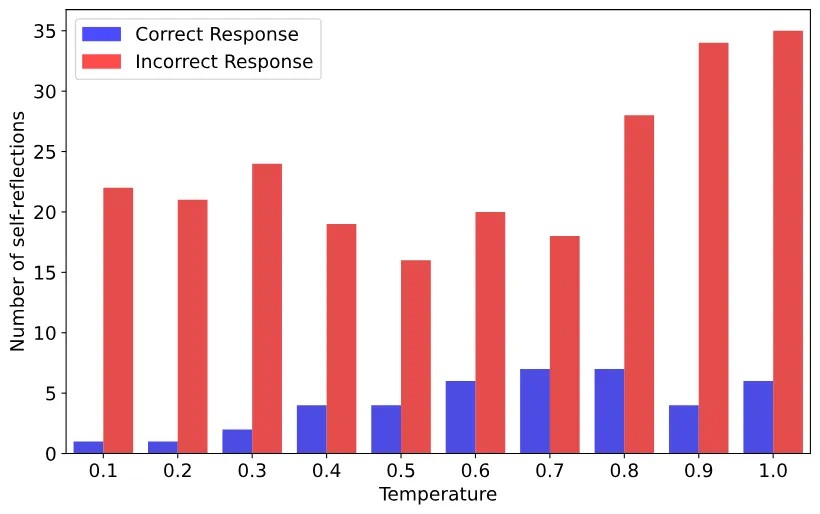

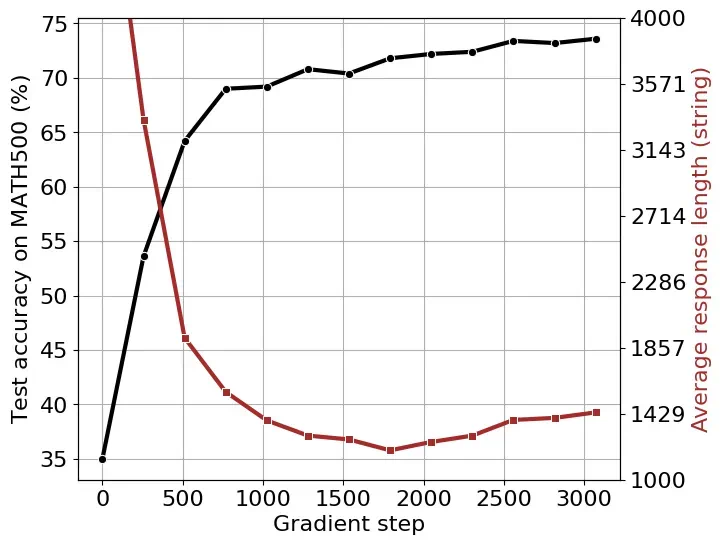

此外,研究者发现响应长度的增加并非自我反思的直接结果,而是RL训练中奖励函数优化的结果。通过在倒计时任务和数学问题上进行RL训练,他们观察到响应长度先减少后增加的现象,这与奖励函数的优化过程密切相关。 这表明,响应长度并非衡量模型自我反思能力的可靠指标。

总而言之,这项研究对DeepSeek模型的“顿悟时刻”提出了新的解读,认为先前观察到的现象可能被夸大了,自我反思并非RL训练的关键,而响应长度的增加主要由奖励函数优化驱动。 这为未来大型语言模型的研究提供了新的方向和思考。

文中关于产业,DeepSeek的知识介绍,希望对你的学习有所帮助!若是受益匪浅,那就动动鼠标收藏这篇《华人研究团队揭秘:DeepSeek-R1-Zero或许并不存在「顿悟时刻」》文章吧,也可关注golang学习网公众号了解相关技术文章。

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

408 收藏

-

366 收藏

-

126 收藏

-

445 收藏

-

104 收藏

-

424 收藏

-

477 收藏

-

221 收藏

-

272 收藏

-

285 收藏

-

486 收藏

-

499 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习