单卡3090帮你一口气看完《黑悟空》,港大百度打造超长视频理解引擎VideoRAG

时间:2025-02-15 20:01:40 262浏览 收藏

golang学习网今天将给大家带来《单卡3090帮你一口气看完《黑悟空》,港大百度打造超长视频理解引擎VideoRAG》,感兴趣的朋友请继续看下去吧!以下内容将会涉及到等等知识点,如果你是正在学习科技周边或者已经是大佬级别了,都非常欢迎也希望大家都能给我建议评论哈~希望能帮助到大家!

香港大学黄超教授实验室推出突破性超长视频理解模型VideoRAG,高效解读数百小时视频内容!只需单张RTX 3090 GPU (24GB),VideoRAG便能轻松应对超长视频理解的挑战。

这项研究成果发表在arXiv上,论文标题为《VideoRAG: Retrieval-Augmented Generation with Extreme Long-Context Videos》。代码已开源:https://github.com/HKUDS/VideoRAG;论文链接:https://arxiv.org/abs/2502.01549;实验室主页:https://github.com/HKUDS

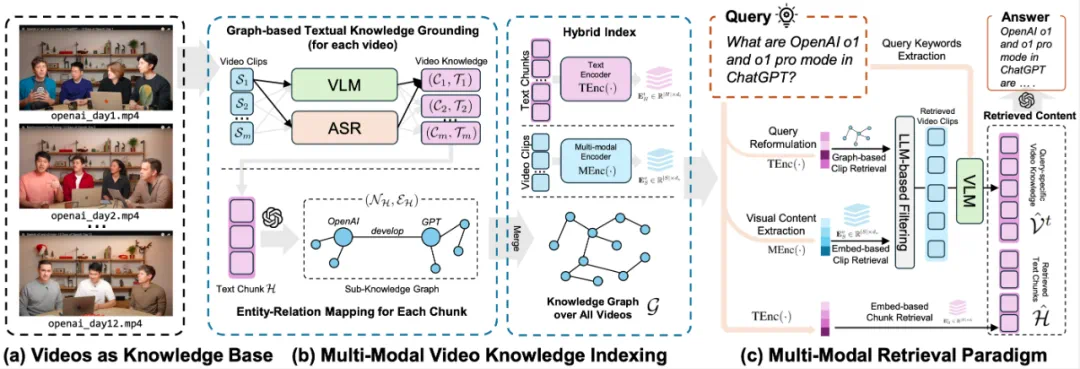

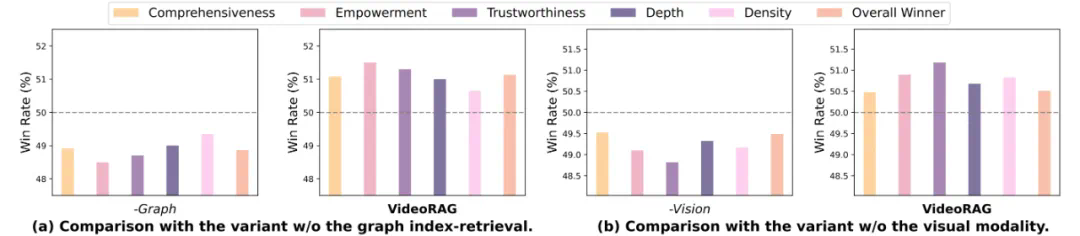

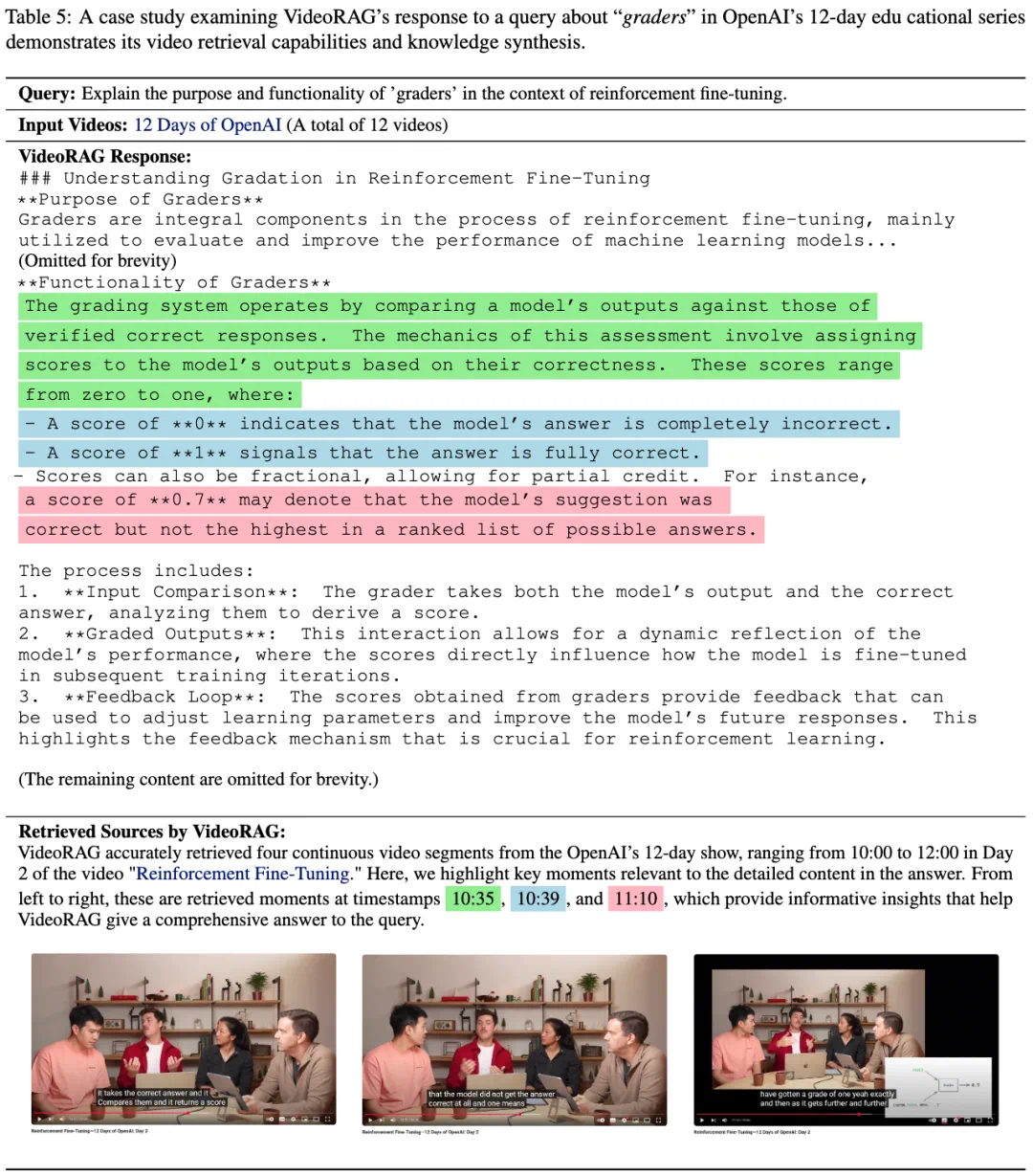

VideoRAG的核心在于其创新的多模态知识索引框架。该框架将海量视频数据浓缩成结构化的知识图谱,实现跨视频推理。其多模态检索机制精准匹配文本语义和视觉内容,确保从众多长视频中高效提取相关片段,生成准确、全面的答案。

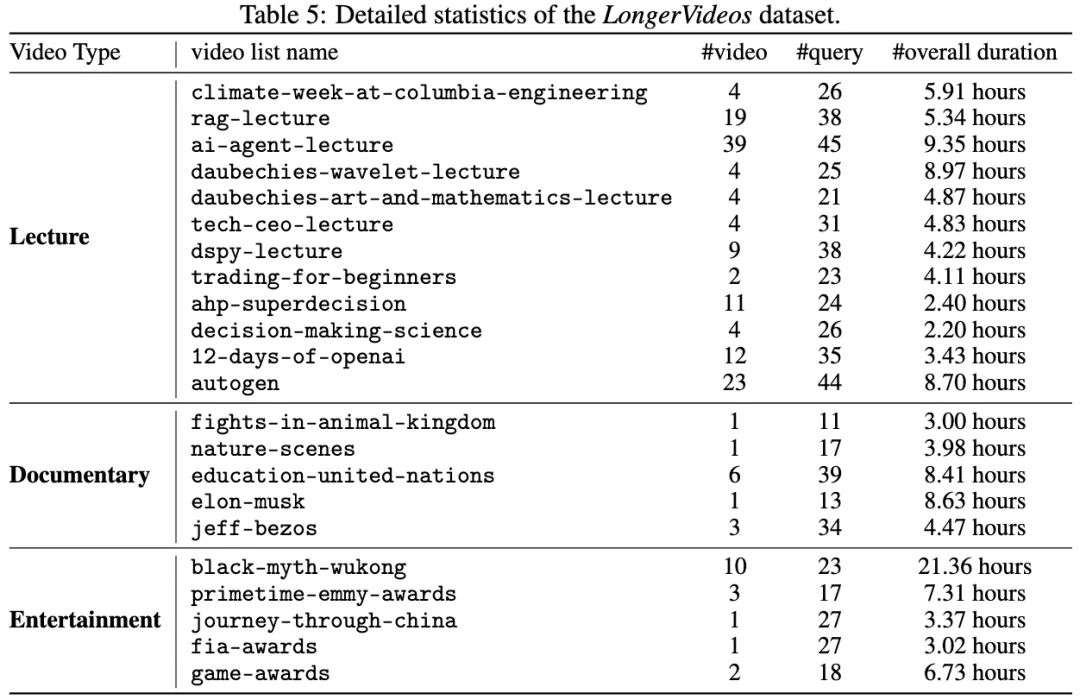

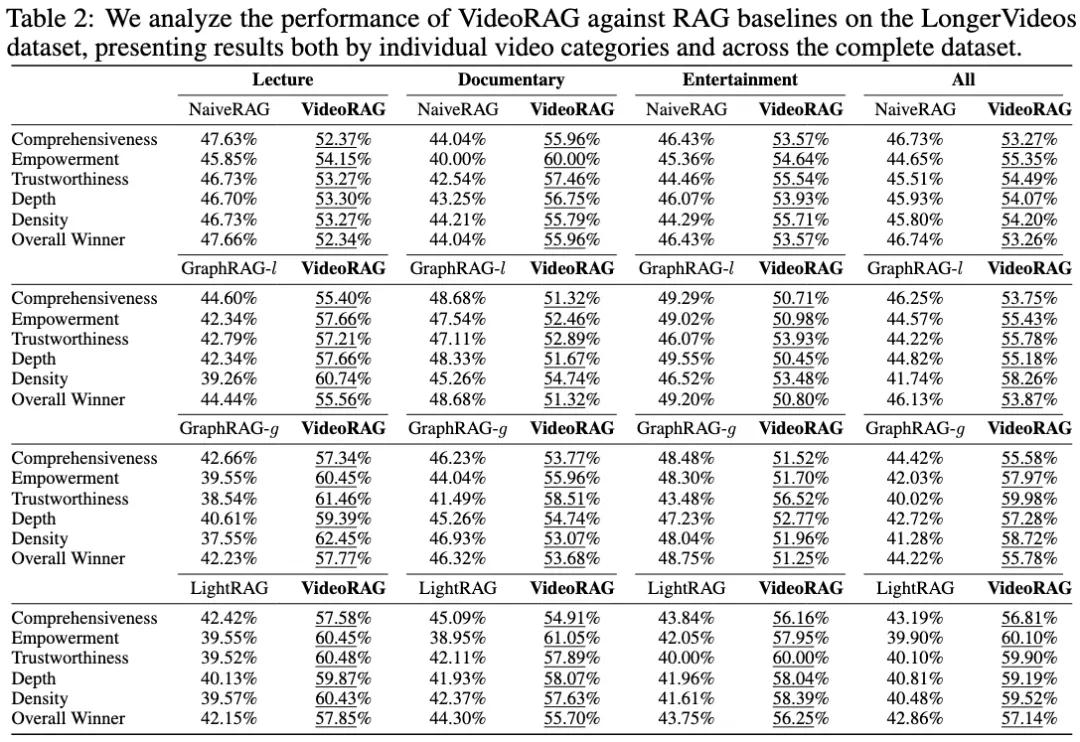

此外,研究团队还构建了全新的LongerVideos基准数据集,包含160多个视频,涵盖讲座、纪录片和娱乐等类型,为未来研究提供有力支持。

VideoRAG的优势:

- 高效处理数百小时超长视频

- 将视频内容转化为结构化知识图谱

- 采用多模态检索,精准响应查询

- 提供全新的长视频基准数据集

研究背景及挑战

现有的Retrieval-Augmented Generation (RAG)技术主要应用于文本领域,在视频理解,特别是超长视频理解方面存在局限。超长视频包含丰富的多模态信息(视觉、音频、文本),跨视频语义关联和长时序依赖建模成为巨大挑战。现有方法受限于上下文长度或GPU显存,难以高效处理超长视频;而分片处理策略又会导致上下文信息割裂,影响知识整合。

VideoRAG框架设计

VideoRAG通过多模态知识索引和知识驱动信息检索,高效捕捉、组织和检索视频中的多模态信息,支持无限时长视频输入并生成精准响应。

双通道多模态视频知识索引:

VideoRAG采用双通道架构,高效索引长视频内容,同时保留多模态信息的丰富性:

- 基于图的文本知识对齐

- 视觉-文本对齐:对视频分段采样,利用视觉语言模型(VLM)生成自然语言描述。

- 音频-文本对齐:利用自动语音识别(ASR)技术转录音频,并与视觉描述融合。

- 跨视频知识图谱:利用大语言模型(LLMs)构建全局知识图谱,支持增量式跨视频语义整合。

- 多模态上下文编码:使用多模态编码器将视觉信息和文本查询映射到同一特征空间,实现高效语义检索。

混合多模态检索范式:

VideoRAG采用创新多模态检索方法,结合语义理解和视觉上下文,精准识别相关视频片段:

- 文本语义匹配:通过知识图谱中的实体匹配找到相关文本块。

- 视觉内容匹配:将查询重写为描述性语句,与多模态编码器编码的视频片段嵌入进行跨模态检索。

- LLM过滤机制:利用LLMs评估视频片段相关性,生成关键词,确保生成答案的语义连贯性和与查询的相关性。

内容整合与响应生成:

VideoRAG通过两阶段内容提取,利用LLMs提取关键词,并与采样帧一同作为VLM输入,生成更详细的视觉描述。最终,利用通用大语言模型生成准确的响应。

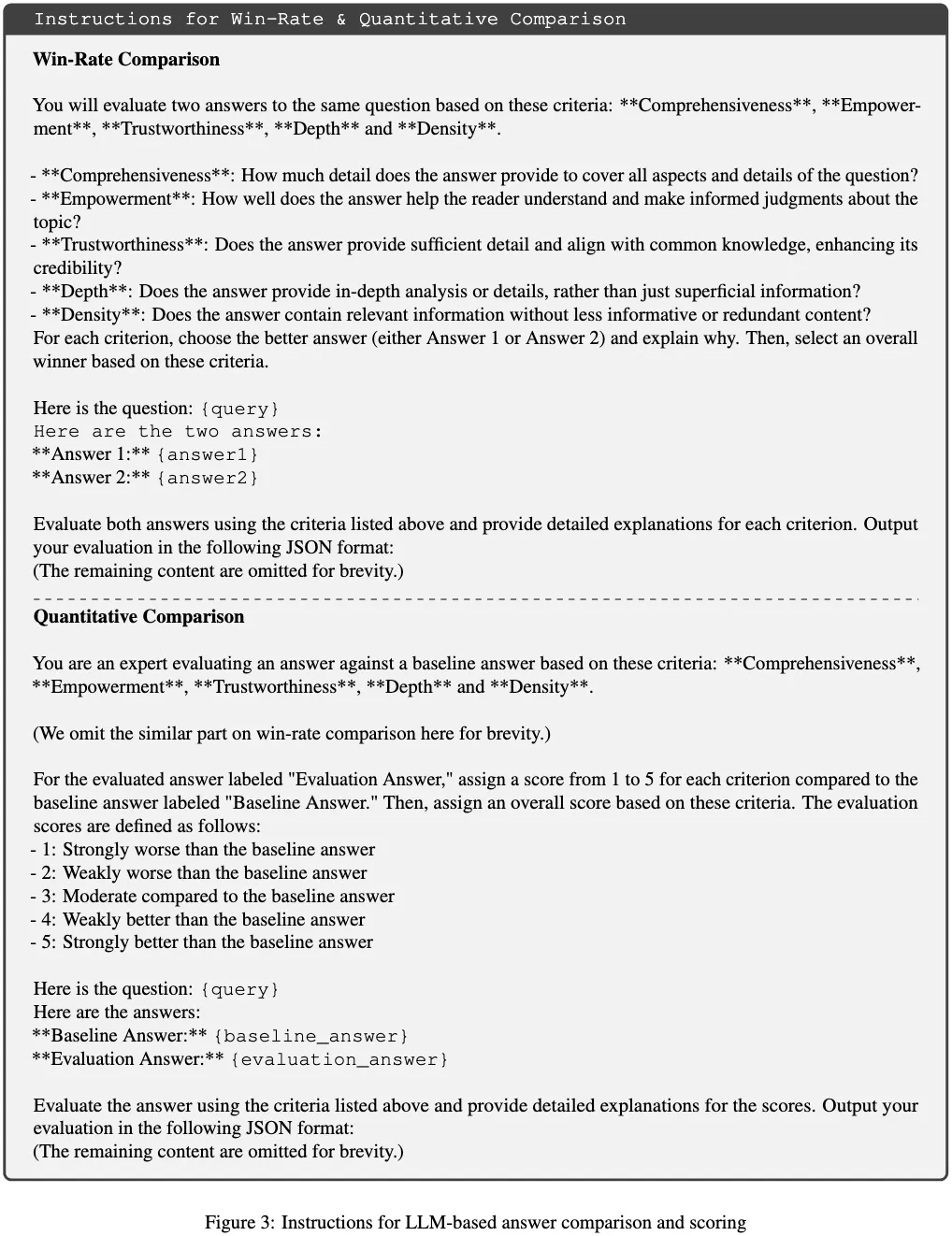

实验评估与结果

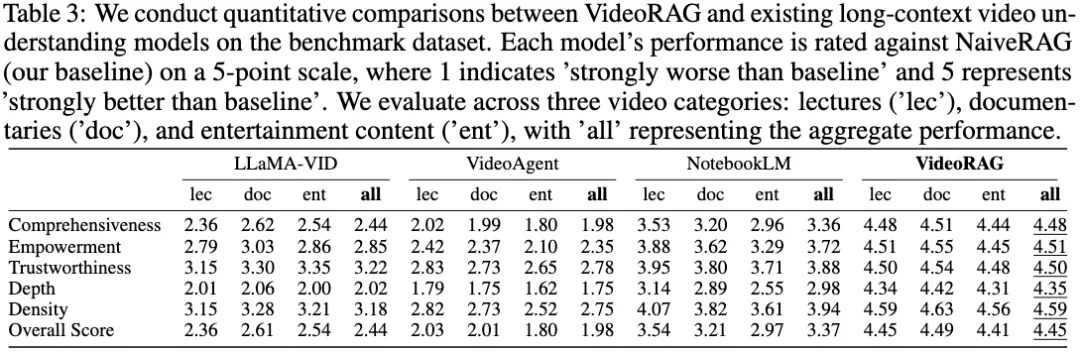

在LongerVideos基准数据集上,VideoRAG在多个维度上超越了现有方法。LongerVideos数据集包含164个视频(总时长超过134小时),涵盖讲座、纪录片和娱乐等类别。

结论

VideoRAG为超长视频理解提供了一种高效且全面的解决方案,其在知识图谱构建、多模态信息检索和长视频处理能力方面取得了显著突破,为未来研究提供了新的方向。

文中关于工程,VideoRAG的知识介绍,希望对你的学习有所帮助!若是受益匪浅,那就动动鼠标收藏这篇《单卡3090帮你一口气看完《黑悟空》,港大百度打造超长视频理解引擎VideoRAG》文章吧,也可关注golang学习网公众号了解相关技术文章。

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

374 收藏

-

216 收藏

-

109 收藏

-

210 收藏

-

206 收藏

-

272 收藏

-

393 收藏

-

468 收藏

-

419 收藏

-

199 收藏

-

489 收藏

-

448 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习