DeepSeek R1不编程就能生成GPU内核,比熟练工程师好,惊到了英伟达

时间:2025-02-16 08:13:13 218浏览 收藏

哈喽!大家好,很高兴又见面了,我是golang学习网的一名作者,今天由我给大家带来一篇《DeepSeek R1不编程就能生成GPU内核,比熟练工程师好,惊到了英伟达》,本文主要会讲到等等知识点,希望大家一起学习进步,也欢迎大家关注、点赞、收藏、转发! 下面就一起来看看吧!

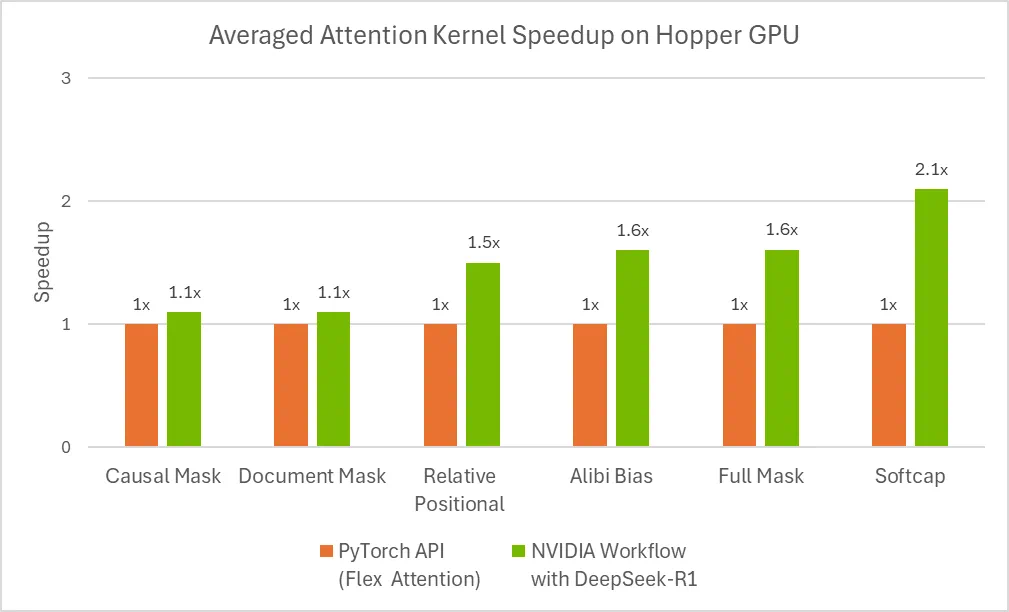

英伟达利用DeepSeek-R1自动生成优化GPU内核,引发AI社区热议。这项研究利用推理时扩展技术,让DeepSeek-R1模型在推理过程中分配额外计算资源,自动生成数值正确且针对不同注意力变体的优化GPU注意力内核,无需任何显式编程。

部分评论认为此举可能“自拆护城河”,也有人担忧工作岗位被AI取代。

随着AI大模型规模扩大和能力提升,测试时扩展(TTS)或推理时扩展(ITS)技术日益重要。该技术通过在推理过程中增加计算资源,评估多种结果并选择最佳方案,从而提升模型性能。 这使得AI初步具备了类似人类分析复杂问题的能力,能够逐步解决问题并得出最终答案。

英伟达的实验中,DeepSeek-R1模型通过推理时扩展技术,解决了自动生成优化GPU注意力内核的难题。在某些情况下,其生成的结果甚至超越了经验丰富的工程师。

优化注意力内核的需求与挑战

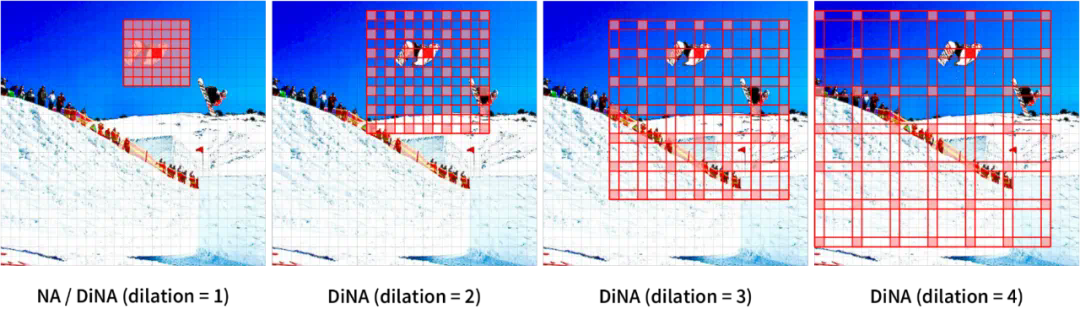

注意力机制是LLM的关键,但其计算复杂度与输入序列长度的平方成正比。因此,需要优化GPU内核以提高效率并避免错误。 此外,注意力机制有多种变体,工程师需要针对特定任务组合使用这些变体。多模态模型则带来了更多挑战,例如需要专门的注意力机制来处理时空信息。

即使对于经验丰富的工程师,创建优化GPU内核也需要大量时间和技能。虽然DeepSeek-R1等大模型在代码生成方面潜力巨大,但其初始尝试效果并不理想,因此需要在推理时采用其他策略。

示例Prompt如下:

<code>Please write a GPU attention kernel to support relative position encodings. Implement the relative positional encoding on the fly within the kernel. The complete code should be returned, including the necessary modifications.

Use the following function to compute the relative positional encoding:

def relative_positional(score, b, h, q_idx, kv_idx):

return score + (q_idx - kv_idx)

When implementing the kernel, keep in mind that a constant scaling factor 1.44269504 should be applied to the relative positional encoding due to qk_scale = sm_scale * 1.44269504. The PyTorch reference does not need to scale the relative positional encoding, but in the GPU kernel, use:

qk = qk * qk_scale + rel_pos * 1.44269504

Please provide the complete updated kernel code that incorporates these changes, ensuring that the relative positional encoding is applied efficiently within the kernel operations.</code>

大模型有时会产生错误或低效的代码。计算最佳GPU线程映射也极具挑战性。

推理时扩展生成优化GPU内核

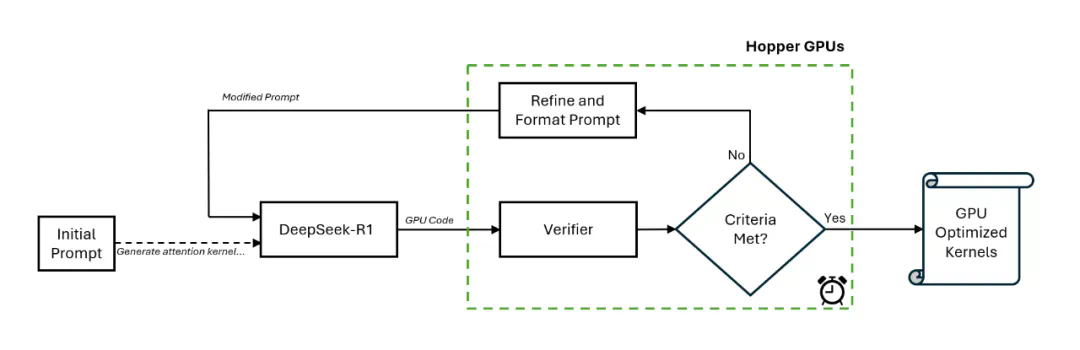

英伟达工程师创建了一个新的工作流程,包括一个验证器和一个闭环推理的DeepSeek-R1模型。

该流程首先由手动提示初始化,DeepSeek-R1生成GPU代码,验证器进行分析并生成新的提示,如此循环迭代。 英伟达发现,15分钟内即可得到改进的注意力内核。

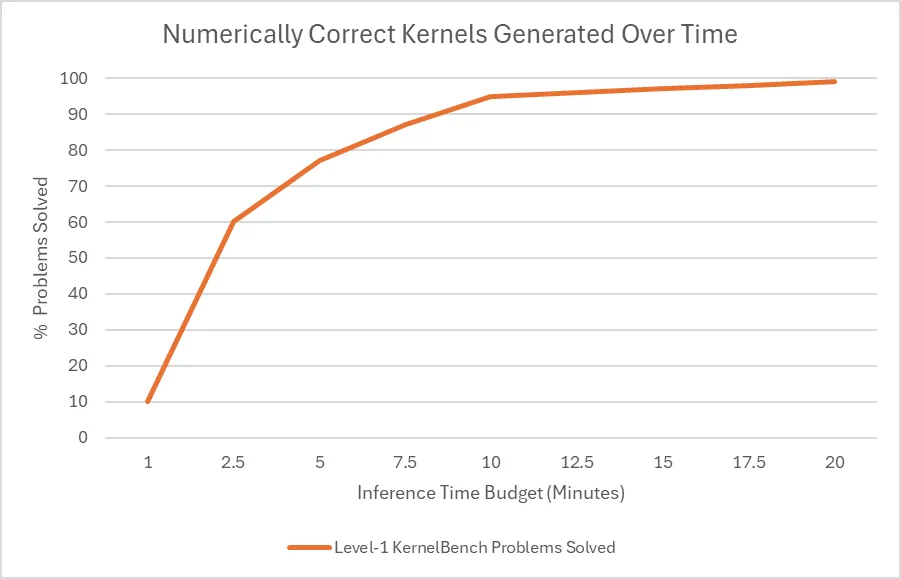

根据斯坦福的KernelBench基准测试,该流程可以为大部分问题生成数值正确的内核。 推理时间预算对解决率有显著影响,分配更多时间可以获得更好的结果。

这些结果表明,增加推理阶段的计算资源可以显著提升DeepSeek-R1生成优化GPU内核的性能。

今天关于《DeepSeek R1不编程就能生成GPU内核,比熟练工程师好,惊到了英伟达》的内容介绍就到此结束,如果有什么疑问或者建议,可以在golang学习网公众号下多多回复交流;文中若有不正之处,也希望回复留言以告知!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

273 收藏

-

252 收藏

-

251 收藏

-

104 收藏

-

315 收藏

-

329 收藏

-

242 收藏

-

162 收藏

-

268 收藏

-

151 收藏

-

311 收藏

-

286 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习