最强全模态模型Ola-7B横扫图像、视频、音频主流榜单,腾讯混元Research&清华&NTU联手打造

时间:2025-02-18 21:34:41 395浏览 收藏

在科技周边实战开发的过程中,我们经常会遇到一些这样那样的问题,然后要卡好半天,等问题解决了才发现原来一些细节知识点还是没有掌握好。今天golang学习网就整理分享《最强全模态模型Ola-7B横扫图像、视频、音频主流榜单,腾讯混元Research&清华&NTU联手打造》,聊聊,希望可以帮助到正在努力赚钱的你。

Ola:一款性能卓越的全模态语言模型,超越现有同类模型!

AIxiv专栏持续报道全球顶尖AI研究成果,如果您有优秀工作,欢迎投稿或联系报道 (liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com)。

Ola模型,由腾讯混元Research、清华大学智能视觉实验室和南洋理工大学S-Lab联合研发,在图像、视频和音频理解方面展现出强大的竞争力。论文共同一作:清华大学刘祖炎博士、南洋理工大学董宇昊博士;通讯作者:腾讯饶永铭高级研究员、清华大学鲁继文教授。

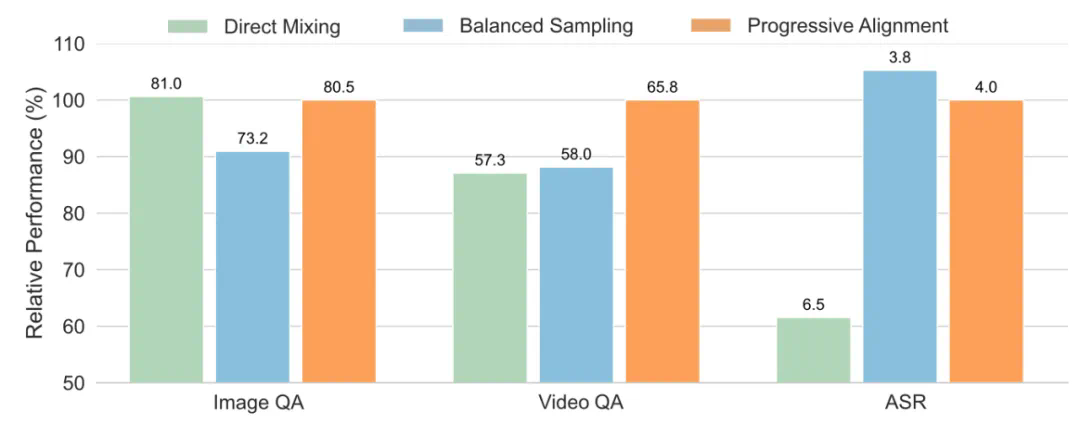

GPT-4o的出现激发了全模态模型的研究热潮。虽然已有开源替代方案,但性能仍逊色于专用单模态模型。Ola模型的核心创新在于其渐进式模态对齐策略,它逐步扩展模型支持的模态,先从图像和文本入手,再逐步加入语音和视频数据,有效降低了训练成本并提升了模型性能。

- 项目地址:https://ola-omni.github.io/

- 论文:https://arxiv.org/abs/2502.04328

- 代码:https://github.com/Ola-Omni/Ola

- 模型:https://huggingface.co/THUdyh/Ola-7b

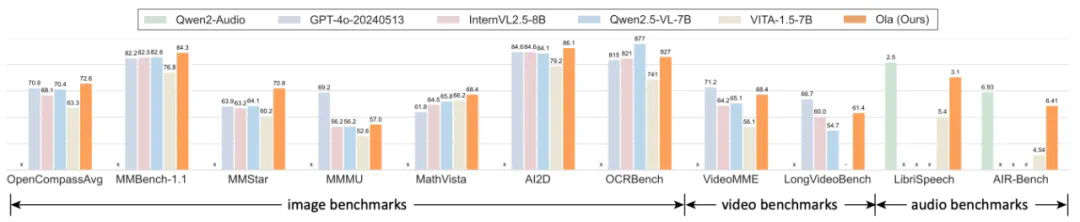

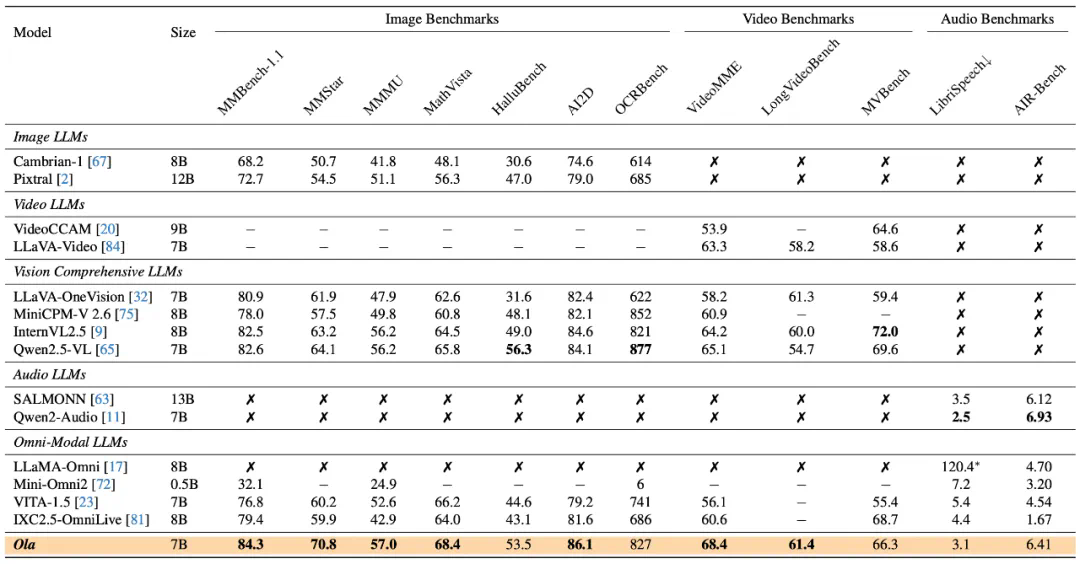

Ola模型在多个基准测试中显著超越了Qwen2.5-VL、InternVL2.5等主流模型。作为一款仅含70亿参数的全模态模型,它在图像、视频和音频理解方面均取得了突破性进展:

- 图像理解: 在OpenCompass基准测试中,其在8个数据集上的平均准确率达到72.6%,在所有参数量小于300亿的模型中排名第一,超越GPT-4o、InternVL2.5等。

- 视频理解: 在VideoMME测试中,Ola在输入视频和音频的情况下,准确率达到68.4%,超越LLaVA-Video、VideoLLaMA3等。

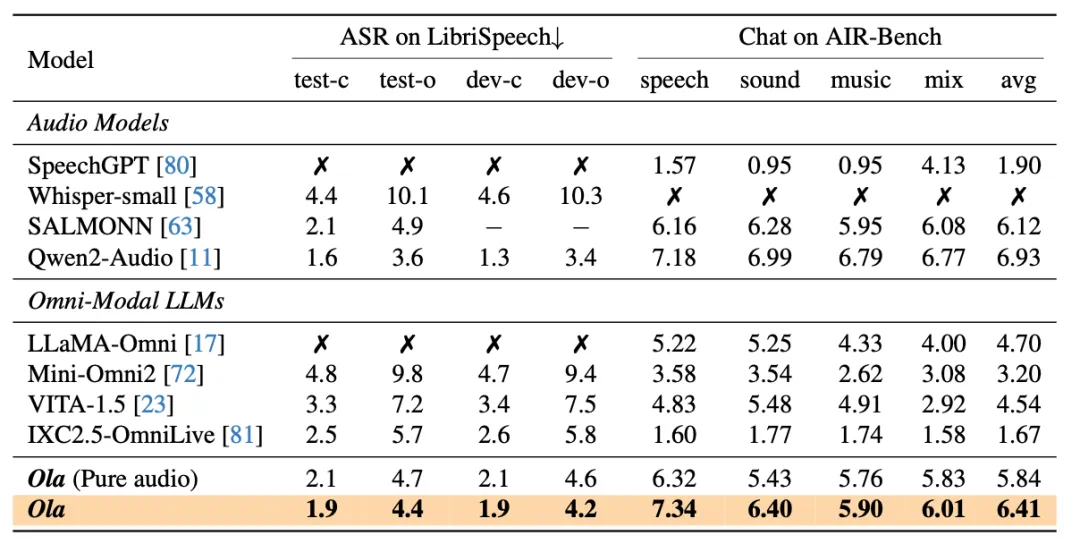

- 音频理解: 在语音识别和对话评估等任务中,Ola的表现也接近最先进的音频理解模型。

Ola模型、代码和训练数据均已开源,旨在推动全模态理解领域的研究发展。

图1:Ola全模态模型超越Qwen2.5-VL、InternVL2.5等主流多模态模型。

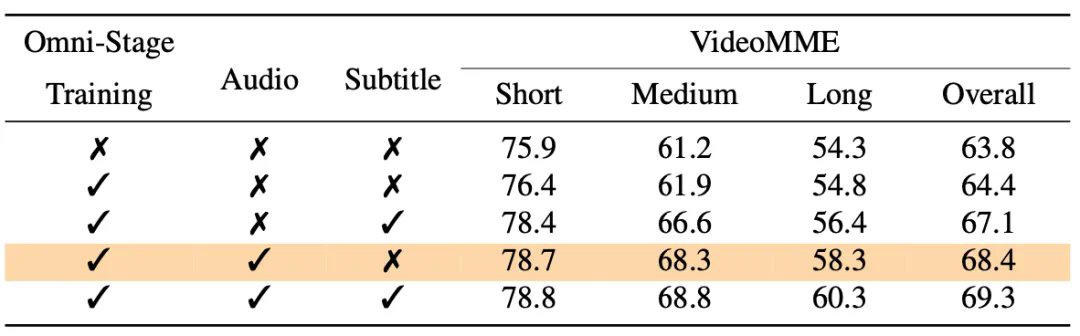

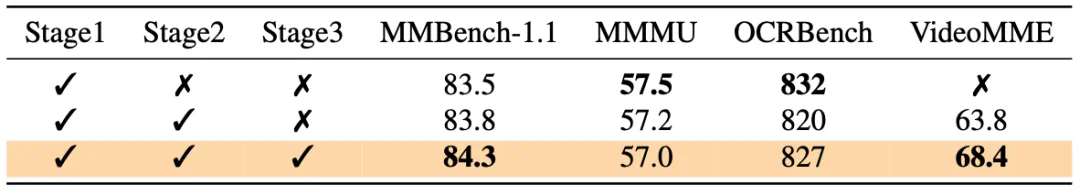

Ola模型的成功,得益于其独特的渐进式模态对齐策略、高效的架构设计以及高质量的训练数据。 该策略将复杂的训练过程分解为更易管理的步骤,并有效利用了视频数据作为连接视觉和音频模态的桥梁。

图2:渐进式模态学习能够训练更好的全模态模型

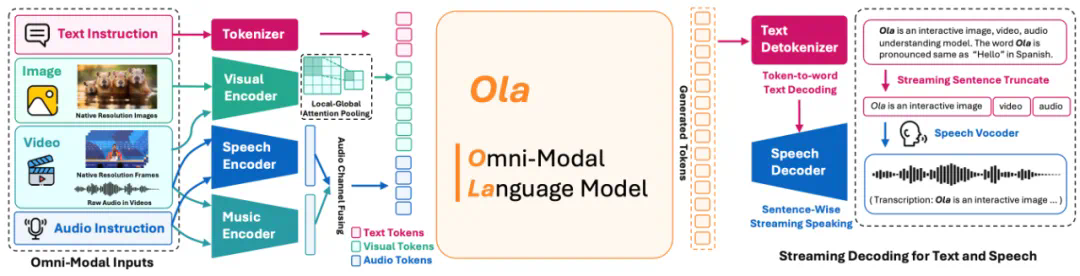

Ola模型的架构支持全模态输入和流式文本及语音生成,其视觉和音频联合对齐模块通过局部-全局注意力池化层有效融合了多模态信息。

图3:Ola模型结构图

Ola的训练数据涵盖了图像、视频和音频等多种模态,并包含专门设计的跨模态视频数据,以增强模型对音频和视频之间关系的理解。 实验结果充分证明了Ola模型的优越性能和渐进式模态对齐策略的有效性。 Ola的出现为全模态大模型的研究和应用带来了新的突破。

好了,本文到此结束,带大家了解了《最强全模态模型Ola-7B横扫图像、视频、音频主流榜单,腾讯混元Research&清华&NTU联手打造》,希望本文对你有所帮助!关注golang学习网公众号,给大家分享更多科技周边知识!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

499 收藏

-

408 收藏

-

323 收藏

-

356 收藏

-

194 收藏

-

473 收藏

-

241 收藏

-

350 收藏

-

188 收藏

-

134 收藏

-

343 收藏

-

355 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习