DeepSeek开源FlashMLA,推理加速惊人

时间:2025-02-27 15:00:56 236浏览 收藏

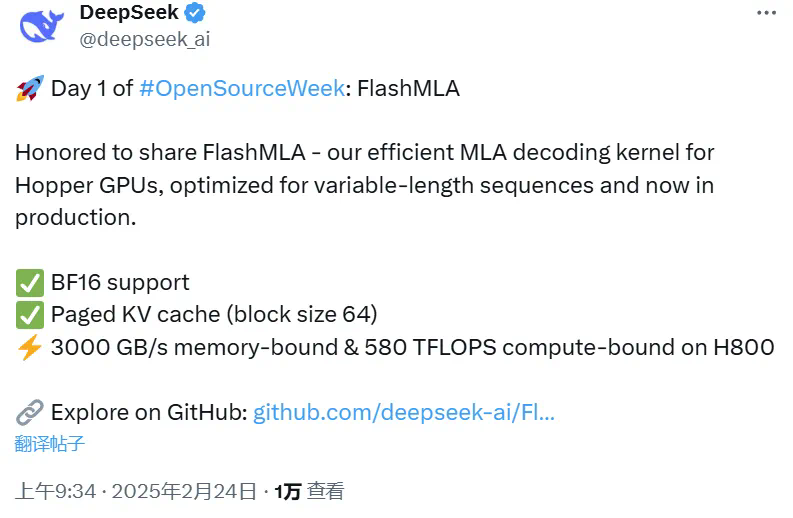

DeepSeek开源高效型MLA解码内核FlashMLA,助力Hopper GPU推理加速!该项目针对Hopper GPU架构优化,通过减少KV Cache并优化可变长度序列处理,显著降低长上下文推理成本,在H800 SXM5 GPU上内存速度上限达3000 GB/s,计算上限达580 TFLOPS。 FlashMLA支持BF16精度和64大小的分页kvcache,仅开源45分钟便收获400+Star,Star数量持续飙升。项目已支持CUDA 12.3及以上版本和PyTorch 2.0及以上版本,GitHub地址:https://github.com/deepseek-ai/FlashMLA。

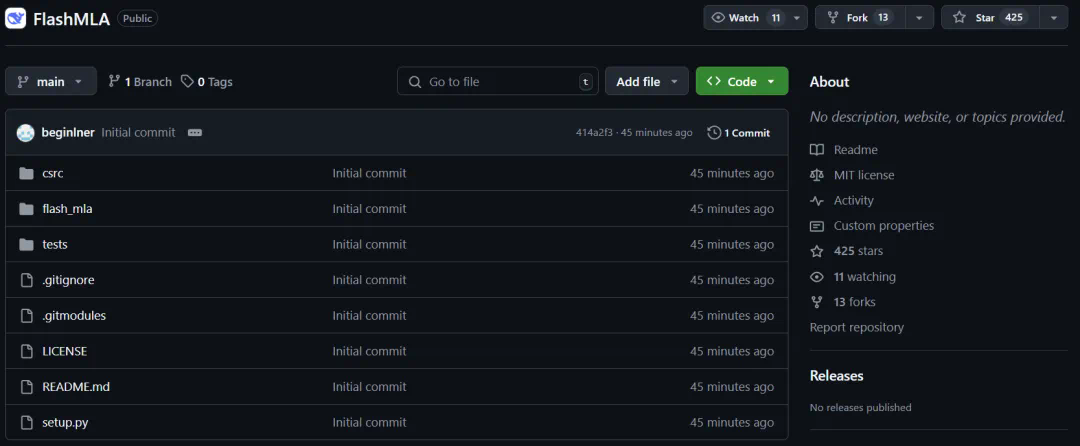

DeepSeek开源高效型MLA解码核FlashMLA,助力Hopper GPU推理加速!上周五DeepSeek预告开源周计划,并于北京时间周一上午9点开源了首个项目——FlashMLA,一款针对Hopper GPU优化的高效MLA解码内核,仅上线45分钟便收获400+Star!

该项目Star数量持续飙升!

项目地址:https://github.com/deepseek-ai/FlashMLA

FlashMLA的核心在于优化可变长度序列处理,减少推理过程中的KV Cache,从而在有限硬件资源下实现更长上下文推理,显著降低推理成本。 目前已发布的版本支持BF16精度和64大小的分页kvcache,在H800 SXM5 GPU上内存速度上限达3000 GB/s,计算上限达580 TFLOPS。

使用条件:

- Hopper GPU

- CUDA 12.3及以上版本

- PyTorch 2.0及以上版本

快速上手:

安装:

from flash_mla import get_mla_metadata, flash_mla_with_kvcache

tile_scheduler_metadata, num_splits = get_mla_metadata(cache_seqlens, s_q * h_q // h_kv, h_kv)

for i in range(num_layers):

...

o_i, lse_i = flash_mla_with_kvcache(

q_i, kvcache_i, block_table, cache_seqlens, dv,

tile_scheduler_metadata, num_splits, causal=True,

)

...

FlashMLA开源后获得广泛好评,甚至有网友调侃“第五天会是AGI”。

这无疑是真正的开源精神的体现!

今天关于《DeepSeek开源FlashMLA,推理加速惊人》的内容介绍就到此结束,如果有什么疑问或者建议,可以在golang学习网公众号下多多回复交流;文中若有不正之处,也希望回复留言以告知!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

135 收藏

-

250 收藏

-

140 收藏

-

329 收藏

-

380 收藏

-

138 收藏

-

477 收藏

-

455 收藏

-

408 收藏

-

366 收藏

-

126 收藏

-

445 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习