【分布式系列01期】常见的分布式ID生成方案浅析及大厂方案调研

来源:SegmentFault

时间:2023-01-13 14:30:12 393浏览 收藏

知识点掌握了,还需要不断练习才能熟练运用。下面golang学习网给大家带来一个数据库开发实战,手把手教大家学习《【分布式系列01期】常见的分布式ID生成方案浅析及大厂方案调研》,在实现功能的过程中也带大家重新温习相关知识点,温故而知新,回头看看说不定又有不一样的感悟!

PS:本文已收录到1.4K+ Star 数的开源项目《大厂面试指北》,如果想要了解更多,可以访问Github项目主页:

https://github.com/NotFound9/interviewGuide

建了一个技术交流群,欢迎大家进群一起玩耍,一起学习进步!进群还获取我自己原创的《大厂面试指北》PDF版

在日常的业务开发中,通常需要对一些数据做唯一标识,例如为大量抓取的文章入库时分配一个唯一的id,为用户下的订单分配订单号等等。并发量小的时候,通常会使用数据库自增的主键id作为唯一id。并发量大的时候就会考虑使用一些分布式ID的生成方案来生成id。由于一些特殊的业务需求,我们的业务中也使用到了分布式ID的生成,对分布式ID的各种方案进行了调研。所以这里给大家分享一些我们在实践过程中进行的调研和实践优化经验,因为篇幅比较长,我们主要分为三篇:

【分布式系列01期】常见的分布式ID生成方案浅析及大厂方案调研

【分布式系列02期】开源分布式ID生成框架Leaf和uid-generator的原理分析

【分布式系列03期】开源分布式ID生成框架Leaf和uid-generator存在的问题及优化改进

摘要

本文是【分布式系列01期】中的第一篇,主要包含分布式ID生成方案简介和当前大公司的ID生成方案研究两部分

一、分布式ID生成方案简介

目前常用的分布式ID生成方案主要由以下几种:

1.使用UUID算法生成唯一id。

2.利用单机数据库主键自增来生成唯一id。

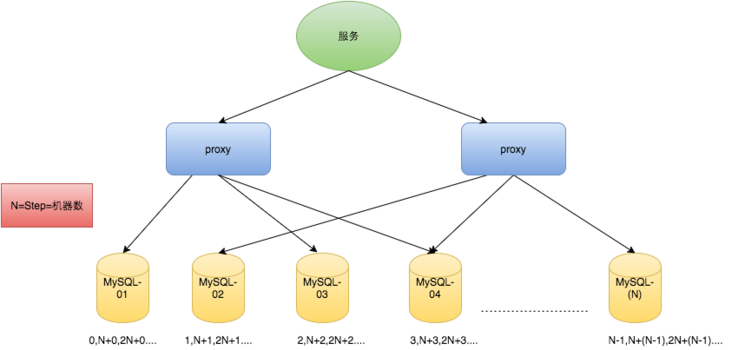

3.多数据库主键自增生成唯一id。(设置步长区分不同数据库)

4.数据库分段发号生成唯一id。(例如美团的Leaf框架中的segement模式)

5.基于snowflake算法生成唯一id(例如美团的Leaf框架中的snowflake模式,百度的uid-generator)

这是我做的总结表:

| 方案 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 使用UUID算法生成唯一id | 无任何依赖 | ID太长,且不是数字类型 | 生成seesion_id |

| 利用单机数据库主键自增来生成唯一id | 方便接入,单调递增 | 生成效率低,强依赖于数据库,id是连续的 | 适用于并发量不高的业务。 |

| 多数据库主键自增生成唯一id | 方便接入,单调递增,生成效率比单机数据库高 | 不方便扩容,强依赖于数据库,id是连续的 | 适合分库分表的架构生成id |

| 数据库分段发号生成唯一id | 效率高 | 强依赖于数据库,id是连续的 | 适合id生成并发量高的业务,并且id连续 不会破坏信息安全的业务。 |

| 基于snowflake算法生成唯一id | 效率高,运行期间可以不依赖其他组件 | id分布不均,对有些业务会造成数据倾斜的问题 | 适合id生成并发量高的业务 |

1.UUID

简单的来说,UUID是服务器在不需要任何外界依赖(像类Snowflake算法的方案都需要注册中心)的情况下,基于当前时间、计数器(counter)和硬件标识等等信息生成的唯一ID。

优点

无任何依赖

其他的技术方案都是有依赖的,比如单机数据库主键自增生成ID强依赖数据库,类Snowflake算法的方案至少启动时都需要注册中心,Leaf框架Snowflake模式需要定时上传时间戳到注册中心,的UUID生成不需要任何外界依赖,

缺点

ID太长,且不是数字类型

当然为了唯一性,带来的牺牲就是生成的结果一般是32位的字符串。由于字符串太长,并且不是数字类型,所以不适合作为数据库的主键。

(字符串作为主键id,插入数据时会是在聚集索引中是随机插入,容易造成页分离。而且字符串的比较比数字类型的开销更大,字符串作为主键id查询效率会低于数字类型的主键。)

适用场景

通常可以作为一些临时性唯一标识,例如用户登陆后,生成一个UUID作为登录的会话ID,作为key存储在Redis中,Value是用户相关的信息。

2.单机数据库主键自增

业务量不大时普遍采用这种方案来生成id。

优点

方便接入

因为一般的项目不一定会用到Zookeeper等这些组件,但是基本都会用到数据库,所以项目接入会比较简单,也没有增加额外的维护成本。

单调递增

是绝对的单调递增的,就是从时间线上看,后面生成的id肯定比前面生成的id要大。

缺点

生成id效率有限

因为id生成依赖于单机数据库的主键自增,所以无法满足id并发量很大的业务需求。

强依赖于数据库

一旦单机数据库发生宕机,就没法生成id,导致整个系统不可用。如果数据库是主从架构的,主库发生故障,切换成从库,如果从库还没来得及收到主库最新的插入id的更新,就有可能导致从库当前的自增id不是最新的,从而生成出重复的id。

id是连续的

id是连续的有可能会成为缺点,竞争对手在当天12点下一个订单,然后在第二天12点下一个订单,可能根据订单id的差就可以推测出每天的订单量。像猫眼电影就使用了这种方法来生成电影的id。一般我们日常使用时,其实为了让我们生成id的方式更难被竞争对手猜测出,一般是不会从1开始的,但是猫眼电影这里是从1开始的,而且是连续的,所以我们使用二分法很快就确定了8875是最大的值,也就是总共有8875部电影,而且由于是连续的,爬取也会比较方便。

猫眼电影的id——也是使用单机数据库生成的,连续自增的

https://maoyan.com/films/1 https://maoyan.com/films/2 https://maoyan.com/films/8874 https://maoyan.com/films/8875 https://maoyan.com/films/8876 (1到8875可以请求到数据,8876及后面的id 请求不到数据,没有这些id对应的电影,说明总共有8875部电影)

除非去做额外的处理(例如定时去获取当前的自增起始值a,然后生成一个随机数b,使用

CREATE TABLE table (...) AUTO_INCREMENT = n; alter table

| 外卖 | 下单时间 |

|---|---|

| 5026 0271 7642 2612 7 | 2018-09-02 17:46:03 |

| 6233 7340 1594 0462 | 2018-07-17 18:34:11 |

| 3962 9431 3190 0632 1 | 2018-07-15 11:52:55 |

| 2273 5322 6921 7033 5 | 2017-06-30 11:39:01 |

汽车之家

使用的就是自增id,现有数据从4位到6位,目前最大320w+,实现原理应该就是数据库主键自增,由于他们的量比较大,应该是采用的多数据库设置步长,来多数据库生成id的。

下面是统计表

| 作品id | URL | 类型 |

|---|---|---|

| 9999 | https://chejiahao.autohome.co... | 轻文 |

| 3200292 | https://chejiahao.autohome.co... | 轻文 |

| 3200293 | https://chejiahao.autohome.co... | 视频 |

| 3200294 | https://chejiahao.autohome.co... | 文章 |

| 3292759 | https://chejiahao.autohome.co... | 车单 |

| 2037191 | https://chejiahao.autohome.co... | 音频 |

总结

感觉目前大公司还是使用Snowflake作为分布式ID生成方案的比较多,一方面可以满足并发量很高的id获取需求,一方面id连续性很低,可以保证信息安全,提高爬虫难度。除此以外,可能有一些业务刚起步时并发量小直接采用单机数据库主键自增生成id,使用

4.数据库分段发号生成唯一id这种方案也能满足高并发量,但主要还是id是连续的,即便是额外开发id丢弃逻辑,也容易被竞争对手一个一个id请求来推测出订单量信息。

精彩回顾:

【大厂面试01期】高并发场景下,如何保证缓存与数据库一致性?

【大厂面试02期】Redis过期key是怎么样清理的?

【大厂面试03期】MySQL是怎么解决幻读问题的?

【大厂面试04期】讲讲一条MySQL更新语句是怎么执行的?

【大厂面试05期】说一说你对MySQL中锁的理解?

【大厂面试06期】谈一谈你对Redis持久化的理解?

【大厂面试07期】说一说你对synchronized锁的理解?

【大厂面试08期】谈一谈你对HashMap的理解?

本篇关于《【分布式系列01期】常见的分布式ID生成方案浅析及大厂方案调研》的介绍就到此结束啦,但是学无止境,想要了解学习更多关于数据库的相关知识,请关注golang学习网公众号!

-

499 收藏

-

286 收藏

-

244 收藏

-

235 收藏

-

157 收藏

-

120 收藏

-

404 收藏

-

427 收藏

-

351 收藏

-

156 收藏

-

405 收藏

-

497 收藏

-

133 收藏

-

319 收藏

-

141 收藏

-

256 收藏

-

259 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习