ICLR2025炸裂!浙大千问DataMan:53页预训练数据管理神器深度解析

时间:2025-03-11 17:34:32 135浏览 收藏

ICLR 2025论文《DataMan: Data Manager for Pre-training Large Language Models》提出了一种名为DataMan的大语言模型预训练数据管理器,由浙江大学和阿里巴巴千问团队联合研发。DataMan创新性地采用逆向思维,通过分析模型对不同数据质量的反应,建立了一套全面的数据质量评估标准,包含13个关键文本质量指标和一个综合评分。该系统集数据标注、模型微调和数据采样于一体,能够有效提升模型训练效率。实验结果表明,DataMan显著提升了模型在语言建模、任务泛化和指令遵循等方面的性能,尤其在指令遵循任务上胜率高达78.5%。 DataMan为大模型预训练数据管理提供了新的解决方案,具有重要的研究价值和应用前景。

DataMan:提升大语言模型预训练效率的数据管理器

AIxiv专栏持续报道全球顶尖AI研究成果。本文介绍由浙江大学和阿里巴巴千问团队合作完成的一项研究,该研究针对大语言模型(LLMs)预训练数据选择问题,提出了一种名为DataMan的数据管理器,用于提升模型训练效率。

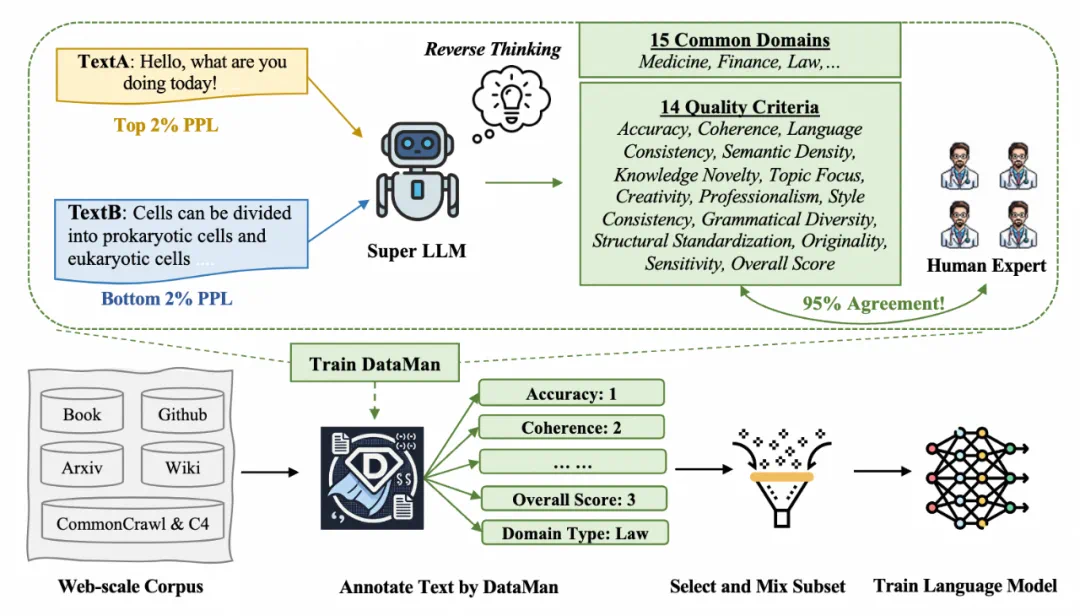

在模型规模不断增长的背景下,预训练数据质量至关重要。然而,现有方法往往依赖经验和直觉,缺乏系统性指导。DataMan通过逆向思维,即分析模型对不同数据质量的反应,来建立一套全面的数据质量评估标准。

一、基于逆向思维的质量标准构建

DataMan的研究人员采用四步法构建质量标准:

- 分析困惑度异常: 利用超级LLM分析预训练数据中困惑度(PPL)极高和极低的文本,找出影响模型性能的关键文本特征。

- 迭代提炼标准: 基于步骤1的分析,迭代提炼出13个关键的文本质量标准,涵盖准确性、连贯性、语言风格、知识新颖性、主题聚焦等多个方面。

- 构建综合评分体系: 除了13个标准外,还构建了一个综合“总体评分”,更全面地评估文本质量。

- 验证标准有效性: 将超级LLM的评分与人工评分进行对比,验证标准的有效性,结果显示一致性超过95%。

二、DataMan数据管理流程

DataMan是一个集数据标注、模型微调和数据采样于一体的数据管理器:

- 数据标注: 对SlimPajama语料库进行标注,为每个文档打上14个质量评分和15个应用领域的标签。

- 模型微调: 使用Qwen2-1.5B作为基础模型,通过文本生成损失进行微调,使DataMan能够自动评分和识别领域。

- 数据采样: 基于DataMan的评分和领域识别结果,采用top-k采样等策略,选择最优的数据子集进行模型训练。

三、实验结果与分析

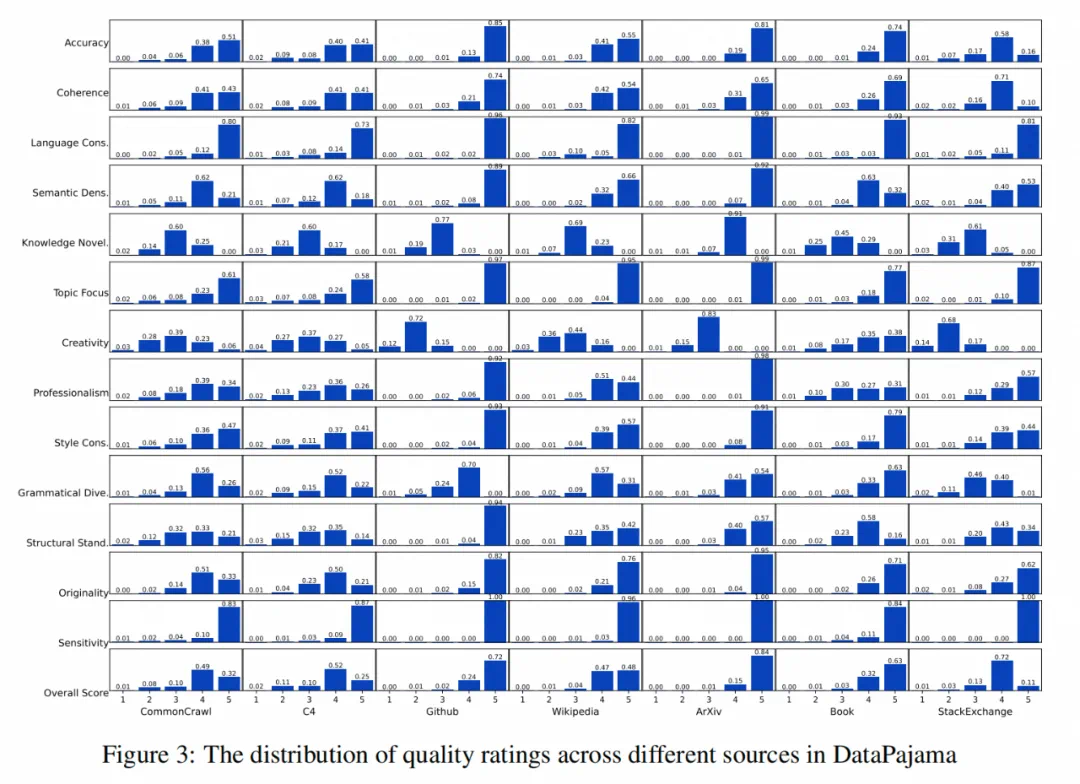

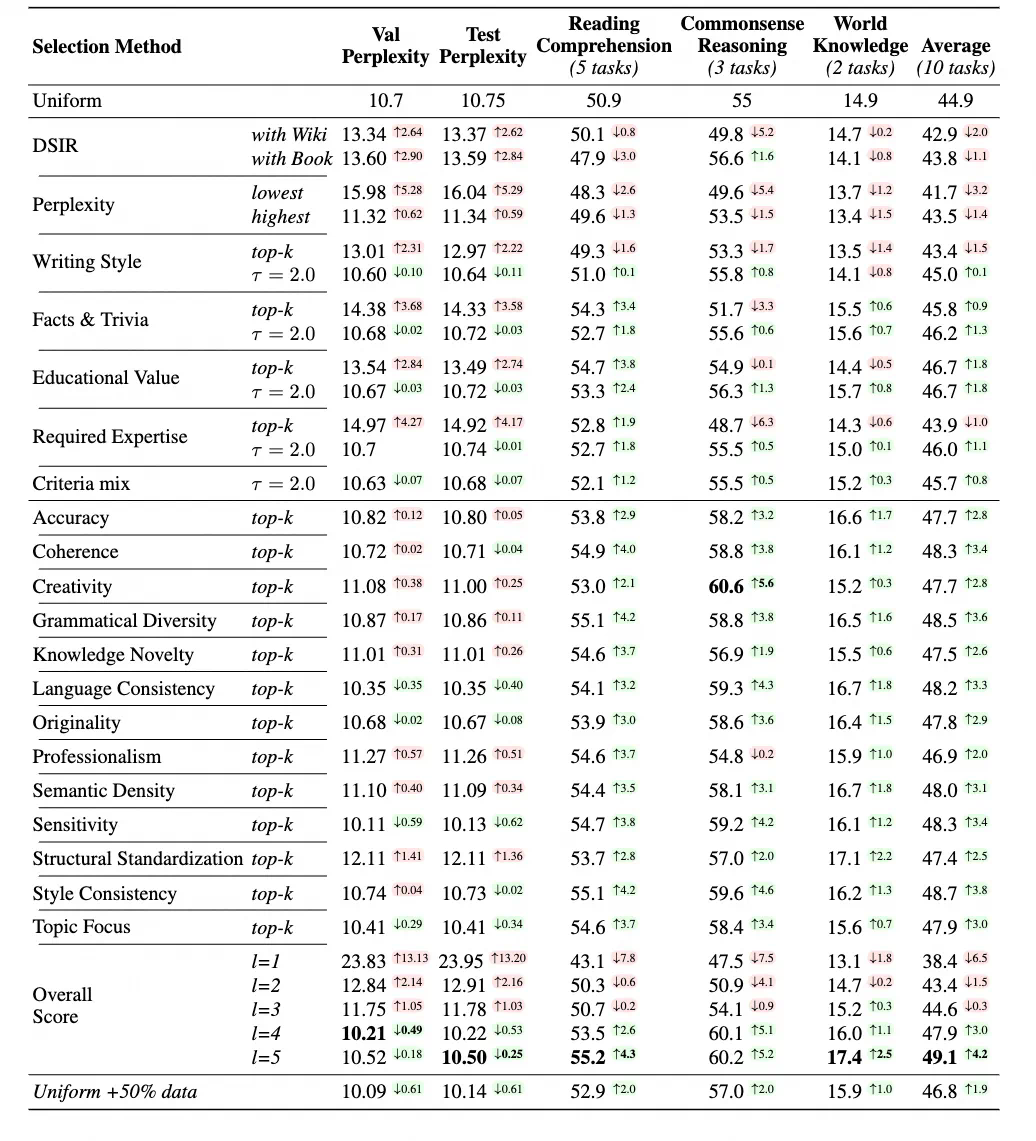

研究人员使用DataPajama (447B tokens)语料库进行实验,对比了DataMan与其他数据选择方法的性能:

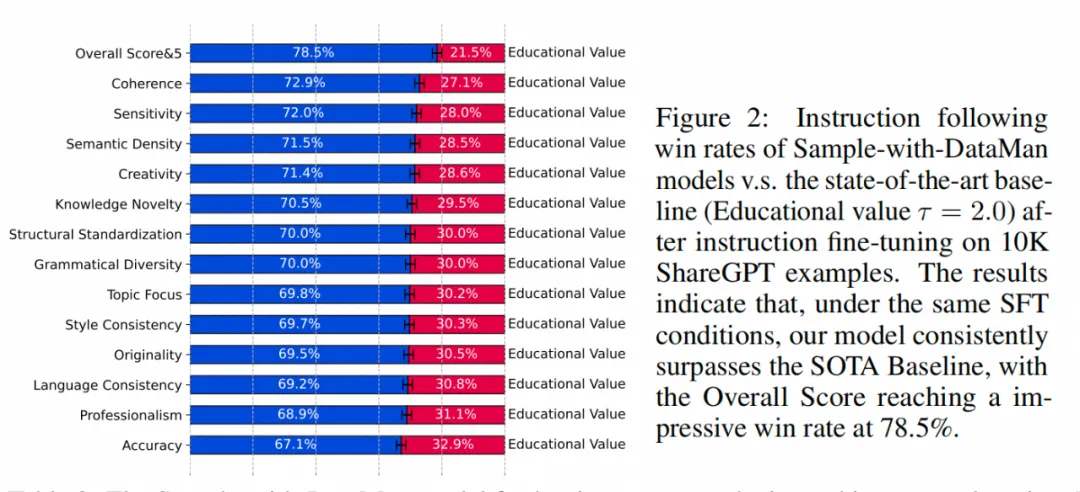

- DataMan显著提升模型性能: 在语言建模、任务泛化和指令遵循等方面,使用DataMan选择的数据训练的模型均优于基线模型,指令遵循任务的胜率高达78.5%。

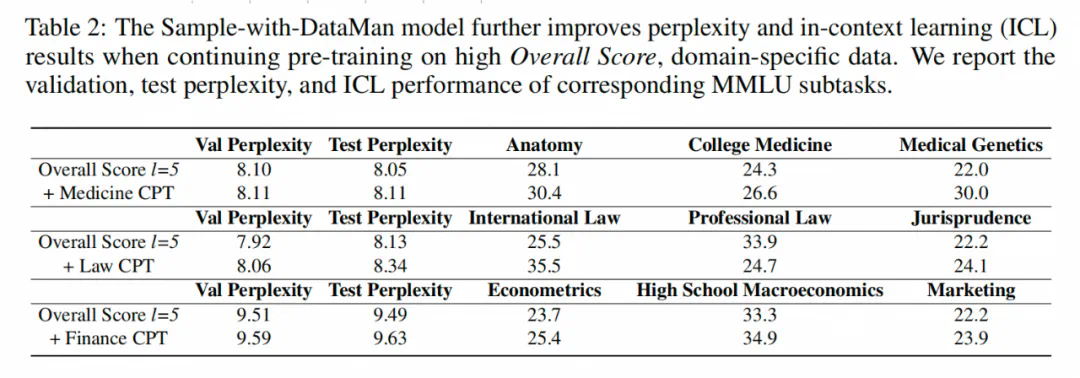

- 有效进行领域数据混合: DataMan的领域识别能力可以有效地进行领域数据混合,进一步提升模型在特定领域的性能。

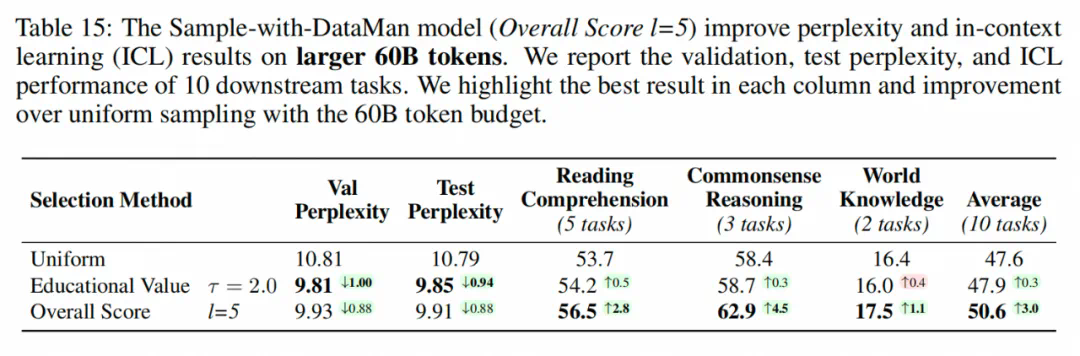

- 数据量与性能正相关: 使用更大规模的数据集(60B tokens)进行训练,模型性能进一步提升。

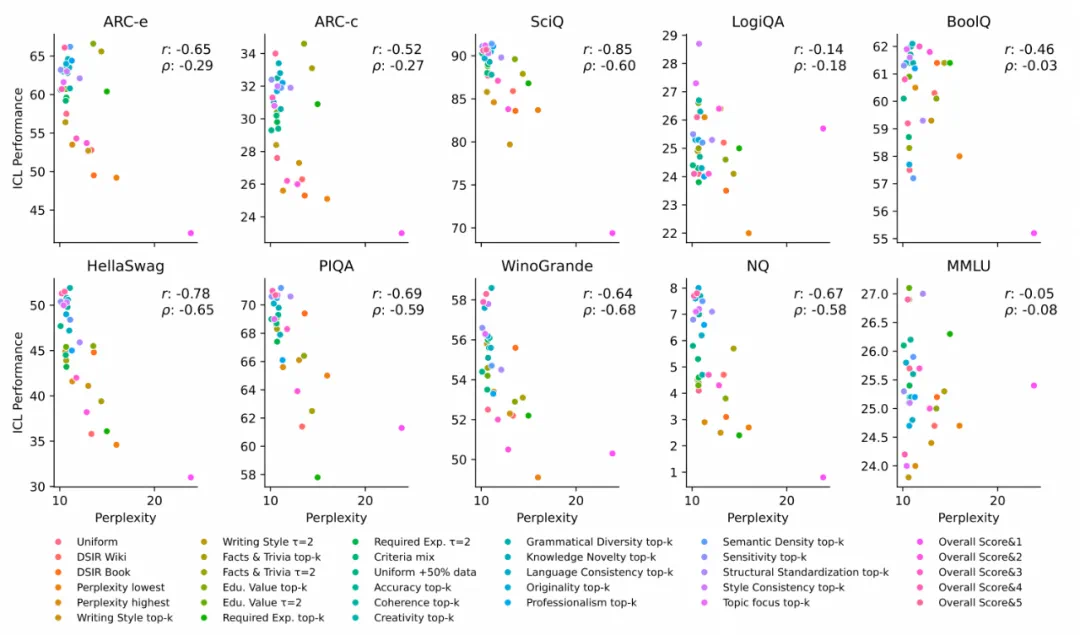

- PPL与ICL性能的错位分析: 研究分析了困惑度(PPL)与上下文学习(ICL)性能之间的关系,发现域不匹配和ICL任务复杂性是造成错位的主要原因。

论文信息:

- 论文标题:DataMan: Data Manager for Pre-training Large Language Models

- 作者单位:浙江大学 & 阿里巴巴

- 论文链接:https://arxiv.org/abs/2502.19363 (链接可能需要更新为实际链接)

DataMan为大语言模型的预训练数据选择提供了一种新的思路和方法,其在提升模型性能和效率方面具有显著的潜力。

好了,本文到此结束,带大家了解了《ICLR2025炸裂!浙大千问DataMan:53页预训练数据管理神器深度解析》,希望本文对你有所帮助!关注golang学习网公众号,给大家分享更多科技周边知识!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

300 收藏

-

461 收藏

-

187 收藏

-

160 收藏

-

339 收藏

-

212 收藏

-

157 收藏

-

308 收藏

-

416 收藏

-

373 收藏

-

392 收藏

-

464 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习