昇腾AI云服务上线,算力格局迎来新变局

时间:2025-08-17 13:57:56 286浏览 收藏

一分耕耘,一分收获!既然都打开这篇《新一代昇腾AI云服务,云上算力格局生变》,就坚持看下去,学下去吧!本文主要会给大家讲到等等知识点,如果大家对本文有好的建议或者看到有不足之处,非常欢迎大家积极提出!在后续文章我会继续更新科技周边相关的内容,希望对大家都有所帮助!

在中国,一个AI大模型要完成从训练到推理的全过程,几乎如同经历一场算力的“九九八十一难”。

首先,它必须面对英伟达高端算力芯片被禁售、被降级的现实困境,导致算力获取成本高昂且渠道受限;紧接着,模型参数日益庞大,单张计算卡已无法承载,必须依赖大规模集群算力;而大规模AI集群又常面临故障频发、恢复缓慢的问题,严重拖慢训练进度;到了推理阶段,还需突破分布式推理的技术瓶颈,才能在应用层面建立竞争优势。

这些大模型宛如棋盘上的棋子,算法走得飞快,脚下的算力棋盘却始终依赖他人。即便如此,中国依然诞生了众多令人瞩目的大模型创新成果。但人们不禁思考:如果拥有一个自主可控、稳定强劲的AI算力底座,中国的AI技术又能走得多远?

在HDC 2025大会上,答案浮现。华为常务董事、华为云计算CEO张平安宣布:基于CloudMatrix384超节点的新一代昇腾AI云服务正式全面上线,为大模型提供澎湃动力。

这项服务的本质,是对传统AI算力形态的一次重构。它打破了以单卡为核心的算力供给模式,直面中国AI算力自主化的迫切需求,并通过云服务这一最适配大模型推训的方式,实现了算力的高效交付。

384个AI计算单元紧密互联,宛如一片“龙鳞”。从这片鳞甲的光泽中,我们看到的是中国AI算力以技术重塑规则的决心与能力。

让我们沿着“发现问题—技术破局—云服务闭环—行业落地”的逻辑脉络,看看AI算力的重重难关,是如何被一一化解的。

自深度学习兴起以来,AI算力作为专项资源被广泛认知,学界与产业界早已预见到中国将在AI算力供需之间面临巨大矛盾。这一矛盾在大模型时代达到了前所未有的高峰。

一方面,中国在算法与应用场景上的创新层出不穷,AI正深度融入社会经济;另一方面,本土AI算力基础设施长期缺失,严重依赖外部供应。这种依赖逐渐演变为发展的结构性短板——就像把自己的棋子放在别人的棋盘上,一旦对方撤盘,我们便无从落子;当棋子越来越多,原有的棋盘也早已不堪承载。

从历史、当下与未来三个维度审视,中国AI算力必须走出一条自主发展的新路径。

- 历史困局:外部封锁下的算力受限

自1996年《瓦森纳协定》签署以来,美国长期主导对华高科技出口管制。进入AI时代,AI算力成为科技博弈的核心战场。近年来,美国不断加码对中国AI芯片的限制,曾占据中国市场95%以上份额的英伟达GPU,频繁遭遇禁售或被迫推出性能缩水的“特供版”。算力变得既昂贵又稀缺,成为制约中国AI发展的关键瓶颈。

- 现实挑战:大模型爆发带来的算力饥渴

聚焦国内市场,算力供需矛盾愈发尖锐。以DeepSeek为代表的国产大模型崛起,以及AI Agent等新型应用的爆发,都对训练与推理能力提出了更高要求。

例如,AI Agent的核心逻辑是“大模型决策+调用工具执行”,这对响应时延极为敏感。要实现大规模商用,必须具备强大的CPU与NPU间高速通信能力。这些底层算力的实现,直接决定了AI应用的成败。

- 未来焦虑:为AGI时代提前布局

更深远的是,大模型仍在快速进化。未来可能出现参数量达百万亿级别的模型,算力需求或将呈百万倍增长。同时,自动驾驶、元宇宙等新兴领域推动多元融合计算成为主流。我们必须提前构建强大的算力底座,才能支撑起未来无限的AI想象。

要破解这些困局,关键在于:不能再依赖外部供应的单卡算力。唯有将算力资源系统化、集群化整合,用整体优势弥补个体短板,才是中国AI算力的破局之道。

尽管技术难度极高,但我们也早已做好准备。华为在网络领域的深厚积累,可突破大规模集群通信瓶颈;昇腾芯片的持续迭代,为自主算力提供支撑;华为云在大规模算力服务与下一代云基础设施上的经验,为超节点的构建奠定了坚实基础。

这些能力的融合,使华为得以打破传统冯诺依曼架构,打造出“一切可池化”“一切皆对等”“一切可组合”的CloudMatrix384超节点,并通过云服务将其推向千行百业。

AI算力的多重困境,由此迎来了底层规则的重构可能。

要突破单卡算力的局限,就必须走向多卡集群化发展。

集约化计算提升资源利用率,构建更适应大规模训练的超节点,这一思路早有共识。但CloudMatrix384的独特之处在于,它通过计算、存储、网络等多维度协同创新,彻底颠覆传统架构,打造出真正的“最强AI服务器”。

CloudMatrix384将384颗昇腾NPU与192颗鲲鹏CPU通过高速互联总线连接,构成一台384卡的超级AI计算机。中国文化崇尚“合”的智慧,这种理念在CloudMatrix384中得以充分体现。通过集约化设计,它突破了硬件与工艺的限制,结合软硬协同、资源池化与动态调度,显著提升有效算力。数据显示,其算力规模可达300PFlops,相较英伟达NVL72提升67%。它的出现,从底层解决了多个紧迫的算力难题:

- 如何满足分布式推理需求?

DeepSeek爆火后,MoE(混合专家)模型成为主流。这类模型对分布式推理能力要求极高。CloudMatrix384通过超节点分布式推理引擎,大幅提升单卡计算与通信效率,单卡吞吐量可达2300Tokens/s,较非超节点提升近4倍,支持“一卡一任务”,算力利用率(MFU)提升50%以上。更可实现“一卡一专家”,单个超节点支持384个专家并行推理,极大提升效率。

- 如何突破集群规模瓶颈?

随着模型规模扩大,业界正从万卡集群向五万、十万卡演进。满足算力规模需求,是超节点的首要任务。

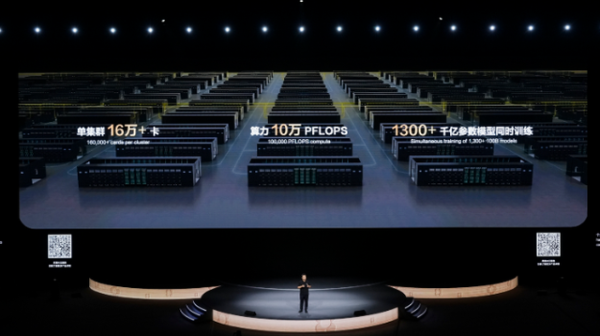

为此,CloudMatrix384采用MatrixLink全对等互联技术,构建高速智能网络,配合集群智能调度,确保性能无损,万卡集群线性度超95%。最高可级联432个超节点,形成16万卡规模的AI集群,提供10万PFlops算力,足以支撑万亿参数模型训练,彻底打破大规模计算的边界。

- 如何实现算力资源最优配置?

对开发者和企业用户而言,算力不仅稀缺,还常伴随浪费、低效与运维复杂等问题。为最大化每比特算力价值,CloudMatrix384支持按逻辑超节点灵活划分资源,像搭积木一样分配算力,实现“一切可组合”,让资源投入发挥最大效益。

此外,超节点支持40天长稳训练、10分钟快速恢复,彻底扫清大模型训练中的卡点与堵点。

正如张平安所言:“CloudMatrix384标志着算力竞争从单点突破迈向系统架构创新。通过技术与资源的深度融合,匹配全面智能时代的企业需求,引领中国AI生态的整体跃迁。”

技术突破之后,关键在于将能力释放到产业中。而云服务,正是最佳载体。

CloudMatrix384的技术本质,是打破单点算力限制,实现弹性、可扩展的大规模算力供给,这与云计算的特性高度契合。企业上云,正是为了灵活

到这里,我们也就讲完了《昇腾AI云服务上线,算力格局迎来新变局》的内容了。个人认为,基础知识的学习和巩固,是为了更好的将其运用到项目中,欢迎关注golang学习网公众号,带你了解更多关于大模型,ai算力,自主可控,昇腾AI云服务,CloudMatrix384的知识点!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

126 收藏

-

254 收藏

-

290 收藏

-

489 收藏

-

423 收藏

-

147 收藏

-

410 收藏

-

427 收藏

-

169 收藏

-

211 收藏

-

413 收藏

-

226 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习