AI新风口?首个高质量「文生视频」模型Zeroscope引发开源大战:最低8G显存可跑

来源:51CTO.COM

时间:2023-07-15 17:40:16 308浏览 收藏

欢迎各位小伙伴来到golang学习网,相聚于此都是缘哈哈哈!今天我给大家带来《AI新风口?首个高质量「文生视频」模型Zeroscope引发开源大战:最低8G显存可跑》,这篇文章主要讲到等等知识,如果你对科技周边相关的知识非常感兴趣或者正在自学,都可以关注我,我会持续更新相关文章!当然,有什么建议也欢迎在评论留言提出!一起学习!

文生图模型Stable Diffusion开源后,将「AI艺术」彻底平民化,只需一张消费级显卡即可制作出非常精美的图片。

而文本转视频领域,目前质量较高的只有Runway前不久推出的商用Gen-2模型,开源界还没有一个能打的模型。

最近,Huggingface上有作者发布了一个文生视频模型Zeroscope_v2,基于17亿参数量的ModelScope-text-to-video-synthesis模型进行二次开发。

图片

图片

模型链接:https://huggingface.co/cerspense/zeroscope_v2_576w

相比于原版本,Zeroscope生成的视频没有水印,并且流畅度和分辨率都得到了提升,适配16:9的宽高比。

开发者cerspense表示,他的目标就是和Gen-2进行开源较量,即提高模型质量的同时,还能免费供大众使用。

Zeroscope_v2包括两个版本,其中Zeroscope_v2 567w可以快速生成576x320像素分辨率、帧率为30帧/秒的视频,可用于视频概念的快速验证,只需要约7.9GB的显存即可运行。

使用Zeroscope_v2 XL可以产生分辨率为1024x576的高清视频,预计需要大约15.3GB的显存。

Zeroscope还可以与音乐生成工具MusicGen一起使用,快速制作一个纯原创短视频。

Zeroscope模型的训练用到了9923个视频片段(clip)以及29769个标注帧,每个片段包括24帧。偏移噪声包括视频帧内对象的随机移动、帧定时的微小波动或微弱扭曲。

训练期间引入噪声可以增强模型对数据分布的理解,从而可以生成更多样化的逼真视频,并更有效地解释文本描述中的变化。

使用方法

使用stable diffusion webui

在Huggingface上下载zs2_XL目录下的权重文件,然后放到stable-diffusion-webui\models\ModelScope\t2v目录下即可。

在生成视频时,推荐的降噪强度值为0.66到0.85

使用Colab

笔记链接:https://colab.research.google.com/drive/1TsZmatSu1-1lNBeOqz3_9Zq5P2c0xTTq?usp=sharing

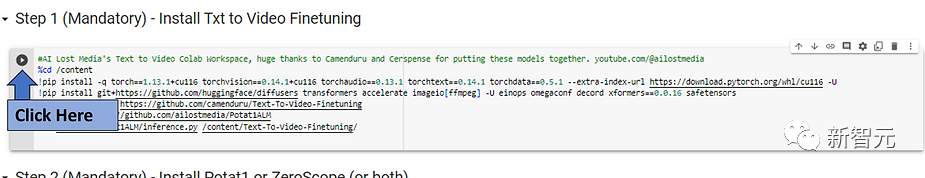

先点击Step 1下的运行按钮,等待安装,大约需要3分钟;

图片

图片

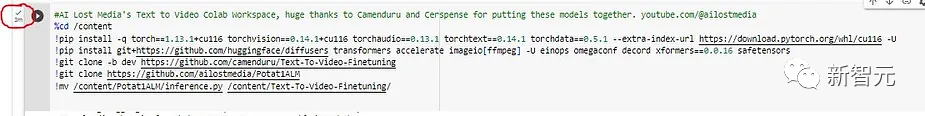

当按钮旁边出现绿色复选标记时,继续执行下一步。

图片

图片

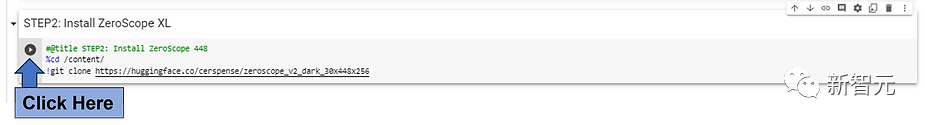

点击想要安装模型附近的运行按钮,为了能够在Colab中快速获得3秒左右的剪辑视频,更推荐使用低分辨率的ZeroScope模型(576或448)。

图片

图片

使用更高分辨率的模型(例如Potat 1或ZeroScope XL)来运行时,我们需要做出考虑,因为运行时间也会相应增加。

再次等待复选标记出现,继续执行下一步。

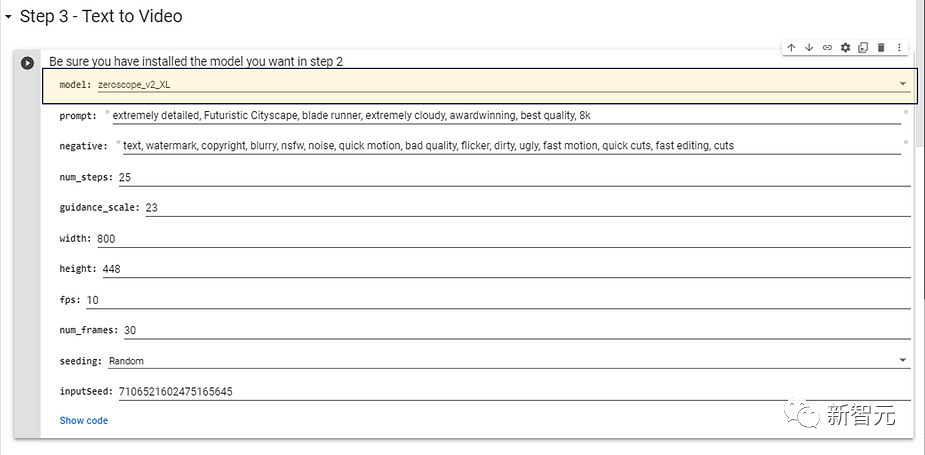

选择在Step2中安装并希望使用的模型型号,对于更高分辨率的模型,推荐下面的配置参数,不需要太长的生成时间。

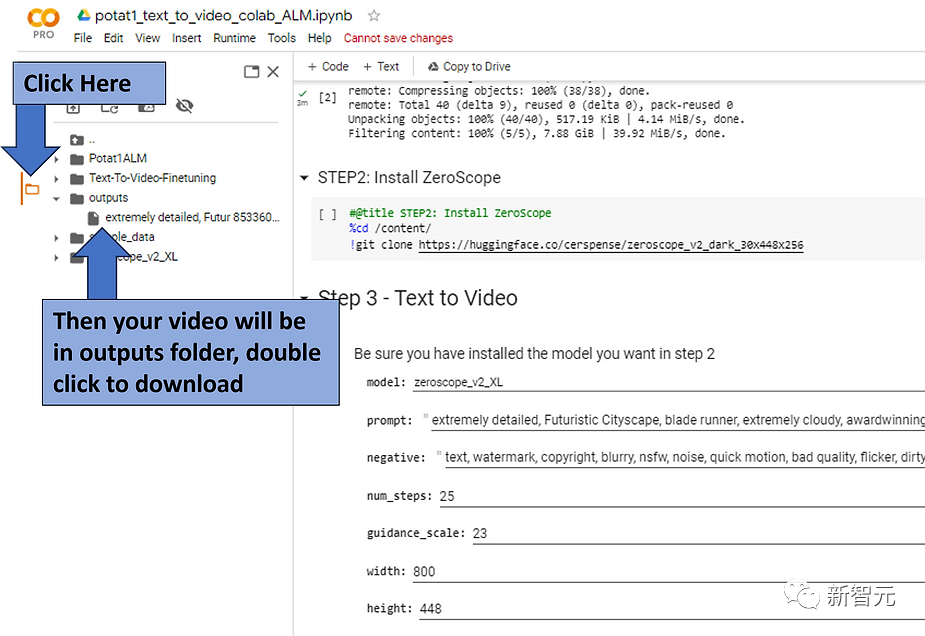

图片

图片

接着,你可以输入目标视频效果的提示词,也可以输入否定提示词,然后点击运行按钮。

等待一会后,生成的视频就会被放置在outputs目录下。

图片

图片

「文生视频」开源竞赛

目前来说,文生视频领域仍处于起步阶段,即便是最好的工具也只能生成几秒钟的视频,并且通常存在较大的视觉缺陷。

但其实文生图模型最初也面临着类似的问题,但仅仅几个月后就实现了照片级真实感。

不过与文生图模型不同的是,视频领域在训练和生成期间所需要的资源都要更比图像更多。

虽然谷歌已经研发出了Phenaki和Imagen Video模型,可以生成高分辨率、更长、逻辑连贯的视频片段,但公众无法使用到这两个模型;Meta的Make-a-Video模型也同样没有发布。

目前可用的工具仍然只有Runway的商用模型Gen-2,此次Zeroscope的发布也标志着文生视频领域第一个高质量开源模型的出现。

今天关于《AI新风口?首个高质量「文生视频」模型Zeroscope引发开源大战:最低8G显存可跑》的内容介绍就到此结束,如果有什么疑问或者建议,可以在golang学习网公众号下多多回复交流;文中若有不正之处,也希望回复留言以告知!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

472 收藏

-

477 收藏

-

274 收藏

-

474 收藏

-

341 收藏

-

308 收藏

-

489 收藏

-

157 收藏

-

326 收藏

-

186 收藏

-

304 收藏

-

391 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习