简单实例:使用强化学习在Gym Anytrading中进行交易

来源:51CTO.COM

时间:2023-08-05 15:01:12 205浏览 收藏

小伙伴们有没有觉得学习科技周边很有意思?有意思就对了!今天就给大家带来《简单实例:使用强化学习在Gym Anytrading中进行交易》,以下内容将会涉及到,若是在学习中对其中部分知识点有疑问,或许看了本文就能帮到你!

近年来,算法交易领域对强化学习(RL)表现出了极大的兴趣。强化学习算法通过从经验中学习,并根据奖励来优化行动,非常适合用于交易机器人。在本文中,我们将简要介绍如何利用Gym Anytrading环境和GME(GameStop Corp.)交易数据集构建一个基于强化学习的交易机器人

强化学习是机器学习的一个分支,其核心是代理与环境之间的交互,以达到特定的目标。代理在环境中采取行动,并通过接收奖励的反馈来学习,以最大化累积奖励。代理的目标是找到一种最优策略,将状态映射到行动,以获得最佳的结果

Gym Anytrading

Gym Anytrading是一个基于OpenAI Gym的开源库,用于创建金融交易环境。它允许模拟不同的交易场景,并使用强化学习算法测试各种交易策略

安装依赖

要安装所需的依赖项,请运行以下代码,其中包括TensorFlow、stable-baselines3和Gym Anytrading这些主要库

!pip install tensorflow !pip install stable_baselines3 !pip install gym !pip install gym-anytrading !pip install tensorflow-gpu

导入库

导入必要的库和设置环境开始:

# Gym stuff import gym import gym_anytrading # Stable baselines - RL stuff from stable_baselines3.common.vec_env import DummyVecEnv from stable_baselines3 import A2C # Processing libraries import numpy as np import pandas as pd from matplotlib import pyplot as plt

加载GME交易数据

将使用GameStop Corp. (GME)的历史交易数据作为示例。我们假设您拥有CSV格式的GME交易数据,没有的话可以通过搜索引擎找到下载地址。

准备Gym Anytrading环境,以便加载GME交易数据

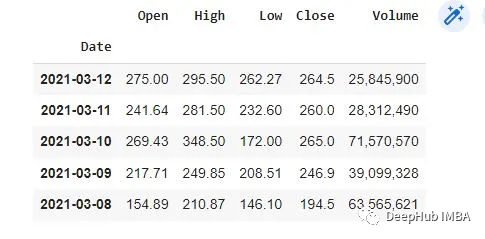

# Load GME trading data df = pd.read_csv('gmedata.csv') # Convert data to datetime type df['Date'] = pd.to_datetime(df['Date']) df.dtypes # Set Date as the index df.set_index('Date', inplace=True) df.head()

通过Gym创建交易环境

我们将使用Gym Anytrading创建一个交易环境,该环境将模拟GME交易数据,并让我们的代理通过购买、出售和持有股票等行为与环境互动

# Create the environment env = gym.make('stocks-v0', df=df, frame_bound=(5, 100), window_size=5) # View environment features env.signal_features # View environment prices env.prices探索环境

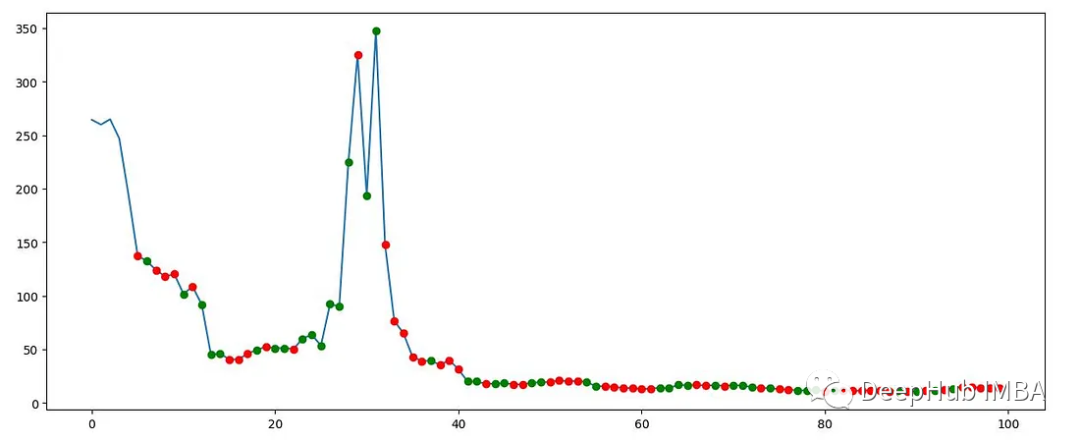

在继续构建RL模型之前,可以先对环境可视化了解其特征。

# Explore the environment env.action_space state = env.reset() while True:action = env.action_space.sample()n_state, reward, done, info = env.step(action)if done:print("info", info)break plt.figure(figsize=(15, 6)) plt.cla() env.render_all() plt.show()该图显示了GME交易数据的一部分,以及Gym Anytrading环境生成的买入和卖出信号。

构建强化学习模型

我们将采用stable-baselines3库来实现RL模型,并使用A2C(Advantage Actor-Critic)算法

# Creating our dummy vectorizing environment env_maker = lambda: gym.make('stocks-v0', df=df, frame_bound=(5, 100), window_size=5) env = DummyVecEnv([env_maker]) # Initializing and training the A2C model model = A2C('MlpPolicy', env, verbose=1) model.learn(total_timesteps=1000000)评估模型

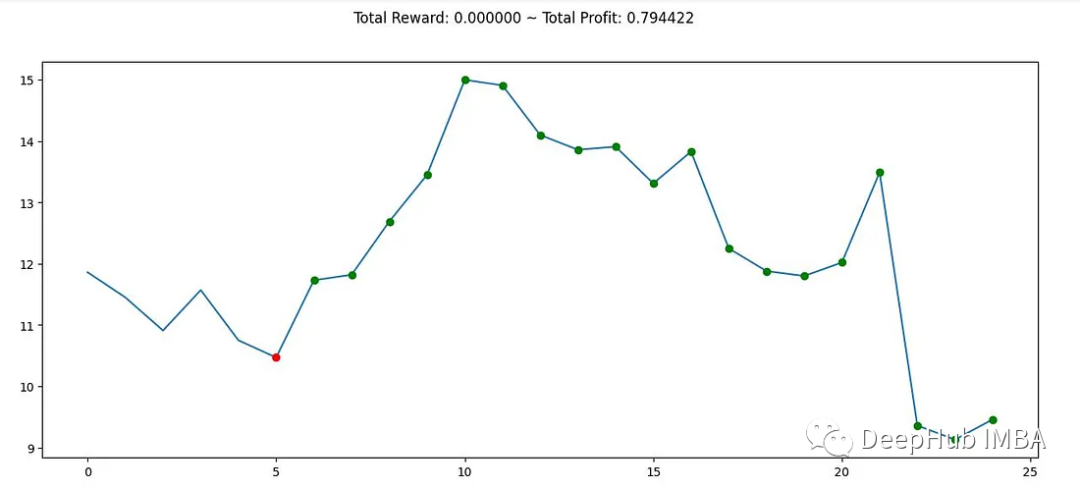

在训练模型之后,可以评估它在GME交易数据的不同部分上的表现。

# Create a new environment for evaluation env = gym.make('stocks-v0', df=df, frame_bound=(90, 110), window_size=5) obs = env.reset() while True:obs = obs[np.newaxis, ...]action, _states = model.predict(obs)obs, rewards, done, info = env.step(action)if done:print("info", info)break plt.figure(figsize=(15, 6)) plt.cla() env.render_all() plt.show()

总结

本文提供了使用Gym Anytrading环境和stable-baselines3库构建强化学习交易机器人的指南,但要构建一个成功的交易机器人,需要综合考虑各种因素并进行持续改进

今天关于《简单实例:使用强化学习在Gym Anytrading中进行交易》的内容就介绍到这里了,是不是学起来一目了然!想要了解更多关于机器学习,强化学习的内容请关注golang学习网公众号!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

256 收藏

-

460 收藏

-

137 收藏

-

319 收藏

-

180 收藏

-

457 收藏

-

390 收藏

-

306 收藏

-

240 收藏

-

347 收藏

-

231 收藏

-

331 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习