书生・浦语 20B 开源 AI 大模型发布,消费级 GPU 单卡即可运行

来源:搜狐

时间:2023-09-21 17:47:13 484浏览 收藏

积累知识,胜过积蓄金银!毕竟在科技周边开发的过程中,会遇到各种各样的问题,往往都是一些细节知识点还没有掌握好而导致的,因此基础知识点的积累是很重要的。下面本文《书生・浦语 20B 开源 AI 大模型发布,消费级 GPU 单卡即可运行》,就带大家讲解一下知识点,若是你对本文感兴趣,或者是想搞懂其中某个知识点,就请你继续往下看吧~

IT之家 9 月 21 日消息,今年 6 月,上海 AI 实验室发布了“书生・浦语”(InternLM)大模型,为 104B 参数,后续又推出了 7B 和 13B 规格模型。

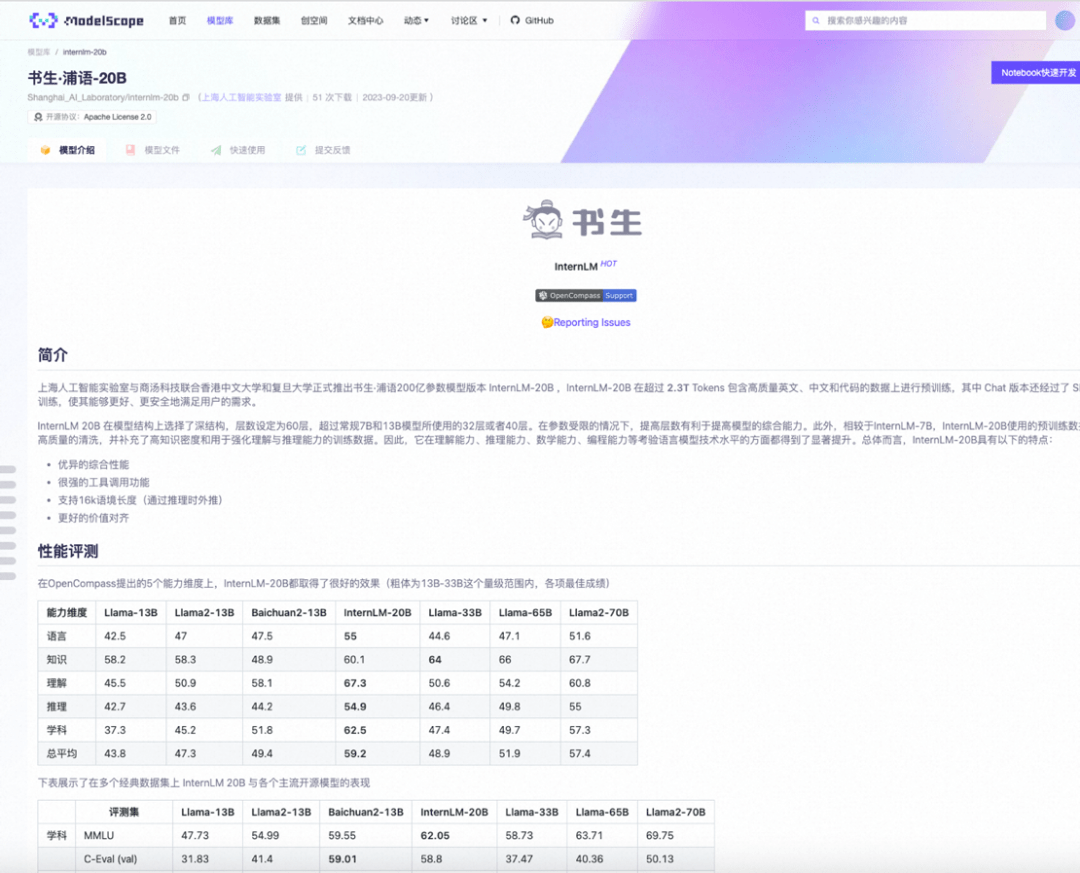

近日,上海 AI 实验室、商汤科技、香港中文大学、复旦大学宣布推出书生・浦语 20B 版本,这是一款中量级大模型,号称基于 2.3T Tokens 预训练语料从头训练,相较于 InternLM-7B,其理解能力、推理能力、数学能力、编程能力等都有显著提升。

根据介绍,与之前国内陆续开源的7B和13B规格模型相比,20B量级模型具备更强大的综合能力,特别是在复杂推理和反思能力方面表现突出,能够为实际应用场景提供更强大的性能支持;同时,20B量级模型可以在单卡上进行推理,在经过低比特量化后,可以在单块消费级GPU上运行,因此在实际应用中更加便捷

相较于之前的开源模型,InternLM-20B 具有几个显著的亮点,以下是IT之家的总结:

- 以不足 1/3 的参数量,测评成绩达到了 Llama2-70B 的水平。

- 支持数十类插件,上万个 API 功能,还具备代码解释和反思修正能力。

- 实现了对长文理解、长文生成和超长对话的有效支持,同时支持 16K 语境长度。

- 研究团队进行了基于 SFT 和 RLHF 两阶段价值对齐,并通过专家红队的对抗训练大幅提高其安全性。

此外,书生・浦语开源工具链已经进行全新升级,形成了更完善的体系。这个体系包括了预训练框架InternLM-Train、低成本微调框架XTuner、部署推理框架LMDeploy、评测框架OpenCompass,以及面向场景应用的智能体框架Lagent

书生・浦语-20B:

书生:你好,浦语。最近过得怎么样? 浦语:你好,书生。我最近过得还不错。工作忙碌,但是很充实。 书生:听说你最近去了一趟旅行,是吗? 浦语:是的,我去了一趟日本。那里的风景非常美丽,我玩得很开心。 书生:听起来很不错。你去了哪些地方? 浦语:我去了东京和京都。东京的繁华和现代感让我印象深刻,而京都的古老建筑和文化底蕴也让我流连忘返。 书生:那你有没有尝试当地的美食? 浦语:当然!我品尝了寿司、拉面和日式烤肉等传统美食,味道真的很棒。 书生:听说你还参观了一些著名的寺庙和神社? 浦语:是的,我去了清水寺和浅草寺。这些古老的寺庙让我感受到了日本的宗教和历史氛围。 书生:听起来你的旅行非常精彩。下次我也想去日本看看。 浦语:你一定会喜欢的。日本有很多值得探索的地方和独特的文化。 书生:谢谢你的分享,浦语。希望你以后还能有更多美好的旅行经历。 浦语:谢谢你,书生。希望你也能有机会去探索世界的美好

本篇关于《书生・浦语 20B 开源 AI 大模型发布,消费级 GPU 单卡即可运行》的介绍就到此结束啦,但是学无止境,想要了解学习更多关于科技周边的相关知识,请关注golang学习网公众号!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

444 收藏

-

264 收藏

-

443 收藏

-

128 收藏

-

242 收藏

-

438 收藏

-

124 收藏

-

184 收藏

-

197 收藏

-

199 收藏

-

173 收藏

-

195 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习