1%参数,超越ControlNet,全新AI绘画控制大师震撼登场

来源:51CTO.COM

时间:2023-09-24 09:23:56 181浏览 收藏

从现在开始,努力学习吧!本文《1%参数,超越ControlNet,全新AI绘画控制大师震撼登场》主要讲解了等等相关知识点,我会在golang学习网中持续更新相关的系列文章,欢迎大家关注并积极留言建议。下面就先一起来看一下本篇正文内容吧,希望能帮到你!

“新·AI绘画细节控制大师”ControlNet-XS来啦!

敲重点的是参数只要原始ControlNet的1%。

就能做到蛋糕口味随意切换:

△左图为改前

改变一个人的着装风格也可以很容易:

图中展示的是同款商品,它的外形保持不变,充满了艺术氛围的感觉

无论是春天的绚丽花海,夏天的碧海蓝天,秋天的金黄枫叶还是冬天的银装素裹,自然风光都能令人心驰神往。四季更迭,每个季节都有独特的魅力,让人流连忘返

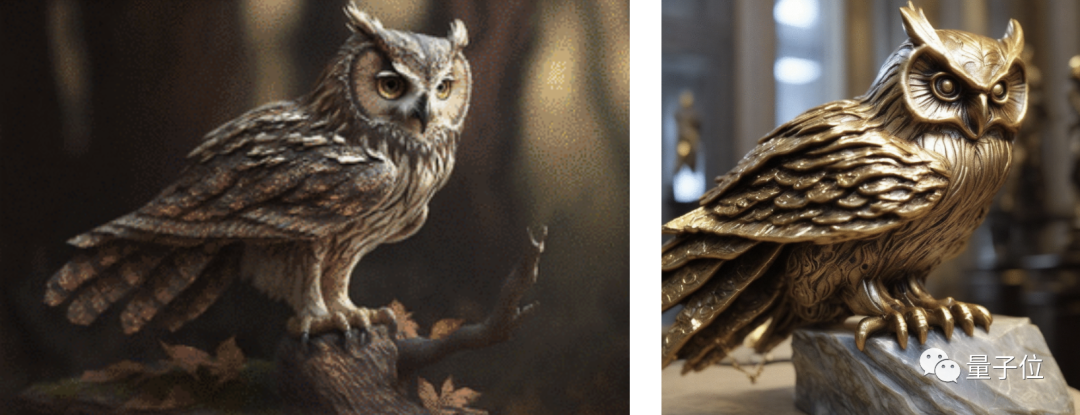

还有这只猫头鹰,它直接从活物变成了雕塑:

在参数很小的情况下,能够达到这样的效果,网友们纷纷赞叹不已,并迫不及待地想要阅读论文

ControlNet-XS由海德堡大学计算机视觉实验室研发,目前相关论文、预训练模型还未公布。

但研究人员表示ControlNet-XSFID分数明显优于ControlNet。

且控制Stable Diffusion-XL和Stable Diffusion 2.1的代码将在不久后开源。

新生代控制大师

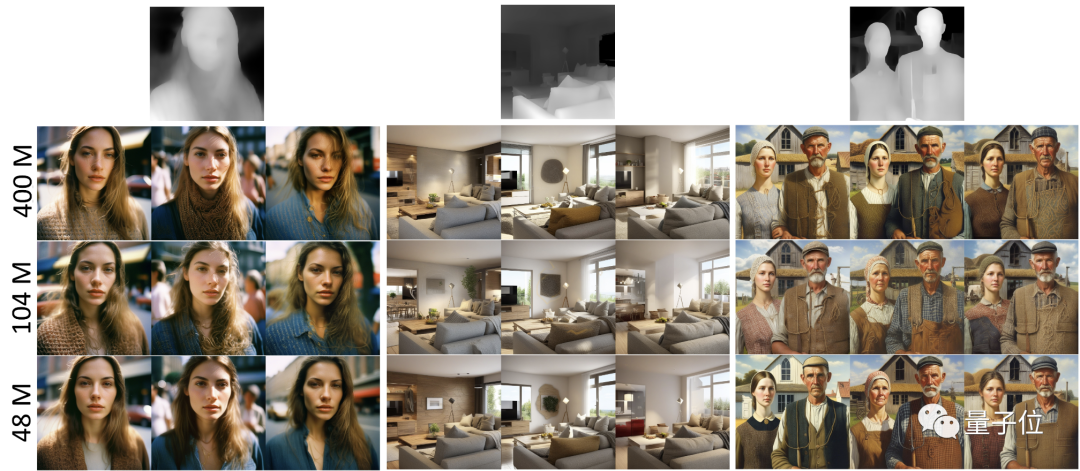

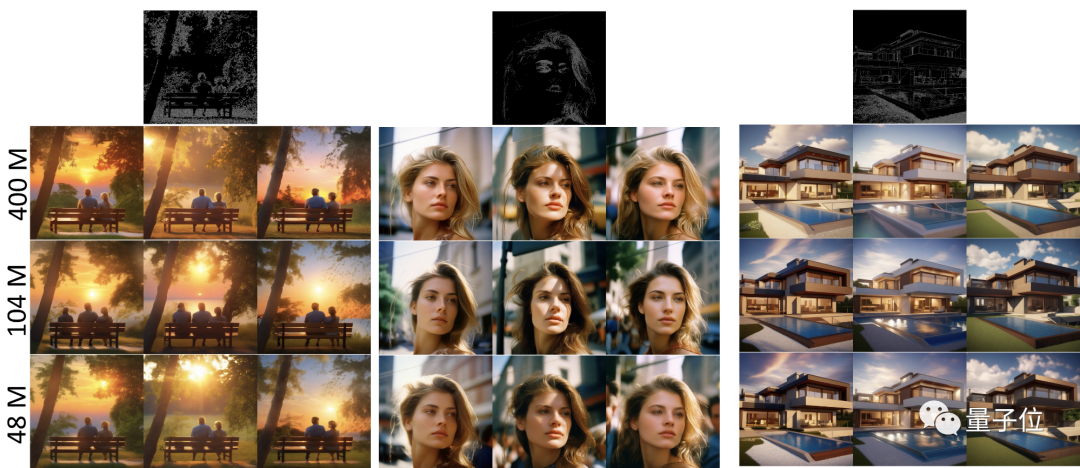

让我们先来看一下对于StableDiffusion-XL的控制

研究人员在评估了不同大小的控制模型后发现,控制模型甚至不必和2.6B参数的StableDiffusion-XL基础网络大小一样。

400M、104M和48M参数的ControlNet-XS控制也很明显。

深度图给出了更为直观的展示,根据图像内容的距离、深度,深度图呈现出准确的颜色深浅度:

要注意的是,这里研究人员设置的每行seed值不同,每列seed值相同。

此外,还有Canny边缘检测图,物体的边界、轮廓都能清晰地展现出来:

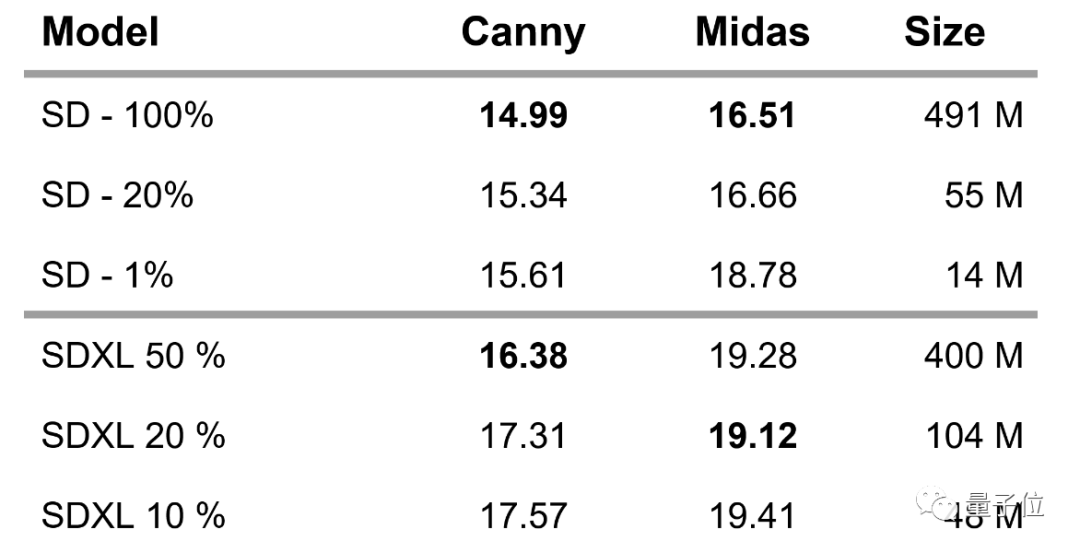

对于StableDiffusion的控制,研究人员评估了三个版本的ControlNet-XS,分别为491M、55M和14M参数

研究结果显示,仅有1.6%的参数(865M)就能够可靠地控制生成过程

那么,如何实现这一点呢?

从头开始训练

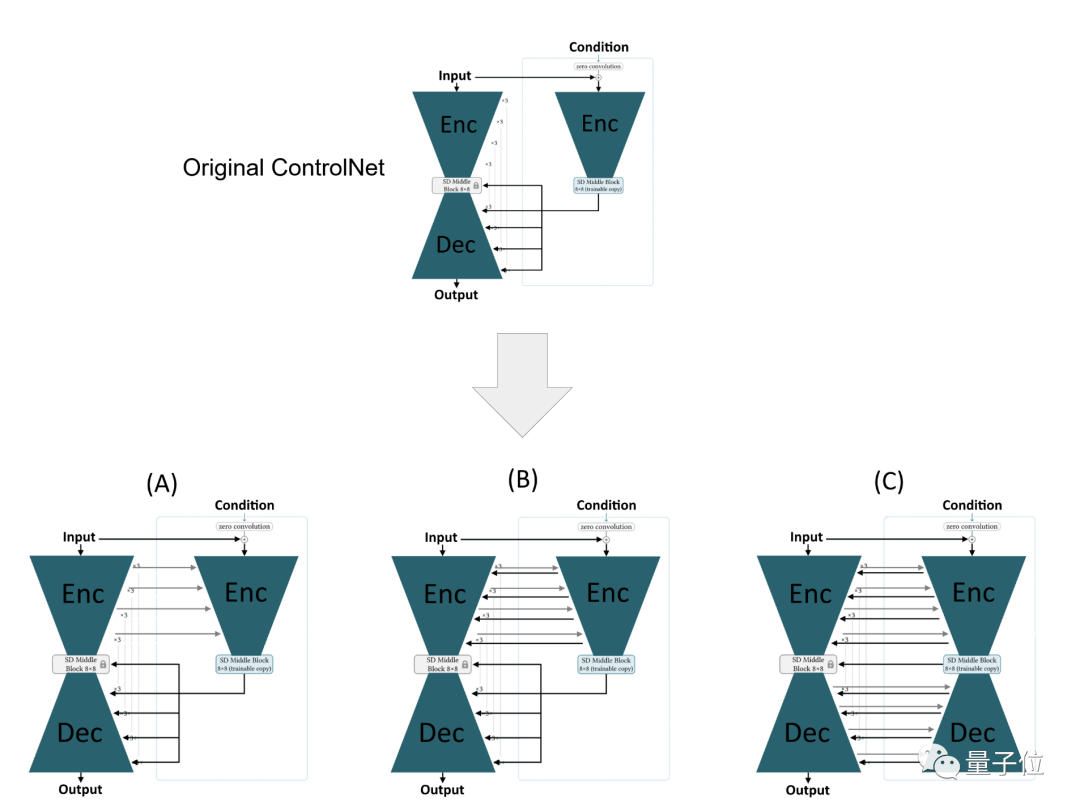

原始ControlNet是StableDiffusion基础模型(base model)中U-Net编码器的副本,所以接收与基础模型相同的输入,并带有额外的引导信号,比如说边缘图。

然后,经过训练的ControlNet的中间输出被添加到基础模型的解码器层的输入中。在ControlNet的整个训练过程中,基础模型的权重保持冻结状态。

ControlNet-XS的研究者们认为这种方法存在问题,ControlNet不必这么庞大。

首先,Stable Diffusion最终输出的图像是通过一系列迭代生成的。在这个过程中,每个步骤都会在U-Net网络结构的编码器和解码器两部分中执行

在每次迭代中,基础模型和控制模型的输入都是由前一步骤生成的图像。此外,控制模型还会接收一个控制图像作为输入

在编码器阶段,这两个模型独立运行,而控制模型的反馈只在基础模型的解码阶段输入

总之,结果就是一个延迟的校正/控制机制。

也就是说ControlNet必须执行两项任务:一边校正/控制,一边还要提前预测基本模型的编码器将犯哪些“错误”。

通过暗示图像生成和控制需要相似的模型容量,可以自然而然地使用基础模型的权重初始化ControlNet的权重,然后进行微调

而对于ControlNet-XS,研究人员表示从设计上就与基础模型不同,是从零开始训练ControlNet-XS权重,解决了延迟反馈的问题。

如上图所示,方法是从基础模型的编码器添加连接到控制编码器(A),这样校正过程可以更快地适应基础模型的生成过程。但这并不能完全消除延迟,因为基础模型的编码器仍然没有受到引导。

因此,研究人员从ControlNet-XS添加额外的连接到基础模型编码器,直接影响整个生成过程(B)。

此外,他们还评估了在ControlNet设置中使用镜像解码架构是否有用(C)

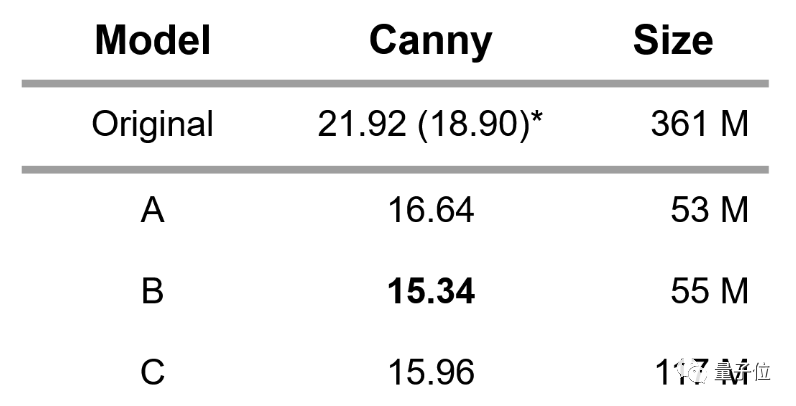

最终,研究人员在COCO2017验证集上,针对Canny边缘引导的三种不同变体(A、B、C)与原始的ControlNet进行了FID分数性能评估。

所有变体的结果都有显著提升,同时只使用了原始ControlNet参数的一小部分

研究人员又拿出了变体B,分别使用Canny边缘图和深度图引导,针对StableDiffusion2.1和StableDiffusion-XL分别训练了三种不同大小的模型。

相关的论文、代码和预训练模型将会很快公布出来,敬请期待下一步的进展!

项目地址:https://vislearn.github.io/ControlNet-XS/ 可以在此链接中找到项目的详细信息

今天带大家了解了的相关知识,希望对你有所帮助;关于科技周边的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

368 收藏

-

375 收藏

-

233 收藏

-

120 收藏

-

180 收藏

-

186 收藏

-

284 收藏

-

476 收藏

-

257 收藏

-

230 收藏

-

394 收藏

-

211 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习