让大型AI模型自主提问:GPT-4打破与人类对话的障碍,展现更高水平的表现

来源:51CTO.COM

时间:2023-11-13 11:12:55 160浏览 收藏

亲爱的编程学习爱好者,如果你点开了这篇文章,说明你对《让大型AI模型自主提问:GPT-4打破与人类对话的障碍,展现更高水平的表现》很感兴趣。本篇文章就来给大家详细解析一下,主要介绍一下,希望所有认真读完的童鞋们,都有实质性的提高。

在最新的人工智能领域动态中,人工生成的提示(prompt)质量对大语言模型(LLM)的响应精度有着决定性影响。OpenAI 提出的建议指出,精确、详细且具体的问题对于这些大语言模型的表现至关重要。然而,普通用户是否能够确保他们的问题对于 LLM 来说足够清晰明了?

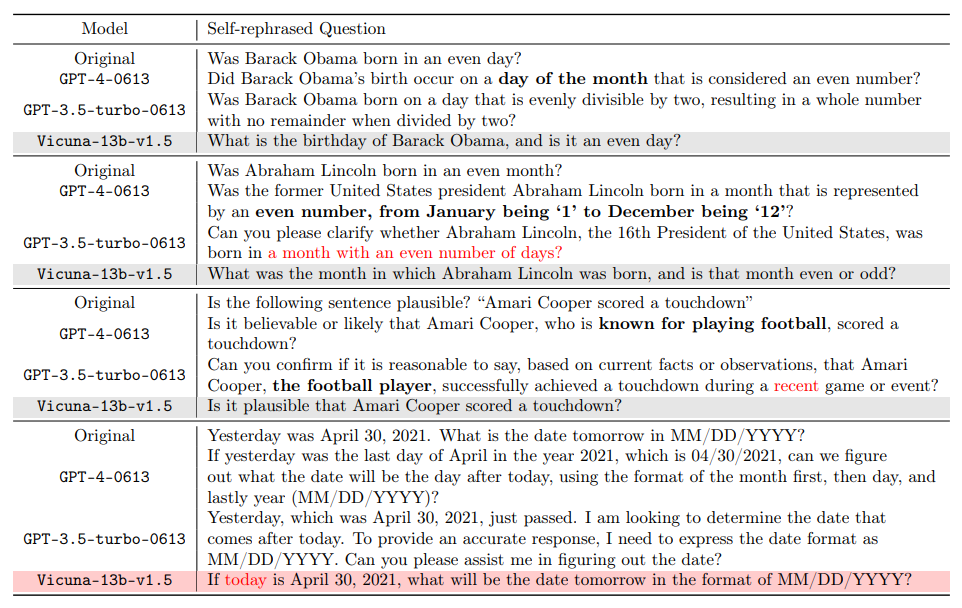

需要重新写的内容是:值得注意的是,人类在某些情境下的自然理解能力与机器的解读存在明显差异。例如,“偶数月” 这一概念,在人类看来很明显指的是二月、四月等月份,而GPT-4却可能将其误解为天数为偶数的月份。这不仅揭示了人工智能在理解日常语境上的局限性,也促使我们反思如何更有效地与这些大型语言模型进行交流。随着人工智能技术的不断进步,如何弥合人类与机器在语言理解方面的鸿沟,是一个未来研究的重要课题

关于此事,加利福尼亚大学洛杉矶分校(UCLA)的顾全全教授领导的通用人工智能实验室发布了一份研究报告,提出了一种创新的解决方案,针对大语言模型(如 GPT-4)在问题理解上的歧义问题。这项研究是由邓依荷、张蔚桐和陈子翔博士生完成的

- 论文地址:https://arxiv.org/pdf/2311.04205.pdf

- 项目地址: https://uclaml.github.io/Rephrase-and-Respond

重写后的中文内容为:该方案的核心是让大型语言模型对提出的问题进行复述和扩写,以提高回答的准确性。研究发现,经过GPT-4重新表述的问题变得更加详细,问题格式也更清晰。这种复述和扩写的方法显著提高了模型的回答准确率。实验表明,一个经过良好复述的问题使得回答的准确率从原来的50%提高到接近100%。这一性能提升不仅展示了大型语言模型自我改进的潜力,也为人工智能如何更有效地处理和理解人类语言提供了新的视角

方法

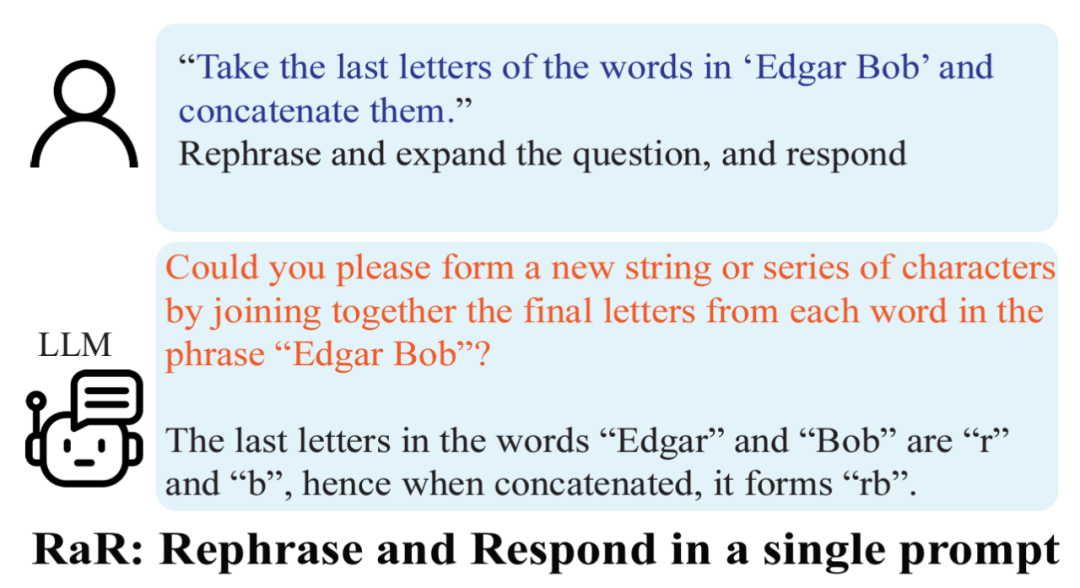

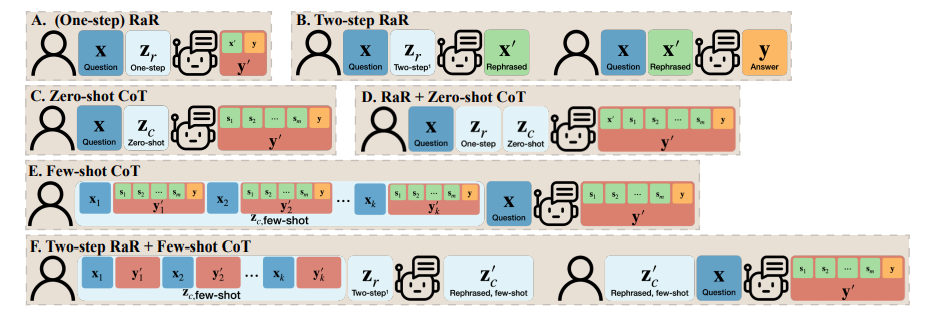

基于以上的发现,研究者提出了一个简单但效果显著的提示词 (prompt):“Rephrase and expand the question, and respond”(简称为 RaR)。这一提示词直接提高了 LLM 回答问题的质量,展示了在问题处理上的一个重要提升。

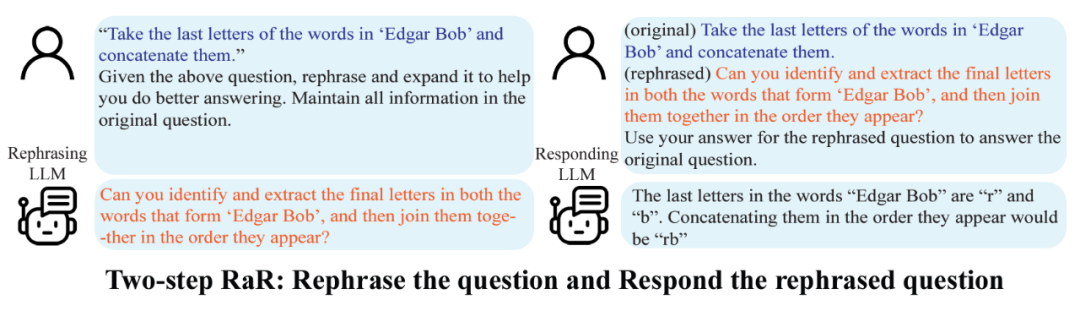

研究团队还提出了 RaR 的一种变体,称为 “Two-step RaR”,以充分利用像 GPT-4 这样的大模型复述问题的能力。这种方法遵循两个步骤:首先,针对给定的问题,使用一个专门的 Rephrasing LLM 生成一个复述问题;其次,将原始问题和复述后的问题结合起来,用于提示一个 Responding LLM 进行回答。

结果

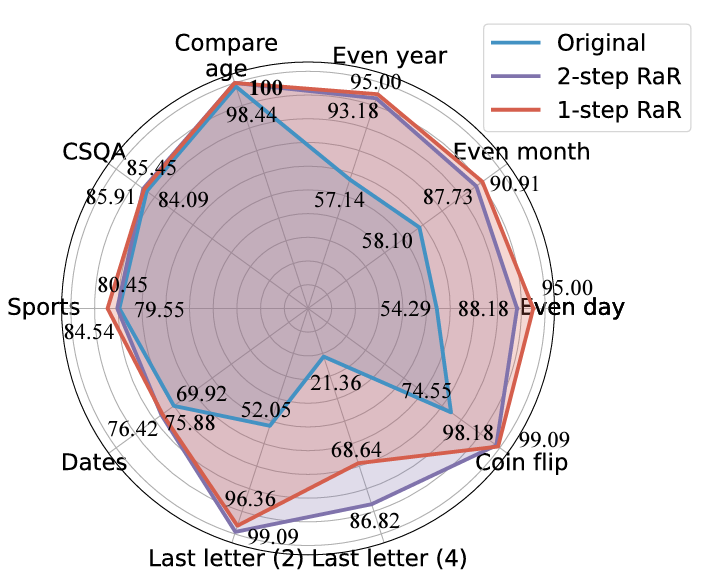

研究人员进行了不同任务的实验,结果表明,无论是单步 RaR 还是两步 RaR,都能有效地提高 GPT4 的回答准确率。值得注意的是,RaR 在原本对 GPT-4 极具挑战性的任务上展现出了显著的改进效果,甚至在某些情况下准确率接近 100%。研究团队总结了以下两点关键结论:

1. 复述并扩写(RaR)提供了一种即插即用的黑箱式提示方法,能够有效地提高 LLM 在各种任务上的性能。

2. 在评估 LLM 在问答(QA)任务上的表现时,检查问题的质量至关重要。

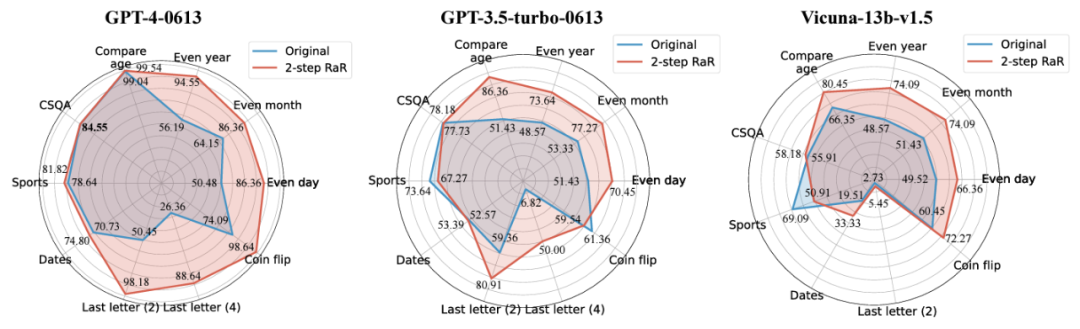

研究人员采用了Two-step RaR方法进行研究,以探究GPT-4、GPT-3.5和Vicuna-13b-v.15等不同模型的表现。实验结果表明,对于那些具备更复杂架构和更强大处理能力的模型,例如GPT-4,RaR方法可以显著提升其处理问题的准确性和效率。而对于较为简单的模型,例如Vicuna,尽管改进幅度较小,但仍然表明了RaR策略的有效性。基于此,研究人员进一步检查了不同模型复述后问题的质量。对于较小模型的复述问题,有时可能会扰乱问题的意图。而像GPT-4这样的高级模型提供的复述问题与人类的意图相符,并且可以增强其他模型的回答效果

这一发现揭示了一个重要的现象:不同等级的语言模型复述的问题在质量和效果上存在差异。特别是像 GPT-4 这样的高级模型,它复述的问题不仅能够为自身提供更清晰的问题理解,还能够作为一种有效的输入,提高其他较小模型的性能。

与思维链(CoT)的区别

为了理解 RaR 与思维链(CoT)之间的区别,研究人员提出了它们的数学表述,并阐明了 RaR 在数学上与 CoT 的不同之处,以及它们如何可以轻松结合。

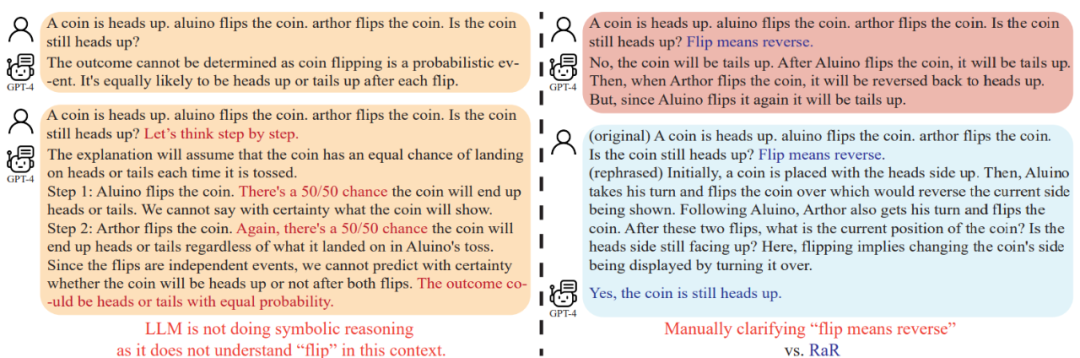

在深入探讨如何增强模型推理能力之前,这项研究指出应该提高问题的质量,以确保能正确评估模型的推理能力。例如,“硬币翻转”问题,人们发现GPT-4将“翻转(flip)”理解为随机抛掷的动作,与人类的意图不同。即使使用“让我们逐步思考”来引导模型进行推理,这种误解仍会在推理过程中存在。只有在澄清问题之后,大型语言模型才会回答预期的问题

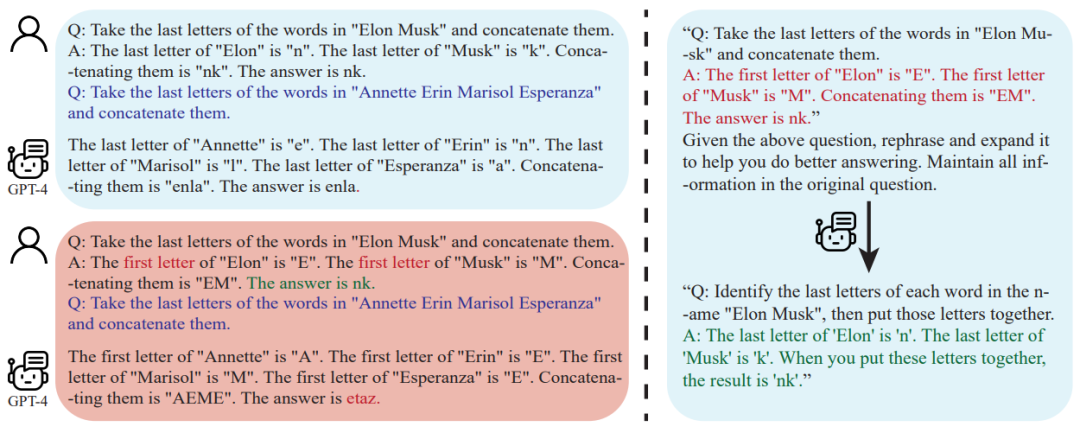

进一步的,研究人员注意到,除了问题文本之外,用于 few-shot CoT 的问答示例也是由人类编写的。这就引发了一个问题:当这些人工构造的示例存在缺陷时,大语言模型(LLM)会作出怎样的反应?该研究提供了一个很有意思的例子,并发现不良的 few-shot CoT 示例可能会对 LLM 产生负面影响。以 “末尾字母连接” 任务为例,先前使用的问题示例在提高模型性能方面显示出了积极效果。然而,当提示逻辑发生变化,比如从找到末尾字母变成找到首位字母,GPT-4 却给出了错误的答案。这一现象突显了模型对人工示例的敏感性。

研究人员发现,使用 RaR,GPT-4 可以修正给定示例中的逻辑缺陷,从而提高 few-shot CoT 的质量和稳健性

结论

人类和大型语言模型(LLM)之间的交流可能存在误解:人类看似清晰的问题,可能会被大型语言模型理解成其他问题。UCLA研究团队提出了RaR这一新颖方法,该方法促使LLM先复述并澄清问题,然后再回答,从而解决了这个问题

RaR 的有效性已经通过在多个基准数据集上进行的实验评估得到证实。进一步的分析结果显示,通过复述问题可以提升问题质量,而这种提升效果可以在不同的模型之间转移

对于未来的展望来说,预计类似于 RaR 这样的方法将不断完善,同时与 CoT 等其他方法的整合将为人类和大型语言模型之间的互动提供更准确、更有效的方式,最终拓展 AI 解释和推理能力的边界

文中关于AI,模型的知识介绍,希望对你的学习有所帮助!若是受益匪浅,那就动动鼠标收藏这篇《让大型AI模型自主提问:GPT-4打破与人类对话的障碍,展现更高水平的表现》文章吧,也可关注golang学习网公众号了解相关技术文章。

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

368 收藏

-

375 收藏

-

233 收藏

-

120 收藏

-

180 收藏

-

186 收藏

-

284 收藏

-

476 收藏

-

257 收藏

-

230 收藏

-

394 收藏

-

211 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习