横扫13个视觉语言任务!哈工深发布多模态大模型「九天」,性能直升5%

来源:51CTO.COM

时间:2023-12-04 14:42:34 166浏览 收藏

知识点掌握了,还需要不断练习才能熟练运用。下面golang学习网给大家带来一个科技周边开发实战,手把手教大家学习《横扫13个视觉语言任务!哈工深发布多模态大模型「九天」,性能直升5%》,在实现功能的过程中也带大家重新温习相关知识点,温故而知新,回头看看说不定又有不一样的感悟!

为了应对多模态大语言模型中视觉信息提取不充分的问题,哈尔滨工业大学(深圳)的研究人员提出了双层知识增强的多模态大语言模型-九天(JiuTian-LION)。

需要重新写的内容是:论文链接:https://arxiv.org/abs/2311.11860

GitHub: https://github.com/rshaojimmy/JiuTian

项目主页: https://rshaojimmy.github.io/Projects/JiuTian-LION

与现有的工作相比,九天首次分析了图像级理解任务和区域级定位任务之间的内部冲突,提出了分段指令微调策略和混合适配器来实现两种任务的互相提升。

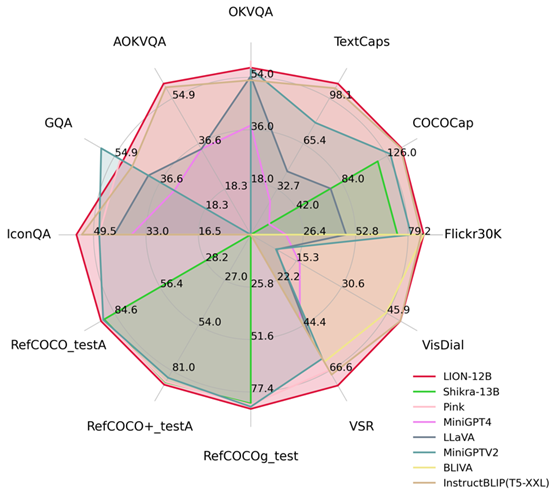

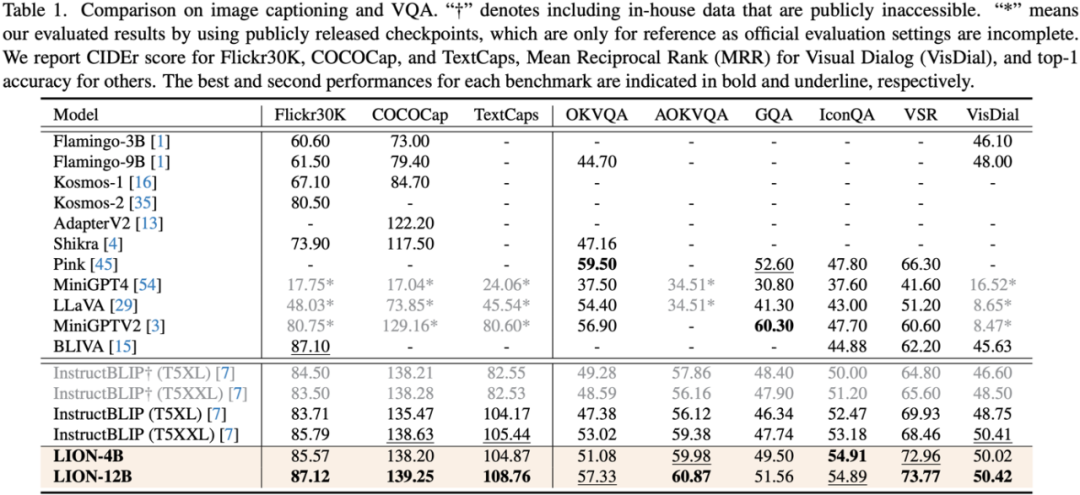

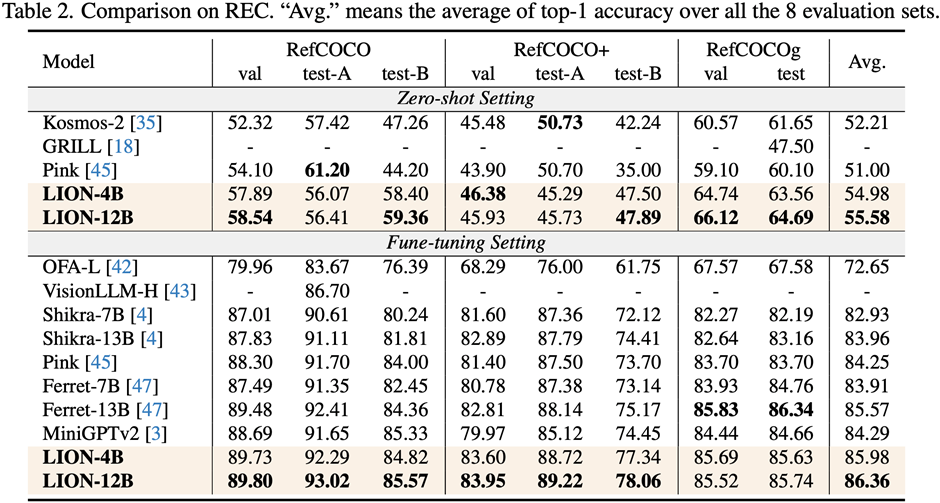

通过注入细粒度空间感知和高层语义视觉知识,九天实现了在包括图像描述、视觉问题、和视觉定位等17个视觉语言任务上显著的性能提升( 比如Visual Spatial Reasoning 上高达5% 的性能提升),在其中13个评测任务上达到了国际领先水平,性能对比如图1所示。

图1:对比其他MLLMs,九天在大部分任务上都取得了最优的性能。

九天JiuTian-LION

通过赋予大型语言模型(LLMs)多模态感知能力,一些工作开始生成多模态大语言模型(MLLMs),并在许多视觉语言任务上取得了突破性进展。然而,现有的MLLMs主要采用图文对预训练得到的视觉编码器,如CLIP-ViT

这些视觉编码器的主要任务是学习图像层面的粗粒度图像文本模态对齐,但是它们缺乏全面的视觉感知和信息抽取能力,无法进行细粒度的视觉理解

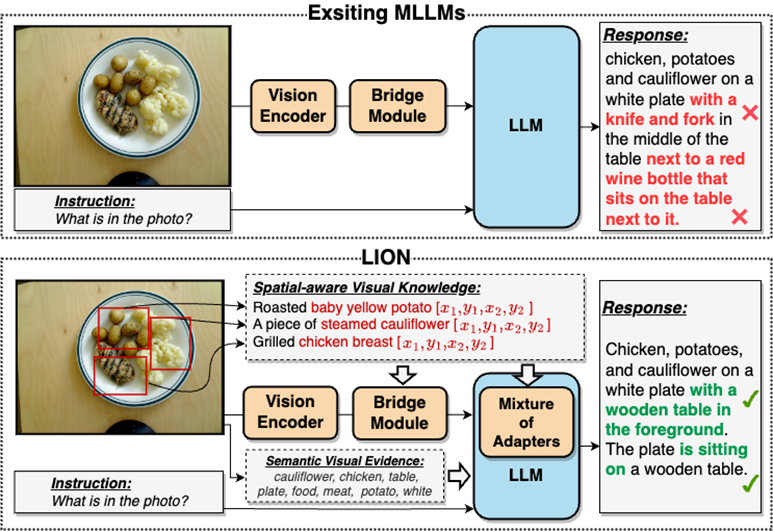

在很大程度上,这种视觉信息提取不足和理解程度不够的问题会导致MLLMs存在视觉定位偏差、空间推理不足和物体幻觉等多个缺陷,如图2所示

请参考图2:九天(JiuTian-LION)是一种采用双层视觉知识增强的多模态大语言模型

九天相较于现有的多模态大语言模型(MLLMs),通过注入细粒度空间感知视觉知识和高层语义视觉证据,有效地提升了MLLMs的视觉理解能力,生成更准确的文本回应,减少了MLLMs的幻觉现象

双层视觉知识增强的多模态大语言模型-九天(JiuTian-LION)

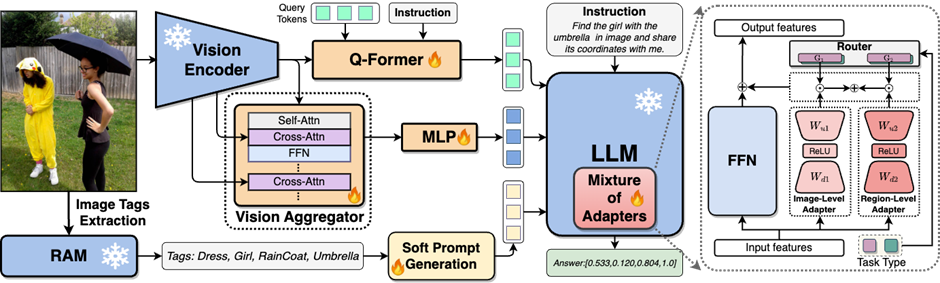

为了解决MLLMs在视觉信息提取和理解方面存在的不足,研究人员提出了一种双层视觉知识增强的MLLMs方法,被称为九天(JiuTian-LION)。具体的方法框架如图3所示

该方法主要从两方面增强MLLMs,渐进式融合细粒度空间感知视觉知识(Progressive Incorporation of Fine-grained Spatial-aware Visual knowledge)和软提示下的高层语义视觉证据(Soft Prompting of High-level Semantic Visual Evidence)。

具体来说,研究人员提出了一种分段指令微调策略,以解决图像级理解任务和区域级定位任务之间的内部冲突。他们逐步将细粒度的空间感知知识注入到MLLMs中。同时,他们将图像标签作为高层语义视觉证据加入MLLMs,并使用软提示方法来减轻不正确标签可能带来的负面影响

九天(JiuTian-LION)模型框架图如下所示:

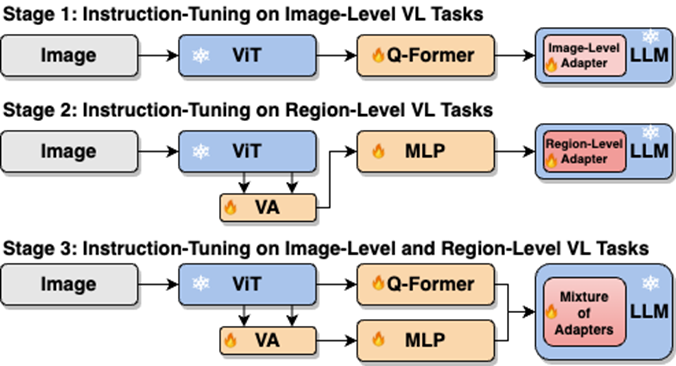

该工作通过分段式训练策略先分别基于Q-Former 和 Vision Aggregator – MLP 两个分支学习图像级理解和区域级定位任务,然后在最后训练阶段利用具有路由机制的混合适配器来动态融合不同分支的知识提升模型在两种任务的表现。

该工作还通过RAM提取图像标签作为高层语义视觉证据,然后提出软提示方法来提高高层语义注入的效果

渐进式融合细粒度空间感知视觉知识

当直接将图像级理解任务(包括图像描述和视觉问答)与区域级定位任务(包括指示表达理解,指示表达生成等)进行单阶段混合训练时,MLLMs 会遭遇两种任务之间存在的内部冲突,从而不能在所有任务上取得较好的综合性能。

研究人员认为这种内部冲突主要由两个问题引起。第一个问题是缺少区域级的模态对齐预训练,当前具有区域级定位能力的 MLLMs 大多先使用大量相关数据进行预训练,不然很难在有限地训练资源下让基于图像级模态对齐的视觉特征适应区域级任务。

另一个问题是图像级理解任务和区域级定位任务之间的输入输出模式差异,后者需要模型额外理解关于物体坐标的特定短句(以 的形式)。为了解决以上问题,研究人员提出了分段式指令微调策略,以及具有路由机制的混合适配器。

的形式)。为了解决以上问题,研究人员提出了分段式指令微调策略,以及具有路由机制的混合适配器。

如图4所示,研究人员将单阶段指令微调过程拆分为三阶段:

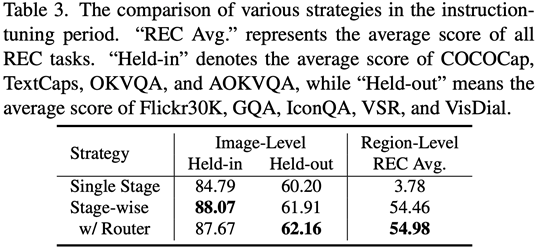

使用ViT、Q-Former和图像级适配器学习全局视觉知识的图像级理解任务;使用Vision Aggregator、MLP和区域级适配器学习细粒度空间感知视觉知识的区域级定位任务;提出了具有路由机制的混合适配器,动态融合不同分支中学习到的不同粒度的视觉知识。表3显示了分段式指令微调策略相对于单阶段训练的性能优势

图4:分段式指令微调策略

对于注入软提示下的高层语义视觉证据,需要进行重写处理

研究人员提出使用图像标签作为高层语义视觉证据的有效补充,以进一步增强MLLMs的全局视觉感知理解能力

具体来说,首先通过 RAM 提取图像的标签,然后利用特定的指令模版“According to

配合模版中特定短语“use or partially use”,软提示向量可以指导模型减轻不正确标签带来的潜在负面影响。

实验结果

研究人员在包括图像描述(image captioning)、视觉问答(VQA)、和指示表达理解(REC)等17个任务基准集上进行了评测。

实验结果表明,九天在13个评测集上达到了国际领先水平。特别的,相比较 InstructBLIP 和 Shikra,九天分别在图像级理解任务和区域级定位任务上取得了全面且一致的性能提升,在 Visual Spatial Reasoning (VSR) 任务上可达到最高5%的提升幅度。

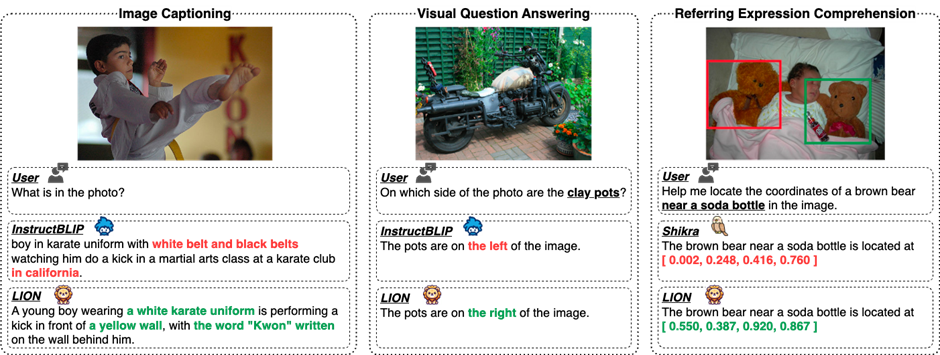

从图5可以看出,在不同的视觉语言多模态任务中,九天和其他MLLMs的能力存在差异,表明九天在细粒度视觉理解和视觉空间推理能力方面表现更优秀,并且能够输出具有更少幻觉的文本回应

重写的内容是:第五张图展示了对九天大模型、InstructBLIP和Shikra的能力差异进行的定性分析

图6通过样本分析,表明了九天模型在图像级和区域级视觉语言任务上都具有优秀的理解和识别能力。

第六张图:通过更多例子的分析,从图像和区域级视觉理解的角度展示了九天大模型的能力

总结

(1)该工作提出了一个新的多模态大语言模型-九天:通过双层视觉知识增强的多模态大语言模型。

(2)该工作在包括图像描述、视觉问答和指示表达理解等17个视觉语言任务基准集上进行评测,其中13个评测集达到了当前最好的性能。

(3)这项工作提出了一种分段式指令微调策略,以解决图像级理解和区域级定位任务之间的内部冲突,并实现了两种任务之间的相互提升

(4)该工作成功将图像级理解和区域级定位任务进行整合,多层次全面理解视觉场景,未来可以将这种全面的视觉理解能力应用到具身智能场景,帮助机器人更好、更全面地识别和理解当前环境,做出有效决策。

以上就是本文的全部内容了,是否有顺利帮助你解决问题?若是能给你带来学习上的帮助,请大家多多支持golang学习网!更多关于科技周边的相关知识,也可关注golang学习网公众号。

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

319 收藏

-

384 收藏

-

229 收藏

-

329 收藏

-

455 收藏

-

185 收藏

-

109 收藏

-

451 收藏

-

199 收藏

-

277 收藏

-

281 收藏

-

376 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习