用8x7B MoE和Flash Attention 2,不到10行代码实现高效推理

来源:51CTO.COM

时间:2024-01-02 15:32:17 281浏览 收藏

在IT行业这个发展更新速度很快的行业,只有不停止的学习,才不会被行业所淘汰。如果你是科技周边学习者,那么本文《用8x7B MoE和Flash Attention 2,不到10行代码实现高效推理》就很适合你!本篇内容主要包括##content_title##,希望对大家的知识积累有所帮助,助力实战开发!

最近,Mistral AI公开了Mixtral 8x7B模型,这一消息在开源社区引起了轰动。该模型的架构与GPT-4非常相似,因此被许多人称为GPT-4的“缩小版”。

众所周知,OpenAI团队一直对于GPT-4的参数和训练细节保持着高度保密。然而,他们最近公开了Mistral 8x7B,这无疑给广大开发者提供了一个接近于GPT-4的开源选择。

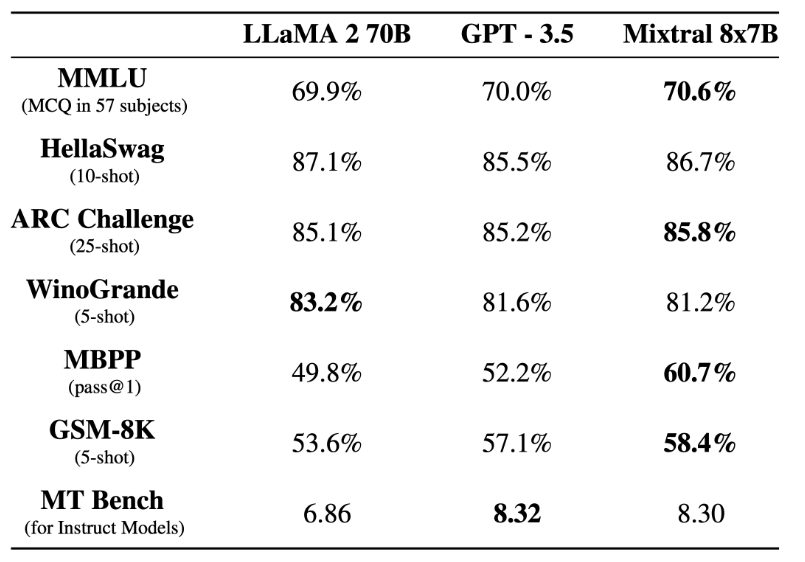

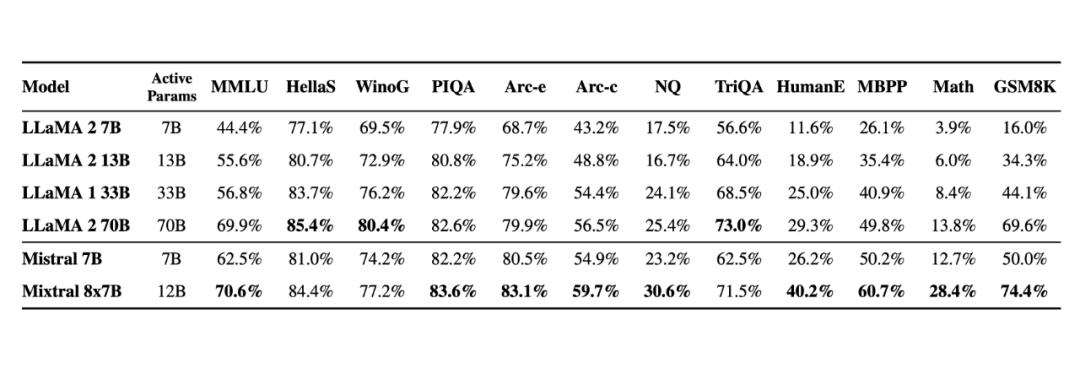

经过基准测试,Mistral 8x7B在性能上表现出色,比Llama 2 70B更为出色。在大多数标准基准测试中,Mistral 8x7B的表现与GPT-3.5不相上下,甚至稍微领先一些。

《文字玩出花》中的怀旧大扫除关卡是该游戏中备受喜爱的一个挑战,每天都会有新的难题等待着我们。在这个关卡中,我们需要仔细观察一幅图像,并找出其中与时代不符的12个细节。为了帮助那些还未通过此关的玩家们,今天我将为大家分享《文字玩出花》怀旧大扫除关卡的通关

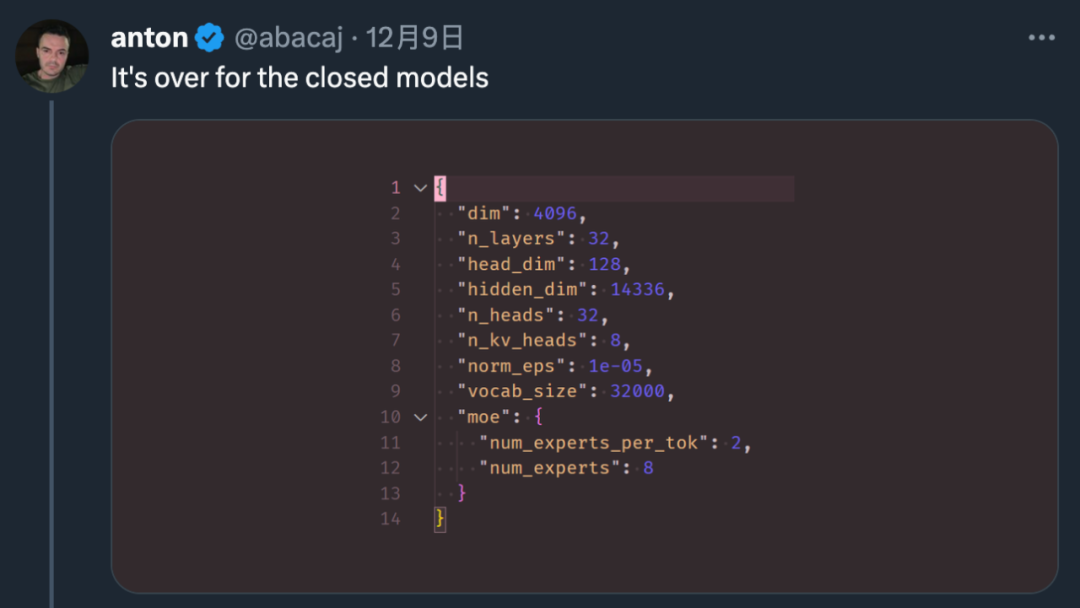

随着这项研究的发布,很多人纷纷表示:“闭源大模型已经走到了尾声。”

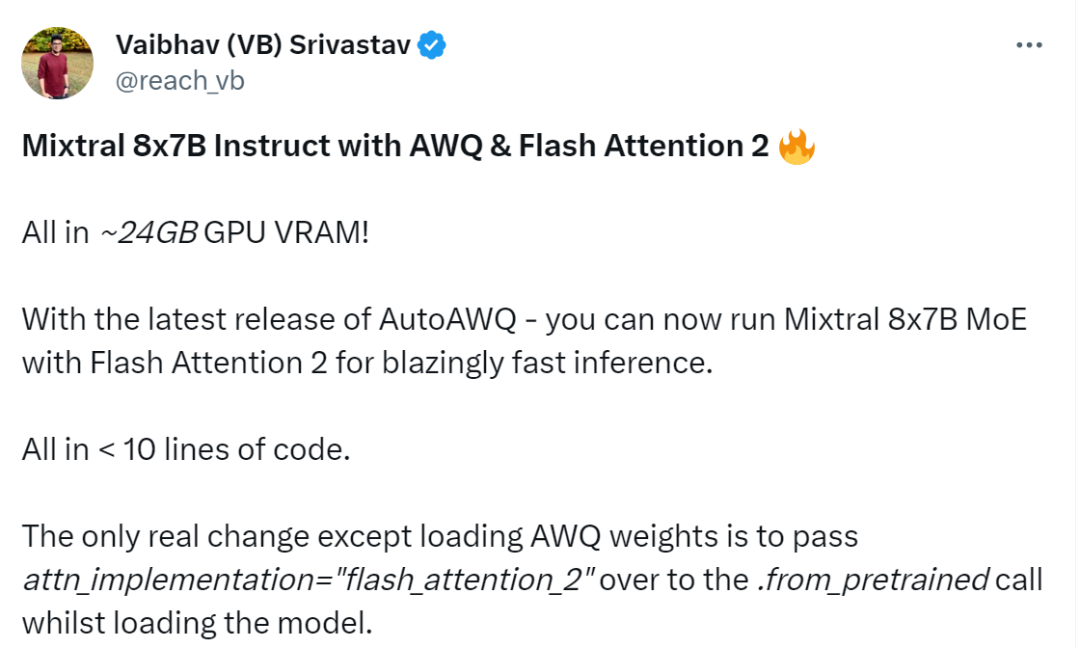

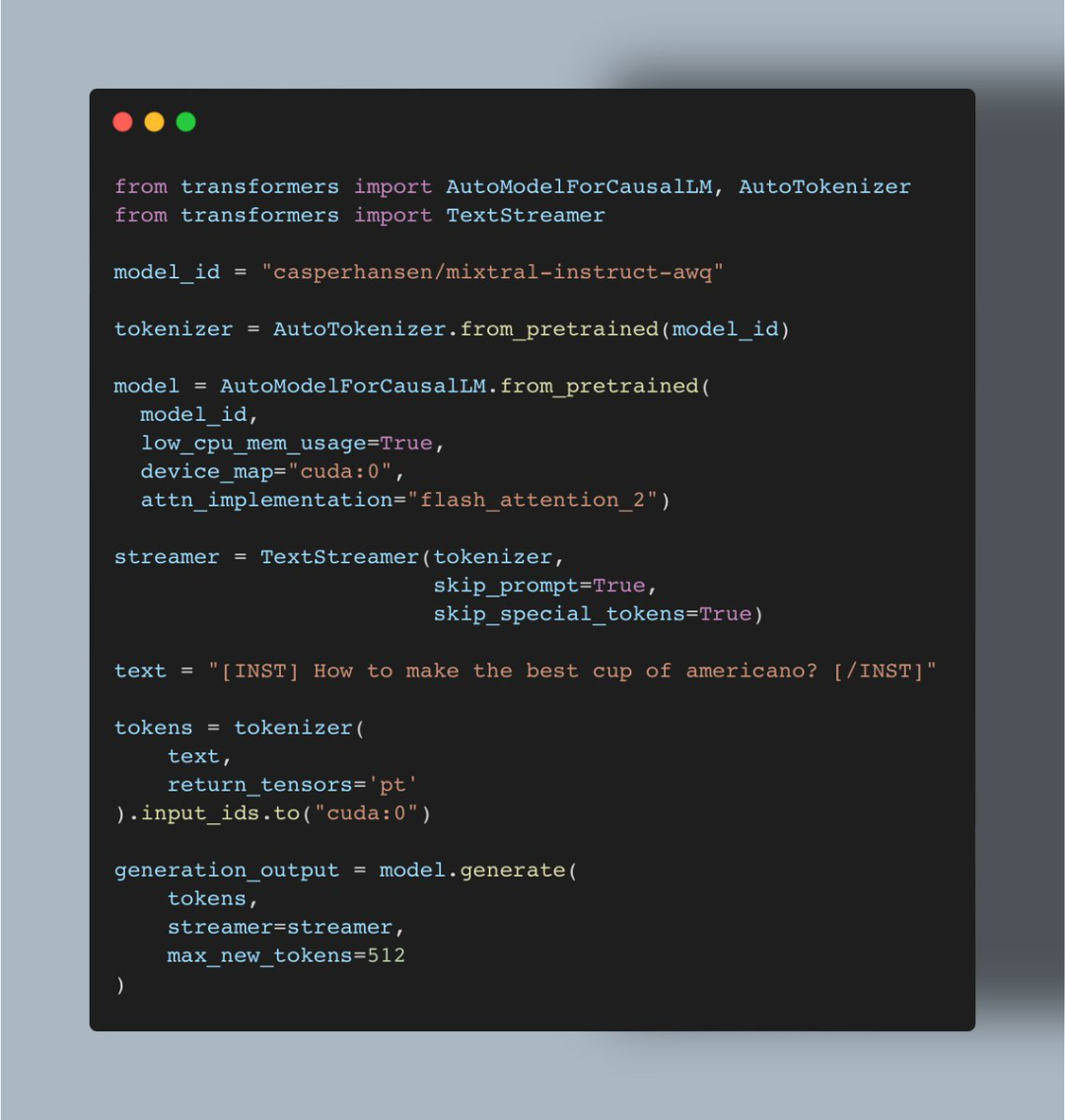

Vaibhav (VB) Srivastav,一个机器学习爱好者,最近表示,在短短几周的时间内,AutoAWQ的最新版本已经发布。这个版本支持了Mixtral和LLaVa等模型的量化。现在用户可以将Mixtral 8x7B Instruct与Flash Attention 2相结合,以实现快速推理的目标。令人惊讶的是,只需要不到24GB的GPU VRAM和不到十行的代码,就能够实现这个功能。

图源:https://twitter.com/reach_vb/status/1741175347821883502

AutoAWQ 地址:https://github.com/casper-hansen/AutoAWQ

操作过程是这样的:

首先是安装 AutoAWQ 以及 transformers:

pip install autoawq git+https://github. com/huggingface/transformers.git

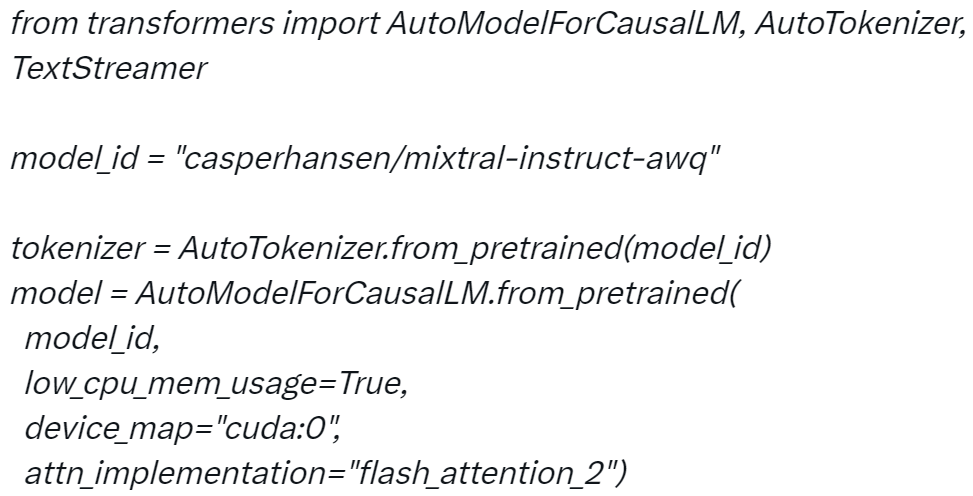

第二步是初始化 tokenizer 和模型:

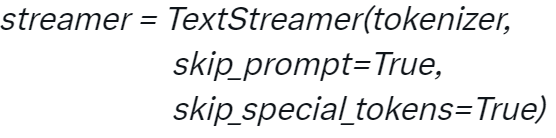

第三步是初始化 TextStreamer:

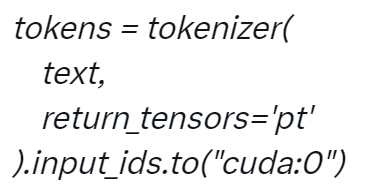

第四步对输入进行 Token 化:

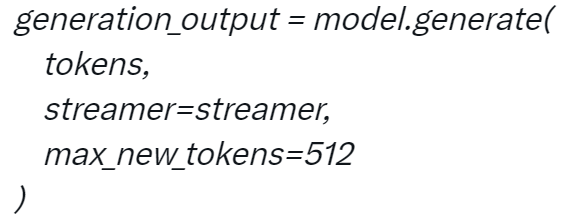

第五步生成:

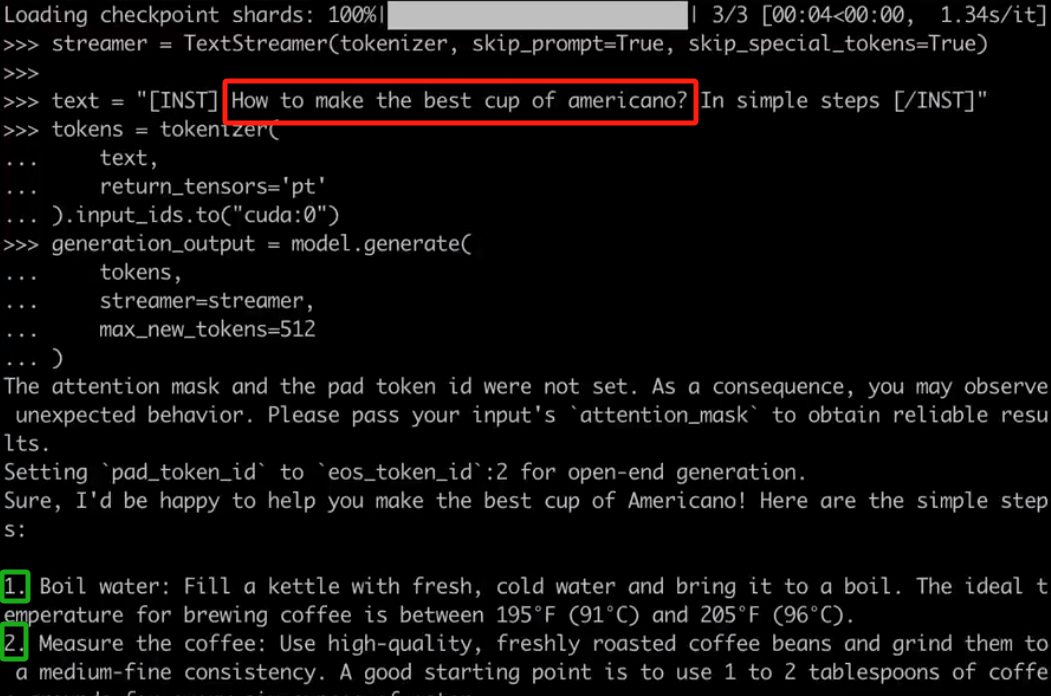

当你配置好项目后,就可以与 Mixtral 进行对话,例如对于用户要求「如何做出最好的美式咖啡?通过简单的步骤完成」,Mixtral 会按照 1、2、3 等步骤进行回答。

项目中使用的代码:

Srivastav 表示上述实现也意味着用户可以使用 AWQ 运行所有的 Mixtral 微调,并使用 Flash Attention 2 来提升它们。

看到这项研究后,网友不禁表示:真的很酷。

更多相关链接,请参考:

模型地址:https://huggingface.co/models?search=mixtral%20awq

Transformer 中量化技术:https://huggingface.co/docs/transformers/main/en/quantization

理论要掌握,实操不能落!以上关于《用8x7B MoE和Flash Attention 2,不到10行代码实现高效推理》的详细介绍,大家都掌握了吧!如果想要继续提升自己的能力,那么就来关注golang学习网公众号吧!

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

501 收藏

-

319 收藏

-

421 收藏

-

231 收藏

-

389 收藏

-

304 收藏

-

357 收藏

-

140 收藏

-

301 收藏

-

183 收藏

-

127 收藏

-

173 收藏

-

202 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习