Hive的安装部署操作

来源:SegmentFault

时间:2023-02-24 18:27:26 179浏览 收藏

知识点掌握了,还需要不断练习才能熟练运用。下面golang学习网给大家带来一个数据库开发实战,手把手教大家学习《Hive的安装部署操作》,在实现功能的过程中也带大家重新温习相关知识点,温故而知新,回头看看说不定又有不一样的感悟!

基本原理

- Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

- Hive构建在基于静态批处理的Hadoop之上,由于Hadoop通常都有较高的延迟并且在作业提交和调度的时候需要大量的开销。因此,Hive并不适合那些需要低延迟的应用,它最适合应用在基于大量不可变数据的批处理作业,例如,网络日志分析。

- Hive的特点是:可伸缩(在Hadoop集群上动态的添加设备)、可扩展、容错、输出格式的松散耦合。

- Hive将元数据存储在关系型数据库(RDBMS)中,比如MySQL、Derby中。

- Hive有三种模式连接到数据,其方式是:单用户模式,多用户模式和远程服务模式。(也就是内嵌模式、本地模式、远程模式)。

系统环境

Linux Ubuntu 20.04

OpenJDK-11.0.11

hadoop-3.2.2

mysql-8.0.25

mysql-connector-java-8.0.25.jar

前提条件

在Hadoop和mysql安装完成的基础上,搭建hive。

安装步骤

1.在Linux本地创建/data/hive1文件夹用来存放安装包。

mkdir -p /data/hive1

切换到/data/hive1的目录下,使用wget命令下载apache-hive-2.3.8-bin.tar.gz和mysql-connector-java-8.0.25.jar。

cd /data/hive1 wget https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-2.3.8/apache-hive-2.3.8-bin.tar.gz wget https://dev.mysql.com/downloads/file/?id=504646

2.将/data/hive1目录下的apache-hive-2.3.8-bin.tar.gz,解压缩到/apps目录下。

tar -xzvf /data/hive1/apache-hive-2.3.8-bin.tar.gz -C /apps/

再切换到/apps目录下,将/apps/hive-1.1.0-cdh5.4.5,重命名为hive。

cd /apps mv /apps/apache-hive-2.3.8-bin.tar.gz/ /apps/hive

3.使用vim打开用户环境变量。

sudo vim ~/.bashrc

将Hive的bin目录,添加到用户环境变量PATH中,然后保存退出。

#hive config export HIVE_HOME=/apps/hive export PATH=$HIVE_HOME/bin:$PATH

执行source命令,使Hive环境变量生效。

source ~/.bashrc

4.由于Hive需要将元数据,存储到Mysql中。所以需要拷贝/data/hive1目录下的mysql-connector-java-8.0.25.jar到hive的lib目录下。

cp /data/hive1/mysql-connector-java-8.0.25.jar/apps/hive/lib/

5.下面配置Hive,切换到/apps/hive/conf目录下,并创建Hive的配置文件hive-site.xml。

cd /apps/hive/conf touch hive-site.xml

使用vim打开hive-site.xml文件。

vim hive-site.xml

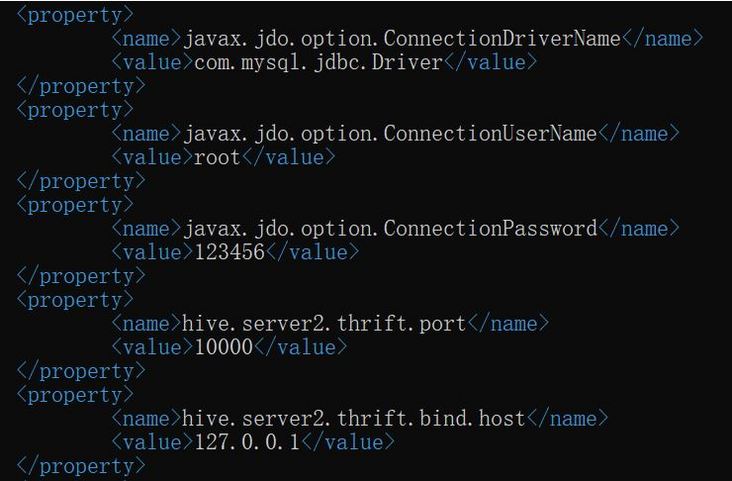

并将下列配置项,添加到hive-site.xml文件中。

<property>

#javax.jdo.option.ConnectionDriverName:连接数据库的驱动包。

<name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value></property><property>

#javax.jdo.option.ConnectionUserName:数据库用户名。

<name>javax.jdo.option.ConnectionUserName</name><value>root</value></property><property>

#javax.jdo.option.ConnectionPassword:连接数据库的密码。

<name>javax.jdo.option.ConnectionPassword</name><value>123456</value></property><property><name>hive.server2.thrift.port</name><value>10000</value></property><property><name>hive.server2.thrift.bind.host</name><value>127.0.0.1</value></property>

由于Hive的元数据会存储在Mysql数据库中,所以需要在Hive的配置文件中,指定mysql的相关信息。

javax.jdo.option.ConnectionURL:数据库链接字符串。

javax.jdo.option.ConnectionDriverName:连接数据库的驱动包。

javax.jdo.option.ConnectionUserName:数据库用户名。

javax.jdo.option.ConnectionPassword:连接数据库的密码。

此处的数据库的用户名及密码,需要设置为自身系统的数据库用户名及密码。

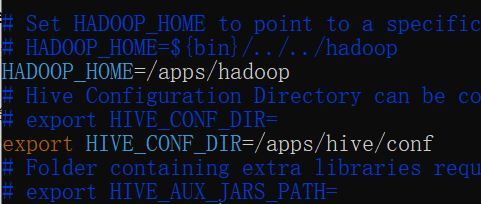

6.另外,还需要告诉Hive,Hadoop的环境配置。所以我们需要修改hive-env.sh文件。

首先我们将hive-env.sh.template重命名为hive-env.sh。

mv /apps/hive/conf/hive-env.sh.template /apps/hive/conf/hive-env.sh

使用vim打开hive-env.sh文件。

vim hive-env.sh

追加Hadoop的路径,以及Hive配置文件的路径到文件中。

# Set HADOOP_HOME to point to a specific hadoop install directory

# HADOOP_HOME=${bin}/../../hadoop

HADOOP_HOME=/apps/hadoop

# Hive Configuration Directory can be controlled by:

# export HIVE_CONF_DIR=

export HIVE_CONF_DIR=/apps/hive/conf

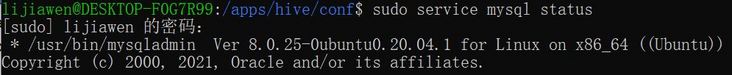

7.下一步是配置Mysql,用于存储Hive的元数据。

首先,需要保证Mysql已经启动。执行以下命令,查看Mysql的运行状态。

sudo service mysql status

通过输出,可以看出Mysql已经启动。如果未启动需要执行启动命令。

sudo service mysql start

如果未安装Mysql则需要执行安装命令。若我们的环境已安装Mysql,则无需执行此步。

sudo apt-get install mysql-server

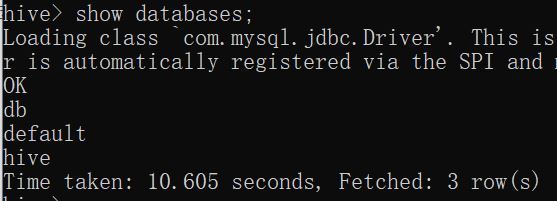

8.开启Mysql数据库。

mysql -u root -p

查看数据库。

show databases;

下面,输入exit退出Mysql。

exit

9.执行测试。由于Hive对数据的处理,依赖MapReduce计算模型,所以需要保证Hadoop相关进程已经启动。

输入jps,查看进程状态。若Hadoop相关进程未启动,则需启动Hadoop。

/apps/hadoop/sbin/start-all.sh

启动Hadoop后,在终端命令行界面,直接输入hive便可启动Hive命令行模式。

hive

输入HQL语句查询数据库,测试Hive是否可以正常使用。

show databases;

踩坑

报错:hive启动时报错

Exception in thread “main” java.lang.NoSuchMethodError: com.google.common.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)V

原因:hadoop和hive的lib下有一个guava开头的jar包不匹配。

查看guava开头的jar分别在hadoop和hive上的所在路径

Hadoop:

cd /apps/hadoop/share/hadoop/common/lib/

Hive:

cd /apps/hive/lib/

解决:查看所在路径下的guava开头的jar,选择版本高的那个去覆盖另一个。

mv /apps/hadoop/share/hadoop/common/lib/guava-27.0-jre.jar /apps/hive/lib/

删除掉版本低的

rm -f guava-19.0.jar

完成!

今天带大家了解了MySQL、ubuntu20.04、hive、hadoop、wsl2的相关知识,希望对你有所帮助;关于数据库的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

-

499 收藏

-

244 收藏

-

235 收藏

-

157 收藏

-

101 收藏

-

413 收藏

-

175 收藏

-

174 收藏

-

120 收藏

-

404 收藏

-

427 收藏

-

351 收藏

-

156 收藏

-

405 收藏

-

497 收藏

-

133 收藏

-

319 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习