这段代码让程序执行效率提升200倍,值得一看!

来源:SegmentFault

时间:2023-02-24 12:44:08 226浏览 收藏

IT行业相对于一般传统行业,发展更新速度更快,一旦停止了学习,很快就会被行业所淘汰。所以我们需要踏踏实实的不断学习,精进自己的技术,尤其是初学者。今天golang学习网给大家整理了《这段代码让程序执行效率提升200倍,值得一看!》,聊聊MySQL、Java,我们一起来看看吧!

点赞的靓仔,你最帅哦!

源码已收录github 查看源码

前言

前几天业务系统部门将我们数据平台给投诉了,因为在工作时间内,业务系统查询不到想要的数据,这种问题可大可小,但毕竟影响到了业务的正常运行,所有的技术都是为业务服务的,所以不论技术难度大小,必须要进行整改,同时作为互联网的‘工匠精神’,我们不光要让功能正常运行,还要让功能以最优的状态运行。

系统介绍

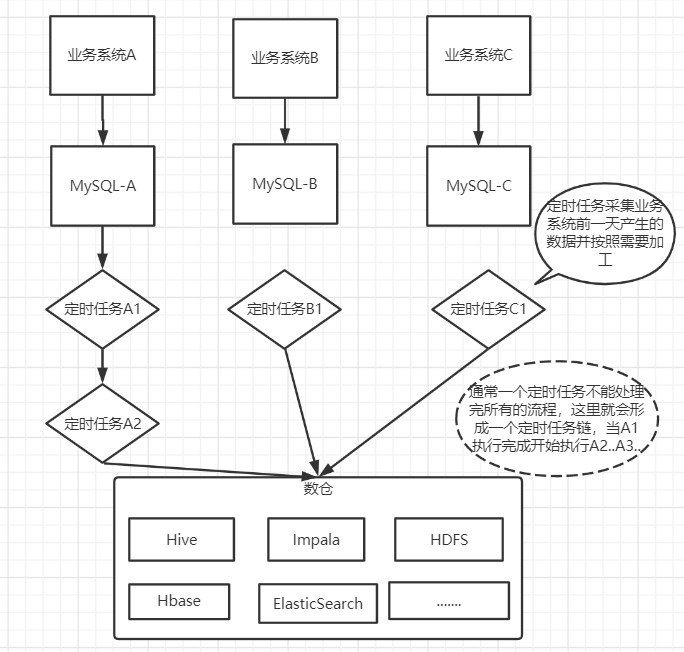

整个系统可以从功能上分为3块:

- 业务系统:在上游有很多的业务系统,业务系统的运行产生很多的数据,这些数据分散在很多的数据库中,大部分是MySQL数据库

- 数据智能平台:数据智能平台属于中台系统,主要为业务系统提供强大的数据支撑服务,下层连接数仓。

- 数据仓库: 数据仓库统一集中的管理所有的数据,数仓会将业务系统产生的数据按天进行加工、抽取、转换到数据仓库存储。

当一天结束后,各个业务系统产生了大量的数据,这些数据由定时任务进行加工、抽取到数据仓库存储,当半夜你还在睡觉的时候,这些定时任务就在默默的运行着。

而每天加工的数据通常要求在上班工作时间之前加工完成,然后通过数据智能平台的查询系统供业务系统查询调用,这一次数据没有查询到是因为在第二天早上10点,数据还没有加工完成。下面就是找问题优化了,因为正常来讲,即使定时任务链再长,也不会慢到第二天10点钟数据还没有出来。下面就是找问题,然后进行优化了。

任务优化

通过任务日志发现有一个上游系统的数据抽取执行时间有3个小时,而数据量仅100万。当然,光凭这样还无法确定这个任务是否是可以被优化的。

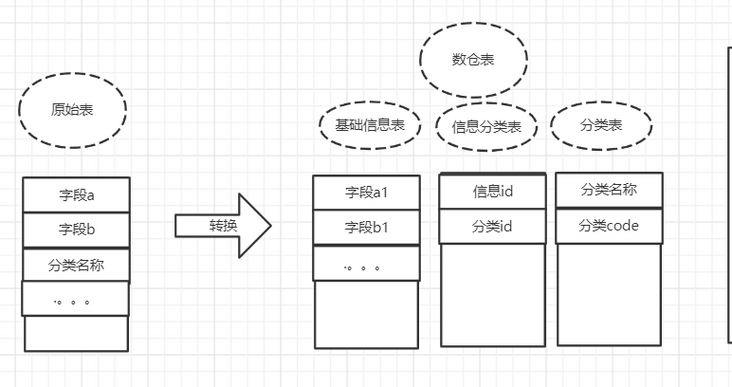

查看任务代码,逻辑还比较简单:有一张原始数据表,记录商品信息以及定义的分类(这一点是虚构的,实际情况要复杂一些,我这里精简然后转换了一下,便于理解),而数仓的目标表是将分类和商品分别存储在不同的表中,大致结构如下。

那为什么需要进行这样的转换呢? 这是因为整个大的系统,一般来说只能定义一些基本的规范,而具体的细节规范则无法约束,比如A系统的身份证字段名称为card_no,而B系统的身份证字段名称为crdt_no(这种情况大家应该经常遇到);再比如处理实体关系的时候,处理方式也是不同的,1对1的关系,可以建两张表关联,也可以一张表都存储,这就造成了多个系统的不统一性,而这种情况是不可避免的,因为从业务系统来说,都保证了系统的正常运行。

而数仓对多个原始数据处理的时候就需要考虑到兼容的问题,所以就会出现如上图的转换过程。

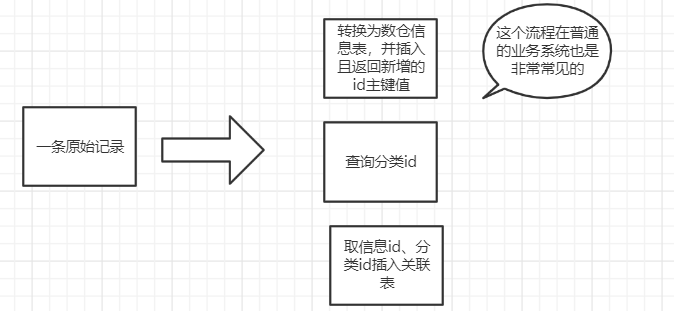

而这个任务执行3个小时的原因在于原始表中的一条记录,会转换到数仓表中的三张表中,而且这三张表是通过id进行关联,整个代码流程如下。

然而问题来了,100万的数据,跑了3个小时,然后我开始尝试去优化程序的执行流程,大概从一下几点入手

- 将分类缓存,分类在系统中已经固定,不会发生变化,缓存可以减少查询数据库的次数

- 每次从原表中读取的数据更多,从原来的500/次 -> 2000/次

经过优化,效率有一些提升,但并不是很明显(有同学可能要问了,这些都是很基本的,为什么最开始做? 咳咳。。。这个嘛,历史原因吧,在最开始数据可能不多,不论以什么方式执行,都差别不大,比如执行10分钟和执行20分钟,看似2倍的执行效率,但是由于没有影响到业务系统,且一直正常运行,也就没有看出问题)。

这里数据是需要关联的,所以我们是需要插入数据并拿到这条记录的自增长id,然后插入到关联表,而表结构基本不可能去动的(表结构动了那真是牵一发而动全身了,第二天准得被叫去喝茶)。

那么我们先来分析一下这里为什么执行这么慢呢。

- 原表100万的数据,每次查询出2000条,所以查询的总次数就是1000000/2000 = 500次,这肯定消耗不了多少时间。这里基本没有优化的空间,就算一次全部查询出来,也仅仅节省499次的查询时间(也不可能一次查询这么多数据)

- 查询的2000条数据,数据转换,然后依次插入到信息表以及关联表中,这里是一条一条解析执行的,总计插入数据库4000次,毫无疑问,这里是最耗时的。数据转换是必须的,而且是在内存中操作,所以耗时不是特别多;那么剩下的就是总计100万 * 2的数据库插入次数,能否进行优化呢?

首先想到的就是批量插入,批量插入可以有效的降低数据库访问次数。但是这里不能进行批量插入是因为需要取到自增长id,感觉陷入了困境。

当天晚上昨晚运动之后,抛开烦恼,觉得浑身舒坦。

突然,脑袋灵光一闪,数据库的自增长id是由数据库控制的数值,而自增长的步长我们是知道的,比如自增长步长为1,当前自增长id为1的话,那么可以肯定,下一条记录的自增长id就为2,以此类推。

那是否可以插入一条记录,取到自增长id,然后就可以计算出之后所有数据的自增长id,而不再需要每条记录都去取自增长id了。

但是这样也有一个问题,就是在数据转换导入的过程中,不能有其他的程序向表中插入数据,不然会导致程序计算的自增长id匹配不上。而这个问题根本不存在,因为数仓的数据都是由原始表计算插入的,在同一时间是没有其他的任务写这张表,那么我们就可以放心大胆的干了。

我将这一部分逻辑抽象出来做成了一个demo,并填充了100万的数据,优化前的核心代码如下:

private void exportSource(){

List<source> sources;

//刷新日期, 这里属性作为日期, 其实应该以局部变量当作参数传递会更好,原谅我偷个懒

date = new Date();

int pageNum = 1;

do{

sources = sourceService.selectList(pageNum++, pageSize);

System.out.println(sources);

for (Source source : sources) {

//数据转换

Target transfer = transfer(source);

//插入数据,返回自增长id

targetService.insert(transfer);

TargetCategory targetCategory = new TargetCategory();

Category category = allCategory.get(source.getCategoryName());

if(category != null){

targetCategory.setCategoryId(category.getId());

}

targetCategory.setTargetId(transfer.getId());

//插入分类数据

targetCategoryService.insert(targetCategory);

}

}while(sources.size() > 0);

}</source>效率就不说了,我跑了1个小时,差不多跑了20万的数据(预计总运行时间大于5小时),然后没继续跑了,在这个基础上做了优化。

private void exportSourcev2(){

List<source> sources;

//刷新日期, 这里属性作为日期, 其实应该以局部变量当作参数传递会更好,原谅我偷个懒

date = new Date();

int pageNum = 1;

Integer startId = 0;

do{

sources = sourceService.selectList(pageNum++, pageSize);

List<target> sourceList = new ArrayList();

List<targetcategory> targetCategoryList = new ArrayList();

for (Source source : sources) {

//数据转换

Target transfer = transfer(source);

//第一次,取出自增长id,后面就直接计算

if(startId == 0){

//插入数据,返回自增长id

targetService.insert(transfer);

startId = transfer.getId();

}else{

startId++;

sourceList.add(transfer);

}

TargetCategory targetCategory = new TargetCategory();

Category category = allCategory.get(source.getCategoryName());

if(category != null){

targetCategory.setCategoryId(category.getId());

}

targetCategory.setTargetId(transfer.getId());

targetCategoryList.add(targetCategory);

}

if(sourceList.size() > 0){

targetService.insertBatch(sourceList);

}

if(targetCategoryList.size() > 0){

targetCategoryService.insertBatch(targetCategoryList);

}

}while(sources.size() > 0);

}</targetcategory></target></source>

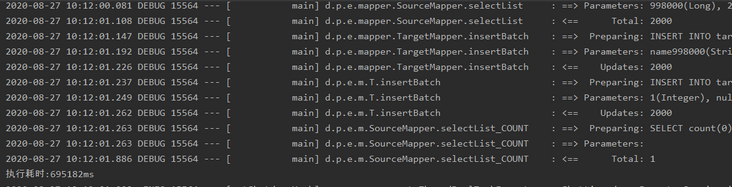

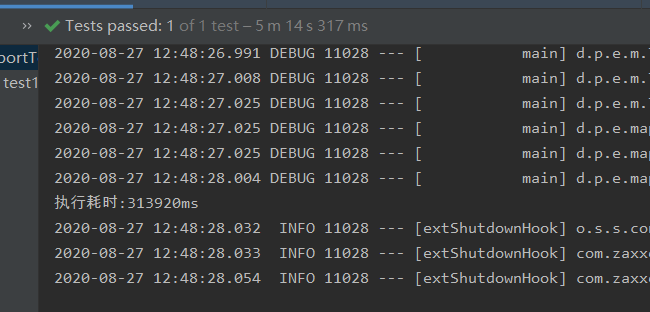

从测试结果来看,执行时间已经大大降低,从至少5小时的运行时间缩短到12分钟不到。

才11分钟,我们怎么就满足了,不够不够!!!!

好吧,可怜的博主继续动动歪脑筋,想个办法满足各位看官。其实从测试打印的SQL速度就能够感觉出来,在刚刚开始的时候,SQL是刷刷刷的打印,到了后面,SQL是刷。。。刷。。。刷的打印,感觉像是快没油了的汽车,从这个地方入手,看能否优化。

public List<source> selectList(Integer pageNum, Integer pageSize) {

//分页查询

PageHelper.startPage(pageNum,pageSize);

List<source> sources = sourceMapper.selectList();

return sources;

}</source></source>//打印的某条查询SQL ==> Preparing: SELECT * FROM source LIMIT ?, ? ==> Parameters: 998000(Long), 2000(Integer)

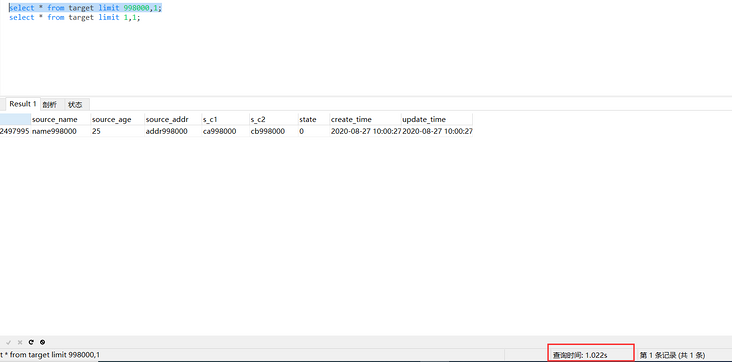

我们把这条SQL在Navcat执行下看看时间呢

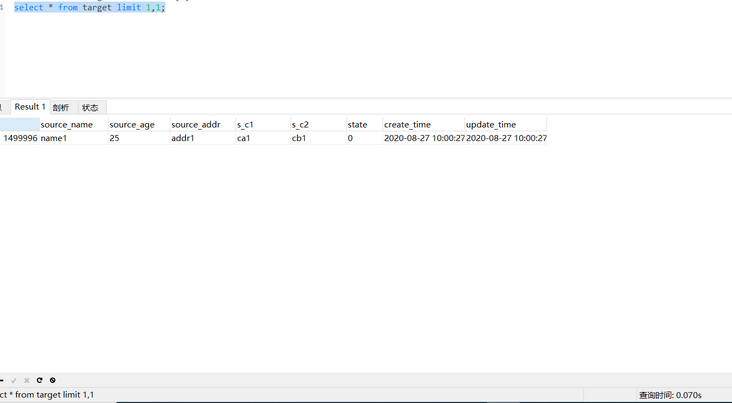

查询1条记录居然用时1秒,再来看另外一个查询。

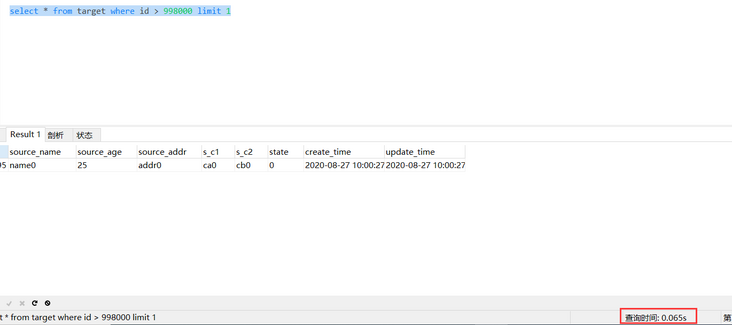

用时70ms,这个挺正常的。由于limit查询会查询出offset的所有数据然后将offest之前的数据丢弃,就是进行了全表检索,所以造成效率低。可以通过where id 构建条件来优化查询效率。

@Select(" SELECT t.* " +

" FROM ( " +

" SELECT id " +

" FROM source " +

" ORDER BY " +

" id " +

" LIMIT #{offset}, #{size} " +

" ) q " +

"JOIN source t " +

"ON t.id = q.id")

List<source> selectList(PageParam page);</source>

这样一来,查询效率也得到了优化。

从实测结果,整体效率提升一倍还多,由12分钟提升至5分钟。

总结

本文的提升程序执行效率是通过批量插入以及优化分页查询效率来实现的,欢迎借鉴、欢迎指正。

以上就是《这段代码让程序执行效率提升200倍,值得一看!》的详细内容,更多关于mysql的资料请关注golang学习网公众号!

-

499 收藏

-

244 收藏

-

235 收藏

-

157 收藏

-

101 收藏

-

174 收藏

-

120 收藏

-

404 收藏

-

427 收藏

-

351 收藏

-

156 收藏

-

405 收藏

-

497 收藏

-

133 收藏

-

319 收藏

-

141 收藏

-

256 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 立即学习 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 立即学习 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 立即学习 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 立即学习 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 立即学习 485次学习