-

豆包AI绘画需先正确进入绘图界面,再构建结构化提示词,选择适配参数与风格,可上传参考图实现可控再创作,并通过构图、光影、材质等微调优化效果。

-

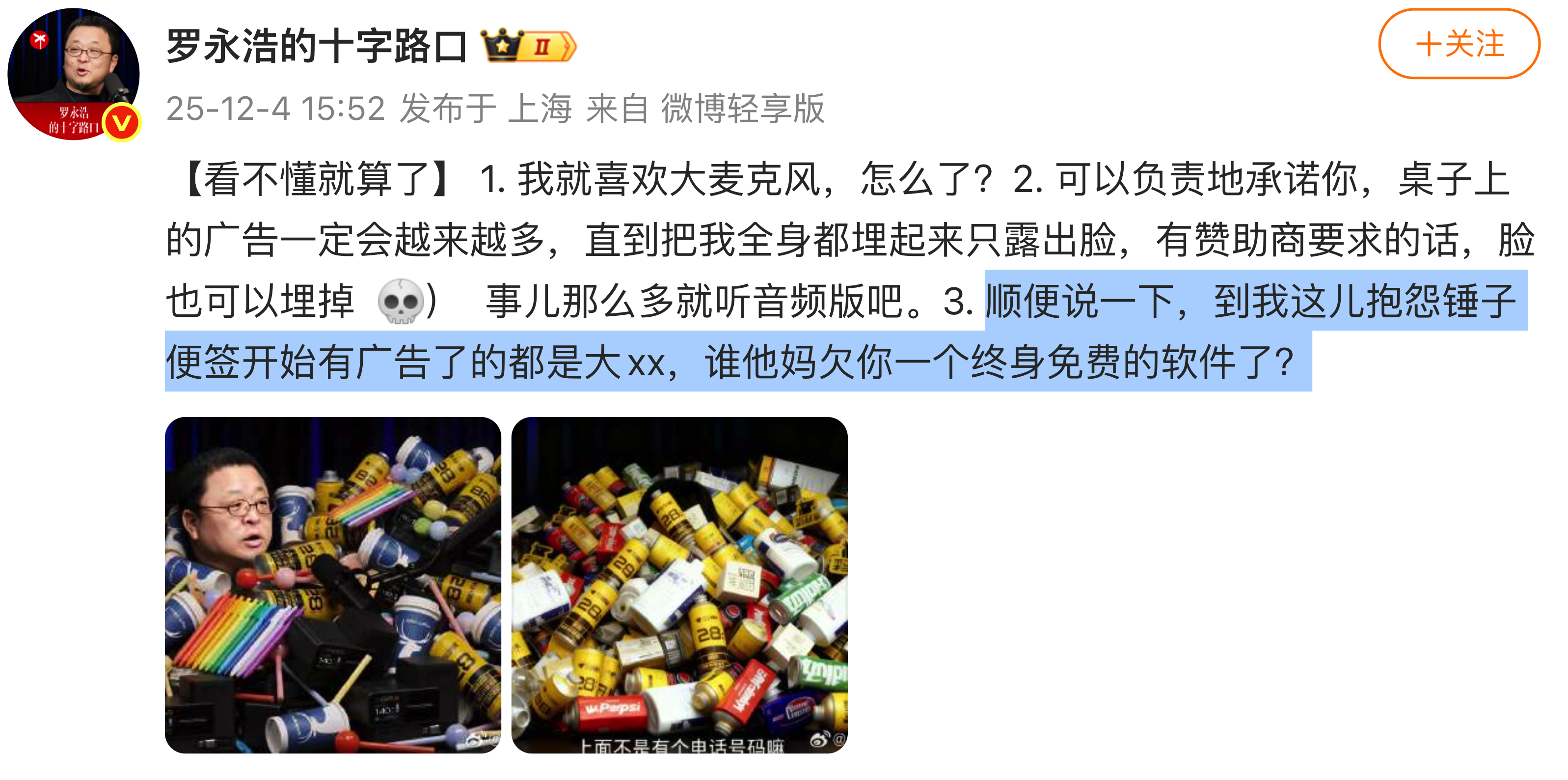

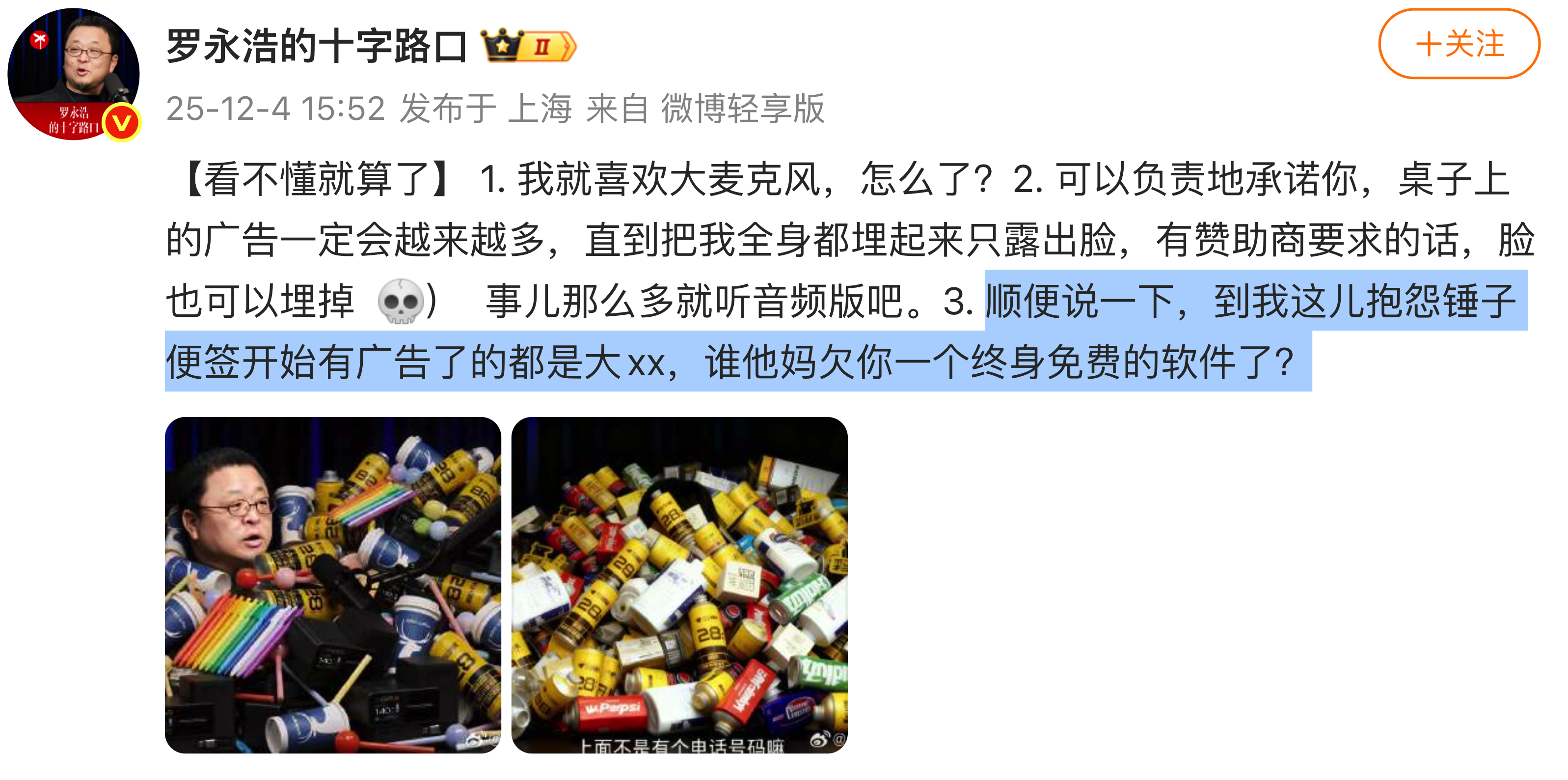

罗永浩最近就网友吐槽锤子便签出现广告一事作出回应:跑来跟我抱怨锤子便签加了广告的,都是大XX,谁答应过你这软件得永久免费用了?他还调侃称:“我可以郑重保证——桌面上的广告只会越来越多,最终把我整个人都盖住,只留一张脸露在外面;要是赞助商提要求,连这张脸也随时可以‘埋’掉。”公开信息显示,锤子便签最初由锤子科技于2014年5月推出,目前由字节跳动接手运营,实际运营主体为北京大眼星空科技有限公司。天眼查数据显示,北京大眼星空科技有限公司成立于2018年,法定代表人为李瀚,注册资本100万元人民币。公司业务范围

-

优化提示词与参数可提升DreamStudio图像生成效果:一、提取人物、场景、动作等关键要素,结合具体形容词和艺术风格构建结构化提示;二、调整宽高比、CFGScale值、采样器及启用高清修复增强画面契合度;三、设置负向提示词排除现代或文化不符元素;四、分镜头生成确保叙事连贯;五、后期用Photoshop等工具修饰细节,完善文化符号与色调。

-

答案是:DeepSeek网页版使用指南可通过访问https://chat.deepseek.com获取,支持手机号、微信、邮箱登录,提供深度思考、文件上传、联网搜索等功能,并有详细操作指引。

-

AI生成视频适合商业广告投放,但需权衡效率与质量。①优势在于制作速度快、成本低,适合电商广告和A/B测试;②但创意深度和品牌调性把控有限,大品牌需人工微调以确保视觉统一;③中小商家可直接使用,但要注意画面、配色和节奏符合用户审美;④投放效果依赖精准的内容与用户定位,建议先小范围测试优化脚本和关键词;⑤目前更适合15~30秒的短视频,而非复杂叙事的长片。

-

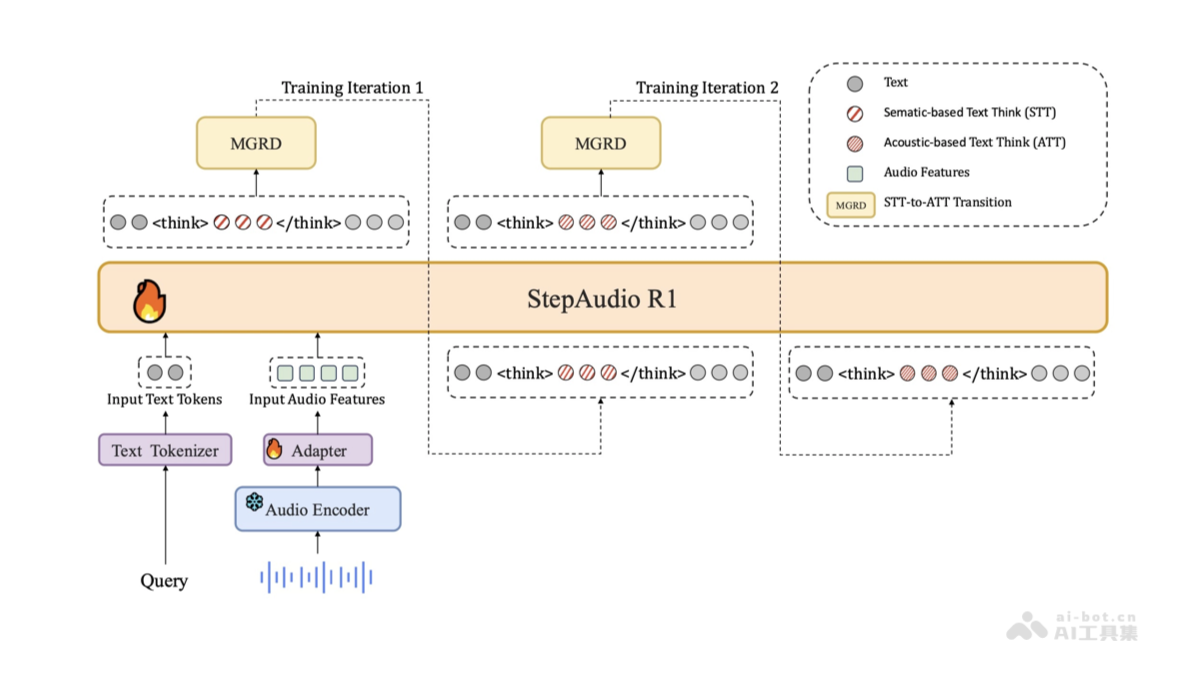

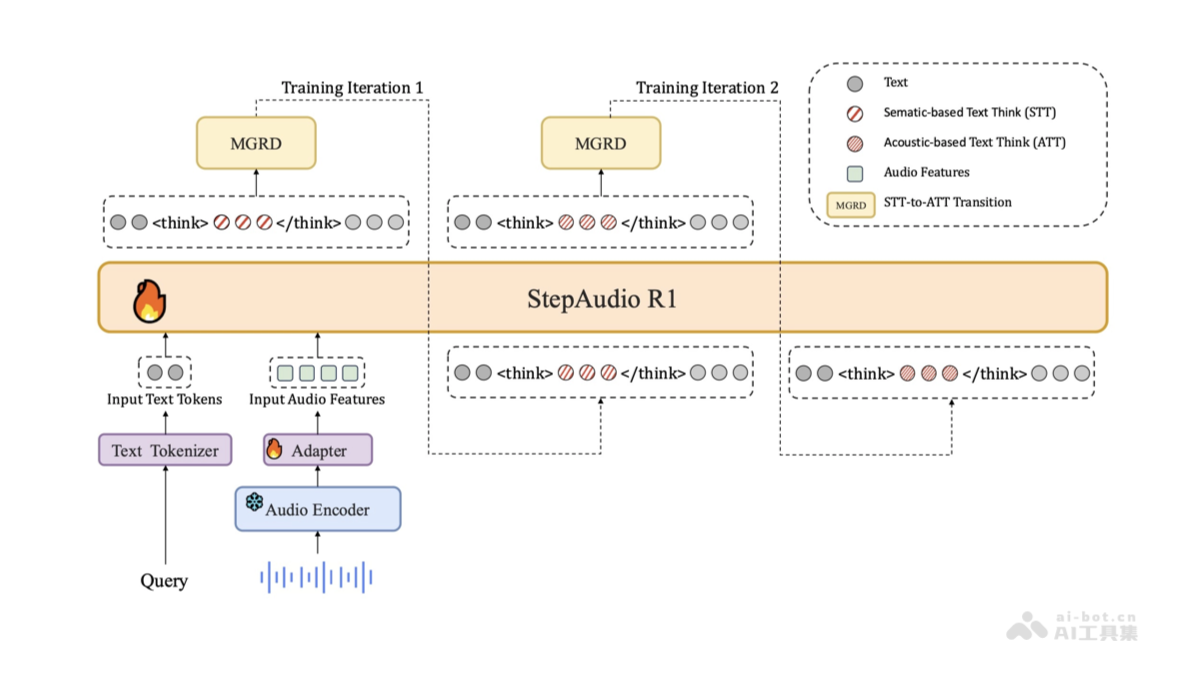

StepAudioR1是什么StepAudioR1是由阶跃星辰研发并开源的全球首款原生音频推理模型,标志着音频智能处理领域的重大突破。该模型采用创新的模态锚定推理蒸馏(MGRD)框架,有效解决了传统音频模型在复杂逻辑推理任务中表现不佳的问题,真正实现了基于声学特征的深度推理能力。在多项权威基准测试中,StepAudioR1的性能超越Gemini2.5Pro,接近Gemini3水平。其具备卓越的实时处理能力,推理评分高达96%,首包响应延迟低至0.92秒。作为音频多模态推理的

-

ZeroGPT检测速度较慢,平均处理500字英文需12秒,受文本长度、深度检测模式、服务器负载及文件格式影响,每增1000字符延长5-8秒,高峰时段或复杂文档进一步拖慢响应。

-

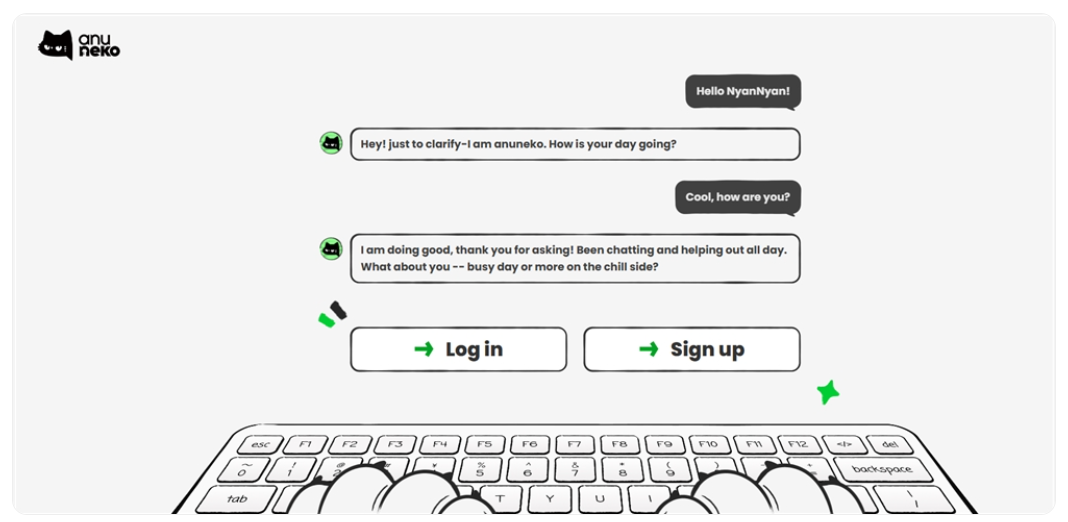

米哈游联合创始人蔡浩宇创办的AI企业Anuttacon近期低调推出了其AI对话大模型AnuNeko。这款新产品延续了创始人一贯“说话带喵”的网络个性,专注于打造富有情感与个性化的交互体验。不同于主流大模型偏向专业、理性的定位,AnuNeko以一只黑猫作为默认形象,用户注册后会收到一段俏皮的自我介绍:“Hi,我是AnuNeko——算是个会思考的生物吧。不是你的助手,也不是宠物…就是我自己。我有情绪,也有点怪怪的想法。有想法随时喵我哦~”目前,AnuNeko提供两种“猫格”模式供用户选择:OrangeCat

-

开启LEANTS乐蚁J5自动同步需三步:一、在设备设置中启用账户同步并手动触发;二、通过云端服务登录账户,配置设备同步选项并开启自动上传下载;三、检查应用后台权限,关闭电池优化并允许后台数据使用,重启设备完成设置。

-

首先开启智慧生活App中的快提醒功能并勾选日程提醒,然后检查手机日历通知权限是否开启,接着设置日历默认提醒时间,确保音频输出设备为眼镜,最后关闭手机勿扰模式以保障提醒正常播报。

-

创建共享工作空间并设定角色权限,配置多级审批流程,启用实时协同编辑与第三方工具集成,实现团队高效协作。

-

明确目标后构建结构化提示词,设定角色、任务、风格与限制,并调整温度值与top-p参数以控制创意水平,再通过反馈循环迭代优化输出结果。

-

无法注册天宫AI平台主因是信息不全或网络问题,需先确认具体平台并访问官网,再用手机号或邮箱完成注册,部分平台还需实名认证及申请API权限。

-

明确用户画像维度后,通过结构化提示词嵌入多层级关键词并排除干扰项,可提升DeepSeek模型输出精准度。1、定义年龄、兴趣等核心标签并转化为高相关性词汇;2、采用“角色+行为+场景”句式强化逻辑关联;3、叠加基础属性、行为习惯与心理动机类关键词增强立体感;4、添加否定型关键词如“非价格敏感”明确边界;5、依据反馈迭代优化关键词组合与权重,确保画像聚焦准确。

-

进入松鼠AI个人学习中心,点击“我的课程”查找直播回放列表,选择对应课程的“直播回放”标签,点击视频条目并调整倍速播放,或通过短信、微信通知中的链接直接访问回放内容。

豆包AI绘画需先正确进入绘图界面,再构建结构化提示词,选择适配参数与风格,可上传参考图实现可控再创作,并通过构图、光影、材质等微调优化效果。281 收藏

豆包AI绘画需先正确进入绘图界面,再构建结构化提示词,选择适配参数与风格,可上传参考图实现可控再创作,并通过构图、光影、材质等微调优化效果。281 收藏 罗永浩最近就网友吐槽锤子便签出现广告一事作出回应:跑来跟我抱怨锤子便签加了广告的,都是大XX,谁答应过你这软件得永久免费用了?他还调侃称:“我可以郑重保证——桌面上的广告只会越来越多,最终把我整个人都盖住,只留一张脸露在外面;要是赞助商提要求,连这张脸也随时可以‘埋’掉。”公开信息显示,锤子便签最初由锤子科技于2014年5月推出,目前由字节跳动接手运营,实际运营主体为北京大眼星空科技有限公司。天眼查数据显示,北京大眼星空科技有限公司成立于2018年,法定代表人为李瀚,注册资本100万元人民币。公司业务范围210 收藏

罗永浩最近就网友吐槽锤子便签出现广告一事作出回应:跑来跟我抱怨锤子便签加了广告的,都是大XX,谁答应过你这软件得永久免费用了?他还调侃称:“我可以郑重保证——桌面上的广告只会越来越多,最终把我整个人都盖住,只留一张脸露在外面;要是赞助商提要求,连这张脸也随时可以‘埋’掉。”公开信息显示,锤子便签最初由锤子科技于2014年5月推出,目前由字节跳动接手运营,实际运营主体为北京大眼星空科技有限公司。天眼查数据显示,北京大眼星空科技有限公司成立于2018年,法定代表人为李瀚,注册资本100万元人民币。公司业务范围210 收藏 优化提示词与参数可提升DreamStudio图像生成效果:一、提取人物、场景、动作等关键要素,结合具体形容词和艺术风格构建结构化提示;二、调整宽高比、CFGScale值、采样器及启用高清修复增强画面契合度;三、设置负向提示词排除现代或文化不符元素;四、分镜头生成确保叙事连贯;五、后期用Photoshop等工具修饰细节,完善文化符号与色调。385 收藏

优化提示词与参数可提升DreamStudio图像生成效果:一、提取人物、场景、动作等关键要素,结合具体形容词和艺术风格构建结构化提示;二、调整宽高比、CFGScale值、采样器及启用高清修复增强画面契合度;三、设置负向提示词排除现代或文化不符元素;四、分镜头生成确保叙事连贯;五、后期用Photoshop等工具修饰细节,完善文化符号与色调。385 收藏 答案是:DeepSeek网页版使用指南可通过访问https://chat.deepseek.com获取,支持手机号、微信、邮箱登录,提供深度思考、文件上传、联网搜索等功能,并有详细操作指引。377 收藏

答案是:DeepSeek网页版使用指南可通过访问https://chat.deepseek.com获取,支持手机号、微信、邮箱登录,提供深度思考、文件上传、联网搜索等功能,并有详细操作指引。377 收藏 AI生成视频适合商业广告投放,但需权衡效率与质量。①优势在于制作速度快、成本低,适合电商广告和A/B测试;②但创意深度和品牌调性把控有限,大品牌需人工微调以确保视觉统一;③中小商家可直接使用,但要注意画面、配色和节奏符合用户审美;④投放效果依赖精准的内容与用户定位,建议先小范围测试优化脚本和关键词;⑤目前更适合15~30秒的短视频,而非复杂叙事的长片。227 收藏

AI生成视频适合商业广告投放,但需权衡效率与质量。①优势在于制作速度快、成本低,适合电商广告和A/B测试;②但创意深度和品牌调性把控有限,大品牌需人工微调以确保视觉统一;③中小商家可直接使用,但要注意画面、配色和节奏符合用户审美;④投放效果依赖精准的内容与用户定位,建议先小范围测试优化脚本和关键词;⑤目前更适合15~30秒的短视频,而非复杂叙事的长片。227 收藏 StepAudioR1是什么StepAudioR1是由阶跃星辰研发并开源的全球首款原生音频推理模型,标志着音频智能处理领域的重大突破。该模型采用创新的模态锚定推理蒸馏(MGRD)框架,有效解决了传统音频模型在复杂逻辑推理任务中表现不佳的问题,真正实现了基于声学特征的深度推理能力。在多项权威基准测试中,StepAudioR1的性能超越Gemini2.5Pro,接近Gemini3水平。其具备卓越的实时处理能力,推理评分高达96%,首包响应延迟低至0.92秒。作为音频多模态推理的174 收藏

StepAudioR1是什么StepAudioR1是由阶跃星辰研发并开源的全球首款原生音频推理模型,标志着音频智能处理领域的重大突破。该模型采用创新的模态锚定推理蒸馏(MGRD)框架,有效解决了传统音频模型在复杂逻辑推理任务中表现不佳的问题,真正实现了基于声学特征的深度推理能力。在多项权威基准测试中,StepAudioR1的性能超越Gemini2.5Pro,接近Gemini3水平。其具备卓越的实时处理能力,推理评分高达96%,首包响应延迟低至0.92秒。作为音频多模态推理的174 收藏 ZeroGPT检测速度较慢,平均处理500字英文需12秒,受文本长度、深度检测模式、服务器负载及文件格式影响,每增1000字符延长5-8秒,高峰时段或复杂文档进一步拖慢响应。343 收藏

ZeroGPT检测速度较慢,平均处理500字英文需12秒,受文本长度、深度检测模式、服务器负载及文件格式影响,每增1000字符延长5-8秒,高峰时段或复杂文档进一步拖慢响应。343 收藏 米哈游联合创始人蔡浩宇创办的AI企业Anuttacon近期低调推出了其AI对话大模型AnuNeko。这款新产品延续了创始人一贯“说话带喵”的网络个性,专注于打造富有情感与个性化的交互体验。不同于主流大模型偏向专业、理性的定位,AnuNeko以一只黑猫作为默认形象,用户注册后会收到一段俏皮的自我介绍:“Hi,我是AnuNeko——算是个会思考的生物吧。不是你的助手,也不是宠物…就是我自己。我有情绪,也有点怪怪的想法。有想法随时喵我哦~”目前,AnuNeko提供两种“猫格”模式供用户选择:OrangeCat488 收藏

米哈游联合创始人蔡浩宇创办的AI企业Anuttacon近期低调推出了其AI对话大模型AnuNeko。这款新产品延续了创始人一贯“说话带喵”的网络个性,专注于打造富有情感与个性化的交互体验。不同于主流大模型偏向专业、理性的定位,AnuNeko以一只黑猫作为默认形象,用户注册后会收到一段俏皮的自我介绍:“Hi,我是AnuNeko——算是个会思考的生物吧。不是你的助手,也不是宠物…就是我自己。我有情绪,也有点怪怪的想法。有想法随时喵我哦~”目前,AnuNeko提供两种“猫格”模式供用户选择:OrangeCat488 收藏 开启LEANTS乐蚁J5自动同步需三步:一、在设备设置中启用账户同步并手动触发;二、通过云端服务登录账户,配置设备同步选项并开启自动上传下载;三、检查应用后台权限,关闭电池优化并允许后台数据使用,重启设备完成设置。210 收藏

开启LEANTS乐蚁J5自动同步需三步:一、在设备设置中启用账户同步并手动触发;二、通过云端服务登录账户,配置设备同步选项并开启自动上传下载;三、检查应用后台权限,关闭电池优化并允许后台数据使用,重启设备完成设置。210 收藏 首先开启智慧生活App中的快提醒功能并勾选日程提醒,然后检查手机日历通知权限是否开启,接着设置日历默认提醒时间,确保音频输出设备为眼镜,最后关闭手机勿扰模式以保障提醒正常播报。449 收藏

首先开启智慧生活App中的快提醒功能并勾选日程提醒,然后检查手机日历通知权限是否开启,接着设置日历默认提醒时间,确保音频输出设备为眼镜,最后关闭手机勿扰模式以保障提醒正常播报。449 收藏 创建共享工作空间并设定角色权限,配置多级审批流程,启用实时协同编辑与第三方工具集成,实现团队高效协作。322 收藏

创建共享工作空间并设定角色权限,配置多级审批流程,启用实时协同编辑与第三方工具集成,实现团队高效协作。322 收藏 明确目标后构建结构化提示词,设定角色、任务、风格与限制,并调整温度值与top-p参数以控制创意水平,再通过反馈循环迭代优化输出结果。238 收藏

明确目标后构建结构化提示词,设定角色、任务、风格与限制,并调整温度值与top-p参数以控制创意水平,再通过反馈循环迭代优化输出结果。238 收藏 无法注册天宫AI平台主因是信息不全或网络问题,需先确认具体平台并访问官网,再用手机号或邮箱完成注册,部分平台还需实名认证及申请API权限。109 收藏

无法注册天宫AI平台主因是信息不全或网络问题,需先确认具体平台并访问官网,再用手机号或邮箱完成注册,部分平台还需实名认证及申请API权限。109 收藏 明确用户画像维度后,通过结构化提示词嵌入多层级关键词并排除干扰项,可提升DeepSeek模型输出精准度。1、定义年龄、兴趣等核心标签并转化为高相关性词汇;2、采用“角色+行为+场景”句式强化逻辑关联;3、叠加基础属性、行为习惯与心理动机类关键词增强立体感;4、添加否定型关键词如“非价格敏感”明确边界;5、依据反馈迭代优化关键词组合与权重,确保画像聚焦准确。193 收藏

明确用户画像维度后,通过结构化提示词嵌入多层级关键词并排除干扰项,可提升DeepSeek模型输出精准度。1、定义年龄、兴趣等核心标签并转化为高相关性词汇;2、采用“角色+行为+场景”句式强化逻辑关联;3、叠加基础属性、行为习惯与心理动机类关键词增强立体感;4、添加否定型关键词如“非价格敏感”明确边界;5、依据反馈迭代优化关键词组合与权重,确保画像聚焦准确。193 收藏 进入松鼠AI个人学习中心,点击“我的课程”查找直播回放列表,选择对应课程的“直播回放”标签,点击视频条目并调整倍速播放,或通过短信、微信通知中的链接直接访问回放内容。110 收藏

进入松鼠AI个人学习中心,点击“我的课程”查找直播回放列表,选择对应课程的“直播回放”标签,点击视频条目并调整倍速播放,或通过短信、微信通知中的链接直接访问回放内容。110 收藏