-

python爬取数据时如何正确导出商品详情到csv中在爬取商品详情并导出到csv文件时,有时会遇到商品详情信息溢出...

-

Python线程池爬虫:数据紊乱问题在使用Python...

-

PythonAI和区块链:一场闹剧还是一场革命?关于Python人工智能(AI)...

-

C++与Python混编の実现方在算法解决方案中,混编不同的语言可以充分利用其各自优势。本文探讨c++与python的混编...

-

JWT多帐号登录:如何使旧令牌失效?JWT(JSONWeb...

-

用换行符写入列表到文件通过使用writelines()...

-

如何在MinIOPythonSDK中判断对象是否存在?虽然「pythonminiodetermineswhetheranobjectexists」的Google...

-

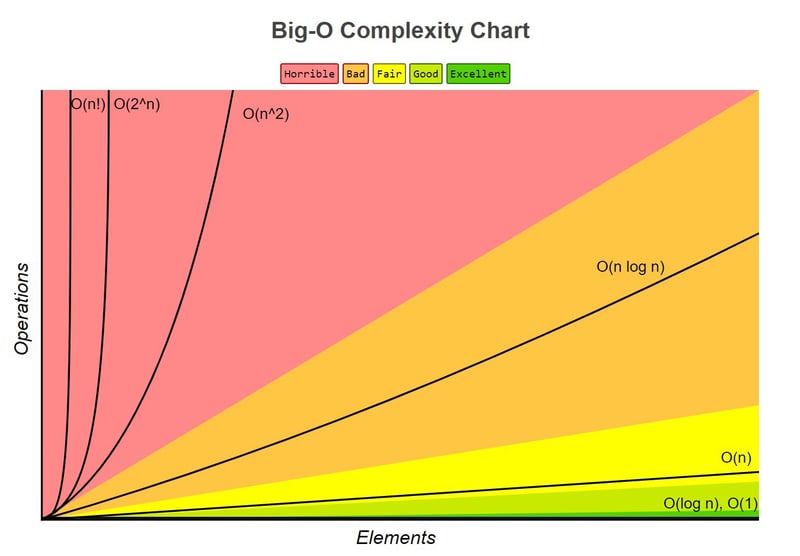

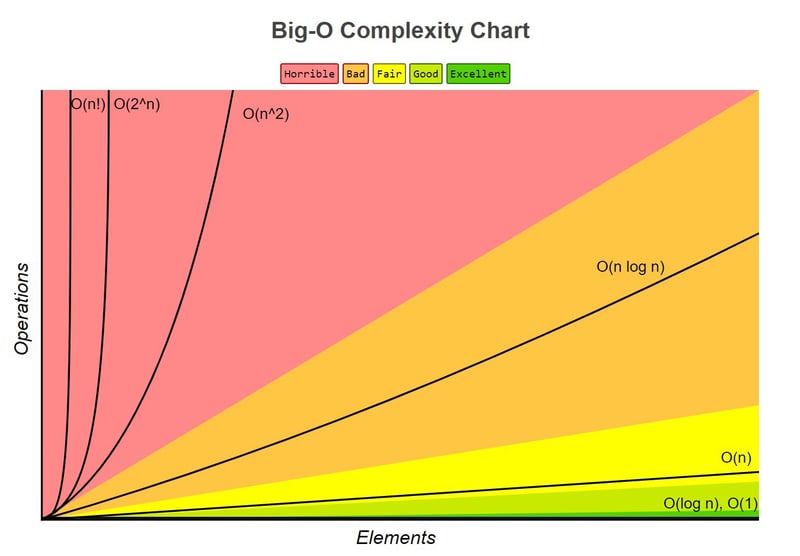

1.定义描述算法执行时间或空间使用上限的数学符号。它表示为o(f(n)),其中f(n)是一个函数,将时间或空间表示为输入n大小的函数.更多信息请访问:http://bigocheatsheet.com2.目的算法比较:允许您比较不同的算法并针对给定问题选择最有效的算法。可扩展性:帮助预测当数据量增加时算法的行为方式。3.复杂度分析最坏情况:指算法耗时更长或使用更多资源的场景。大o通常指的是这种情况。最佳情况和平均情况:虽然很重要,但它们在大o表示法中使用频率较低。4.空间与空间时间时间复杂度:指算法执行所

-

Python幂运算顺序:从右到左在Python中,多个数进行幂运算时,计算顺序是从右到左。例如,3**4**5等于...

-

程序员的代码命名技巧:写出易于理解的代码我们经常编写代码,却很少认真思考代码命名。好的代码命名如同清晰的文档,让代码易于理解和维护。为什么代码命名如此重要?想象一下,一个房间里所有物品都标注为“东西1”、“东西2”……混乱不堪!糟糕的代码命名也会让其他开发者(甚至未来的你)感到困惑。错误示范:deff(x,y):returnx*y改进版本:def计算矩形面积(长,宽):return长*宽区别显而易见,改进后的版本清晰地说明了代码的功能。好的代码命名应该解答以下三个问题:代码的功能是什么?代码存在的意义是什

-

我一直想摆脱第三方博客平台,拥有自己的独立博客。经过一番努力,我终于实现了这个目标!之前一直困扰我的问题主要有两个:网站托管和框架选择。过去我曾使用WordPress,但现在我已经不再依赖PHP了,而且WordPress对我来说过于复杂。我偏爱Django和Python,本想用它们来搭建博客,但又不想支付托管费用。我使用GitHubPages,之前的网站是用React构建的,但我更想尝试一个免JavaScript的静态网站。最终,我找到了一个简单的解决方案:DjangoDistill。它可以将Django

-

开启我的编程学习日志!我将记录我的编码学习历程,分享项目成果,并与大家一起成长。为何踏上这段旅程?我是一名全职数据分析师,也是三个孩子的父亲。日常工作中大量使用定性和定量分析方法,为了提升技能,我决定重拾编码热情,学习Python正是将专业知识与新技能结合的绝佳途径。这个博客记录了我学习过程中的心得体会,也希望能与同样学习Python的朋友们分享经验。Python之禅:编码哲学学习Python的第一步便是领悟“Python之禅”,这套原则精辟地概括了Python的设计理念。

-

本文介绍如何使用Docker构建镜像,并从GCPArtifactRegistry安装私有Python包,避免将敏感的服务帐户密钥直接放入镜像中。您已开发一个内部使用的Python包,并希望将其发布到GCPArtifactRegistry,而不是PyPI。本文提供了一种安全的方案,避免在Docker镜像中直接包含服务帐户密钥文件。包发布:使用Poetry发布包到ArtifactRegistry:poetrysourceadd--priority=supplementalgcp

-

Mac电脑上安装Pandas和NumPy时报错的原因探究安装Pandas和NumPy时遇到报错,让人头疼不已。特别是在Mac系统上,一�...

-

文章介绍了Python数值字段异常值处理方法。1.使用箱线图直观识别离群点;2.利用Z-score方法,基于标准差判断异常值;3.使用IQR方法,基于四分位距识别异常值,该方法对数据分布不敏感。处理策略包括删除、替换和转换,需结合实际情况选择。需注意阈值选择、数据分布和异常值类型,最终选择合适的策略取决于数据和任务。

python爬取数据时如何正确导出商品详情到csv中在爬取商品详情并导出到csv文件时,有时会遇到商品详情信息溢出...483 收藏

python爬取数据时如何正确导出商品详情到csv中在爬取商品详情并导出到csv文件时,有时会遇到商品详情信息溢出...483 收藏 Python线程池爬虫:数据紊乱问题在使用Python...483 收藏

Python线程池爬虫:数据紊乱问题在使用Python...483 收藏 PythonAI和区块链:一场闹剧还是一场革命?关于Python人工智能(AI)...483 收藏

PythonAI和区块链:一场闹剧还是一场革命?关于Python人工智能(AI)...483 收藏 C++与Python混编の実现方在算法解决方案中,混编不同的语言可以充分利用其各自优势。本文探讨c++与python的混编...483 收藏

C++与Python混编の実现方在算法解决方案中,混编不同的语言可以充分利用其各自优势。本文探讨c++与python的混编...483 收藏 JWT多帐号登录:如何使旧令牌失效?JWT(JSONWeb...483 收藏

JWT多帐号登录:如何使旧令牌失效?JWT(JSONWeb...483 收藏 用换行符写入列表到文件通过使用writelines()...483 收藏

用换行符写入列表到文件通过使用writelines()...483 收藏 如何在MinIOPythonSDK中判断对象是否存在?虽然「pythonminiodetermineswhetheranobjectexists」的Google...483 收藏

如何在MinIOPythonSDK中判断对象是否存在?虽然「pythonminiodetermineswhetheranobjectexists」的Google...483 收藏 1.定义描述算法执行时间或空间使用上限的数学符号。它表示为o(f(n)),其中f(n)是一个函数,将时间或空间表示为输入n大小的函数.更多信息请访问:http://bigocheatsheet.com2.目的算法比较:允许您比较不同的算法并针对给定问题选择最有效的算法。可扩展性:帮助预测当数据量增加时算法的行为方式。3.复杂度分析最坏情况:指算法耗时更长或使用更多资源的场景。大o通常指的是这种情况。最佳情况和平均情况:虽然很重要,但它们在大o表示法中使用频率较低。4.空间与空间时间时间复杂度:指算法执行所483 收藏

1.定义描述算法执行时间或空间使用上限的数学符号。它表示为o(f(n)),其中f(n)是一个函数,将时间或空间表示为输入n大小的函数.更多信息请访问:http://bigocheatsheet.com2.目的算法比较:允许您比较不同的算法并针对给定问题选择最有效的算法。可扩展性:帮助预测当数据量增加时算法的行为方式。3.复杂度分析最坏情况:指算法耗时更长或使用更多资源的场景。大o通常指的是这种情况。最佳情况和平均情况:虽然很重要,但它们在大o表示法中使用频率较低。4.空间与空间时间时间复杂度:指算法执行所483 收藏 Python幂运算顺序:从右到左在Python中,多个数进行幂运算时,计算顺序是从右到左。例如,3**4**5等于...483 收藏

Python幂运算顺序:从右到左在Python中,多个数进行幂运算时,计算顺序是从右到左。例如,3**4**5等于...483 收藏 程序员的代码命名技巧:写出易于理解的代码我们经常编写代码,却很少认真思考代码命名。好的代码命名如同清晰的文档,让代码易于理解和维护。为什么代码命名如此重要?想象一下,一个房间里所有物品都标注为“东西1”、“东西2”……混乱不堪!糟糕的代码命名也会让其他开发者(甚至未来的你)感到困惑。错误示范:deff(x,y):returnx*y改进版本:def计算矩形面积(长,宽):return长*宽区别显而易见,改进后的版本清晰地说明了代码的功能。好的代码命名应该解答以下三个问题:代码的功能是什么?代码存在的意义是什483 收藏

程序员的代码命名技巧:写出易于理解的代码我们经常编写代码,却很少认真思考代码命名。好的代码命名如同清晰的文档,让代码易于理解和维护。为什么代码命名如此重要?想象一下,一个房间里所有物品都标注为“东西1”、“东西2”……混乱不堪!糟糕的代码命名也会让其他开发者(甚至未来的你)感到困惑。错误示范:deff(x,y):returnx*y改进版本:def计算矩形面积(长,宽):return长*宽区别显而易见,改进后的版本清晰地说明了代码的功能。好的代码命名应该解答以下三个问题:代码的功能是什么?代码存在的意义是什483 收藏 我一直想摆脱第三方博客平台,拥有自己的独立博客。经过一番努力,我终于实现了这个目标!之前一直困扰我的问题主要有两个:网站托管和框架选择。过去我曾使用WordPress,但现在我已经不再依赖PHP了,而且WordPress对我来说过于复杂。我偏爱Django和Python,本想用它们来搭建博客,但又不想支付托管费用。我使用GitHubPages,之前的网站是用React构建的,但我更想尝试一个免JavaScript的静态网站。最终,我找到了一个简单的解决方案:DjangoDistill。它可以将Django483 收藏

我一直想摆脱第三方博客平台,拥有自己的独立博客。经过一番努力,我终于实现了这个目标!之前一直困扰我的问题主要有两个:网站托管和框架选择。过去我曾使用WordPress,但现在我已经不再依赖PHP了,而且WordPress对我来说过于复杂。我偏爱Django和Python,本想用它们来搭建博客,但又不想支付托管费用。我使用GitHubPages,之前的网站是用React构建的,但我更想尝试一个免JavaScript的静态网站。最终,我找到了一个简单的解决方案:DjangoDistill。它可以将Django483 收藏 开启我的编程学习日志!我将记录我的编码学习历程,分享项目成果,并与大家一起成长。为何踏上这段旅程?我是一名全职数据分析师,也是三个孩子的父亲。日常工作中大量使用定性和定量分析方法,为了提升技能,我决定重拾编码热情,学习Python正是将专业知识与新技能结合的绝佳途径。这个博客记录了我学习过程中的心得体会,也希望能与同样学习Python的朋友们分享经验。Python之禅:编码哲学学习Python的第一步便是领悟“Python之禅”,这套原则精辟地概括了Python的设计理念。483 收藏

开启我的编程学习日志!我将记录我的编码学习历程,分享项目成果,并与大家一起成长。为何踏上这段旅程?我是一名全职数据分析师,也是三个孩子的父亲。日常工作中大量使用定性和定量分析方法,为了提升技能,我决定重拾编码热情,学习Python正是将专业知识与新技能结合的绝佳途径。这个博客记录了我学习过程中的心得体会,也希望能与同样学习Python的朋友们分享经验。Python之禅:编码哲学学习Python的第一步便是领悟“Python之禅”,这套原则精辟地概括了Python的设计理念。483 收藏 本文介绍如何使用Docker构建镜像,并从GCPArtifactRegistry安装私有Python包,避免将敏感的服务帐户密钥直接放入镜像中。您已开发一个内部使用的Python包,并希望将其发布到GCPArtifactRegistry,而不是PyPI。本文提供了一种安全的方案,避免在Docker镜像中直接包含服务帐户密钥文件。包发布:使用Poetry发布包到ArtifactRegistry:poetrysourceadd--priority=supplementalgcp483 收藏

本文介绍如何使用Docker构建镜像,并从GCPArtifactRegistry安装私有Python包,避免将敏感的服务帐户密钥直接放入镜像中。您已开发一个内部使用的Python包,并希望将其发布到GCPArtifactRegistry,而不是PyPI。本文提供了一种安全的方案,避免在Docker镜像中直接包含服务帐户密钥文件。包发布:使用Poetry发布包到ArtifactRegistry:poetrysourceadd--priority=supplementalgcp483 收藏 Mac电脑上安装Pandas和NumPy时报错的原因探究安装Pandas和NumPy时遇到报错,让人头疼不已。特别是在Mac系统上,一�...483 收藏

Mac电脑上安装Pandas和NumPy时报错的原因探究安装Pandas和NumPy时遇到报错,让人头疼不已。特别是在Mac系统上,一�...483 收藏 文章介绍了Python数值字段异常值处理方法。1.使用箱线图直观识别离群点;2.利用Z-score方法,基于标准差判断异常值;3.使用IQR方法,基于四分位距识别异常值,该方法对数据分布不敏感。处理策略包括删除、替换和转换,需结合实际情况选择。需注意阈值选择、数据分布和异常值类型,最终选择合适的策略取决于数据和任务。483 收藏

文章介绍了Python数值字段异常值处理方法。1.使用箱线图直观识别离群点;2.利用Z-score方法,基于标准差判断异常值;3.使用IQR方法,基于四分位距识别异常值,该方法对数据分布不敏感。处理策略包括删除、替换和转换,需结合实际情况选择。需注意阈值选择、数据分布和异常值类型,最终选择合适的策略取决于数据和任务。483 收藏