-

豆包AI可通过五种方法将普通照片转为高度拟真的真人风格图像:一、“真人感增强”指令法;二、以图生图+高相似度控制;三、分层指令叠加法;四、证件照级专用流程;五、中文文字融合技巧。

-

LEANTS乐蚁J5不支持安装应用,需通过手机蓝牙设置查看已连接设备信息,进入手机蓝牙详情页可查看可交互应用列表;下载官方App可管理设备服务权限与使用记录;在手机系统中审查蓝牙权限可控制应用访问;长按眼镜按键重置蓝牙可清除所有配对记录。

-

未正确调用Pika1.5的AI物理模拟特效系统会导致视频缺乏动态物理效果与趣味性,需通过Pikaffects库点击应用、基础指令+特效关键词、参数命令精准控制、图+文+参数混合触发或新道具植入五种方法激活。

-

AI驱动会议室预订通过四步实现:一、集成日历API实时检测冲突;二、规则引擎自动推荐合规会议室;三、自然语言交互式预订闭环;四、实时监听变更并主动干预冲突。

-

若MurfAI语音生硬呆板,需用提示词强化语音表现力:一、加语速与停顿控制词;二、注入语气情绪修饰语;三、指定角色身份特征;四、嵌入口语化标记;五、调整标点功能权重。

-

若缺乏系统性数据采集与结构化输出能力,则需建立标准化竞品抓取路径与对比维度框架:明确目标与竞品范围、多源交叉采集信息、构建三级评分对比矩阵、验证差异化价值主张、生成带数据溯源的可视化草稿。

-

雷鸟Air1S固件更新失败需按三路径处理:一、电脑Chrome浏览器升级(推荐),二、雷鸟XRAPP手机升级(备用),三、强制恢复出厂固件(异常时使用)。

-

松鼠AI官方教育网址入口是https://www.squirrelai.com,该平台提供个性化学习路径规划、融合真人教师辅导,并拥有覆盖小初高阶段的多元课程资源体系。

-

苹果用户可通过三种方法快速启用DeepSeek:一、iPhone用户可直接通过Safari浏览器访问官网使用网页版,无需下载应用,适合日常便捷使用;二、Mac用户可选择Ollama或LMStudio工具本地部署模型,提升隐私性和稳定性,适合深度用户;三、需注意设备系统版本、存储空间及网络环境等前提条件,确保操作顺利。

-

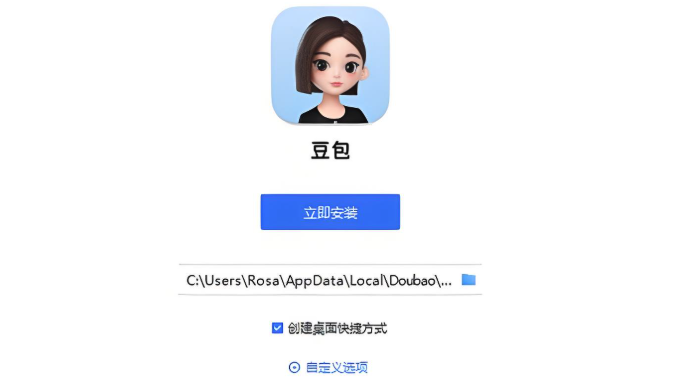

豆包AI智能体是用户自定义角色、知识与风格的专属AI对话实体,需通过“我的→+创建机器人”或复制模板创建,设置名称、头像、角色描述,上传知识并训练后测试调试。

-

知网AIGC查重需通过唯一官方入口https://cx.cnki.net,注册登录后上传Word或PDF文件(≤10万字),按2元/千字符计费,10分钟出报告,提供简洁版与全文版两种结果,总AIGC率为加权平均值,用于评估AI参与度,建议用户防范仿冒网站并结合人工判断结果。

-

明确目标后,通过提问式引导、分类拓展、反向思维与多轮迭代,利用Claude生成多样化创意内容。首先设定主题与背景,获取初步方向;接着以开放式问题激发创新,从不同视角深化构想;再按维度拆解主题,系统产出各类示例并交叉组合;随后设想失败方案,逆向重构独特创意;最后通过多轮对话持续优化,聚焦细节与传播性,逐步完善创意成果。

-

82岁的德国豪华汽车品牌保时捷监事会主席沃尔夫冈·保时捷近日在奥地利萨尔茨堡低调完婚,迎娶62岁的长期伴侣加布里埃拉·祖·莱宁根,正式开启人生第四段婚姻。当地时间12月7日,保时捷官方发言人克里斯蒂安·舍尔茨证实了这一消息,并强调婚礼以私密形式举行,未对外公开具体流程与细节。发言人同时呼吁公众给予新人充分空间,尊重其个人生活边界。布里埃拉·祖·莱宁根和沃尔夫冈·保时捷作为保时捷创始人费迪南德·保时捷的嫡孙,沃尔夫冈自2007年起执掌保时捷股份公司监事会,主导高层人事任命与战略监督。他与其家族亦通过控股架构

-

首先注册登录AI志愿助手App,搜索并加入环保打卡活动,每日上传环保行为记录,坚持打卡可获积分与奖励。

-

OpenAI推出教学提示词模板,帮助教师高效利用ChatGPT开展课程设计、差异化教学、作业评估与课堂互动。1.明确角色、任务、格式与受众可生成适配的教案与内容;2.通过标注学生水平实现分层任务定制;3.辅助撰写评语与评分标准提升反馈效率;4.预设学生疑问解答增强教学应变。模板强调结构化提示设计,助力教师精准获取资源,推动AI融入教育实践。

豆包AI可通过五种方法将普通照片转为高度拟真的真人风格图像:一、“真人感增强”指令法;二、以图生图+高相似度控制;三、分层指令叠加法;四、证件照级专用流程;五、中文文字融合技巧。322 收藏

豆包AI可通过五种方法将普通照片转为高度拟真的真人风格图像:一、“真人感增强”指令法;二、以图生图+高相似度控制;三、分层指令叠加法;四、证件照级专用流程;五、中文文字融合技巧。322 收藏 LEANTS乐蚁J5不支持安装应用,需通过手机蓝牙设置查看已连接设备信息,进入手机蓝牙详情页可查看可交互应用列表;下载官方App可管理设备服务权限与使用记录;在手机系统中审查蓝牙权限可控制应用访问;长按眼镜按键重置蓝牙可清除所有配对记录。322 收藏

LEANTS乐蚁J5不支持安装应用,需通过手机蓝牙设置查看已连接设备信息,进入手机蓝牙详情页可查看可交互应用列表;下载官方App可管理设备服务权限与使用记录;在手机系统中审查蓝牙权限可控制应用访问;长按眼镜按键重置蓝牙可清除所有配对记录。322 收藏 未正确调用Pika1.5的AI物理模拟特效系统会导致视频缺乏动态物理效果与趣味性,需通过Pikaffects库点击应用、基础指令+特效关键词、参数命令精准控制、图+文+参数混合触发或新道具植入五种方法激活。322 收藏

未正确调用Pika1.5的AI物理模拟特效系统会导致视频缺乏动态物理效果与趣味性,需通过Pikaffects库点击应用、基础指令+特效关键词、参数命令精准控制、图+文+参数混合触发或新道具植入五种方法激活。322 收藏 AI驱动会议室预订通过四步实现:一、集成日历API实时检测冲突;二、规则引擎自动推荐合规会议室;三、自然语言交互式预订闭环;四、实时监听变更并主动干预冲突。322 收藏

AI驱动会议室预订通过四步实现:一、集成日历API实时检测冲突;二、规则引擎自动推荐合规会议室;三、自然语言交互式预订闭环;四、实时监听变更并主动干预冲突。322 收藏 若MurfAI语音生硬呆板,需用提示词强化语音表现力:一、加语速与停顿控制词;二、注入语气情绪修饰语;三、指定角色身份特征;四、嵌入口语化标记;五、调整标点功能权重。322 收藏

若MurfAI语音生硬呆板,需用提示词强化语音表现力:一、加语速与停顿控制词;二、注入语气情绪修饰语;三、指定角色身份特征;四、嵌入口语化标记;五、调整标点功能权重。322 收藏 若缺乏系统性数据采集与结构化输出能力,则需建立标准化竞品抓取路径与对比维度框架:明确目标与竞品范围、多源交叉采集信息、构建三级评分对比矩阵、验证差异化价值主张、生成带数据溯源的可视化草稿。322 收藏

若缺乏系统性数据采集与结构化输出能力,则需建立标准化竞品抓取路径与对比维度框架:明确目标与竞品范围、多源交叉采集信息、构建三级评分对比矩阵、验证差异化价值主张、生成带数据溯源的可视化草稿。322 收藏 雷鸟Air1S固件更新失败需按三路径处理:一、电脑Chrome浏览器升级(推荐),二、雷鸟XRAPP手机升级(备用),三、强制恢复出厂固件(异常时使用)。322 收藏

雷鸟Air1S固件更新失败需按三路径处理:一、电脑Chrome浏览器升级(推荐),二、雷鸟XRAPP手机升级(备用),三、强制恢复出厂固件(异常时使用)。322 收藏 松鼠AI官方教育网址入口是https://www.squirrelai.com,该平台提供个性化学习路径规划、融合真人教师辅导,并拥有覆盖小初高阶段的多元课程资源体系。321 收藏

松鼠AI官方教育网址入口是https://www.squirrelai.com,该平台提供个性化学习路径规划、融合真人教师辅导,并拥有覆盖小初高阶段的多元课程资源体系。321 收藏 苹果用户可通过三种方法快速启用DeepSeek:一、iPhone用户可直接通过Safari浏览器访问官网使用网页版,无需下载应用,适合日常便捷使用;二、Mac用户可选择Ollama或LMStudio工具本地部署模型,提升隐私性和稳定性,适合深度用户;三、需注意设备系统版本、存储空间及网络环境等前提条件,确保操作顺利。321 收藏

苹果用户可通过三种方法快速启用DeepSeek:一、iPhone用户可直接通过Safari浏览器访问官网使用网页版,无需下载应用,适合日常便捷使用;二、Mac用户可选择Ollama或LMStudio工具本地部署模型,提升隐私性和稳定性,适合深度用户;三、需注意设备系统版本、存储空间及网络环境等前提条件,确保操作顺利。321 收藏 豆包AI智能体是用户自定义角色、知识与风格的专属AI对话实体,需通过“我的→+创建机器人”或复制模板创建,设置名称、头像、角色描述,上传知识并训练后测试调试。321 收藏

豆包AI智能体是用户自定义角色、知识与风格的专属AI对话实体,需通过“我的→+创建机器人”或复制模板创建,设置名称、头像、角色描述,上传知识并训练后测试调试。321 收藏 知网AIGC查重需通过唯一官方入口https://cx.cnki.net,注册登录后上传Word或PDF文件(≤10万字),按2元/千字符计费,10分钟出报告,提供简洁版与全文版两种结果,总AIGC率为加权平均值,用于评估AI参与度,建议用户防范仿冒网站并结合人工判断结果。321 收藏

知网AIGC查重需通过唯一官方入口https://cx.cnki.net,注册登录后上传Word或PDF文件(≤10万字),按2元/千字符计费,10分钟出报告,提供简洁版与全文版两种结果,总AIGC率为加权平均值,用于评估AI参与度,建议用户防范仿冒网站并结合人工判断结果。321 收藏 明确目标后,通过提问式引导、分类拓展、反向思维与多轮迭代,利用Claude生成多样化创意内容。首先设定主题与背景,获取初步方向;接着以开放式问题激发创新,从不同视角深化构想;再按维度拆解主题,系统产出各类示例并交叉组合;随后设想失败方案,逆向重构独特创意;最后通过多轮对话持续优化,聚焦细节与传播性,逐步完善创意成果。321 收藏

明确目标后,通过提问式引导、分类拓展、反向思维与多轮迭代,利用Claude生成多样化创意内容。首先设定主题与背景,获取初步方向;接着以开放式问题激发创新,从不同视角深化构想;再按维度拆解主题,系统产出各类示例并交叉组合;随后设想失败方案,逆向重构独特创意;最后通过多轮对话持续优化,聚焦细节与传播性,逐步完善创意成果。321 收藏 82岁的德国豪华汽车品牌保时捷监事会主席沃尔夫冈·保时捷近日在奥地利萨尔茨堡低调完婚,迎娶62岁的长期伴侣加布里埃拉·祖·莱宁根,正式开启人生第四段婚姻。当地时间12月7日,保时捷官方发言人克里斯蒂安·舍尔茨证实了这一消息,并强调婚礼以私密形式举行,未对外公开具体流程与细节。发言人同时呼吁公众给予新人充分空间,尊重其个人生活边界。布里埃拉·祖·莱宁根和沃尔夫冈·保时捷作为保时捷创始人费迪南德·保时捷的嫡孙,沃尔夫冈自2007年起执掌保时捷股份公司监事会,主导高层人事任命与战略监督。他与其家族亦通过控股架构321 收藏

82岁的德国豪华汽车品牌保时捷监事会主席沃尔夫冈·保时捷近日在奥地利萨尔茨堡低调完婚,迎娶62岁的长期伴侣加布里埃拉·祖·莱宁根,正式开启人生第四段婚姻。当地时间12月7日,保时捷官方发言人克里斯蒂安·舍尔茨证实了这一消息,并强调婚礼以私密形式举行,未对外公开具体流程与细节。发言人同时呼吁公众给予新人充分空间,尊重其个人生活边界。布里埃拉·祖·莱宁根和沃尔夫冈·保时捷作为保时捷创始人费迪南德·保时捷的嫡孙,沃尔夫冈自2007年起执掌保时捷股份公司监事会,主导高层人事任命与战略监督。他与其家族亦通过控股架构321 收藏 首先注册登录AI志愿助手App,搜索并加入环保打卡活动,每日上传环保行为记录,坚持打卡可获积分与奖励。321 收藏

首先注册登录AI志愿助手App,搜索并加入环保打卡活动,每日上传环保行为记录,坚持打卡可获积分与奖励。321 收藏 OpenAI推出教学提示词模板,帮助教师高效利用ChatGPT开展课程设计、差异化教学、作业评估与课堂互动。1.明确角色、任务、格式与受众可生成适配的教案与内容;2.通过标注学生水平实现分层任务定制;3.辅助撰写评语与评分标准提升反馈效率;4.预设学生疑问解答增强教学应变。模板强调结构化提示设计,助力教师精准获取资源,推动AI融入教育实践。321 收藏

OpenAI推出教学提示词模板,帮助教师高效利用ChatGPT开展课程设计、差异化教学、作业评估与课堂互动。1.明确角色、任务、格式与受众可生成适配的教案与内容;2.通过标注学生水平实现分层任务定制;3.辅助撰写评语与评分标准提升反馈效率;4.预设学生疑问解答增强教学应变。模板强调结构化提示设计,助力教师精准获取资源,推动AI融入教育实践。321 收藏