-

无需登录直接下载的AI图片生成工具在2025年仍是效率首选,如Artbreeder部分功能、DeepDreamGenerator免费版、Fotor限时活动、在线StableDiffusion镜像站、RunDiffusion特定模型、NightCafe免费积分、Clipdrop部分功能、Hotpot.ai简易工具、Craiyon及本地部署的DreamBoothAI;这些工具虽便捷,但存在隐私与安全风险,且生成质量依赖提示词精准度与后期处理,无法取代专业设计,仅作为辅助创意工具。

-

11月5日,问界汽车宣布其全系车型正式接入“出厂即查验”服务,全国范围内的购车用户将无需再前往车管所排队验车,可通过线上流程直接完成车辆登记与上牌。问界汽车自2025年11月起,问界用户中心的“一站式上牌”服务将进一步扩展。目前,已有36个城市的支持门店提供该项服务,包括北京、上海、广州、深圳、成都、武汉等一线及新一线城市。用户在提车当日即可通过“交管12123”APP在线选号并办理牌证业务,最快1小时内便可完成全部流程。此举大幅压缩了从购车到合法上路的时间成本,部分区域更实现了“一次都不用跑”的全流程网

-

投喂AI最新官方访问地址为https://www.p2hp.com,该平台集成多种AI工具,支持自然语言指令、快速文本生成与多格式内容输出,页面简洁且无需注册即可使用基础功能。

-

使用豆包AI生成JavaScript代码的关键在于明确需求、提供清晰指令并进行结果优化。一要明确具体功能,如表单验证或DOM操作,避免模糊提问;二要用结构化的中文指令,如“请用JavaScript写一个函数用来……”,并可添加兼容性等限制条件;三要检查生成代码的逻辑与语法,结合浏览器测试进行调整。实际应用包括生成随机颜色值、表格排序、倒计时等功能。

-

腾讯AI官网链接为https://ai.tencent.com/,该平台集成多模态内容生成、语音处理、OCR识别及人脸识别等功能,提供详尽API文档与SDK工具包,支持金融、教育、政务等场景的智能化应用。

-

即梦AI可解析梦境中的象征意义,通过输入梦境内容提取关键词、分析情绪曲线、关联多梦主题并生成PDF报告。用户在三星GalaxyS24(Android14)运行该应用,依次完成梦境记录上传、查看关键词云、标注情感标签、开启跨梦境分析,最终导出结构化解析报告,辅助理解潜意识心理象征。

-

答案是https://www.vidu.studio/,该平台支持文本一键生成高清视频,基于U-ViT架构可输出16秒以上连贯画面,具备高动态与场景一致性控制,提供1080P画质,适用于品牌宣传、社交媒体、活动预热及知识类视频创作,界面简洁、中文理解强、多风格可选且无需下载云端完成。

-

要让豆包AI有效优化Python算法性能,关键在于明确问题、提供具体代码和上下文,并通过多次追问细化优化点。首先,明确优化方向,如减少运行时间、降低内存占用或提升可读性;其次,给出具体的函数、数据规模及性能瓶颈信息,而非模糊描述;接着,通过逐步追问探索多种优化可能,如列表推导式、生成器或NumPy的使用;最后,结合基础工具如timeit、cProfile定位瓶颈,并掌握高效数据结构与算法思路,才能真正发挥AI辅助作用。

-

使用明确节日关键词、文化地域特征、艺术风格参数及光照色彩描述,可精准生成Midjourney节日图像。例如输入“ChineseNewYearcelebrationwithredlanternsandfireworksinBeijing,digitalpainting--v6--ar16:9”,能呈现具叙事性与视觉冲击力的春节场景。

-

豆包AI大模型在数据迁移中可通过自然语言处理与智能生成提升效率,具体操作包括:1.数据预处理时解析非结构化内容并结构化关键字段;2.利用AI迁移工具自动执行结构映射并生成字段匹配建议;3.通过分析日志实现异常检测与自动生成修复建议;4.构建标准化流程并管理提示词模板,将AI能力封装为模块,减少人工干预,提升迁移智能化水平。

-

Gemini2.5网页端官方入口为https://gemini.google.com,登录Google账号即可使用;国内用户可尝试https://chat.lanjingai.org或https://xsimplechat.com镜像站点访问。

-

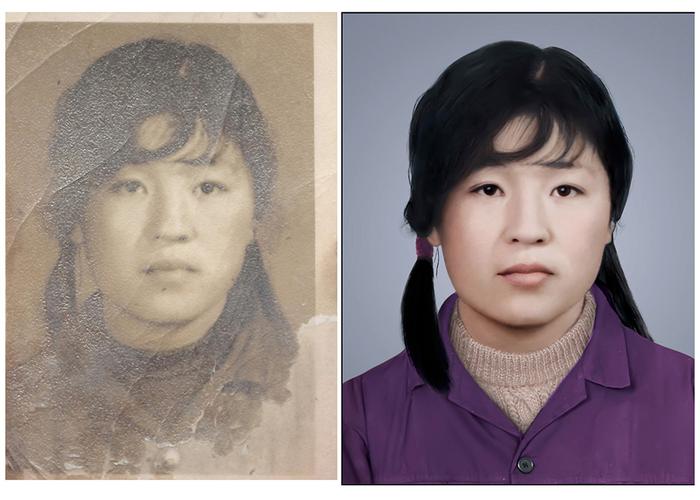

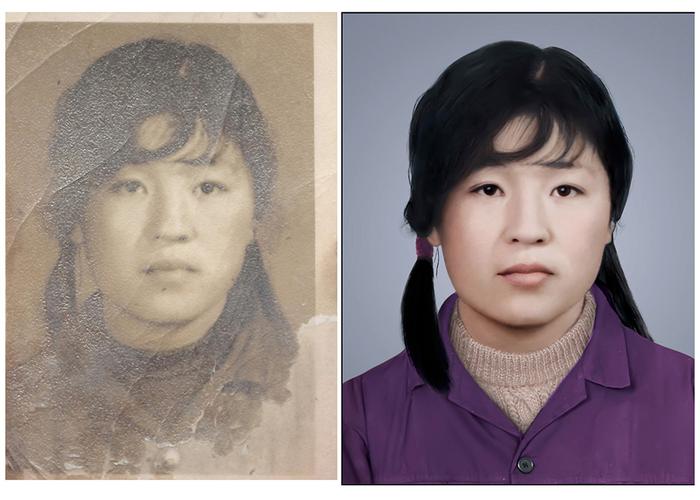

老照片修复AI工具链接为https://www.lightsec.cc/ai-image-enhancer,该工具提供网页版与客户端,支持多系统及批量处理,内置多种AI模型,可实现16倍无损放大与细节重建,有效修复划痕、降噪并保留纹理,操作简便且保障用户隐私,适用于家庭老照、文献资料等多场景数字化修复。

-

AI视频情感分析技术可实时识别画面中人物情绪变化,优化内容制作。一、拍摄时通过AI捕捉演员面部表情,量化情绪表现,指导表演调整;二、剪辑阶段自动分类情感标签,筛选高感染力片段,匹配音乐节奏;三、试映中分析观众情绪反馈,定位薄弱场景并优化叙事;四、建立情感元数据标签,实现流媒体平台按情绪个性化推荐。

-

豆包AI网页端官网为https://www.doubao.com,提供多设备同步、文档分析、内容生成及截图问答等智能服务。

-

腾讯元宝网页版可通过官网https://yuanbao.tencent.com或聊天入口https://yuanbao.tencent.com/chat/直接使用,支持微信、QQ、手机号登录,提供文本生成、编程帮助等功能,2025年2月起接入DeepSeekR1模型,支持深度思考与联网搜索。

无需登录直接下载的AI图片生成工具在2025年仍是效率首选,如Artbreeder部分功能、DeepDreamGenerator免费版、Fotor限时活动、在线StableDiffusion镜像站、RunDiffusion特定模型、NightCafe免费积分、Clipdrop部分功能、Hotpot.ai简易工具、Craiyon及本地部署的DreamBoothAI;这些工具虽便捷,但存在隐私与安全风险,且生成质量依赖提示词精准度与后期处理,无法取代专业设计,仅作为辅助创意工具。381 收藏

无需登录直接下载的AI图片生成工具在2025年仍是效率首选,如Artbreeder部分功能、DeepDreamGenerator免费版、Fotor限时活动、在线StableDiffusion镜像站、RunDiffusion特定模型、NightCafe免费积分、Clipdrop部分功能、Hotpot.ai简易工具、Craiyon及本地部署的DreamBoothAI;这些工具虽便捷,但存在隐私与安全风险,且生成质量依赖提示词精准度与后期处理,无法取代专业设计,仅作为辅助创意工具。381 收藏 11月5日,问界汽车宣布其全系车型正式接入“出厂即查验”服务,全国范围内的购车用户将无需再前往车管所排队验车,可通过线上流程直接完成车辆登记与上牌。问界汽车自2025年11月起,问界用户中心的“一站式上牌”服务将进一步扩展。目前,已有36个城市的支持门店提供该项服务,包括北京、上海、广州、深圳、成都、武汉等一线及新一线城市。用户在提车当日即可通过“交管12123”APP在线选号并办理牌证业务,最快1小时内便可完成全部流程。此举大幅压缩了从购车到合法上路的时间成本,部分区域更实现了“一次都不用跑”的全流程网150 收藏

11月5日,问界汽车宣布其全系车型正式接入“出厂即查验”服务,全国范围内的购车用户将无需再前往车管所排队验车,可通过线上流程直接完成车辆登记与上牌。问界汽车自2025年11月起,问界用户中心的“一站式上牌”服务将进一步扩展。目前,已有36个城市的支持门店提供该项服务,包括北京、上海、广州、深圳、成都、武汉等一线及新一线城市。用户在提车当日即可通过“交管12123”APP在线选号并办理牌证业务,最快1小时内便可完成全部流程。此举大幅压缩了从购车到合法上路的时间成本,部分区域更实现了“一次都不用跑”的全流程网150 收藏 投喂AI最新官方访问地址为https://www.p2hp.com,该平台集成多种AI工具,支持自然语言指令、快速文本生成与多格式内容输出,页面简洁且无需注册即可使用基础功能。344 收藏

投喂AI最新官方访问地址为https://www.p2hp.com,该平台集成多种AI工具,支持自然语言指令、快速文本生成与多格式内容输出,页面简洁且无需注册即可使用基础功能。344 收藏 使用豆包AI生成JavaScript代码的关键在于明确需求、提供清晰指令并进行结果优化。一要明确具体功能,如表单验证或DOM操作,避免模糊提问;二要用结构化的中文指令,如“请用JavaScript写一个函数用来……”,并可添加兼容性等限制条件;三要检查生成代码的逻辑与语法,结合浏览器测试进行调整。实际应用包括生成随机颜色值、表格排序、倒计时等功能。310 收藏

使用豆包AI生成JavaScript代码的关键在于明确需求、提供清晰指令并进行结果优化。一要明确具体功能,如表单验证或DOM操作,避免模糊提问;二要用结构化的中文指令,如“请用JavaScript写一个函数用来……”,并可添加兼容性等限制条件;三要检查生成代码的逻辑与语法,结合浏览器测试进行调整。实际应用包括生成随机颜色值、表格排序、倒计时等功能。310 收藏 腾讯AI官网链接为https://ai.tencent.com/,该平台集成多模态内容生成、语音处理、OCR识别及人脸识别等功能,提供详尽API文档与SDK工具包,支持金融、教育、政务等场景的智能化应用。273 收藏

腾讯AI官网链接为https://ai.tencent.com/,该平台集成多模态内容生成、语音处理、OCR识别及人脸识别等功能,提供详尽API文档与SDK工具包,支持金融、教育、政务等场景的智能化应用。273 收藏 即梦AI可解析梦境中的象征意义,通过输入梦境内容提取关键词、分析情绪曲线、关联多梦主题并生成PDF报告。用户在三星GalaxyS24(Android14)运行该应用,依次完成梦境记录上传、查看关键词云、标注情感标签、开启跨梦境分析,最终导出结构化解析报告,辅助理解潜意识心理象征。419 收藏

即梦AI可解析梦境中的象征意义,通过输入梦境内容提取关键词、分析情绪曲线、关联多梦主题并生成PDF报告。用户在三星GalaxyS24(Android14)运行该应用,依次完成梦境记录上传、查看关键词云、标注情感标签、开启跨梦境分析,最终导出结构化解析报告,辅助理解潜意识心理象征。419 收藏 答案是https://www.vidu.studio/,该平台支持文本一键生成高清视频,基于U-ViT架构可输出16秒以上连贯画面,具备高动态与场景一致性控制,提供1080P画质,适用于品牌宣传、社交媒体、活动预热及知识类视频创作,界面简洁、中文理解强、多风格可选且无需下载云端完成。276 收藏

答案是https://www.vidu.studio/,该平台支持文本一键生成高清视频,基于U-ViT架构可输出16秒以上连贯画面,具备高动态与场景一致性控制,提供1080P画质,适用于品牌宣传、社交媒体、活动预热及知识类视频创作,界面简洁、中文理解强、多风格可选且无需下载云端完成。276 收藏 要让豆包AI有效优化Python算法性能,关键在于明确问题、提供具体代码和上下文,并通过多次追问细化优化点。首先,明确优化方向,如减少运行时间、降低内存占用或提升可读性;其次,给出具体的函数、数据规模及性能瓶颈信息,而非模糊描述;接着,通过逐步追问探索多种优化可能,如列表推导式、生成器或NumPy的使用;最后,结合基础工具如timeit、cProfile定位瓶颈,并掌握高效数据结构与算法思路,才能真正发挥AI辅助作用。301 收藏

要让豆包AI有效优化Python算法性能,关键在于明确问题、提供具体代码和上下文,并通过多次追问细化优化点。首先,明确优化方向,如减少运行时间、降低内存占用或提升可读性;其次,给出具体的函数、数据规模及性能瓶颈信息,而非模糊描述;接着,通过逐步追问探索多种优化可能,如列表推导式、生成器或NumPy的使用;最后,结合基础工具如timeit、cProfile定位瓶颈,并掌握高效数据结构与算法思路,才能真正发挥AI辅助作用。301 收藏 使用明确节日关键词、文化地域特征、艺术风格参数及光照色彩描述,可精准生成Midjourney节日图像。例如输入“ChineseNewYearcelebrationwithredlanternsandfireworksinBeijing,digitalpainting--v6--ar16:9”,能呈现具叙事性与视觉冲击力的春节场景。321 收藏

使用明确节日关键词、文化地域特征、艺术风格参数及光照色彩描述,可精准生成Midjourney节日图像。例如输入“ChineseNewYearcelebrationwithredlanternsandfireworksinBeijing,digitalpainting--v6--ar16:9”,能呈现具叙事性与视觉冲击力的春节场景。321 收藏 豆包AI大模型在数据迁移中可通过自然语言处理与智能生成提升效率,具体操作包括:1.数据预处理时解析非结构化内容并结构化关键字段;2.利用AI迁移工具自动执行结构映射并生成字段匹配建议;3.通过分析日志实现异常检测与自动生成修复建议;4.构建标准化流程并管理提示词模板,将AI能力封装为模块,减少人工干预,提升迁移智能化水平。379 收藏

豆包AI大模型在数据迁移中可通过自然语言处理与智能生成提升效率,具体操作包括:1.数据预处理时解析非结构化内容并结构化关键字段;2.利用AI迁移工具自动执行结构映射并生成字段匹配建议;3.通过分析日志实现异常检测与自动生成修复建议;4.构建标准化流程并管理提示词模板,将AI能力封装为模块,减少人工干预,提升迁移智能化水平。379 收藏 Gemini2.5网页端官方入口为https://gemini.google.com,登录Google账号即可使用;国内用户可尝试https://chat.lanjingai.org或https://xsimplechat.com镜像站点访问。173 收藏

Gemini2.5网页端官方入口为https://gemini.google.com,登录Google账号即可使用;国内用户可尝试https://chat.lanjingai.org或https://xsimplechat.com镜像站点访问。173 收藏 老照片修复AI工具链接为https://www.lightsec.cc/ai-image-enhancer,该工具提供网页版与客户端,支持多系统及批量处理,内置多种AI模型,可实现16倍无损放大与细节重建,有效修复划痕、降噪并保留纹理,操作简便且保障用户隐私,适用于家庭老照、文献资料等多场景数字化修复。137 收藏

老照片修复AI工具链接为https://www.lightsec.cc/ai-image-enhancer,该工具提供网页版与客户端,支持多系统及批量处理,内置多种AI模型,可实现16倍无损放大与细节重建,有效修复划痕、降噪并保留纹理,操作简便且保障用户隐私,适用于家庭老照、文献资料等多场景数字化修复。137 收藏 AI视频情感分析技术可实时识别画面中人物情绪变化,优化内容制作。一、拍摄时通过AI捕捉演员面部表情,量化情绪表现,指导表演调整;二、剪辑阶段自动分类情感标签,筛选高感染力片段,匹配音乐节奏;三、试映中分析观众情绪反馈,定位薄弱场景并优化叙事;四、建立情感元数据标签,实现流媒体平台按情绪个性化推荐。129 收藏

AI视频情感分析技术可实时识别画面中人物情绪变化,优化内容制作。一、拍摄时通过AI捕捉演员面部表情,量化情绪表现,指导表演调整;二、剪辑阶段自动分类情感标签,筛选高感染力片段,匹配音乐节奏;三、试映中分析观众情绪反馈,定位薄弱场景并优化叙事;四、建立情感元数据标签,实现流媒体平台按情绪个性化推荐。129 收藏 豆包AI网页端官网为https://www.doubao.com,提供多设备同步、文档分析、内容生成及截图问答等智能服务。235 收藏

豆包AI网页端官网为https://www.doubao.com,提供多设备同步、文档分析、内容生成及截图问答等智能服务。235 收藏 腾讯元宝网页版可通过官网https://yuanbao.tencent.com或聊天入口https://yuanbao.tencent.com/chat/直接使用,支持微信、QQ、手机号登录,提供文本生成、编程帮助等功能,2025年2月起接入DeepSeekR1模型,支持深度思考与联网搜索。427 收藏

腾讯元宝网页版可通过官网https://yuanbao.tencent.com或聊天入口https://yuanbao.tencent.com/chat/直接使用,支持微信、QQ、手机号登录,提供文本生成、编程帮助等功能,2025年2月起接入DeepSeekR1模型,支持深度思考与联网搜索。427 收藏