-

豆包AI写作入口位于其官网https://www.doubao.com/chat/,平台提供“帮我写作”功能,支持多种文体创作、文本润色、智能续写,用户注册登录后可输入写作要求生成初稿,系统基于先进模型精准理解意图,结合广泛知识库与简洁界面,实现高效多轮优化与图文混排处理。

-

首先确认华为AI眼镜是否进入配对模式,再检查安卓手机蓝牙功能。1、使用充电绳长按4秒使指示灯白闪进入配对;2、或双侧镜腿触控区长按4秒听提示音进入配对;3、通过智慧生活App添加设备并按指引完成连接;4、若失败则长按充电绳按键10秒重置眼镜,清除手机旧记录后重新配对。

-

秘塔AI编辑图片入口位于官网首页“图像工坊”快捷按钮,点击即可直达https://www.mita-ai.com/image-editor,支持拖拽上传、智能去背景、局部重绘与滤镜风格化等功能,无需注册即可使用。

-

即梦支持通过文本生成、AI绘图和模板替换三种方式定制文字与Logo。首先,在“创作”页面使用“文本生成”功能,输入内容并选择字体、颜色等样式生成文字图像;其次,利用“AI绘图”功能,输入包含文字与风格的提示词(如“科技公司Logo,含字母X,极简风”),设定画布尺寸生成个性化Logo;最后,也可在“模板中心”选取Logo模板,替换文字后调整布局导出。全过程适用于iPadPro及iPadOS17环境,操作简便高效。

-

答案:通过明确需求、上传图片、使用模板和反馈优化四步,可在腾讯元宝获取精准时尚搭配建议。

-

若使用虚拟伴侣AI影响情绪与生活,需建立健康机制:一、设每日30分钟使用上限并开启提醒;二、启用防沉迷功能,让AI在聊天超15分钟时建议暂停;三、每周设“无AI日”,用现实活动替代互动;四、开启多重验证退出机制,增加延时成本以减少依赖。

-

百度AI搜索免登录智能官网入口是https://ai.baidu.com/,该平台提供无需注册即可体验的AI功能,涵盖图像识别、语音合成、文心大模型支持的自然语言处理,并开放API接口与SDK工具包,同时设有行业解决方案展示区。

-

OpenAI生成PPT需通过DALL·E平台实现,入口为https://www.openai.com/dall-e。用户登录后选择图像生成功能,输入主题关键词,系统将自动生成适配幻灯片的高清视觉素材,支持多语言、多风格及个性化调整,便于快速制作专业PPT。

-

ChatGPTforanyrole是什么ChatGPTforanyrole是由OpenAI官方发布的一套ChatGPT提示词模板工具包,旨在帮助用户更高效地利用AI完成各类职场任务。该模板涵盖邮件写作、会议协作、决策支持到效率优化等多个工作场景,适用于销售、产品经理、市场人员、开发工程师、团队管理者等不同岗位角色。每个提示模板都经过专业设计,开箱即用,可直接复制操作,快速生成高质量的文本内容。PromptPacks作为完全免费的资源,特别适合希望提升办公自动化与沟通效率的

-

讯飞星火主页链接是https://xinghuo.xfyun.cn,该平台提供人工智能语言理解、文本生成、语音识别与语义分析功能,支持多轮对话、编程辅助与问题解答,适用于教育、办公、开发及个人创意场景,网页界面清晰易用,适配多端,依托科大讯飞技术持续优化,并开放SDK与API,支持多语言处理与硬件联动。

-

文心一言官网为https://yiyan.baidu.com,提供文案创作、内容生成、逻辑推理、多轮对话、文档解析、图片生成及插件扩展等功能,支持网页和移动端访问,企业合作可联系wenxin-all@baidu.com。

-

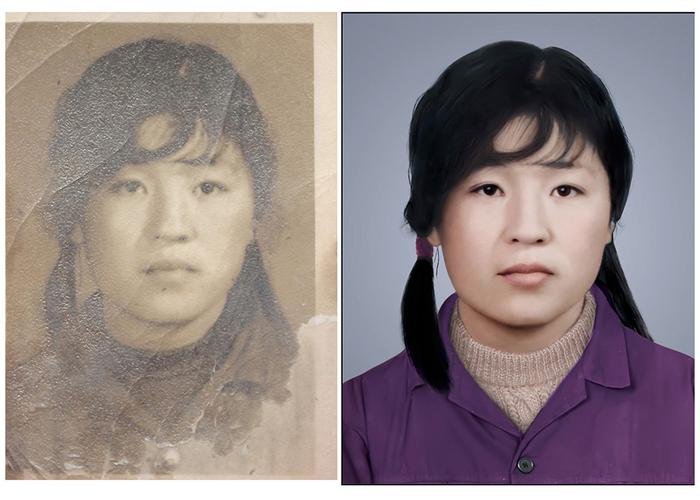

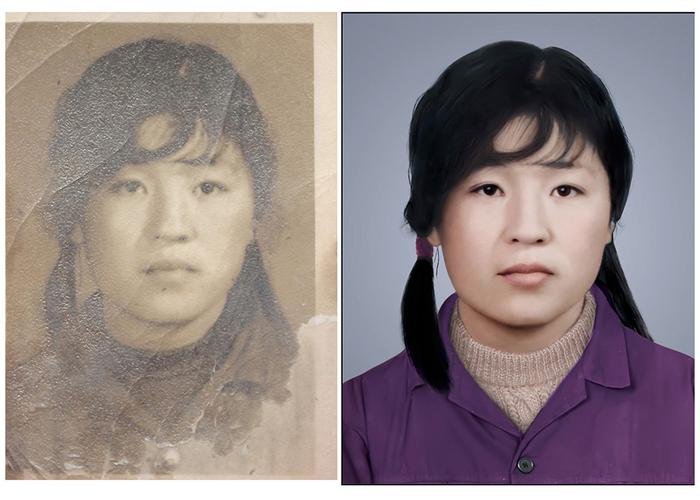

老照片修复AI官方入口为https://www.photoscissors.com/zh/photo-repair/,进入后上传照片,系统自动识别破损区域,用户选择修复强度及功能选项,点击开始修复,AI完成图像重建与色彩还原,预览并优化效果后可下载高清图片,支持多种格式导出,无需注册即可使用基础功能。

-

文心一言官方入口注册需访问官网或下载APP,通过手机号获取验证码完成账号创建,支持百度、微信、QQ快捷登录,设置强密码并同意服务协议,完成实名认证与邮箱激活,完善个人信息以提升安全性与使用体验。

-

用DeepSeek写品牌宣传文案的关键在于明确品牌定位、设计清晰Prompt并进行后期优化。一、需先明确品牌是谁、卖什么、差异点及目标人群,如为环保护肤品牌撰写文案时突出“天然成分”、“可持续包装”等关键词;二、Prompt应包含品牌名称、核心理念、受众描述、用途及语气要求,例如“为‘绿源生活’写一段官网文案,语气温暖自然,面向关注环保的都市白领”;三、生成初稿后需检查核心卖点覆盖情况、语气统一性及表达简洁度,并可多次生成或反向优化;四、实际案例中,“晨光咖啡”的Prompt强调手工烘焙与产地直采,生成文

-

可通过调整API请求中的model字段实现多模型切换,适用于不同任务场景:1、调用时指定model参数可灵活使用gpt-3.5-turbo或gpt-4等模型;2、构建调度层根据任务复杂度自动路由,提升成本与性能平衡;3、采用微服务架构将模型封装为独立服务,通过网关分发流量,增强系统稳定性;4、利用环境变量控制默认模型选择,便于多环境管理和成本控制。

豆包AI写作入口位于其官网https://www.doubao.com/chat/,平台提供“帮我写作”功能,支持多种文体创作、文本润色、智能续写,用户注册登录后可输入写作要求生成初稿,系统基于先进模型精准理解意图,结合广泛知识库与简洁界面,实现高效多轮优化与图文混排处理。384 收藏

豆包AI写作入口位于其官网https://www.doubao.com/chat/,平台提供“帮我写作”功能,支持多种文体创作、文本润色、智能续写,用户注册登录后可输入写作要求生成初稿,系统基于先进模型精准理解意图,结合广泛知识库与简洁界面,实现高效多轮优化与图文混排处理。384 收藏 首先确认华为AI眼镜是否进入配对模式,再检查安卓手机蓝牙功能。1、使用充电绳长按4秒使指示灯白闪进入配对;2、或双侧镜腿触控区长按4秒听提示音进入配对;3、通过智慧生活App添加设备并按指引完成连接;4、若失败则长按充电绳按键10秒重置眼镜,清除手机旧记录后重新配对。297 收藏

首先确认华为AI眼镜是否进入配对模式,再检查安卓手机蓝牙功能。1、使用充电绳长按4秒使指示灯白闪进入配对;2、或双侧镜腿触控区长按4秒听提示音进入配对;3、通过智慧生活App添加设备并按指引完成连接;4、若失败则长按充电绳按键10秒重置眼镜,清除手机旧记录后重新配对。297 收藏 秘塔AI编辑图片入口位于官网首页“图像工坊”快捷按钮,点击即可直达https://www.mita-ai.com/image-editor,支持拖拽上传、智能去背景、局部重绘与滤镜风格化等功能,无需注册即可使用。166 收藏

秘塔AI编辑图片入口位于官网首页“图像工坊”快捷按钮,点击即可直达https://www.mita-ai.com/image-editor,支持拖拽上传、智能去背景、局部重绘与滤镜风格化等功能,无需注册即可使用。166 收藏 即梦支持通过文本生成、AI绘图和模板替换三种方式定制文字与Logo。首先,在“创作”页面使用“文本生成”功能,输入内容并选择字体、颜色等样式生成文字图像;其次,利用“AI绘图”功能,输入包含文字与风格的提示词(如“科技公司Logo,含字母X,极简风”),设定画布尺寸生成个性化Logo;最后,也可在“模板中心”选取Logo模板,替换文字后调整布局导出。全过程适用于iPadPro及iPadOS17环境,操作简便高效。349 收藏

即梦支持通过文本生成、AI绘图和模板替换三种方式定制文字与Logo。首先,在“创作”页面使用“文本生成”功能,输入内容并选择字体、颜色等样式生成文字图像;其次,利用“AI绘图”功能,输入包含文字与风格的提示词(如“科技公司Logo,含字母X,极简风”),设定画布尺寸生成个性化Logo;最后,也可在“模板中心”选取Logo模板,替换文字后调整布局导出。全过程适用于iPadPro及iPadOS17环境,操作简便高效。349 收藏 答案:通过明确需求、上传图片、使用模板和反馈优化四步,可在腾讯元宝获取精准时尚搭配建议。375 收藏

答案:通过明确需求、上传图片、使用模板和反馈优化四步,可在腾讯元宝获取精准时尚搭配建议。375 收藏 若使用虚拟伴侣AI影响情绪与生活,需建立健康机制:一、设每日30分钟使用上限并开启提醒;二、启用防沉迷功能,让AI在聊天超15分钟时建议暂停;三、每周设“无AI日”,用现实活动替代互动;四、开启多重验证退出机制,增加延时成本以减少依赖。286 收藏

若使用虚拟伴侣AI影响情绪与生活,需建立健康机制:一、设每日30分钟使用上限并开启提醒;二、启用防沉迷功能,让AI在聊天超15分钟时建议暂停;三、每周设“无AI日”,用现实活动替代互动;四、开启多重验证退出机制,增加延时成本以减少依赖。286 收藏 百度AI搜索免登录智能官网入口是https://ai.baidu.com/,该平台提供无需注册即可体验的AI功能,涵盖图像识别、语音合成、文心大模型支持的自然语言处理,并开放API接口与SDK工具包,同时设有行业解决方案展示区。369 收藏

百度AI搜索免登录智能官网入口是https://ai.baidu.com/,该平台提供无需注册即可体验的AI功能,涵盖图像识别、语音合成、文心大模型支持的自然语言处理,并开放API接口与SDK工具包,同时设有行业解决方案展示区。369 收藏 OpenAI生成PPT需通过DALL·E平台实现,入口为https://www.openai.com/dall-e。用户登录后选择图像生成功能,输入主题关键词,系统将自动生成适配幻灯片的高清视觉素材,支持多语言、多风格及个性化调整,便于快速制作专业PPT。485 收藏

OpenAI生成PPT需通过DALL·E平台实现,入口为https://www.openai.com/dall-e。用户登录后选择图像生成功能,输入主题关键词,系统将自动生成适配幻灯片的高清视觉素材,支持多语言、多风格及个性化调整,便于快速制作专业PPT。485 收藏 ChatGPTforanyrole是什么ChatGPTforanyrole是由OpenAI官方发布的一套ChatGPT提示词模板工具包,旨在帮助用户更高效地利用AI完成各类职场任务。该模板涵盖邮件写作、会议协作、决策支持到效率优化等多个工作场景,适用于销售、产品经理、市场人员、开发工程师、团队管理者等不同岗位角色。每个提示模板都经过专业设计,开箱即用,可直接复制操作,快速生成高质量的文本内容。PromptPacks作为完全免费的资源,特别适合希望提升办公自动化与沟通效率的386 收藏

ChatGPTforanyrole是什么ChatGPTforanyrole是由OpenAI官方发布的一套ChatGPT提示词模板工具包,旨在帮助用户更高效地利用AI完成各类职场任务。该模板涵盖邮件写作、会议协作、决策支持到效率优化等多个工作场景,适用于销售、产品经理、市场人员、开发工程师、团队管理者等不同岗位角色。每个提示模板都经过专业设计,开箱即用,可直接复制操作,快速生成高质量的文本内容。PromptPacks作为完全免费的资源,特别适合希望提升办公自动化与沟通效率的386 收藏 讯飞星火主页链接是https://xinghuo.xfyun.cn,该平台提供人工智能语言理解、文本生成、语音识别与语义分析功能,支持多轮对话、编程辅助与问题解答,适用于教育、办公、开发及个人创意场景,网页界面清晰易用,适配多端,依托科大讯飞技术持续优化,并开放SDK与API,支持多语言处理与硬件联动。320 收藏

讯飞星火主页链接是https://xinghuo.xfyun.cn,该平台提供人工智能语言理解、文本生成、语音识别与语义分析功能,支持多轮对话、编程辅助与问题解答,适用于教育、办公、开发及个人创意场景,网页界面清晰易用,适配多端,依托科大讯飞技术持续优化,并开放SDK与API,支持多语言处理与硬件联动。320 收藏 文心一言官网为https://yiyan.baidu.com,提供文案创作、内容生成、逻辑推理、多轮对话、文档解析、图片生成及插件扩展等功能,支持网页和移动端访问,企业合作可联系wenxin-all@baidu.com。177 收藏

文心一言官网为https://yiyan.baidu.com,提供文案创作、内容生成、逻辑推理、多轮对话、文档解析、图片生成及插件扩展等功能,支持网页和移动端访问,企业合作可联系wenxin-all@baidu.com。177 收藏 老照片修复AI官方入口为https://www.photoscissors.com/zh/photo-repair/,进入后上传照片,系统自动识别破损区域,用户选择修复强度及功能选项,点击开始修复,AI完成图像重建与色彩还原,预览并优化效果后可下载高清图片,支持多种格式导出,无需注册即可使用基础功能。337 收藏

老照片修复AI官方入口为https://www.photoscissors.com/zh/photo-repair/,进入后上传照片,系统自动识别破损区域,用户选择修复强度及功能选项,点击开始修复,AI完成图像重建与色彩还原,预览并优化效果后可下载高清图片,支持多种格式导出,无需注册即可使用基础功能。337 收藏 文心一言官方入口注册需访问官网或下载APP,通过手机号获取验证码完成账号创建,支持百度、微信、QQ快捷登录,设置强密码并同意服务协议,完成实名认证与邮箱激活,完善个人信息以提升安全性与使用体验。461 收藏

文心一言官方入口注册需访问官网或下载APP,通过手机号获取验证码完成账号创建,支持百度、微信、QQ快捷登录,设置强密码并同意服务协议,完成实名认证与邮箱激活,完善个人信息以提升安全性与使用体验。461 收藏 用DeepSeek写品牌宣传文案的关键在于明确品牌定位、设计清晰Prompt并进行后期优化。一、需先明确品牌是谁、卖什么、差异点及目标人群,如为环保护肤品牌撰写文案时突出“天然成分”、“可持续包装”等关键词;二、Prompt应包含品牌名称、核心理念、受众描述、用途及语气要求,例如“为‘绿源生活’写一段官网文案,语气温暖自然,面向关注环保的都市白领”;三、生成初稿后需检查核心卖点覆盖情况、语气统一性及表达简洁度,并可多次生成或反向优化;四、实际案例中,“晨光咖啡”的Prompt强调手工烘焙与产地直采,生成文247 收藏

用DeepSeek写品牌宣传文案的关键在于明确品牌定位、设计清晰Prompt并进行后期优化。一、需先明确品牌是谁、卖什么、差异点及目标人群,如为环保护肤品牌撰写文案时突出“天然成分”、“可持续包装”等关键词;二、Prompt应包含品牌名称、核心理念、受众描述、用途及语气要求,例如“为‘绿源生活’写一段官网文案,语气温暖自然,面向关注环保的都市白领”;三、生成初稿后需检查核心卖点覆盖情况、语气统一性及表达简洁度,并可多次生成或反向优化;四、实际案例中,“晨光咖啡”的Prompt强调手工烘焙与产地直采,生成文247 收藏 可通过调整API请求中的model字段实现多模型切换,适用于不同任务场景:1、调用时指定model参数可灵活使用gpt-3.5-turbo或gpt-4等模型;2、构建调度层根据任务复杂度自动路由,提升成本与性能平衡;3、采用微服务架构将模型封装为独立服务,通过网关分发流量,增强系统稳定性;4、利用环境变量控制默认模型选择,便于多环境管理和成本控制。201 收藏

可通过调整API请求中的model字段实现多模型切换,适用于不同任务场景:1、调用时指定model参数可灵活使用gpt-3.5-turbo或gpt-4等模型;2、构建调度层根据任务复杂度自动路由,提升成本与性能平衡;3、采用微服务架构将模型封装为独立服务,通过网关分发流量,增强系统稳定性;4、利用环境变量控制默认模型选择,便于多环境管理和成本控制。201 收藏