-

接入DeepSeek到AzureAIStudio的过程并不复杂,但需要注意一些关键步骤和配置。如何在AzureAIStudio中设置DeepSeek?首先,确保你已经拥有Azure账户并登陆AzureAIStudio。在设置DeepSeek之前,你需要在Azure门户中创建一个资源组,并在其中添加一个AzureAI服务实例。接下来,导航到AzureAIStudio,选择“连接外部模型”选项,然后选择DeepSeek。你需要提供DeepSeek的A

-

选择支持DeepSeek集成的软件工具时,首要考虑的是工具的功能适配度。1)功能适配度包括API集成和利用DeepSeek算法增强核心功能。2)用户界面友好性和详细的使用指南及技术支持也很重要。表现最佳的软件工具包括Trello、Asana和Slack,它们在功能适配和用户体验上表现优异。

-

调用DALL·E生成图像的关键在于掌握API调用方式、核心参数和注意事项。1.首先需注册OpenAI账号并获取APIKey,使用Python库或HTTP工具发送请求;2.核心参数包括prompt(描述内容)、n(生成数量)、size(图像尺寸)、response_format(返回格式)和user(用户标识);3.常见问题涉及权限验证、费用控制、内容限制、网络延迟及缓存缺失等,务必注意避免错误和资源浪费。

-

登录MemoAI网页端只需打开官网并选择手机号、邮箱或第三方账号登录即可;界面分为左侧边栏、中间内容区和右上角工具按钮,支持键盘快捷键提升效率;新建笔记可点击按钮或按N键,并支持Markdown格式排版;编辑笔记直接点击正文即可,系统自动保存;搜索通过顶部搜索框输入关键词实现,支持模糊匹配,整理笔记可用标签分类或拖拽至文件夹。

-

AI生成证件照的底层技术原理是深度学习、生成对抗网络(GANs)和计算机视觉算法的结合。1.深度学习模型通过大量真实证件照和普通照片训练,学会识别面部特征、背景和光线。2.GANs由生成器和判别器组成,通过对抗学习生成逼真的证件照。3.计算机视觉算法用于调整面部表情、角度和光线,提升生成质量。

-

多模态AI模型的安全性可通过四方面措施加强:1.多模态内容过滤,包括使用先进算法、定期更新规则、设置多层验证;2.防范对抗攻击,通过增强鲁棒性、实时监控、数据预处理;3.跨域安全防护,实施传输过滤、加密通信、访问控制;4.指令遵循与幻觉抑制,优化指令数据、提升泛化能力、建立检测机制。

-

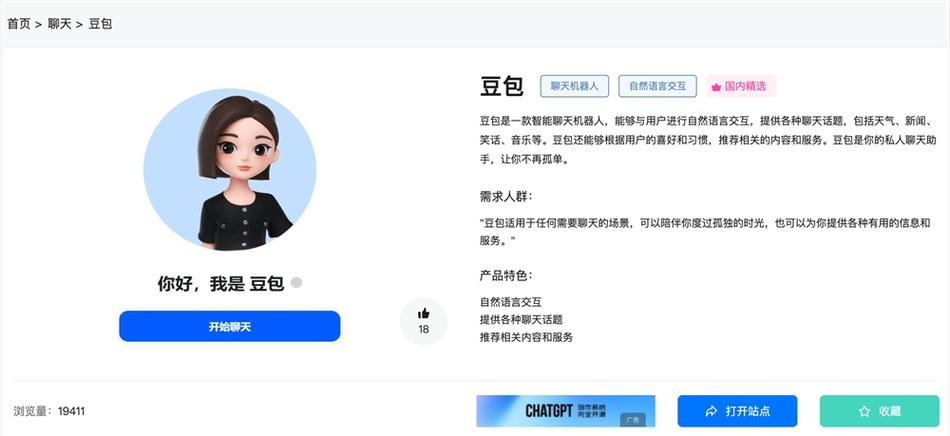

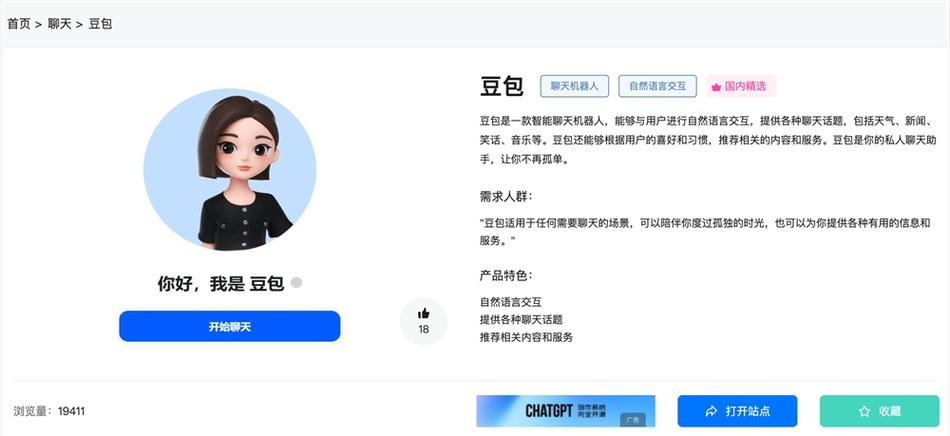

利用豆包AI生成高质量选题需注意三点:1.明确目标受众和内容方向;2.使用具体关键词和描述;3.检查并调整AI生成的选题。精确输入和人工审核是关键,确保选题符合标准和目标。

-

选择AI工具切入点在于找到最需解决的问题并动手操作,可快速上手的关键是使用基于文本的AI聊天机器人或写作助手;推荐文本生成类工具因其门槛低、反馈快,能直接提升效率;提示词应清晰具体、加入角色和上下文,并通过迭代优化提升效果;AI的应用不仅限于聊天和画图,还可用于学习、内容创作、数据处理及个人发展等多领域,成为多功能助手。

-

豆包AI写代码的关键在于清晰提问和具体描述。使用方法有三:1.在IDE安装插件并输入功能描述,如“写一个Python函数计算两个日期天数差”;2.由豆包AI生成代码草稿后复制或修改使用;3.适用于重复性高或模板化任务。常见问题包括语法错误、逻辑不符、库支持不全,解决方式是检查代码、细化需求描述、结合文档调整提示。提高代码质量需做到三点:1.提问要具体明确而非简单模糊;2.提供上下文如框架版本(如Flask+Python3.9);3.参照项目风格生成代码。用好豆包AI还需多试、多改、多总结。

-

DeepseekAI在视频创意生成中的独特优势体现在其强大的联想发散能力、内容结构化梳理能力以及多模态理解与生成潜力。①它能从一个关键词联想到多个具体场景并生成详细描述,突破创意瓶颈;②可自动生成分镜脚本、旁白文案及时间轴建议,提升叙事逻辑性;③具备从抽象概念到执行指导的转化能力,辅助视觉与音乐风格落地。

-

豆包AI导入自定义词典的核心操作是通过其“知识库”或“术语管理”模块上传特定格式的文件。具体步骤为:1.定位功能入口,如“知识库管理”或“自定义词典”;2.准备CSV或TXT格式的词典文件,注意使用UTF-8编码;3.上传并解析文件,确认词条识别正确;4.激活词典并应用到目标模型。自定义词典能提升AI的专业性、语境一致性、品牌形象和生成效率。常见问题包括格式错误、词条冲突、内容质量低和效果不明显,可通过规范文件格式、调整优先级、校对内容及检查激活状态解决。此外,结合领域语料投喂、提示词工程、少量样本学习、

-

【小编科技】随着全球迈入新能源时代,电力已成为各行各业运转的核心动力。作为储能的关键载体,电池技术的进步直接映射出整个产业的发展方向。无论是新能源汽车还是智能手机,厂商们都在不断加码电池技术的研发,不仅追求更高的电池容量,更重视安全性与稳定性。唯有在多维度上同步突破,才能真正提升用户的使用体验与安全保障。在昨日举行的全新MG4预售发布会上,半固态电池技术的亮相成为全场焦点,也为10万元级别的两厢车型带来了前所未有的电池革新。发布会期间,#半固态电池强在哪儿#话题迅速登上热搜,引发网友广泛讨论。借此契机,

-

选择合适的AI数字人形象和声音需先明确视频主题与目标受众,再匹配相应风格的数字人和声音,确保形象、语气与内容协调一致;2.优化视频节奏感和画面匹配度可通过将文案分段、设置停顿、匹配关键词与背景、调整语速及添加视觉提示实现;3.新手常见问题包括数字人不自然、语音生硬、画面不匹配、节奏拖沓及生成失败,解决方案分别为增强文案情感表达、尝试不同声音模型、自定义背景素材、精简文案并分段输出、检查网络与素材大小,最终通过反复预览调整提升视频质量。

-

蝉镜智能解锁的核心安全机制在于融合多重生物识别、加密通信和情境感知;2.生物识别采用3D人脸识别、超声波指纹及活体检测技术,防止欺骗攻击;3.生物特征以加密模板形式存储于独立安全芯片,不上传云端,保障隐私;4.设备联动通过BLE或Wi-FiDirect建立加密连接,使用短时令牌和双向认证确保通信安全;5.情境感知动态调整安全策略,在可信环境降低门槛,在异常环境提升验证要求;6.网络中断时支持本地生物识别或PIN码解锁,保障离线可用性;7.提供机械钥匙、一次性密码等备用方案,防止用户被锁门外;8.手机丢失后

-

8月1日起,上海浦东新区金桥与花木片区的市民正式迎来了一种崭新的出行方式——搭乘小马智行的全无人驾驶Robotaxi。据悉,小马智行作为首批取得上海最新一批智能网联汽车示范运营资质的企业,携手锦江出租率先在浦东金桥、花木区域启动面向公众的常态化Robotaxi服务。从每周一至周五的早上7:30到晚上9:30,市民只需打开“小马智行”App或使用其打车小程序,即可预约无人驾驶车辆,轻松开启智能出行。该服务时段全面覆盖早晚通勤高峰及日常休闲出行需求,运营路线贯穿浦东新区人民政府、啦啦宝都购物中心、世纪公园、浦

接入DeepSeek到AzureAIStudio的过程并不复杂,但需要注意一些关键步骤和配置。如何在AzureAIStudio中设置DeepSeek?首先,确保你已经拥有Azure账户并登陆AzureAIStudio。在设置DeepSeek之前,你需要在Azure门户中创建一个资源组,并在其中添加一个AzureAI服务实例。接下来,导航到AzureAIStudio,选择“连接外部模型”选项,然后选择DeepSeek。你需要提供DeepSeek的A464 收藏

接入DeepSeek到AzureAIStudio的过程并不复杂,但需要注意一些关键步骤和配置。如何在AzureAIStudio中设置DeepSeek?首先,确保你已经拥有Azure账户并登陆AzureAIStudio。在设置DeepSeek之前,你需要在Azure门户中创建一个资源组,并在其中添加一个AzureAI服务实例。接下来,导航到AzureAIStudio,选择“连接外部模型”选项,然后选择DeepSeek。你需要提供DeepSeek的A464 收藏 选择支持DeepSeek集成的软件工具时,首要考虑的是工具的功能适配度。1)功能适配度包括API集成和利用DeepSeek算法增强核心功能。2)用户界面友好性和详细的使用指南及技术支持也很重要。表现最佳的软件工具包括Trello、Asana和Slack,它们在功能适配和用户体验上表现优异。464 收藏

选择支持DeepSeek集成的软件工具时,首要考虑的是工具的功能适配度。1)功能适配度包括API集成和利用DeepSeek算法增强核心功能。2)用户界面友好性和详细的使用指南及技术支持也很重要。表现最佳的软件工具包括Trello、Asana和Slack,它们在功能适配和用户体验上表现优异。464 收藏 调用DALL·E生成图像的关键在于掌握API调用方式、核心参数和注意事项。1.首先需注册OpenAI账号并获取APIKey,使用Python库或HTTP工具发送请求;2.核心参数包括prompt(描述内容)、n(生成数量)、size(图像尺寸)、response_format(返回格式)和user(用户标识);3.常见问题涉及权限验证、费用控制、内容限制、网络延迟及缓存缺失等,务必注意避免错误和资源浪费。464 收藏

调用DALL·E生成图像的关键在于掌握API调用方式、核心参数和注意事项。1.首先需注册OpenAI账号并获取APIKey,使用Python库或HTTP工具发送请求;2.核心参数包括prompt(描述内容)、n(生成数量)、size(图像尺寸)、response_format(返回格式)和user(用户标识);3.常见问题涉及权限验证、费用控制、内容限制、网络延迟及缓存缺失等,务必注意避免错误和资源浪费。464 收藏 登录MemoAI网页端只需打开官网并选择手机号、邮箱或第三方账号登录即可;界面分为左侧边栏、中间内容区和右上角工具按钮,支持键盘快捷键提升效率;新建笔记可点击按钮或按N键,并支持Markdown格式排版;编辑笔记直接点击正文即可,系统自动保存;搜索通过顶部搜索框输入关键词实现,支持模糊匹配,整理笔记可用标签分类或拖拽至文件夹。464 收藏

登录MemoAI网页端只需打开官网并选择手机号、邮箱或第三方账号登录即可;界面分为左侧边栏、中间内容区和右上角工具按钮,支持键盘快捷键提升效率;新建笔记可点击按钮或按N键,并支持Markdown格式排版;编辑笔记直接点击正文即可,系统自动保存;搜索通过顶部搜索框输入关键词实现,支持模糊匹配,整理笔记可用标签分类或拖拽至文件夹。464 收藏 AI生成证件照的底层技术原理是深度学习、生成对抗网络(GANs)和计算机视觉算法的结合。1.深度学习模型通过大量真实证件照和普通照片训练,学会识别面部特征、背景和光线。2.GANs由生成器和判别器组成,通过对抗学习生成逼真的证件照。3.计算机视觉算法用于调整面部表情、角度和光线,提升生成质量。464 收藏

AI生成证件照的底层技术原理是深度学习、生成对抗网络(GANs)和计算机视觉算法的结合。1.深度学习模型通过大量真实证件照和普通照片训练,学会识别面部特征、背景和光线。2.GANs由生成器和判别器组成,通过对抗学习生成逼真的证件照。3.计算机视觉算法用于调整面部表情、角度和光线,提升生成质量。464 收藏 多模态AI模型的安全性可通过四方面措施加强:1.多模态内容过滤,包括使用先进算法、定期更新规则、设置多层验证;2.防范对抗攻击,通过增强鲁棒性、实时监控、数据预处理;3.跨域安全防护,实施传输过滤、加密通信、访问控制;4.指令遵循与幻觉抑制,优化指令数据、提升泛化能力、建立检测机制。464 收藏

多模态AI模型的安全性可通过四方面措施加强:1.多模态内容过滤,包括使用先进算法、定期更新规则、设置多层验证;2.防范对抗攻击,通过增强鲁棒性、实时监控、数据预处理;3.跨域安全防护,实施传输过滤、加密通信、访问控制;4.指令遵循与幻觉抑制,优化指令数据、提升泛化能力、建立检测机制。464 收藏 利用豆包AI生成高质量选题需注意三点:1.明确目标受众和内容方向;2.使用具体关键词和描述;3.检查并调整AI生成的选题。精确输入和人工审核是关键,确保选题符合标准和目标。464 收藏

利用豆包AI生成高质量选题需注意三点:1.明确目标受众和内容方向;2.使用具体关键词和描述;3.检查并调整AI生成的选题。精确输入和人工审核是关键,确保选题符合标准和目标。464 收藏 选择AI工具切入点在于找到最需解决的问题并动手操作,可快速上手的关键是使用基于文本的AI聊天机器人或写作助手;推荐文本生成类工具因其门槛低、反馈快,能直接提升效率;提示词应清晰具体、加入角色和上下文,并通过迭代优化提升效果;AI的应用不仅限于聊天和画图,还可用于学习、内容创作、数据处理及个人发展等多领域,成为多功能助手。464 收藏

选择AI工具切入点在于找到最需解决的问题并动手操作,可快速上手的关键是使用基于文本的AI聊天机器人或写作助手;推荐文本生成类工具因其门槛低、反馈快,能直接提升效率;提示词应清晰具体、加入角色和上下文,并通过迭代优化提升效果;AI的应用不仅限于聊天和画图,还可用于学习、内容创作、数据处理及个人发展等多领域,成为多功能助手。464 收藏 豆包AI写代码的关键在于清晰提问和具体描述。使用方法有三:1.在IDE安装插件并输入功能描述,如“写一个Python函数计算两个日期天数差”;2.由豆包AI生成代码草稿后复制或修改使用;3.适用于重复性高或模板化任务。常见问题包括语法错误、逻辑不符、库支持不全,解决方式是检查代码、细化需求描述、结合文档调整提示。提高代码质量需做到三点:1.提问要具体明确而非简单模糊;2.提供上下文如框架版本(如Flask+Python3.9);3.参照项目风格生成代码。用好豆包AI还需多试、多改、多总结。464 收藏

豆包AI写代码的关键在于清晰提问和具体描述。使用方法有三:1.在IDE安装插件并输入功能描述,如“写一个Python函数计算两个日期天数差”;2.由豆包AI生成代码草稿后复制或修改使用;3.适用于重复性高或模板化任务。常见问题包括语法错误、逻辑不符、库支持不全,解决方式是检查代码、细化需求描述、结合文档调整提示。提高代码质量需做到三点:1.提问要具体明确而非简单模糊;2.提供上下文如框架版本(如Flask+Python3.9);3.参照项目风格生成代码。用好豆包AI还需多试、多改、多总结。464 收藏 DeepseekAI在视频创意生成中的独特优势体现在其强大的联想发散能力、内容结构化梳理能力以及多模态理解与生成潜力。①它能从一个关键词联想到多个具体场景并生成详细描述,突破创意瓶颈;②可自动生成分镜脚本、旁白文案及时间轴建议,提升叙事逻辑性;③具备从抽象概念到执行指导的转化能力,辅助视觉与音乐风格落地。464 收藏

DeepseekAI在视频创意生成中的独特优势体现在其强大的联想发散能力、内容结构化梳理能力以及多模态理解与生成潜力。①它能从一个关键词联想到多个具体场景并生成详细描述,突破创意瓶颈;②可自动生成分镜脚本、旁白文案及时间轴建议,提升叙事逻辑性;③具备从抽象概念到执行指导的转化能力,辅助视觉与音乐风格落地。464 收藏 豆包AI导入自定义词典的核心操作是通过其“知识库”或“术语管理”模块上传特定格式的文件。具体步骤为:1.定位功能入口,如“知识库管理”或“自定义词典”;2.准备CSV或TXT格式的词典文件,注意使用UTF-8编码;3.上传并解析文件,确认词条识别正确;4.激活词典并应用到目标模型。自定义词典能提升AI的专业性、语境一致性、品牌形象和生成效率。常见问题包括格式错误、词条冲突、内容质量低和效果不明显,可通过规范文件格式、调整优先级、校对内容及检查激活状态解决。此外,结合领域语料投喂、提示词工程、少量样本学习、464 收藏

豆包AI导入自定义词典的核心操作是通过其“知识库”或“术语管理”模块上传特定格式的文件。具体步骤为:1.定位功能入口,如“知识库管理”或“自定义词典”;2.准备CSV或TXT格式的词典文件,注意使用UTF-8编码;3.上传并解析文件,确认词条识别正确;4.激活词典并应用到目标模型。自定义词典能提升AI的专业性、语境一致性、品牌形象和生成效率。常见问题包括格式错误、词条冲突、内容质量低和效果不明显,可通过规范文件格式、调整优先级、校对内容及检查激活状态解决。此外,结合领域语料投喂、提示词工程、少量样本学习、464 收藏 【小编科技】随着全球迈入新能源时代,电力已成为各行各业运转的核心动力。作为储能的关键载体,电池技术的进步直接映射出整个产业的发展方向。无论是新能源汽车还是智能手机,厂商们都在不断加码电池技术的研发,不仅追求更高的电池容量,更重视安全性与稳定性。唯有在多维度上同步突破,才能真正提升用户的使用体验与安全保障。在昨日举行的全新MG4预售发布会上,半固态电池技术的亮相成为全场焦点,也为10万元级别的两厢车型带来了前所未有的电池革新。发布会期间,#半固态电池强在哪儿#话题迅速登上热搜,引发网友广泛讨论。借此契机,464 收藏

【小编科技】随着全球迈入新能源时代,电力已成为各行各业运转的核心动力。作为储能的关键载体,电池技术的进步直接映射出整个产业的发展方向。无论是新能源汽车还是智能手机,厂商们都在不断加码电池技术的研发,不仅追求更高的电池容量,更重视安全性与稳定性。唯有在多维度上同步突破,才能真正提升用户的使用体验与安全保障。在昨日举行的全新MG4预售发布会上,半固态电池技术的亮相成为全场焦点,也为10万元级别的两厢车型带来了前所未有的电池革新。发布会期间,#半固态电池强在哪儿#话题迅速登上热搜,引发网友广泛讨论。借此契机,464 收藏 选择合适的AI数字人形象和声音需先明确视频主题与目标受众,再匹配相应风格的数字人和声音,确保形象、语气与内容协调一致;2.优化视频节奏感和画面匹配度可通过将文案分段、设置停顿、匹配关键词与背景、调整语速及添加视觉提示实现;3.新手常见问题包括数字人不自然、语音生硬、画面不匹配、节奏拖沓及生成失败,解决方案分别为增强文案情感表达、尝试不同声音模型、自定义背景素材、精简文案并分段输出、检查网络与素材大小,最终通过反复预览调整提升视频质量。464 收藏

选择合适的AI数字人形象和声音需先明确视频主题与目标受众,再匹配相应风格的数字人和声音,确保形象、语气与内容协调一致;2.优化视频节奏感和画面匹配度可通过将文案分段、设置停顿、匹配关键词与背景、调整语速及添加视觉提示实现;3.新手常见问题包括数字人不自然、语音生硬、画面不匹配、节奏拖沓及生成失败,解决方案分别为增强文案情感表达、尝试不同声音模型、自定义背景素材、精简文案并分段输出、检查网络与素材大小,最终通过反复预览调整提升视频质量。464 收藏 蝉镜智能解锁的核心安全机制在于融合多重生物识别、加密通信和情境感知;2.生物识别采用3D人脸识别、超声波指纹及活体检测技术,防止欺骗攻击;3.生物特征以加密模板形式存储于独立安全芯片,不上传云端,保障隐私;4.设备联动通过BLE或Wi-FiDirect建立加密连接,使用短时令牌和双向认证确保通信安全;5.情境感知动态调整安全策略,在可信环境降低门槛,在异常环境提升验证要求;6.网络中断时支持本地生物识别或PIN码解锁,保障离线可用性;7.提供机械钥匙、一次性密码等备用方案,防止用户被锁门外;8.手机丢失后464 收藏

蝉镜智能解锁的核心安全机制在于融合多重生物识别、加密通信和情境感知;2.生物识别采用3D人脸识别、超声波指纹及活体检测技术,防止欺骗攻击;3.生物特征以加密模板形式存储于独立安全芯片,不上传云端,保障隐私;4.设备联动通过BLE或Wi-FiDirect建立加密连接,使用短时令牌和双向认证确保通信安全;5.情境感知动态调整安全策略,在可信环境降低门槛,在异常环境提升验证要求;6.网络中断时支持本地生物识别或PIN码解锁,保障离线可用性;7.提供机械钥匙、一次性密码等备用方案,防止用户被锁门外;8.手机丢失后464 收藏 8月1日起,上海浦东新区金桥与花木片区的市民正式迎来了一种崭新的出行方式——搭乘小马智行的全无人驾驶Robotaxi。据悉,小马智行作为首批取得上海最新一批智能网联汽车示范运营资质的企业,携手锦江出租率先在浦东金桥、花木区域启动面向公众的常态化Robotaxi服务。从每周一至周五的早上7:30到晚上9:30,市民只需打开“小马智行”App或使用其打车小程序,即可预约无人驾驶车辆,轻松开启智能出行。该服务时段全面覆盖早晚通勤高峰及日常休闲出行需求,运营路线贯穿浦东新区人民政府、啦啦宝都购物中心、世纪公园、浦464 收藏

8月1日起,上海浦东新区金桥与花木片区的市民正式迎来了一种崭新的出行方式——搭乘小马智行的全无人驾驶Robotaxi。据悉,小马智行作为首批取得上海最新一批智能网联汽车示范运营资质的企业,携手锦江出租率先在浦东金桥、花木区域启动面向公众的常态化Robotaxi服务。从每周一至周五的早上7:30到晚上9:30,市民只需打开“小马智行”App或使用其打车小程序,即可预约无人驾驶车辆,轻松开启智能出行。该服务时段全面覆盖早晚通勤高峰及日常休闲出行需求,运营路线贯穿浦东新区人民政府、啦啦宝都购物中心、世纪公园、浦464 收藏