-

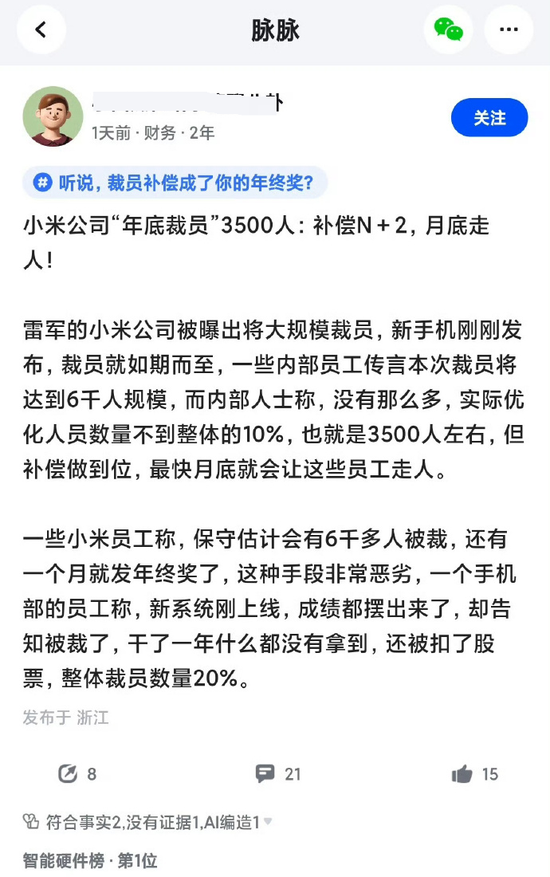

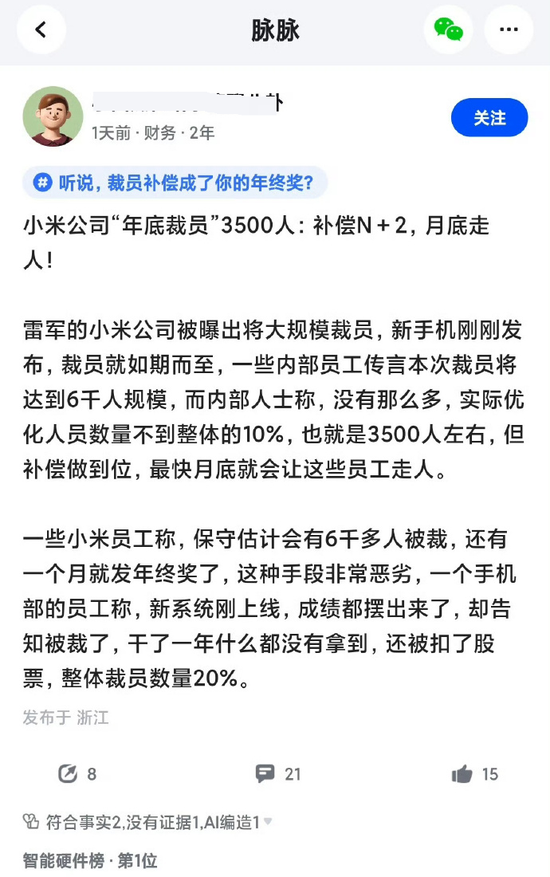

小米辟谣年底裁员3500人传闻:纯属造谣!近日,网络上流传小米公司年底将裁员3500人的消息,补偿方案为“N+2”,引发广泛关注。对此,小米集团公关部总经理王化于12月24日晚间公开辟谣。王化在其个人社交媒体账号上表示,每年年底都会出现类似的裁员谣言,此次传闻尤其离谱,并质疑了传闻中提及的裁员规模(6000人规模、3500人、不到10%、整体20%)的可信度,指出如此大规模的裁员行为必须向有关部门报备,质疑传闻缺乏基本常识。值得注意的是,这并非王化近期首次辟谣有关小米集团的裁员或招聘传闻。此前,他还针对“

-

加拿大电动商用车制造商LionElectric近日宣布,已在美国和加拿大同时申请破产保护。这家曾是北美首家同时在美国和加拿大上市的电动汽车公司,其市值一度突破300亿元人民币。LionElectric创立于2008年,最初以生产黄色校车起家,随后全面转型为全电动巴士生产商,并成为加拿大首家实现巴士生产和电池制造自动化整合的企业。该公司在电动巴士领域取得了显著的成就。2014年,LionElectric与LG化学建立合作关系,采购电芯并自主研发电池管理系统(BMS)。次年,其首款全电动巴士eLion正式面世

-

2024年,低空经济在中国迎来元年。无人机、电动垂直起降飞行器(eVTOL)和通用航空飞行器是其核心驱动力。然而,大规模无人机群的安全性融入现有智慧城市系统,是摆在科学家面前的一大挑战。北京大学工学院航空航天工程系、湍流与复杂系统国家重点实验室黄迅教授团队,基于其在气动噪声、空气动力学和飞行智能控制方面的研究积累,深入分析了无人机赋能低空经济面临的四个关键问题,相关成果以评论文章的形式,于2024年12月19日在线发表于《自然》(Nature)期刊(“Thesmall-dronerevolutionisc

-

科技周边小白一枚,正在不断学习积累知识,现将学习到的知识记录一下,也是将我的所得分享给大家!而今天这篇文章《业界盼AI应用潮带动复甦》带大家来了解一下##content_title##,希望对大

-

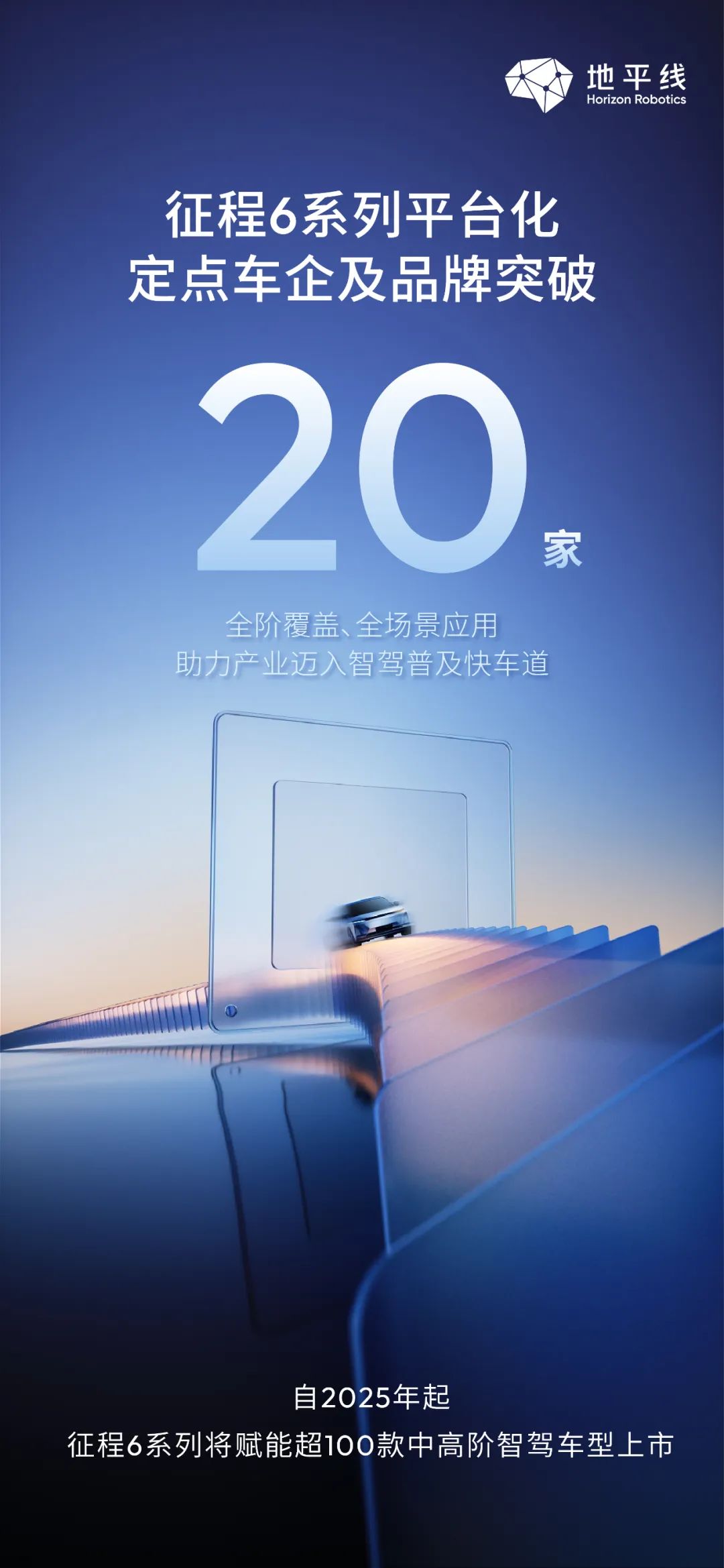

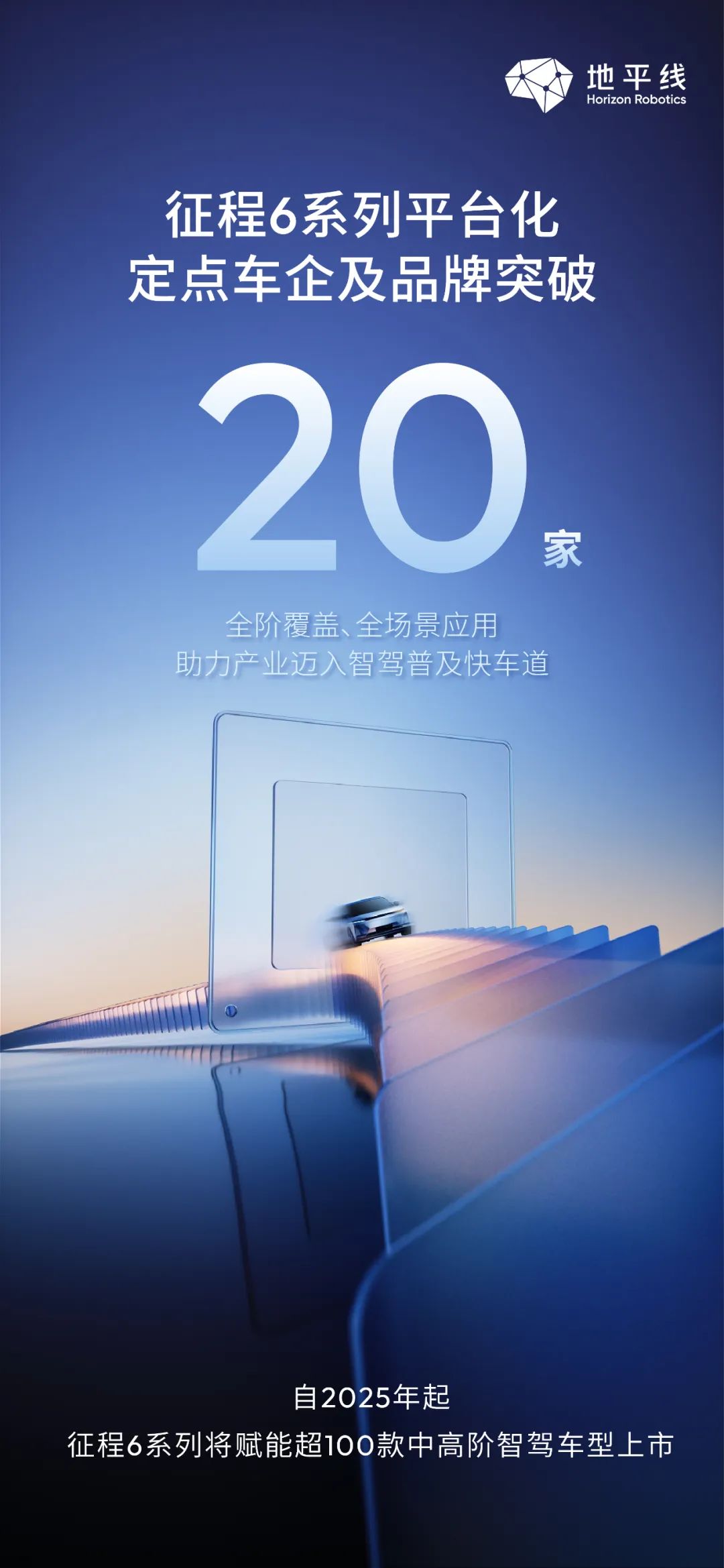

地平线2024生态大会:征程6系列智驾方案再获突破,赋能百款车型地平线在2024生态大会上宣布,其征程6系列智能驾驶方案已与超过20家车企及汽车品牌达成合作,自四月发布以来新增合作夥伴超过10家,涵盖国内外头部车企、新势力车企及合资车企。从2025年起,征程6系列将助力超过100款中高阶智能驾驶车型上市,预计到2025年,征程家族的累计出货量将突破1000万套,成为国内首个突破千万级量产的智驾科技品牌。地平线提供全阶、全场景智能驾驶解决方案,征程6系列及其量产方案能够灵活满足不同车企的差异化需求,显著缩短

-

特斯拉ModelY老款正式停产,焕新版独占市场!汽车博主@胖虎Shawn爆料,今日起,老款特斯拉ModelY正式退出市场,消费者只能选择焕新版ModelY。1月10日,特斯拉中国发布了焕新版ModelY,后轮驱动版起售价26.35万元,长续航全轮驱动版起售价30.35万元。特斯拉官方表示,该车型是目前续航里程最长的ModelY,最高可达719公里。焕新版ModelY不仅动力升级,外观内饰也焕然一新。重新设计的前脸和尾部更显现代感,内饰更加精致。后排乘客配备全新娱乐屏幕,悬挂系统也经过优

-

全球最大太阳能和电池联合储能项目——阿联酋RTC项目,其电池储能系统供应商花落宁德时代。马斯达尔公司正式宣布这一消息,该项目总投资额超过60亿美元,包含5.2GW光伏项目和总容量达19GWh的电池储能系统,宁德时代将为此项目提供其先进的天恒电池储能系统。此次合作将助力宁德时代拓展国际市场。依托罗尔斯罗伊斯在欧洲的市场渠道和品牌影响力,天恒储能系统有望在欧盟和英国市场迅速推广,进一步巩固宁德时代在全球储能领域的领先地位。对罗尔斯罗伊斯而言,引进宁德时代先进的天恒储能系统,将完善其能源存储解决方案,提升

-

水晶光电近期机构调研纪要显示,公司在光学创新升级方面取得显著进展。在手机业务领域,公司不仅满足客户对产品性能的要求,更注重性价比,从而成为客户的技术战略合作伙伴。预计2025年,公司将有机会进入大客户旋涂滤光片供应链,凭借高性价比优势赢得市场份额。目前,旋涂滤光片已成为北美大客户所有机型前后摄的标配,但此前主要由海外供应商供应。水晶光电有望从涂胶端切入,公司计划首年确保产品品质稳定,并逐步提升市场渗透率。安卓头部客户的回归以及AI赋能,也为消费电子光学硬件带来了新的需求和更高标准,例如环境感知等,水晶

-

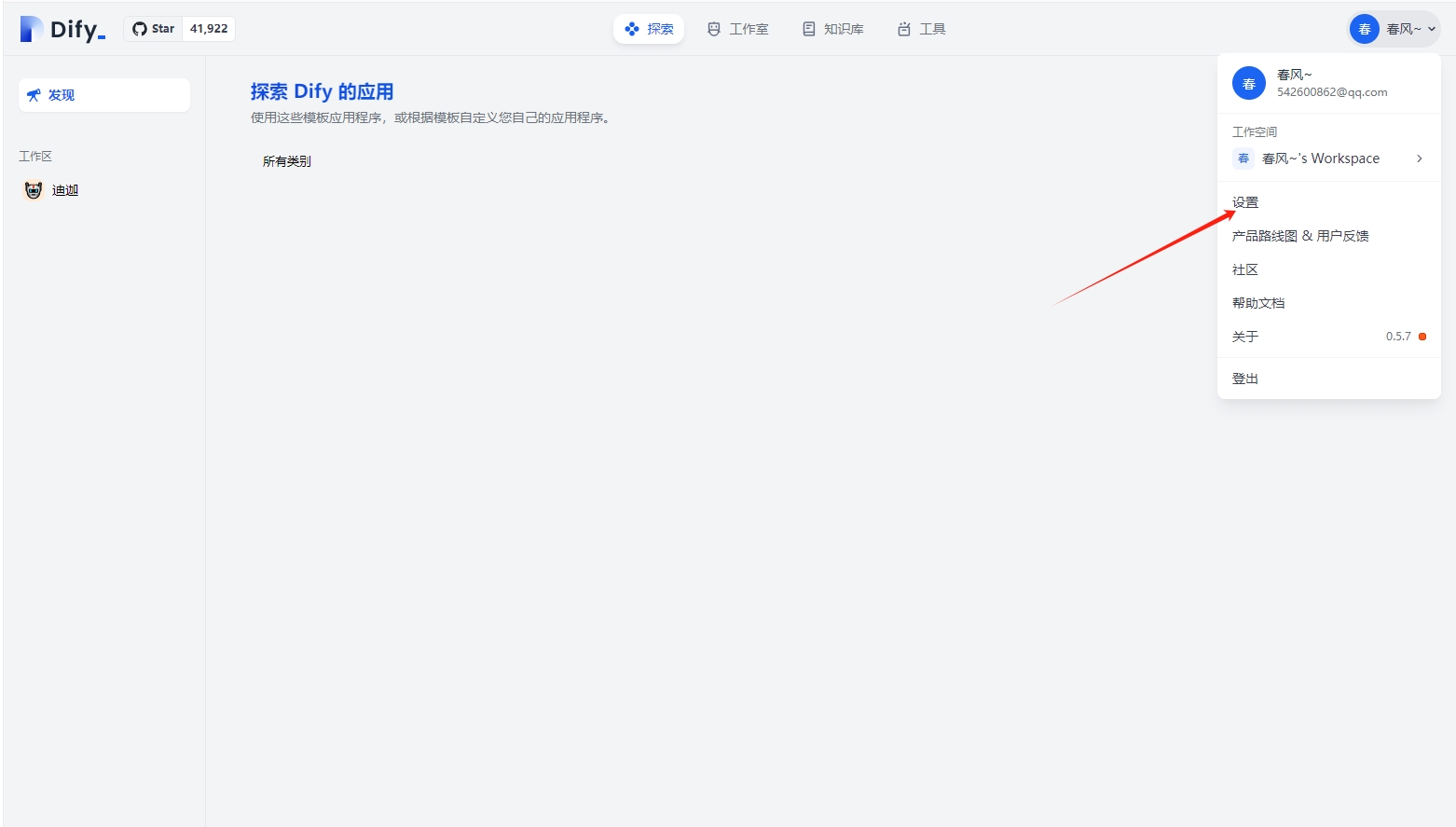

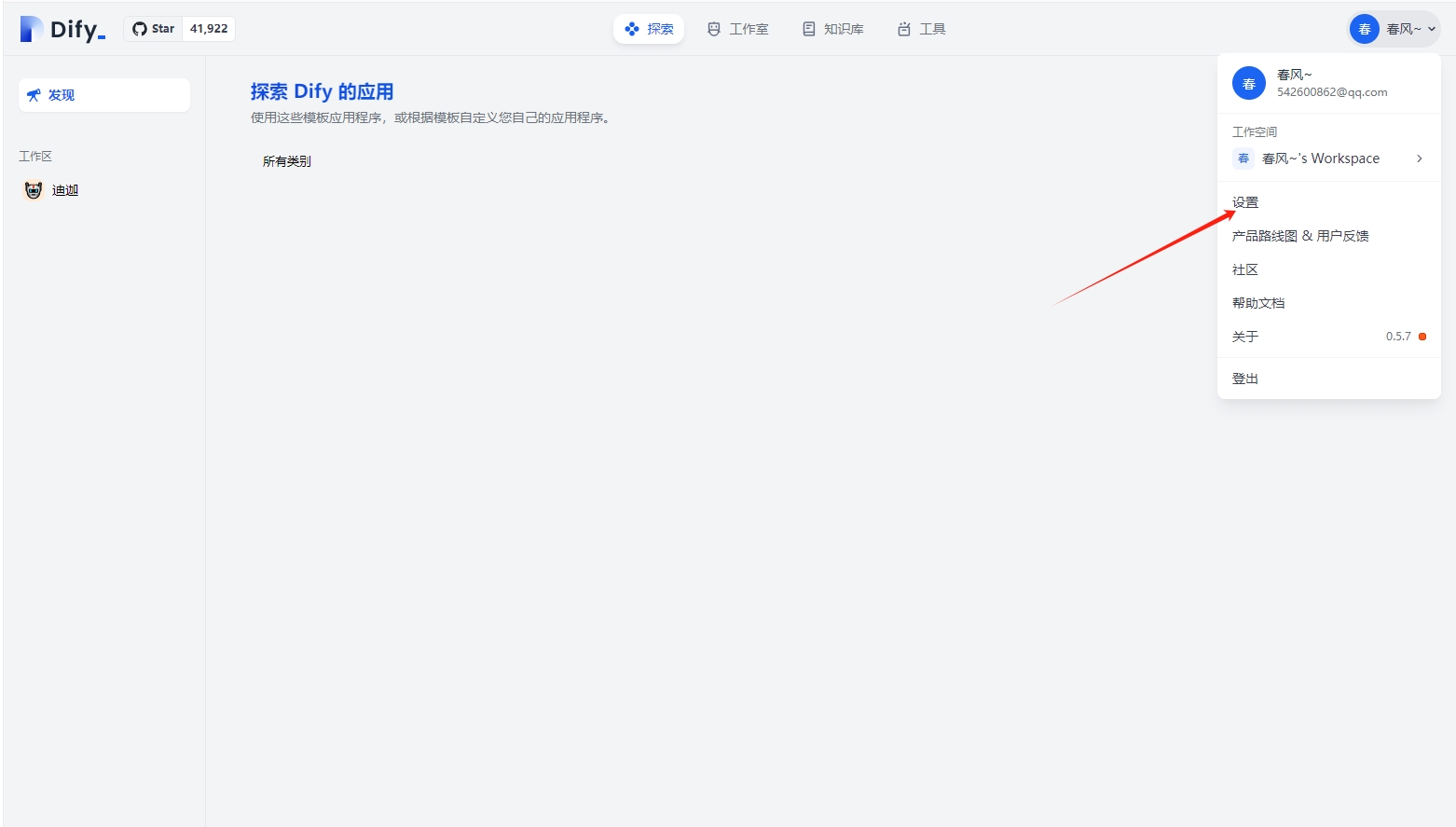

Dify支持集成Ollama部署的大型语言模型(LLM)推理和嵌入能力。快速集成指南下载并运行Ollama:请参考Ollama官方文档进行本地部署和配置。运行Ollama并启动Llama模型,例如:ollamarunllama3.1。成功启动后,Ollama会在本地11434端口启动API服务,访问地址为http://localhost:11434。更多模型信息请访问https://ollama.ai/library。在Dify中配置Oll

-

2025年前两个月,中国新能源汽车市场竞争激烈,新势力车企交付成绩单已陆续公布。小鹏、鸿蒙智行和理想汽车占据前三甲位置。数据显示,小鹏汽车以60803辆的交付量领跑,同比增长高达358.03%,展现出强劲的市场复苏势头。紧随其后的是鸿蒙智行,交付量达56504辆,同比增长3.13%。理想汽车以56190辆的交付量位列第三,同比增长7.37%,在高端SUV市场保持稳定增长。零跑汽车表现亮眼,交付量达到50457辆,同比增长191.98%,展现出强劲的增长潜力。小米汽车虽然未公布具体数据,但前两个月交

-

Pollinations.AI是一个开源的AI内容生成平台,提供免费且易于使用的文本和图像生成API。Pollinations.AI无需注册或API密钥即可使用,支持多种功能,包括图像生成、文本生成、文生音频、音频转文字及视觉内容解析。Pollinations.AI提供丰富的API接口和SDK,方便开发者快速集成。Pollinations.AI推出了基于浏览器的开发环境Pollinations.DIY,进一步降低了开发门槛,适合开发者、创作者和AI爱好者使用。Pollinations.AI的主要功能包括

-

4月28日,天力锂能发布了2024年度的业绩报告,报告中指出,由于主要原材料锂源价格的大幅下跌,产品售价同比下降了40.55%,导致营业收入为17.54亿元,同比下降28.23%。归属于上市公司股东的净亏损为4.29亿元,比上年同期亏损减少了14.5%;扣除非经常性损益后的净亏损为4.28亿元,同比减亏11.43%。报告期内,公司的主营业务收入主要来自于三元材料、磷酸铁锂及碳酸锂等锂电池材料的销售。其中,三元材料是公司的核心产品,收入占比约为89.73%,磷酸铁锂占比约为4.23%,碳酸锂占比约为3.4%

-

在VSStudio中配置通义灵码需要以下步骤:1.打开VSStudio,进入“工具”菜单,选择“选项”,然后在“环境”下的“扩展和更新”中搜索并安装通义灵码插件。2.重启VSStudio后,通义灵码即可使用。常见问题及解决方法包括:1.检查插件兼容性或更新VSStudio以解决插件加载问题。2.更新通义灵码或VSStudio以解决代码提示和语法高亮问题。3.手动编辑配置文件确保通义灵码正确识别代码。优化使用体验可以通过调整设置、学习快捷键和寻求社区帮助来实现。

-

乘联分会最新数据显示,2025年4月国内乘用车零售市场表现出多样化的趋势。当月,全国乘用车零售总量达到175.5万辆,同比增长14.5%,但与上月相比下降了9.4%。其中,新能源汽车的零售销量为90.5万辆,同比增长33.9%,但环比下降8.7%,渗透率上升至52%。从1月至4月,国内狭义乘用车累计零售达687.2万辆,同比增长7.9%。以下是2025年4月中国车企零售销量排名前十的列表:第一名,比亚迪汽车,销量26.8万辆,增长5.8%。第二名,吉利汽车,销量20.9万辆,增长81.4%。第三名,一汽大

-

生成AI证件照时,肤色调整通过复杂的图像处理技术和算法实现,使照片看起来更加自然和真实。1.肤色检测和分离技术通过机器学习模型准确识别皮肤区域。2.调整色调、饱和度和亮度,考虑个人肤色类型和光照条件。3.使用高级技术如深度学习模型和A/B测试来优化效果,确保符合不同地区和文化的审美标准。

小米辟谣年底裁员3500人传闻:纯属造谣!近日,网络上流传小米公司年底将裁员3500人的消息,补偿方案为“N+2”,引发广泛关注。对此,小米集团公关部总经理王化于12月24日晚间公开辟谣。王化在其个人社交媒体账号上表示,每年年底都会出现类似的裁员谣言,此次传闻尤其离谱,并质疑了传闻中提及的裁员规模(6000人规模、3500人、不到10%、整体20%)的可信度,指出如此大规模的裁员行为必须向有关部门报备,质疑传闻缺乏基本常识。值得注意的是,这并非王化近期首次辟谣有关小米集团的裁员或招聘传闻。此前,他还针对“462 收藏

小米辟谣年底裁员3500人传闻:纯属造谣!近日,网络上流传小米公司年底将裁员3500人的消息,补偿方案为“N+2”,引发广泛关注。对此,小米集团公关部总经理王化于12月24日晚间公开辟谣。王化在其个人社交媒体账号上表示,每年年底都会出现类似的裁员谣言,此次传闻尤其离谱,并质疑了传闻中提及的裁员规模(6000人规模、3500人、不到10%、整体20%)的可信度,指出如此大规模的裁员行为必须向有关部门报备,质疑传闻缺乏基本常识。值得注意的是,这并非王化近期首次辟谣有关小米集团的裁员或招聘传闻。此前,他还针对“462 收藏 加拿大电动商用车制造商LionElectric近日宣布,已在美国和加拿大同时申请破产保护。这家曾是北美首家同时在美国和加拿大上市的电动汽车公司,其市值一度突破300亿元人民币。LionElectric创立于2008年,最初以生产黄色校车起家,随后全面转型为全电动巴士生产商,并成为加拿大首家实现巴士生产和电池制造自动化整合的企业。该公司在电动巴士领域取得了显著的成就。2014年,LionElectric与LG化学建立合作关系,采购电芯并自主研发电池管理系统(BMS)。次年,其首款全电动巴士eLion正式面世462 收藏

加拿大电动商用车制造商LionElectric近日宣布,已在美国和加拿大同时申请破产保护。这家曾是北美首家同时在美国和加拿大上市的电动汽车公司,其市值一度突破300亿元人民币。LionElectric创立于2008年,最初以生产黄色校车起家,随后全面转型为全电动巴士生产商,并成为加拿大首家实现巴士生产和电池制造自动化整合的企业。该公司在电动巴士领域取得了显著的成就。2014年,LionElectric与LG化学建立合作关系,采购电芯并自主研发电池管理系统(BMS)。次年,其首款全电动巴士eLion正式面世462 收藏 2024年,低空经济在中国迎来元年。无人机、电动垂直起降飞行器(eVTOL)和通用航空飞行器是其核心驱动力。然而,大规模无人机群的安全性融入现有智慧城市系统,是摆在科学家面前的一大挑战。北京大学工学院航空航天工程系、湍流与复杂系统国家重点实验室黄迅教授团队,基于其在气动噪声、空气动力学和飞行智能控制方面的研究积累,深入分析了无人机赋能低空经济面临的四个关键问题,相关成果以评论文章的形式,于2024年12月19日在线发表于《自然》(Nature)期刊(“Thesmall-dronerevolutionisc462 收藏

2024年,低空经济在中国迎来元年。无人机、电动垂直起降飞行器(eVTOL)和通用航空飞行器是其核心驱动力。然而,大规模无人机群的安全性融入现有智慧城市系统,是摆在科学家面前的一大挑战。北京大学工学院航空航天工程系、湍流与复杂系统国家重点实验室黄迅教授团队,基于其在气动噪声、空气动力学和飞行智能控制方面的研究积累,深入分析了无人机赋能低空经济面临的四个关键问题,相关成果以评论文章的形式,于2024年12月19日在线发表于《自然》(Nature)期刊(“Thesmall-dronerevolutionisc462 收藏 科技周边小白一枚,正在不断学习积累知识,现将学习到的知识记录一下,也是将我的所得分享给大家!而今天这篇文章《业界盼AI应用潮带动复甦》带大家来了解一下##content_title##,希望对大462 收藏

科技周边小白一枚,正在不断学习积累知识,现将学习到的知识记录一下,也是将我的所得分享给大家!而今天这篇文章《业界盼AI应用潮带动复甦》带大家来了解一下##content_title##,希望对大462 收藏 地平线2024生态大会:征程6系列智驾方案再获突破,赋能百款车型地平线在2024生态大会上宣布,其征程6系列智能驾驶方案已与超过20家车企及汽车品牌达成合作,自四月发布以来新增合作夥伴超过10家,涵盖国内外头部车企、新势力车企及合资车企。从2025年起,征程6系列将助力超过100款中高阶智能驾驶车型上市,预计到2025年,征程家族的累计出货量将突破1000万套,成为国内首个突破千万级量产的智驾科技品牌。地平线提供全阶、全场景智能驾驶解决方案,征程6系列及其量产方案能够灵活满足不同车企的差异化需求,显著缩短462 收藏

地平线2024生态大会:征程6系列智驾方案再获突破,赋能百款车型地平线在2024生态大会上宣布,其征程6系列智能驾驶方案已与超过20家车企及汽车品牌达成合作,自四月发布以来新增合作夥伴超过10家,涵盖国内外头部车企、新势力车企及合资车企。从2025年起,征程6系列将助力超过100款中高阶智能驾驶车型上市,预计到2025年,征程家族的累计出货量将突破1000万套,成为国内首个突破千万级量产的智驾科技品牌。地平线提供全阶、全场景智能驾驶解决方案,征程6系列及其量产方案能够灵活满足不同车企的差异化需求,显著缩短462 收藏 特斯拉ModelY老款正式停产,焕新版独占市场!汽车博主@胖虎Shawn爆料,今日起,老款特斯拉ModelY正式退出市场,消费者只能选择焕新版ModelY。1月10日,特斯拉中国发布了焕新版ModelY,后轮驱动版起售价26.35万元,长续航全轮驱动版起售价30.35万元。特斯拉官方表示,该车型是目前续航里程最长的ModelY,最高可达719公里。焕新版ModelY不仅动力升级,外观内饰也焕然一新。重新设计的前脸和尾部更显现代感,内饰更加精致。后排乘客配备全新娱乐屏幕,悬挂系统也经过优462 收藏

特斯拉ModelY老款正式停产,焕新版独占市场!汽车博主@胖虎Shawn爆料,今日起,老款特斯拉ModelY正式退出市场,消费者只能选择焕新版ModelY。1月10日,特斯拉中国发布了焕新版ModelY,后轮驱动版起售价26.35万元,长续航全轮驱动版起售价30.35万元。特斯拉官方表示,该车型是目前续航里程最长的ModelY,最高可达719公里。焕新版ModelY不仅动力升级,外观内饰也焕然一新。重新设计的前脸和尾部更显现代感,内饰更加精致。后排乘客配备全新娱乐屏幕,悬挂系统也经过优462 收藏 全球最大太阳能和电池联合储能项目——阿联酋RTC项目,其电池储能系统供应商花落宁德时代。马斯达尔公司正式宣布这一消息,该项目总投资额超过60亿美元,包含5.2GW光伏项目和总容量达19GWh的电池储能系统,宁德时代将为此项目提供其先进的天恒电池储能系统。此次合作将助力宁德时代拓展国际市场。依托罗尔斯罗伊斯在欧洲的市场渠道和品牌影响力,天恒储能系统有望在欧盟和英国市场迅速推广,进一步巩固宁德时代在全球储能领域的领先地位。对罗尔斯罗伊斯而言,引进宁德时代先进的天恒储能系统,将完善其能源存储解决方案,提升462 收藏

全球最大太阳能和电池联合储能项目——阿联酋RTC项目,其电池储能系统供应商花落宁德时代。马斯达尔公司正式宣布这一消息,该项目总投资额超过60亿美元,包含5.2GW光伏项目和总容量达19GWh的电池储能系统,宁德时代将为此项目提供其先进的天恒电池储能系统。此次合作将助力宁德时代拓展国际市场。依托罗尔斯罗伊斯在欧洲的市场渠道和品牌影响力,天恒储能系统有望在欧盟和英国市场迅速推广,进一步巩固宁德时代在全球储能领域的领先地位。对罗尔斯罗伊斯而言,引进宁德时代先进的天恒储能系统,将完善其能源存储解决方案,提升462 收藏 水晶光电近期机构调研纪要显示,公司在光学创新升级方面取得显著进展。在手机业务领域,公司不仅满足客户对产品性能的要求,更注重性价比,从而成为客户的技术战略合作伙伴。预计2025年,公司将有机会进入大客户旋涂滤光片供应链,凭借高性价比优势赢得市场份额。目前,旋涂滤光片已成为北美大客户所有机型前后摄的标配,但此前主要由海外供应商供应。水晶光电有望从涂胶端切入,公司计划首年确保产品品质稳定,并逐步提升市场渗透率。安卓头部客户的回归以及AI赋能,也为消费电子光学硬件带来了新的需求和更高标准,例如环境感知等,水晶462 收藏

水晶光电近期机构调研纪要显示,公司在光学创新升级方面取得显著进展。在手机业务领域,公司不仅满足客户对产品性能的要求,更注重性价比,从而成为客户的技术战略合作伙伴。预计2025年,公司将有机会进入大客户旋涂滤光片供应链,凭借高性价比优势赢得市场份额。目前,旋涂滤光片已成为北美大客户所有机型前后摄的标配,但此前主要由海外供应商供应。水晶光电有望从涂胶端切入,公司计划首年确保产品品质稳定,并逐步提升市场渗透率。安卓头部客户的回归以及AI赋能,也为消费电子光学硬件带来了新的需求和更高标准,例如环境感知等,水晶462 收藏 Dify支持集成Ollama部署的大型语言模型(LLM)推理和嵌入能力。快速集成指南下载并运行Ollama:请参考Ollama官方文档进行本地部署和配置。运行Ollama并启动Llama模型,例如:ollamarunllama3.1。成功启动后,Ollama会在本地11434端口启动API服务,访问地址为http://localhost:11434。更多模型信息请访问https://ollama.ai/library。在Dify中配置Oll462 收藏

Dify支持集成Ollama部署的大型语言模型(LLM)推理和嵌入能力。快速集成指南下载并运行Ollama:请参考Ollama官方文档进行本地部署和配置。运行Ollama并启动Llama模型,例如:ollamarunllama3.1。成功启动后,Ollama会在本地11434端口启动API服务,访问地址为http://localhost:11434。更多模型信息请访问https://ollama.ai/library。在Dify中配置Oll462 收藏 2025年前两个月,中国新能源汽车市场竞争激烈,新势力车企交付成绩单已陆续公布。小鹏、鸿蒙智行和理想汽车占据前三甲位置。数据显示,小鹏汽车以60803辆的交付量领跑,同比增长高达358.03%,展现出强劲的市场复苏势头。紧随其后的是鸿蒙智行,交付量达56504辆,同比增长3.13%。理想汽车以56190辆的交付量位列第三,同比增长7.37%,在高端SUV市场保持稳定增长。零跑汽车表现亮眼,交付量达到50457辆,同比增长191.98%,展现出强劲的增长潜力。小米汽车虽然未公布具体数据,但前两个月交462 收藏

2025年前两个月,中国新能源汽车市场竞争激烈,新势力车企交付成绩单已陆续公布。小鹏、鸿蒙智行和理想汽车占据前三甲位置。数据显示,小鹏汽车以60803辆的交付量领跑,同比增长高达358.03%,展现出强劲的市场复苏势头。紧随其后的是鸿蒙智行,交付量达56504辆,同比增长3.13%。理想汽车以56190辆的交付量位列第三,同比增长7.37%,在高端SUV市场保持稳定增长。零跑汽车表现亮眼,交付量达到50457辆,同比增长191.98%,展现出强劲的增长潜力。小米汽车虽然未公布具体数据,但前两个月交462 收藏 Pollinations.AI是一个开源的AI内容生成平台,提供免费且易于使用的文本和图像生成API。Pollinations.AI无需注册或API密钥即可使用,支持多种功能,包括图像生成、文本生成、文生音频、音频转文字及视觉内容解析。Pollinations.AI提供丰富的API接口和SDK,方便开发者快速集成。Pollinations.AI推出了基于浏览器的开发环境Pollinations.DIY,进一步降低了开发门槛,适合开发者、创作者和AI爱好者使用。Pollinations.AI的主要功能包括462 收藏

Pollinations.AI是一个开源的AI内容生成平台,提供免费且易于使用的文本和图像生成API。Pollinations.AI无需注册或API密钥即可使用,支持多种功能,包括图像生成、文本生成、文生音频、音频转文字及视觉内容解析。Pollinations.AI提供丰富的API接口和SDK,方便开发者快速集成。Pollinations.AI推出了基于浏览器的开发环境Pollinations.DIY,进一步降低了开发门槛,适合开发者、创作者和AI爱好者使用。Pollinations.AI的主要功能包括462 收藏 4月28日,天力锂能发布了2024年度的业绩报告,报告中指出,由于主要原材料锂源价格的大幅下跌,产品售价同比下降了40.55%,导致营业收入为17.54亿元,同比下降28.23%。归属于上市公司股东的净亏损为4.29亿元,比上年同期亏损减少了14.5%;扣除非经常性损益后的净亏损为4.28亿元,同比减亏11.43%。报告期内,公司的主营业务收入主要来自于三元材料、磷酸铁锂及碳酸锂等锂电池材料的销售。其中,三元材料是公司的核心产品,收入占比约为89.73%,磷酸铁锂占比约为4.23%,碳酸锂占比约为3.4%462 收藏

4月28日,天力锂能发布了2024年度的业绩报告,报告中指出,由于主要原材料锂源价格的大幅下跌,产品售价同比下降了40.55%,导致营业收入为17.54亿元,同比下降28.23%。归属于上市公司股东的净亏损为4.29亿元,比上年同期亏损减少了14.5%;扣除非经常性损益后的净亏损为4.28亿元,同比减亏11.43%。报告期内,公司的主营业务收入主要来自于三元材料、磷酸铁锂及碳酸锂等锂电池材料的销售。其中,三元材料是公司的核心产品,收入占比约为89.73%,磷酸铁锂占比约为4.23%,碳酸锂占比约为3.4%462 收藏 在VSStudio中配置通义灵码需要以下步骤:1.打开VSStudio,进入“工具”菜单,选择“选项”,然后在“环境”下的“扩展和更新”中搜索并安装通义灵码插件。2.重启VSStudio后,通义灵码即可使用。常见问题及解决方法包括:1.检查插件兼容性或更新VSStudio以解决插件加载问题。2.更新通义灵码或VSStudio以解决代码提示和语法高亮问题。3.手动编辑配置文件确保通义灵码正确识别代码。优化使用体验可以通过调整设置、学习快捷键和寻求社区帮助来实现。462 收藏

在VSStudio中配置通义灵码需要以下步骤:1.打开VSStudio,进入“工具”菜单,选择“选项”,然后在“环境”下的“扩展和更新”中搜索并安装通义灵码插件。2.重启VSStudio后,通义灵码即可使用。常见问题及解决方法包括:1.检查插件兼容性或更新VSStudio以解决插件加载问题。2.更新通义灵码或VSStudio以解决代码提示和语法高亮问题。3.手动编辑配置文件确保通义灵码正确识别代码。优化使用体验可以通过调整设置、学习快捷键和寻求社区帮助来实现。462 收藏 乘联分会最新数据显示,2025年4月国内乘用车零售市场表现出多样化的趋势。当月,全国乘用车零售总量达到175.5万辆,同比增长14.5%,但与上月相比下降了9.4%。其中,新能源汽车的零售销量为90.5万辆,同比增长33.9%,但环比下降8.7%,渗透率上升至52%。从1月至4月,国内狭义乘用车累计零售达687.2万辆,同比增长7.9%。以下是2025年4月中国车企零售销量排名前十的列表:第一名,比亚迪汽车,销量26.8万辆,增长5.8%。第二名,吉利汽车,销量20.9万辆,增长81.4%。第三名,一汽大462 收藏

乘联分会最新数据显示,2025年4月国内乘用车零售市场表现出多样化的趋势。当月,全国乘用车零售总量达到175.5万辆,同比增长14.5%,但与上月相比下降了9.4%。其中,新能源汽车的零售销量为90.5万辆,同比增长33.9%,但环比下降8.7%,渗透率上升至52%。从1月至4月,国内狭义乘用车累计零售达687.2万辆,同比增长7.9%。以下是2025年4月中国车企零售销量排名前十的列表:第一名,比亚迪汽车,销量26.8万辆,增长5.8%。第二名,吉利汽车,销量20.9万辆,增长81.4%。第三名,一汽大462 收藏 生成AI证件照时,肤色调整通过复杂的图像处理技术和算法实现,使照片看起来更加自然和真实。1.肤色检测和分离技术通过机器学习模型准确识别皮肤区域。2.调整色调、饱和度和亮度,考虑个人肤色类型和光照条件。3.使用高级技术如深度学习模型和A/B测试来优化效果,确保符合不同地区和文化的审美标准。462 收藏

生成AI证件照时,肤色调整通过复杂的图像处理技术和算法实现,使照片看起来更加自然和真实。1.肤色检测和分离技术通过机器学习模型准确识别皮肤区域。2.调整色调、饱和度和亮度,考虑个人肤色类型和光照条件。3.使用高级技术如深度学习模型和A/B测试来优化效果,确保符合不同地区和文化的审美标准。462 收藏