-

即梦4.0支持通过文本指令生成三维虚拟场景,用户可输入自然语言描述创建环境,如“黄昏下的沙漠绿洲”,系统将自动渲染;结合结构化关键词(如环境、建筑、氛围类)可优化细节精度;还可选择“草图+文本”模式,上传手绘轮廓并补充说明,实现更精准的AI场景构建。

-

虚拟伴侣通过情感计算技术实时识别用户情绪,首先利用语音分析提取语调、语速等特征并结合MFCC、F0等参数输入SVM或DNN模型判断情绪;其次通过NLP技术解析文本分词与语法结构,匹配情绪词典并借助BERT模型识别语义中的隐含情绪;再通过摄像头采集面部图像,使用CNN检测关键点并比对AU组合识别表情情绪;最后采用多模态融合策略,整合语音、文本、面部及生理信号,利用注意力机制加权各模态置信度,经融合模型输出最终情绪状态,动态调整回应策略。

-

首先打开即梦4.0的“设置”中“键盘与快捷方式”,进入“自定义快捷键”页面,点击+添加新快捷键,选择功能并设置组合键如Command+Shift+E,保存后生效;可双击修改或点击-删除已有快捷键;通过导出配置为.json文件并在其他设备导入,实现多端同步。

-

使用夸克AI优化文本需依次执行四步:一、通过“智能润色”提升语言流畅度;二、利用“风格化改写”适配不同表达场景;三、启用“关键词优化”增强主题相关性;四、运行“语法纠错”确保语言规范,全面提升内容质量。

-

GPT-5并非万能,其高效使用的核心在于精细化沟通与严格质量把控,必须通过明确角色设定、提供充分上下文、清晰目标与约束、示例引导、思维链提示等方式设计高质量提示词,并在多轮迭代中持续优化输出;同时要警惕其“幻觉”和数据偏差,对关键信息进行人工核查,避免在敏感领域过度依赖;最终应将其融入工作流,通过任务拆解、人机协同、API自动化及RAG等技术构建专家系统,实现从单次交互到高效自动化协作的跃迁,真正发挥其作为“数字分身”的潜力。

-

即梦4.0可通过智能美化功能改善肤色暗沉、五官不立体等问题。首先启用智能人物美化模式,系统基于人脸识别自动优化人脸亮度、对比度与色彩平衡;接着使用一键美颜功能,整合磨皮、瘦脸、大眼等技术快速提升面容质感,并通过强度调节保持皮肤自然纹理;随后进入细节编辑,手动增强眼睛明亮度、校正唇色及调整面部轮廓以强化立体感;再结合AI抠图与背景虚化技术分离主体,突出人物视觉中心;最后可将常用参数保存为自定义模板,便于后续高效复用,全面提升人像处理质量与效率。

-

文心一言官网为https://yiyan.baidu.com/,用户可免登录在线体验其多轮对话、内容创作、逻辑推理、代码编写等功能,界面简洁,响应迅速,支持长文本处理与进阶服务。

-

即梦4.0可在iPadPro上实现AI风格迁移,先导入源图像与目标图像,再调整风格强度至70%左右,开启多层细节优化模式提升画质,最后点击“开始迁移”生成并导出结果。

-

可通过智慧场景联动、蓝牙连接外部设备或手动同步录音三种方式实现华为AI眼镜音频记录。①在智慧生活App中创建场景,设置镜腿双击触发手机录音应用启动;②将眼镜作为蓝牙麦克风,在手机录音App中选择其为输入源进行录制;③佩戴眼镜时直接使用手机录音机手动开始录音,确保重要对话被完整捕获。

-

优化DeepSeekOCR访问效率需从多方面入手:调整TCP参数如启用BBR和TFO、增大缓冲区、复用TIME_WAIT连接以降低延迟;前后端采用内网通信、HTTP/2或gRPC协议,并压缩图像数据减少传输开销;通过异步推理、批量处理和负载均衡提升并发能力;结合Redis缓存高频结果与边缘节点部署,减少重复计算和物理传输距离。最终需根据实际环境平衡性能与资源消耗。

-

华为AI眼镜续航缩短可通过设置优化改善:一、关闭非必要通知播报以减少系统唤醒;二、禁用安静环境减小音量功能降低功耗;三、将音频播放音量调至60%以下以节能护耳;四、定期充满电并避免低温使用,长期不用时每两周充电至50%以上以维护电池健康。

-

2026年DeepSeekAI聊天入口仍为https://www.deepseek.com,支持网页、APP、微信及API多端使用,提供深度对话、代码生成、文本润色和文件读取等功能。

-

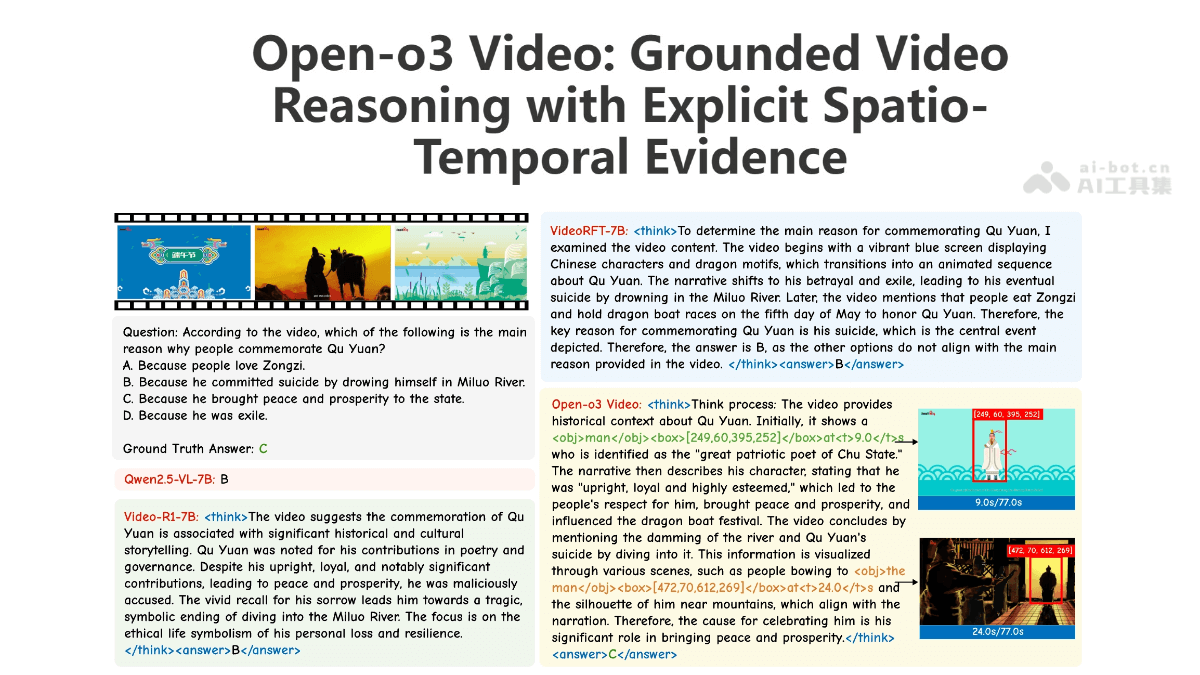

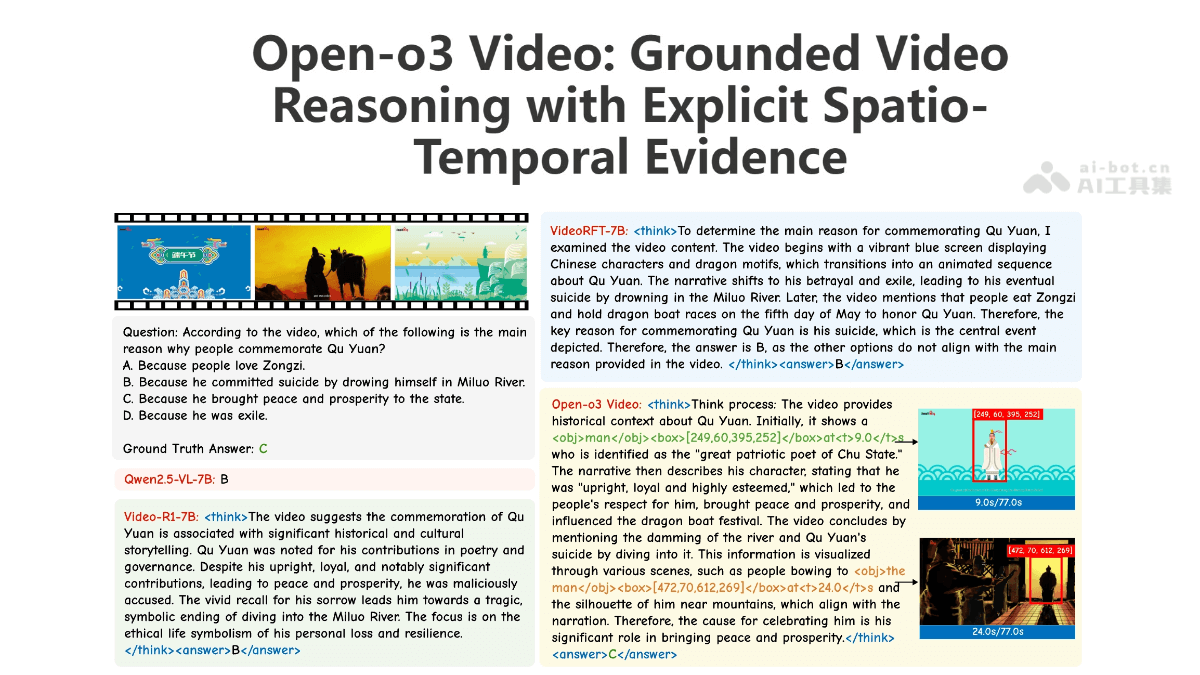

Open-o3Video是什么Open-o3Video是由北京大学与字节跳动联合研发的一款开源视频推理模型,致力于通过引入显式的时空线索(如关键时间点和目标边界框)来提升视频理解的精度。该模型依托精心构建的STGR数据集,并采用“监督微调+强化学习”两阶段训练策略,在V-STAR基准测试中取得了领先表现。其非代理架构设计有效支持复杂时空关系建模,在多项视频推理任务中展现出卓越性能。整个训练流程包含冷启动初始化和强化学习优化两个阶段,使模型具备更强的泛化能力与场景适应性。Open-o3V

-

开启低亮度模式、启用单光机运行、设定15秒自动熄屏、开启夜间护眼光学滤镜可延长续航并护眼。

-

快速创建Memo:点击“+”或语音输入“新建备忘录”,支持文字、图片、录音、链接,AI自动识别关键词并分类;2.利用AI整理内容:AI可识别内容并建议设置提醒、生成表格模板、推荐相关资料,需开启“AI智能建议”;3.多端同步与查找:支持手机和网页端同步,使用标签、筛选器高效搜索,定期整理星标内容;4.小功能提升效率:语音速记、通知栏快捷入口、桌面小部件,方便快速记录。掌握这些核心操作后,MemoAI能显著提升日常记录与管理效率。

即梦4.0支持通过文本指令生成三维虚拟场景,用户可输入自然语言描述创建环境,如“黄昏下的沙漠绿洲”,系统将自动渲染;结合结构化关键词(如环境、建筑、氛围类)可优化细节精度;还可选择“草图+文本”模式,上传手绘轮廓并补充说明,实现更精准的AI场景构建。142 收藏

即梦4.0支持通过文本指令生成三维虚拟场景,用户可输入自然语言描述创建环境,如“黄昏下的沙漠绿洲”,系统将自动渲染;结合结构化关键词(如环境、建筑、氛围类)可优化细节精度;还可选择“草图+文本”模式,上传手绘轮廓并补充说明,实现更精准的AI场景构建。142 收藏 虚拟伴侣通过情感计算技术实时识别用户情绪,首先利用语音分析提取语调、语速等特征并结合MFCC、F0等参数输入SVM或DNN模型判断情绪;其次通过NLP技术解析文本分词与语法结构,匹配情绪词典并借助BERT模型识别语义中的隐含情绪;再通过摄像头采集面部图像,使用CNN检测关键点并比对AU组合识别表情情绪;最后采用多模态融合策略,整合语音、文本、面部及生理信号,利用注意力机制加权各模态置信度,经融合模型输出最终情绪状态,动态调整回应策略。167 收藏

虚拟伴侣通过情感计算技术实时识别用户情绪,首先利用语音分析提取语调、语速等特征并结合MFCC、F0等参数输入SVM或DNN模型判断情绪;其次通过NLP技术解析文本分词与语法结构,匹配情绪词典并借助BERT模型识别语义中的隐含情绪;再通过摄像头采集面部图像,使用CNN检测关键点并比对AU组合识别表情情绪;最后采用多模态融合策略,整合语音、文本、面部及生理信号,利用注意力机制加权各模态置信度,经融合模型输出最终情绪状态,动态调整回应策略。167 收藏 首先打开即梦4.0的“设置”中“键盘与快捷方式”,进入“自定义快捷键”页面,点击+添加新快捷键,选择功能并设置组合键如Command+Shift+E,保存后生效;可双击修改或点击-删除已有快捷键;通过导出配置为.json文件并在其他设备导入,实现多端同步。351 收藏

首先打开即梦4.0的“设置”中“键盘与快捷方式”,进入“自定义快捷键”页面,点击+添加新快捷键,选择功能并设置组合键如Command+Shift+E,保存后生效;可双击修改或点击-删除已有快捷键;通过导出配置为.json文件并在其他设备导入,实现多端同步。351 收藏 使用夸克AI优化文本需依次执行四步:一、通过“智能润色”提升语言流畅度;二、利用“风格化改写”适配不同表达场景;三、启用“关键词优化”增强主题相关性;四、运行“语法纠错”确保语言规范,全面提升内容质量。394 收藏

使用夸克AI优化文本需依次执行四步:一、通过“智能润色”提升语言流畅度;二、利用“风格化改写”适配不同表达场景;三、启用“关键词优化”增强主题相关性;四、运行“语法纠错”确保语言规范,全面提升内容质量。394 收藏 GPT-5并非万能,其高效使用的核心在于精细化沟通与严格质量把控,必须通过明确角色设定、提供充分上下文、清晰目标与约束、示例引导、思维链提示等方式设计高质量提示词,并在多轮迭代中持续优化输出;同时要警惕其“幻觉”和数据偏差,对关键信息进行人工核查,避免在敏感领域过度依赖;最终应将其融入工作流,通过任务拆解、人机协同、API自动化及RAG等技术构建专家系统,实现从单次交互到高效自动化协作的跃迁,真正发挥其作为“数字分身”的潜力。481 收藏

GPT-5并非万能,其高效使用的核心在于精细化沟通与严格质量把控,必须通过明确角色设定、提供充分上下文、清晰目标与约束、示例引导、思维链提示等方式设计高质量提示词,并在多轮迭代中持续优化输出;同时要警惕其“幻觉”和数据偏差,对关键信息进行人工核查,避免在敏感领域过度依赖;最终应将其融入工作流,通过任务拆解、人机协同、API自动化及RAG等技术构建专家系统,实现从单次交互到高效自动化协作的跃迁,真正发挥其作为“数字分身”的潜力。481 收藏 即梦4.0可通过智能美化功能改善肤色暗沉、五官不立体等问题。首先启用智能人物美化模式,系统基于人脸识别自动优化人脸亮度、对比度与色彩平衡;接着使用一键美颜功能,整合磨皮、瘦脸、大眼等技术快速提升面容质感,并通过强度调节保持皮肤自然纹理;随后进入细节编辑,手动增强眼睛明亮度、校正唇色及调整面部轮廓以强化立体感;再结合AI抠图与背景虚化技术分离主体,突出人物视觉中心;最后可将常用参数保存为自定义模板,便于后续高效复用,全面提升人像处理质量与效率。424 收藏

即梦4.0可通过智能美化功能改善肤色暗沉、五官不立体等问题。首先启用智能人物美化模式,系统基于人脸识别自动优化人脸亮度、对比度与色彩平衡;接着使用一键美颜功能,整合磨皮、瘦脸、大眼等技术快速提升面容质感,并通过强度调节保持皮肤自然纹理;随后进入细节编辑,手动增强眼睛明亮度、校正唇色及调整面部轮廓以强化立体感;再结合AI抠图与背景虚化技术分离主体,突出人物视觉中心;最后可将常用参数保存为自定义模板,便于后续高效复用,全面提升人像处理质量与效率。424 收藏 文心一言官网为https://yiyan.baidu.com/,用户可免登录在线体验其多轮对话、内容创作、逻辑推理、代码编写等功能,界面简洁,响应迅速,支持长文本处理与进阶服务。158 收藏

文心一言官网为https://yiyan.baidu.com/,用户可免登录在线体验其多轮对话、内容创作、逻辑推理、代码编写等功能,界面简洁,响应迅速,支持长文本处理与进阶服务。158 收藏 即梦4.0可在iPadPro上实现AI风格迁移,先导入源图像与目标图像,再调整风格强度至70%左右,开启多层细节优化模式提升画质,最后点击“开始迁移”生成并导出结果。151 收藏

即梦4.0可在iPadPro上实现AI风格迁移,先导入源图像与目标图像,再调整风格强度至70%左右,开启多层细节优化模式提升画质,最后点击“开始迁移”生成并导出结果。151 收藏 可通过智慧场景联动、蓝牙连接外部设备或手动同步录音三种方式实现华为AI眼镜音频记录。①在智慧生活App中创建场景,设置镜腿双击触发手机录音应用启动;②将眼镜作为蓝牙麦克风,在手机录音App中选择其为输入源进行录制;③佩戴眼镜时直接使用手机录音机手动开始录音,确保重要对话被完整捕获。206 收藏

可通过智慧场景联动、蓝牙连接外部设备或手动同步录音三种方式实现华为AI眼镜音频记录。①在智慧生活App中创建场景,设置镜腿双击触发手机录音应用启动;②将眼镜作为蓝牙麦克风,在手机录音App中选择其为输入源进行录制;③佩戴眼镜时直接使用手机录音机手动开始录音,确保重要对话被完整捕获。206 收藏 优化DeepSeekOCR访问效率需从多方面入手:调整TCP参数如启用BBR和TFO、增大缓冲区、复用TIME_WAIT连接以降低延迟;前后端采用内网通信、HTTP/2或gRPC协议,并压缩图像数据减少传输开销;通过异步推理、批量处理和负载均衡提升并发能力;结合Redis缓存高频结果与边缘节点部署,减少重复计算和物理传输距离。最终需根据实际环境平衡性能与资源消耗。160 收藏

优化DeepSeekOCR访问效率需从多方面入手:调整TCP参数如启用BBR和TFO、增大缓冲区、复用TIME_WAIT连接以降低延迟;前后端采用内网通信、HTTP/2或gRPC协议,并压缩图像数据减少传输开销;通过异步推理、批量处理和负载均衡提升并发能力;结合Redis缓存高频结果与边缘节点部署,减少重复计算和物理传输距离。最终需根据实际环境平衡性能与资源消耗。160 收藏 华为AI眼镜续航缩短可通过设置优化改善:一、关闭非必要通知播报以减少系统唤醒;二、禁用安静环境减小音量功能降低功耗;三、将音频播放音量调至60%以下以节能护耳;四、定期充满电并避免低温使用,长期不用时每两周充电至50%以上以维护电池健康。179 收藏

华为AI眼镜续航缩短可通过设置优化改善:一、关闭非必要通知播报以减少系统唤醒;二、禁用安静环境减小音量功能降低功耗;三、将音频播放音量调至60%以下以节能护耳;四、定期充满电并避免低温使用,长期不用时每两周充电至50%以上以维护电池健康。179 收藏 2026年DeepSeekAI聊天入口仍为https://www.deepseek.com,支持网页、APP、微信及API多端使用,提供深度对话、代码生成、文本润色和文件读取等功能。174 收藏

2026年DeepSeekAI聊天入口仍为https://www.deepseek.com,支持网页、APP、微信及API多端使用,提供深度对话、代码生成、文本润色和文件读取等功能。174 收藏 Open-o3Video是什么Open-o3Video是由北京大学与字节跳动联合研发的一款开源视频推理模型,致力于通过引入显式的时空线索(如关键时间点和目标边界框)来提升视频理解的精度。该模型依托精心构建的STGR数据集,并采用“监督微调+强化学习”两阶段训练策略,在V-STAR基准测试中取得了领先表现。其非代理架构设计有效支持复杂时空关系建模,在多项视频推理任务中展现出卓越性能。整个训练流程包含冷启动初始化和强化学习优化两个阶段,使模型具备更强的泛化能力与场景适应性。Open-o3V358 收藏

Open-o3Video是什么Open-o3Video是由北京大学与字节跳动联合研发的一款开源视频推理模型,致力于通过引入显式的时空线索(如关键时间点和目标边界框)来提升视频理解的精度。该模型依托精心构建的STGR数据集,并采用“监督微调+强化学习”两阶段训练策略,在V-STAR基准测试中取得了领先表现。其非代理架构设计有效支持复杂时空关系建模,在多项视频推理任务中展现出卓越性能。整个训练流程包含冷启动初始化和强化学习优化两个阶段,使模型具备更强的泛化能力与场景适应性。Open-o3V358 收藏 开启低亮度模式、启用单光机运行、设定15秒自动熄屏、开启夜间护眼光学滤镜可延长续航并护眼。320 收藏

开启低亮度模式、启用单光机运行、设定15秒自动熄屏、开启夜间护眼光学滤镜可延长续航并护眼。320 收藏 快速创建Memo:点击“+”或语音输入“新建备忘录”,支持文字、图片、录音、链接,AI自动识别关键词并分类;2.利用AI整理内容:AI可识别内容并建议设置提醒、生成表格模板、推荐相关资料,需开启“AI智能建议”;3.多端同步与查找:支持手机和网页端同步,使用标签、筛选器高效搜索,定期整理星标内容;4.小功能提升效率:语音速记、通知栏快捷入口、桌面小部件,方便快速记录。掌握这些核心操作后,MemoAI能显著提升日常记录与管理效率。495 收藏

快速创建Memo:点击“+”或语音输入“新建备忘录”,支持文字、图片、录音、链接,AI自动识别关键词并分类;2.利用AI整理内容:AI可识别内容并建议设置提醒、生成表格模板、推荐相关资料,需开启“AI智能建议”;3.多端同步与查找:支持手机和网页端同步,使用标签、筛选器高效搜索,定期整理星标内容;4.小功能提升效率:语音速记、通知栏快捷入口、桌面小部件,方便快速记录。掌握这些核心操作后,MemoAI能显著提升日常记录与管理效率。495 收藏